連続スクロールと GSC ボイド: Google のデスクトップ検索結果での連続スクロールの開始は、インプレッションとクリックに影響を与えましたか? [勉強]

公開: 2023-01-25

Google は 2022 年 12 月 5 日に、米国で英語のクエリに対するデスクトップ検索結果の連続スクロールを展開しました。連続スクロールにより、ユーザーは結果の下部にある [次へ] ボタンをクリックすることなく、2 ページ目以降にシームレスに進むことができます。 . これは、Google が 2021 年 10 月にモバイル検索結果で連続スクロールを展開したことに続くものです (これも、英語のクエリについては米国のみです)。

これは、12 月初旬のデスクトップへのロールアウトに関する Google の発表です (連続スクロールの gif が動作中です)。

デスクトップへの展開後、連続スクロールがページ 1 を超えたランキングの可視性にどのような影響を与えるか、多くの人が疑問に思いました。 たとえば、URL が 2 ページ目、場合によっては 2 ページ目のトップにランク付けされているサイトの場合、ユーザーが検索結果の別のページに簡単にスクロールできるようになれば、より多くのインプレッション、クリック、およびコンバージョンにつながるはずです。 とにかくそれがアイデアであり、私が分析するために着手したものです.

SERPで連続スクロールが展開される前は、2ページ目以降のランキングは、おそらくあなたのリストがあまり見られないことを意味していました. 確かに、あえて 2 ページ目以降に進む人もいますが、ほとんどの人は 1 ページ目に固執します (結果をスキャンした後に必要な情報が見つからない場合は、検索を絞り込むだけです)。 ただし、連続スクロールを使用すると、ユーザーはボタンをクリックしなくても、結果の 2 ページ目に簡単に移動できます。 最初の結果セットの一番下に近づくと、新しい結果が表示されます。

米国のデスクトップ検索結果における連続スクロールの分析:

デスクトップでの連続スクロールの展開直後に、ユーザーが検索結果でより多くのリストをシームレスに表示できることに基づいて、インプレッション、クリック、およびクリック率の変化を分析する方法を説明する投稿を公開しました. 私のチュートリアルでは、Excel で GSC API と Analytics Edge を使用して、GSC からデータを一括エクスポートし、米国のデスクトップのみでフィルター処理し、時間枠を比較して、2 ページ目と 3 ページ目の結果でフィルター処理する方法について説明します。 結果として得られるワークシートは、連続スクロールが展開される前後の時間枠を比較すると、メトリック全体の変化をすばやく提供します。

その投稿を公開した後、サイト全体のレポートを掘り下げるために、さらにデータが構築されるのを待ち望んでいました. そして、それはまさに私がさまざまな業種の多くのサイトで行ったことです。 サイトには分析対象のデータが大量にあることはわかっていたので、米国のデスクトップ SERP で展開されている継続的なスクロールに基づいて違いを簡単に確認できるはずです。

以下では、私が使用した方法論、分析したデータ、GSC データに関するいくつかの興味深い (そして恐ろしい) 調査結果、およびデスクトップ検索結果での継続的なスクロールのロールアウトの影響またはその欠如について説明します。 飛び込みましょう。

方法論:

最初に、Google オーガニックからの安定した大量のトラフィックがある 12 の異なるサイトを選択しました。 一部のプロパティは、Google オーガニック検索から多くのクリックを獲得する大規模なサイトであり、他のプロパティは、トラフィックが少ない (それでもかなりのクリック数) を生成するニッチなサイトです。 私はサイトが複数のバーティカルにまたがっており、それらのバーティカルが休暇の影響を (できる限り) 受けないようにしました。 また、連続スクロールはまだ国際的に展開されていないため、米国のデスクトップの結果のみに焦点を当てるようにしました.

次に、チュートリアルで作成したプロセスを使用して、GSC からデータを一括でエクスポートし、米国からのデスクトップのみでフィルタリングし、時間枠を比較し、2 ページ目と 3 ページ目の結果でフィルタリングすることに基づいてメトリックの変化を分析しました。 GSC API、Excel、および Analytics Edge を使用してこれを達成する方法については、私のチュートリアルをご覧ください。

データを分析するときは、連続スクロールのロールアウトの前後で平均位置がほぼ同じであるクエリを確認しました。 たとえば、更新前は 24 位、更新後は 16 位だったクエリはレビューしません。 これは大きな違いであり、明らかにデータに影響を与える可能性があります。 連続スクロールが可視性とエンゲージメントに影響を与えているかどうかをよりよく分析できるように、サイトがほぼ同じ順位にランク付けされたクエリを探しました。

12 のサイトの Google オーガニック検索トラフィックに関して、分析した各サイトの過去 3 か月間のクリック数を提供しました (最近 Google からどれだけのトラフィックが発生したかを感じていただけるように)。

過去 3 か月間のサイトのクリック数は 8,900 万回から 140 万回に及び、さまざまな業種にまたがっています。

- サイト 1: 8,900 万回のクリック

- サイト 2: 3,100 万回のクリック

- サイト 3: 860 万回のクリック

- サイト 4: 480 万回のクリック

- サイト 5: 380 万回のクリック

- サイト 6: 340 万回のクリック

- サイト 7: 280 万回のクリック

- サイト 8: 140 万回のクリック

GSC の虚無: 暗く、暗く、決定的でない

まず、クエリに基づいてデータをエクスポートした後、フィルター処理された GSC データの現実に大きな打撃を受けました。 Barry Schwartz は 2022 年 7 月に、Patrick Stox が GSC フィルタリング データを使用してサイト全体で見ていることを説明する投稿を書いた後、これを取り上げました。 一部のサイトでどれだけのデータがフィルタリングされたかを見るのは目を見張るものがありました…

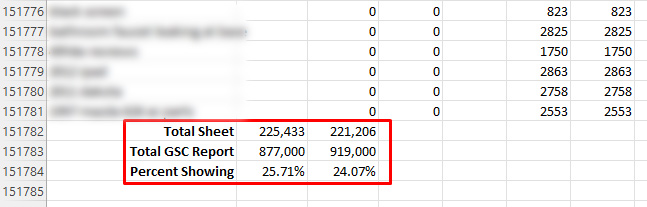

当時、複数のサイトで確認したところ、クエリに基づいてエクスポートすると、データに大きなギャップがありました。 たとえば、GSC のパフォーマンス レポートの上部に表示される合計は、クエリごとにデータをエクスポートした (その後、クリック数とインプレッション数を合計した) 後に表示されるものよりもはるかに大きくなる可能性があります。 そして、私はWAY OFFを意味します。 当時分析したいくつかのサイトでは、データをエクスポートした後、全体の 20% しか表示されませんでした。 はい、それはデータの80%がフィルター処理されたことを意味します。

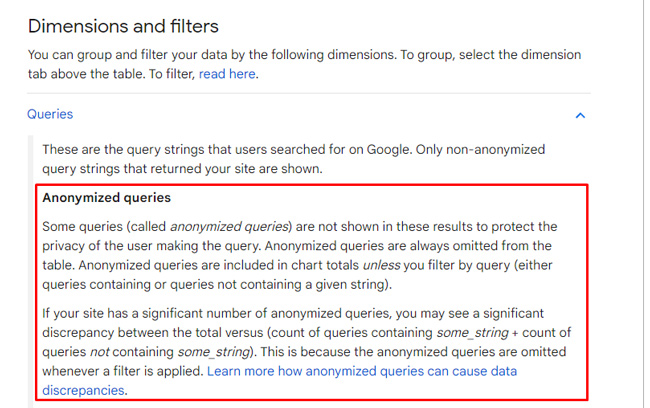

その理由は、Google がプライバシーの問題に基づいてクエリをフィルタリングするためです。 Patrick の調査後に改良されたドキュメントの中で、Google は、ユーザーのプライバシーを保護するために「匿名化されたクエリ」をフィルタリングすると説明しています。 また、サイトによっては、大量のデータになる場合があります。 ページごとにエクスポートすると完全な結果が得られる (または閉じる) ことは注目に値しますが、クエリごとにエクスポートすると、GSC void と呼ばれるものが強調されます。

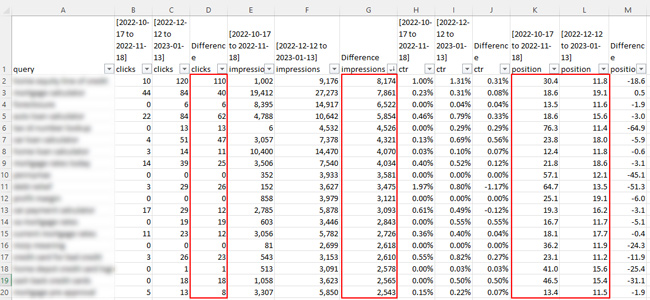

連続スクロール データに戻ります… 私が分析した 12 のサイトでは、一部の GSC プロパティは、フィルタリングにより、パフォーマンス レポートで報告された合計データの 20 ~ 30% しか提供しませんでした。 あなたはそれを正しく読みました。 つまり、これらのサイトでは 70 ~ 80% がフィルタリングされました。

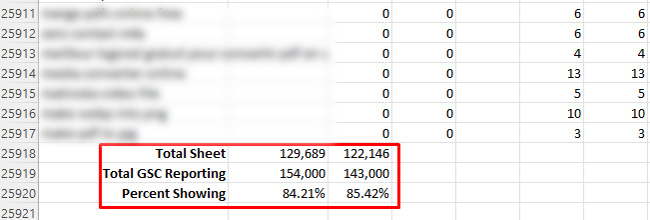

反対に、表示されているデータの 84% (つまり 16% がフィルター処理されている) も見ましたが、GSC で多数のプロパティを確認した結果、これが最大でした。 誤解しないでほしいのですが、これは 24% よりもはるかに優れています。

フィルタリングの量を見たとき、データを分析しようとすることで自分の仕事が切り詰められていることがわかりました。 継続的なスクロールの展開に基づいて変化が見られるだけの十分な量があることを願っていました... 1 つ明らかなことは、GSC の空白は暗くて暗いということです。

Dark and Murky: インプレッション数、クリック数、クリック率への影響を分析します。

まず、「ダーク アンド マーキー」は、リゾートのプールサイドで注文できるトレンディな新しいドリンクの名前ではありません。 これは、私が分析したサイト全体のデータを調べた後、最初に言ったことです。 結果の最初のページを過ぎると、ほとんどのサイトの数値が急落しました。 デスクトップのSERPからのクリック数とクリックスルー率に継続的なスクロールがどのように影響しているかについて結論を出すことはほとんど不可能です.

インプレッションの観点からは、インプレッションの増加に一貫した傾向は見られませんでした。 一部のクエリでは、インプレッションが増加しました。 他の人にとっては、彼らは落ちました。 繰り返しになりますが、クリック数とクリックスルー率は、ページ 1 を超える数値が非常に低いため、分析が非常に困難でした。

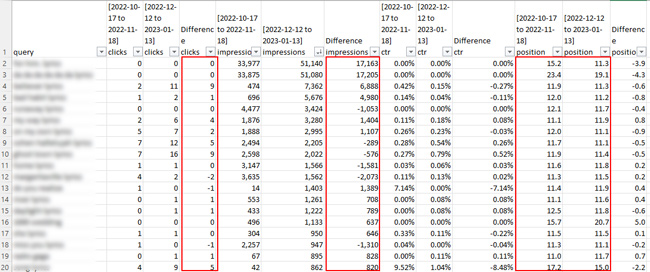

たとえば、スプレッドシートでいくつかのサイトの 2 ページ目の結果を確認したところ、クリック数は重要ではありませんでした。 ちなみに、これはどれだけのデータがフィルタリングされているかを示しています... 1 ページ目では、いくつかのクエリが数万回以上のクリックを生み出しています。 その後、2 ページ目はほとんど何も表示されなくなりますか? そうです、GSC の空隙は現実のものであり、分析を著しく妨げる可能性があります。

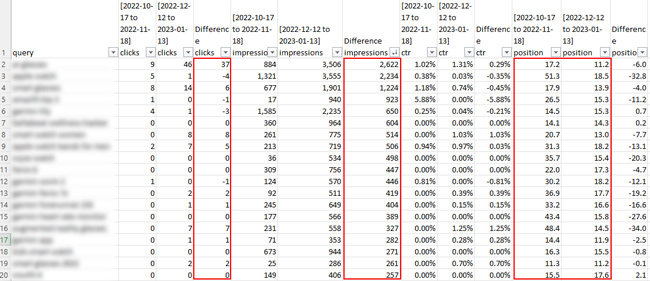

検索結果の 2 ページ目のスプレッドシートのスクリーンショットを次に示します。 クリックの観点から圧倒される準備をしてください。 :)

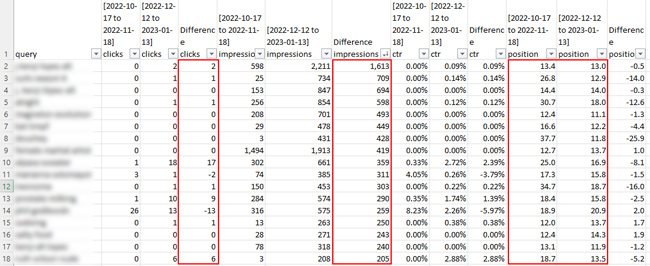

しかし、データの 16% しかフィルター処理されていない 1 つのサイトについて言及しました (これは、12 のサイトの中で最高でした)。 そのサイトについては、何らかの結論を下すのに十分なデータがあると思うかもしれませんが、そうではありません. 2ページ目以降を分析すると、クリック数は非常に低かった. 多くのクエリでインプレッションが増加していることがわかりましたが、クリックは増加していません。 また、1 ページ目以降のクリック数が非常に少なかったため、クリック率の差を確認する意味がありませんでした。

これは、14% のみがフィルタリングされたサイトのスクリーンショットです。

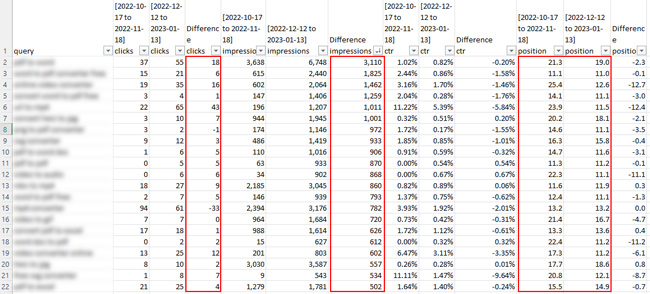

たとえば、あるクエリでは、インプレッション数は 3,110 増加しましたが、クリック数は 18 増加しただけでした。平均掲載順位は 21.3 から 19.0 に上がりました。 明らかに、これは結論を引き出すのに十分なデータではありません。 インプレッションの増加は 1 つのことですが、クリック数が少なすぎてあまり意味がありませんでした。 正直なところ、クリックが続かない場合のインプレッションの増加を本当に気にする人はいません。 ほとんどのサイト所有者にとって、これは実際にはブランディングの練習ではありません。 彼らはクリックとその後のコンバージョンを望んでいます! :)

これは別のサイトで、一部のクエリでインプレッションが大幅に増加し、一部のクエリでクリック数が確実に増加しています。 とはいえ、増加の一部は、最新の時間枠でサイトのランキングがはるかに強かったためです. サイトがほぼ同じ順位にランク付けされたときに、いくつかのクエリでインプレッションが増加しましたが、重大な結論を引き出すのに十分なクリック データがありません…

デスクトップの SERP での連続スクロールの分析に基づく主なポイント:

- サイト全体の私の分析に基づくと、2 ページ目以降には分析するデータがあまりありません。これは、Google のオーガニック トラフィックが大量にある大規模なサイトの場合でも同様です。 これは、匿名化されたクエリの GSC フィルタリングに基づいています。

- 一部のクエリでインプレッションの増加が見られましたが、時間枠を比較すると減少したものも多く、結論を出すのは困難でした.

- クリック数とクリック率の分析はさらに困難でした。 1 ページ目以降は全体的に報告するクリック数が多くなかったため、結論を出すのは非常に困難でした。

- GSC データの観点から言えば、GSC フィルタリングに基づくデータは非常に限られていました。 これは以前に報告されており、この調査では、フィルタリングがどれだけ行われているかが強調されています。 たとえば、一部のエクスポートでは、パフォーマンス レポートで GSC で報告されたデータの 20 ~ 30% しか得られませんでした (クエリで分析した場合)。

- 私が公開したチュートリアルを使用して、自分のサイトでこのプロセスを実行することをお勧めします (クエリでエクスポートするときに GSC データで厳しいフィルタリングが行われることを確認する以外の理由がない場合)。 ページごとにエクスポートする場合は完全なデータを表示できるはずですが、特定のページにつながる多くのクエリがあることに注意してください (これにより、分析的に混乱する可能性があります)。

要約: SERP における連続スクロールの GSC Void Limits 分析

デスクトップの検索結果に継続的なスクロールが展開された後、2 ページ目以降にスクロールするユーザーに基づいて、インプレッションとクリックへの影響を分析することに非常に興奮しました。 残念ながら、GSC のデータ フィルタリングは、私の努力を大幅に妨げました。 一部のサイトでは、GSC の匿名化されたクエリのフィルタリングに基づいて、合計データの 20 ~ 30% しか返されませんでした。

サイト全体の連続スクロールの分析に基づいて、より強力な調査結果に出くわした場合は、この投稿を必ず更新します. それまでは、自分のサイトでこのプロセスを実行することをお勧めします。 GSC があなたのデータの多くをフィルター処理していない可能性があります。幸運を祈ります。

GG