Continuous Scroll und die GSC-Void: Hat sich die Einführung von Continuous Scroll in den Desktop-Suchergebnissen von Google auf Impressions und Klicks ausgewirkt? [Lernen]

Veröffentlicht: 2023-01-25

Google hat am 5. Dezember 2022 Continuous Scroll in den Desktop-Suchergebnissen für englische Suchanfragen in den USA eingeführt. Continuous Scroll ermöglicht es Benutzern, nahtlos zu Seite zwei und darüber hinaus fortzufahren, ohne auf eine „Weiter“-Schaltfläche am Ende der Ergebnisse klicken zu müssen . Dies folgte Google, das im Oktober 2021 kontinuierliches Scrollen in den mobilen Ergebnissen einführte (wiederum nur in den USA für englische Suchanfragen).

Hier ist die Ankündigung von Google zum Rollout auf den Desktop Anfang Dezember (mit einem GIF von kontinuierlichem Scrollen in Aktion):

Nach dem Rollout auf den Desktop fragten sich viele, wie sich kontinuierliches Scrollen auf die Sichtbarkeit von Rankings auswirken würde, die über die Seite eins hinausgingen. Beispielsweise sollte bei Websites mit URLs, die auf Seite zwei und vielleicht sogar ganz oben auf Seite zwei rangieren, die Möglichkeit für Benutzer, einfach zu weiteren Seiten mit Suchergebnissen zu scrollen, zu mehr Impressionen, Klicks und Conversions führen. Das ist sowieso die Idee, und etwas, das ich analysieren wollte.

Bevor das kontinuierliche Scrollen in den SERPs eingeführt wurde, bedeutete das Ranking auf Seite zwei und darüber hinaus, dass Ihre Einträge wahrscheinlich nicht viel gesehen wurden. Sicher, einige Leute würden sich auf Seite zwei und darüber hinaus wagen, aber die meisten würden auf Seite eins bleiben (und ihre Suche einfach verfeinern, wenn sie nach dem Scannen der Ergebnisse nicht finden konnten, was sie brauchten). Aber mit kontinuierlichem Scrollen können Benutzer einfach zur zweiten Ergebnisseite wechseln, ohne auf eine Schaltfläche klicken zu müssen. Die neuen Ergebnisse werden nur angezeigt, wenn Sie sich dem Ende der anfänglichen Ergebnismenge nähern.

Analysieren von Continuous Scroll in den US-Desktop-Suchergebnissen:

Unmittelbar nach der Einführung des kontinuierlichen Scrollens auf dem Desktop habe ich einen Beitrag veröffentlicht, in dem erklärt wird, wie die Änderung der Impressionen, Klicks und der Klickrate analysiert werden kann, basierend darauf, dass Benutzer nahtlos mehr Einträge in den Suchergebnissen anzeigen können. In meinem Tutorial wird erläutert, wie Sie die GSC-API und Analytics Edge in Excel verwenden, um Daten aus GSC in großen Mengen zu exportieren, nur nach Desktop aus den USA zu filtern, Zeiträume zu vergleichen und dann nach den Ergebnissen von Seite zwei und drei zu filtern. Die resultierenden Arbeitsblätter liefern schnell die Änderungen über die Metriken hinweg, wenn der Zeitrahmen vor und nach der Einführung des kontinuierlichen Scrollens verglichen wird.

Nach der Veröffentlichung dieses Beitrags habe ich gespannt darauf gewartet, weitere Daten zu erstellen, um mich mit der standortübergreifenden Berichterstellung zu befassen. Und genau das habe ich für eine Reihe von Websites in allen Branchen getan. Ich wusste, dass die Websites eine Menge Daten zum Analysieren haben würden, und zwar über Branchen hinweg, also sollte es einfacher sein, Unterschiede zu erkennen, die auf dem kontinuierlichen Scrollen basieren, das in den Desktop-SERPs in den Vereinigten Staaten eingeführt wird.

Im Folgenden werde ich die von mir verwendete Methodik, die von mir analysierten Daten, einige interessante (und beängstigende) Erkenntnisse über GSC-Daten und die Auswirkungen oder deren Fehlen des kontinuierlichen Scrollens in den Desktop-Suchergebnissen behandeln. Springen wir hinein.

Methodik:

Zuerst habe ich zwölf verschiedene Websites ausgewählt, die eine konstante und erhebliche Menge an organischem Traffic von Google haben. Einige der Eigenschaften sind große Websites, die viele Klicks von Google organisch generieren, während andere Nischenwebsites waren, die weniger Traffic (aber immer noch eine gute Anzahl von Klicks) generieren. Ich habe dafür gesorgt, dass die Websites branchenübergreifend waren und dass diese Branchen nicht stark von den Feiertagen betroffen waren (soweit ich konnte). Außerdem habe ich darauf geachtet, mich nur auf die Desktop-Ergebnisse aus den USA zu konzentrieren, da Continuous Scroll international noch nicht eingeführt wurde.

Dann habe ich den Prozess verwendet, den ich in meinem Tutorial beschrieben habe, um die Änderung der Metriken basierend auf dem Exportieren von Daten aus GSC in großen Mengen zu analysieren, nur nach Desktop aus den USA zu filtern, Zeitrahmen zu vergleichen und dann nach den Ergebnissen von Seite zwei und drei zu filtern. In meinem Tutorial erfahren Sie, wie Sie dies mit der GSC-API, Excel und Analytics Edge erreichen.

Bei der Analyse der Daten habe ich darauf geachtet, Abfragen zu überprüfen, bei denen die durchschnittliche Position vor und nach der Einführung des kontinuierlichen Scrollens ungefähr gleich war. Zum Beispiel würde ich keine Suchanfrage überprüfen, die vor dem Update auf Rang 24 und danach auf Rang 16 lag. Das ist ein großer Unterschied und könnte sich offensichtlich auf die Daten auswirken. Ich habe nach Abfragen gesucht, bei denen die Website ungefähr an derselben Position rangiert, damit ich besser analysieren kann, ob kontinuierliches Scrollen Auswirkungen auf die Sichtbarkeit und das Engagement hat.

In Bezug auf den organischen Google-Suchverkehr für die zwölf Websites habe ich die Anzahl der Klicks in den letzten drei Monaten für jede der von mir analysierten Websites angegeben (nur damit Sie ein Gefühl dafür haben, wie viel Verkehr sie in letzter Zeit von Google generiert haben).

Die Seiten reichten von 89 Mio. Klicks bis 1,4 Mio. Klicks in den letzten drei Monaten und umfassten eine Reihe von Branchen:

- Seite 1: 89 Millionen Klicks

- Seite 2: 31 Millionen Klicks

- Seite 3: 8,6 Millionen Klicks

- Seite 4: 4,8 Millionen Klicks

- Seite 5: 3,8 Mio. Klicks

- Seite 6: 3,4 Millionen Klicks

- Seite 7: 2,8 Millionen Klicks

- Seite 8: 1,4 Millionen Klicks

Die GSC-Void: Dunkel, düster und nicht schlüssig

Erstens wurde die Realität gefilterter GSC-Daten nach dem Export von Daten basierend auf Abfragen hart getroffen. Barry Schwartz berichtete im Juli 2022 darüber, nachdem Patrick Stox einen Beitrag geschrieben hatte, in dem er erklärte, was er auf Websites mit GSC-Filterdaten sah. Es war aufschlussreich zu sehen, wie viele Daten für einige Websites gefiltert wurden…

Als ich damals seitenübergreifend nachgeschaut habe, habe ich beim Export auf Anfrage auch massive Datenlücken gesehen. Beispielsweise kann die Summe oben im Leistungsbericht in GSC viel größer sein als das, was Sie sehen, nachdem Sie die Daten nach Abfrage exportiert haben (und dann die Klicks und Impressionen summiert haben). Und ich meine WEG. Bei einigen Websites, die ich damals analysierte, sah ich nach dem Export der Daten nur 20 % der Gesamtzahl. Ja, das bedeutet, dass 80 % der Daten gefiltert wurden.

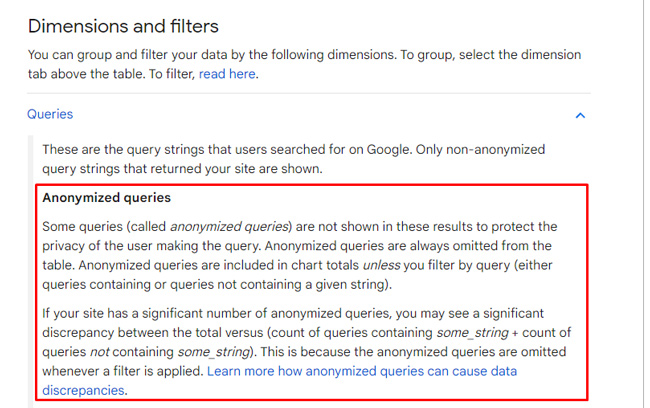

Der Grund dafür ist, dass Google Abfragen basierend auf Datenschutzbedenken filtert. In seiner Dokumentation, die es nach Patricks Studie verfeinert hat, erklärt Google, dass es „anonymisierte Anfragen“ filtert, um die Privatsphäre der Nutzer zu schützen. Und für einige Websites kann es sich um eine Menge Daten handeln. Es ist erwähnenswert, dass der Export nach Seite die vollständigen Ergebnisse (oder den Abschluss) liefert, aber der Export nach Abfrage hebt hervor, was ich die GSC-Void nenne.

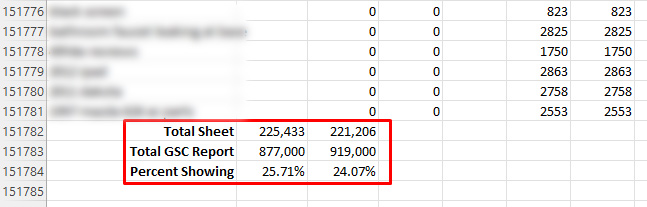

Zurück zu den Continuous-Scroll-Daten… Für die zwölf von mir analysierten Websites lieferten einige GSC-Eigenschaften aufgrund von Filterung nur 20–30 % der Gesamtdaten, die in den Leistungsberichten gemeldet wurden. Das hast du richtig gelesen. Das bedeutet, dass 70-80 % für diese Seiten gefiltert wurden.

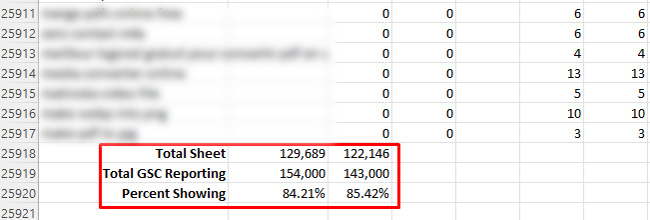

Auf der anderen Seite habe ich bis zu 84 % der angezeigten Daten gesehen (also 16 % gefiltert), aber das war das Maximum, das ich bei der Überprüfung einer Reihe von Eigenschaften in GSC finden konnte. Verstehen Sie mich nicht falsch, das ist viel besser als 24 %!

Als ich den Umfang der Filterung sah, wusste ich, dass ich meine Arbeit mit dem Versuch, die Daten zu analysieren, für mich ausgeschnitten hatte. Ich hatte gehofft, es gäbe genug, um Änderungen zu sehen, die auf dem fortlaufenden Scrollen basieren … Eines war klar, die GSC-Leere war dunkel und trübe.

Dark and Murky: Analyse der Auswirkungen auf Impressionen, Klicks und Klickrate.

Erstens ist „Dark and Murky“ nicht der Name eines trendigen neuen Getränks, das Sie in einem Resort am Pool bestellen können. Das ist nur das Erste, was ich sagte, nachdem ich die Daten der von mir analysierten Websites durchgesehen hatte. Als ich über die erste Ergebnisseite hinausging, sanken die Zahlen auf den meisten Websites. Sie fallen so stark ab, dass es fast unmöglich ist, Schlussfolgerungen darüber zu ziehen, wie sich kontinuierliches Scrollen auf die Klicks und die Klickrate von den Desktop-SERPs auswirkt.

Und aus Sicht der Impressionen konnte ich keinen konsistenten Trend bei der Zunahme der Impressionen erkennen. Bei einigen Suchanfragen stiegen die Impressionen. Bei anderen sind sie gefallen. Und auch hier waren Klicks und Klickraten aufgrund der wahnsinnig niedrigen Zahlen jenseits der ersten Seite sehr schwer zu analysieren.

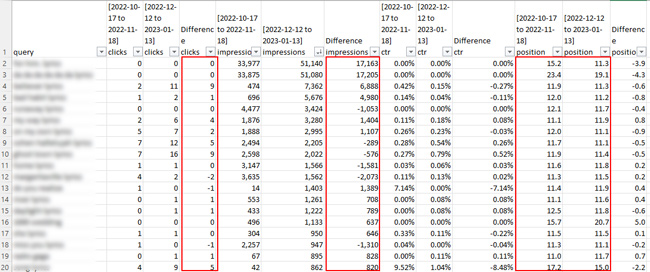

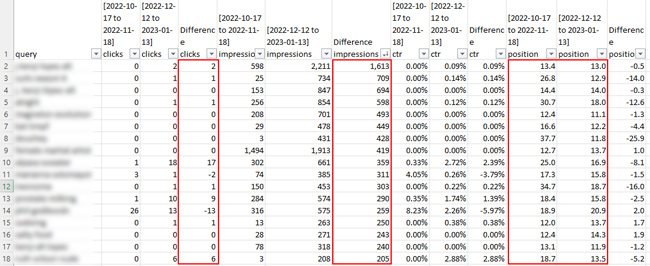

Sobald ich zum Beispiel die Tabelle für die Ergebnisse von Seite zwei auf mehreren Websites überprüfte, war die Anzahl der Klicks belanglos. Das zeigt Ihnen übrigens, wie viele Daten gefiltert werden … Auf Seite eins erzielen einige Abfragen Zehntausende von Klicks oder mehr. Dann fällt Seite zwei auf fast nichts? Also ja, die GSC-Leerstelle ist real und kann Ihre Analyse ernsthaft behindern.

Hier sind einige Screenshots aus den Tabellenkalkulationen für Seite zwei der Suchergebnisse. Machen Sie sich bereit, vom Standpunkt der Klicks überwältigt zu werden. :)

Aber ich habe eine Seite erwähnt, bei der nur 16 % der Daten gefiltert wurden (was das Beste war, was ich von den zwölf gefunden habe). Für diese Seite würde man meinen, ich hätte genug Daten, um einige Schlussfolgerungen zu ziehen … aber nicht wirklich. Die Klicks waren sehr gering, nachdem ich Seite zwei und darüber hinaus analysiert hatte. Ich konnte sehen, dass die Impressionen für eine Reihe von Suchanfragen gestiegen sind, die Klicks jedoch nicht. Und da die Klicks nach Seite eins so niedrig waren, war es sinnlos, den Unterschied in der Klickrate zu überprüfen.

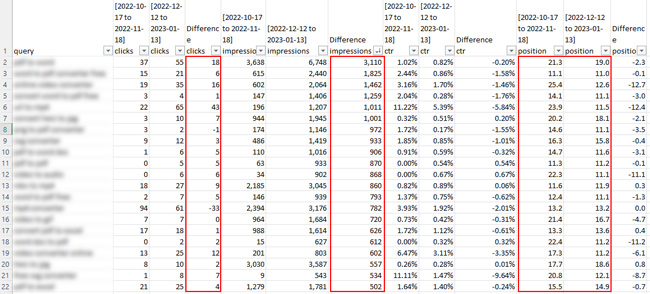

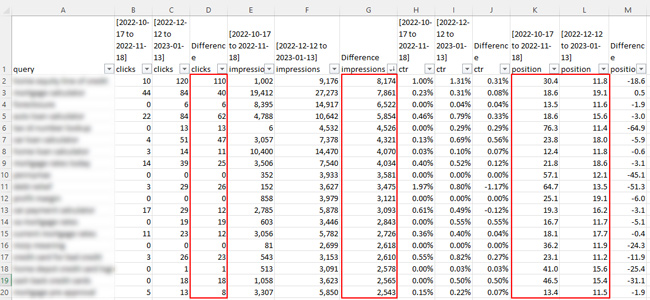

Hier ist ein Screenshot von der Seite, die nur zu 14 % gefiltert wurde:

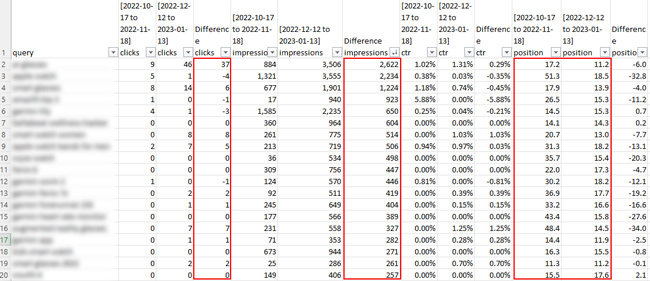

Zum Beispiel stieg die Anzahl der Impressionen bei einer Suchanfrage um 3.110, aber die Klicks stiegen nur um 18. Die durchschnittliche Position stieg von 21,3 auf 19,0, was knapp ist, aber das hätte einen Sprung von Seite drei der Ergebnisse auf zwei bedeuten können. Offensichtlich sind dies nicht genug Daten, um irgendwelche Schlussfolgerungen zu ziehen. Der Anstieg der Impressionen ist eine Sache, aber die Klicks waren so gering, dass es nicht viel bedeutete. Und mal ehrlich, wen kümmert schon eine Steigerung der Impressions, wenn keine Klicks folgen. Für die meisten Websitebesitzer ist dies nicht wirklich eine Branding-Übung. Sie wollen die Klicks und die nachfolgenden Conversions! :)

Hier ist eine weitere Website, auf der es bei einigen Suchanfragen einen netten Anstieg der Impressionen und definitiv einen Anstieg der Klicks für einige der Suchanfragen gab. Allerdings waren einige der Steigerungen darauf zurückzuführen, dass das Ranking der Website im letzten Zeitraum viel stärker war. Bei einigen Suchanfragen gab es einen Anstieg der Impressionen, wenn die Website ungefähr die gleiche Position hatte, aber es gibt einfach nicht genügend Klickdaten, um ernsthafte Schlussfolgerungen zu ziehen …

Wichtige Erkenntnisse basierend auf der Analyse von Continuous Scroll in den Desktop-SERPs :

- Basierend auf meiner seitenübergreifenden Analyse gibt es nicht viele Daten auf Seite zwei und darüber hinaus zu analysieren… Das gilt sogar für große Seiten mit einer Menge organischem Google-Traffic. Das basiert darauf, dass GSC anonymisierte Abfragen filtert.

- Ich konnte bei einigen Suchanfragen einen Anstieg der Impressionen feststellen, aber es war schwer, irgendwelche Schlussfolgerungen zu ziehen, da viele auch beim Vergleich der Zeiträume zurückgingen.

- Klicks und Klickraten waren noch schwieriger zu analysieren. Es gab insgesamt nicht viele Klicks, die über die erste Seite hinaus berichtet werden konnten, was es sehr schwierig machte, irgendwelche Schlussfolgerungen zu ziehen.

- Vom Standpunkt der GSC-Daten aus hatte ich stark eingeschränkte Daten basierend auf der GSC-Filterung. Dies wurde bereits früher berichtet, und diese Studie unterstreicht, wie stark gefiltert wird. Beispielsweise lieferten einige der Exporte nur 20–30 % der Daten, die im GSC in den Leistungsberichten (bei der Analyse nach Abfrage) gemeldet wurden.

- Ich empfehle, diesen Prozess für Ihre eigenen Websites mithilfe des von mir veröffentlichten Tutorials durchzuführen (wenn auch aus keinem anderen Grund, als die strenge Filterung zu sehen, die bei GSC-Daten beim Exportieren nach Abfrage vor sich geht). Beachten Sie, dass Sie in der Lage sein sollten, die vollständigen Daten zu sehen, wenn Sie nach Seiten exportieren, aber es gibt viele Abfragen, die zu bestimmten Seiten führen (was die Analyse trüben kann).

Zusammenfassung: Die GSC Void Limits Analysis of Continuous Scroll in den SERPs

Nachdem das kontinuierliche Scrollen in den Desktop-Suchergebnissen eingeführt wurde, war ich sehr gespannt darauf, die Auswirkungen auf Impressionen und Klicks zu analysieren, die darauf basieren, dass Benutzer zu Seite zwei und darüber hinaus scrollen. Leider hat die GSC-Datenfilterung meine Bemühungen stark behindert. Einige Websites gaben nur 20–30 % der gesamten Daten zurück, basierend auf der GSC-Filterung anonymisierter Abfragen.

Ich werde diesen Beitrag auf jeden Fall aktualisieren, wenn ich auf stärkere Ergebnisse stoße, die auf der Analyse des kontinuierlichen Scrollens zwischen Websites basieren. In der Zwischenzeit empfehle ich, diesen Prozess für Ihre eigenen Websites durchzuführen. Sie wissen nie, GSC filtert möglicherweise nicht so viele Ihrer Daten ... Viel Glück.

GG

– Glenn Gabe (@glenngabe) 11. Juli 2022

– Glenn Gabe (@glenngabe) 11. Juli 2022