Pengguliran Berkelanjutan Dan Kekosongan GSC: Apakah Peluncuran Pengguliran Berkelanjutan Di Hasil Pencarian Desktop Google Mempengaruhi Tayangan Dan Klik? [Belajar]

Diterbitkan: 2023-01-25

Google meluncurkan pengguliran berkelanjutan di hasil penelusuran desktop untuk kueri bahasa Inggris di Amerika Serikat pada 5 Desember 2022. Pengguliran berkelanjutan memungkinkan pengguna untuk melanjutkan ke halaman dua dan seterusnya tanpa harus mengeklik tombol "berikutnya" di bagian bawah hasil . Ini mengikuti Google meluncurkan gulir berkelanjutan di hasil seluler pada Oktober 2021 (sekali lagi, hanya AS untuk kueri bahasa Inggris).

Berikut adalah pengumuman Google tentang peluncuran ke desktop pada awal Desember (dengan gif aksi gulir terus menerus):

Setelah diluncurkan ke desktop, banyak yang bertanya-tanya bagaimana pengguliran berkelanjutan akan memengaruhi visibilitas peringkat yang berada di luar halaman satu. Misalnya, untuk situs dengan peringkat url di halaman dua, dan bahkan mungkin bagian atas halaman dua, kemampuan pengguna untuk menggulir ke halaman tambahan hasil penelusuran dengan mudah akan menghasilkan lebih banyak tayangan, klik, dan konversi. Itulah idenya, dan sesuatu yang ingin saya analisis.

Sebelum pengguliran terus-menerus diluncurkan di SERP, memberi peringkat pada halaman dua dan seterusnya berarti cantuman Anda mungkin tidak akan banyak terlihat. Tentu saja, beberapa orang akan menjelajah ke halaman dua dan seterusnya, tetapi sebagian besar akan bertahan di halaman satu (dan hanya mempersempit pencarian mereka jika mereka tidak dapat menemukan apa yang mereka butuhkan setelah memindai hasilnya). Namun dengan scroll terus menerus, pengguna dapat dengan mudah berpindah ke halaman kedua hasil tanpa harus mengklik tombol. Hasil baru muncul begitu Anda mendekati bagian bawah kumpulan hasil awal.

Menganalisis Gulir Berkelanjutan di Hasil Pencarian Desktop AS:

Tepat setelah peluncuran pengguliran berkelanjutan di desktop, saya menerbitkan postingan yang menjelaskan cara menganalisis perubahan tayangan, klik, dan rasio klik-tayang berdasarkan kemampuan pengguna untuk melihat lebih banyak daftar di hasil pencarian dengan mulus. Tutorial saya menjelaskan cara menggunakan GSC API dan Analytics Edge di Excel untuk mengekspor data secara massal dari GSC, memfilter berdasarkan desktop hanya dari Amerika Serikat, membandingkan kerangka waktu, lalu memfilter menurut hasil halaman dua dan tiga. Lembar kerja yang dihasilkan dengan cepat memberikan perubahan di seluruh metrik saat membandingkan jangka waktu sebelum, dan setelah, pengguliran berkelanjutan diluncurkan.

Setelah memublikasikan postingan itu, saya dengan tidak sabar menunggu lebih banyak data dibuat untuk menggali pelaporan di seluruh situs. Dan itulah yang saya lakukan untuk sejumlah situs lintas vertikal. Saya tahu situs tersebut akan memiliki banyak sekali data untuk dianalisis, dan lintas vertikal, jadi akan lebih mudah untuk melihat perbedaan berdasarkan pengguliran berkelanjutan yang diluncurkan di SERP desktop di Amerika Serikat.

Di bawah ini, saya akan membahas metodologi yang saya gunakan, data yang saya analisis, beberapa temuan menarik (dan menakutkan) tentang data GSC, dan dampak, atau ketiadaan, dari pengguliran terus menerus di hasil pencarian desktop. Mari kita masuk.

Metodologi:

Pertama, saya memilih dua belas situs berbeda yang memiliki jumlah lalu lintas yang stabil dan signifikan dari Google organik. Beberapa properti adalah situs berskala besar yang mendorong banyak klik dari Google organik, di mana yang lain adalah situs khusus yang menghasilkan lebih sedikit lalu lintas (tetapi masih memiliki jumlah klik yang bagus). Saya memastikan situs-situs itu melintang secara vertikal, dan bahwa vertikal tersebut tidak terlalu terpengaruh oleh liburan (sebanyak yang saya bisa). Selain itu, saya memastikan untuk fokus hanya pada hasil desktop dari Amerika Serikat, karena pengguliran berkelanjutan belum diluncurkan secara internasional.

Kemudian saya menggunakan proses yang saya petakan dalam tutorial saya untuk menganalisis perubahan metrik berdasarkan mengekspor data dari GSC secara massal, memfilter menurut desktop hanya dari AS, membandingkan kerangka waktu, lalu memfilter menurut hasil halaman dua dan tiga. Anda dapat memeriksa tutorial saya untuk mengetahui cara melakukannya menggunakan GSC API, Excel, dan Analytics Edge.

Saat menganalisis data, saya memastikan untuk meninjau kueri di mana posisi rata-rata hampir sama sebelum dan sesudah pengguliran berkelanjutan diluncurkan. Misalnya, saya tidak akan meninjau kueri yang berperingkat 24 sebelum pembaruan dan 16 setelahnya. Itu perbedaan besar dan jelas dapat memengaruhi data. Saya mencari kueri di mana peringkat situs berada pada posisi yang kira-kira sama sehingga saya dapat menganalisis dengan lebih baik jika pengguliran berkelanjutan berdampak pada visibilitas dan keterlibatan.

Mengenai lalu lintas pencarian organik Google untuk dua belas situs, saya telah memberikan jumlah klik selama tiga bulan terakhir untuk setiap situs yang saya analisis (agar Anda dapat merasakan berapa banyak lalu lintas yang mereka dorong dari Google baru-baru ini).

Situs berkisar dari 89 juta klik hingga 1,4 juta klik selama tiga bulan terakhir dan menjangkau sejumlah vertikal:

- Situs 1: 89 juta klik

- Situs 2: 31 juta klik

- Situs 3: 8,6 juta klik

- Situs 4: 4,8 juta klik

- Situs 5: 3,8 juta klik

- Situs 6: 3,4 juta klik

- Situs 7: 2,8 juta klik

- Situs 8: 1,4 juta klik

Kekosongan GSC: Gelap, Keruh, dan Tidak Meyakinkan

Pertama, realitas data GSC yang difilter sangat terpukul setelah mengekspor data berdasarkan kueri. Barry Schwartz meliput ini pada Juli 2022 setelah Patrick Stox menulis postingan yang menjelaskan apa yang dia lihat di seluruh situs dengan data pemfilteran GSC. Sungguh membuka mata untuk melihat berapa banyak data yang difilter untuk beberapa situs…

Saat saya memeriksa waktu di seluruh situs, saya juga melihat celah besar dalam data saat mengekspor berdasarkan kueri. Misalnya, total di bagian atas laporan Performa di GSC bisa jauh lebih besar daripada yang Anda lihat setelah mengekspor data dengan kueri (lalu menjumlahkan klik dan tayangan). Dan maksud saya CARA MATI. Untuk beberapa situs yang saya analisis saat itu, saya hanya melihat 20% dari total setelah mengekspor data. Ya, itu artinya 80% data sudah difilter.

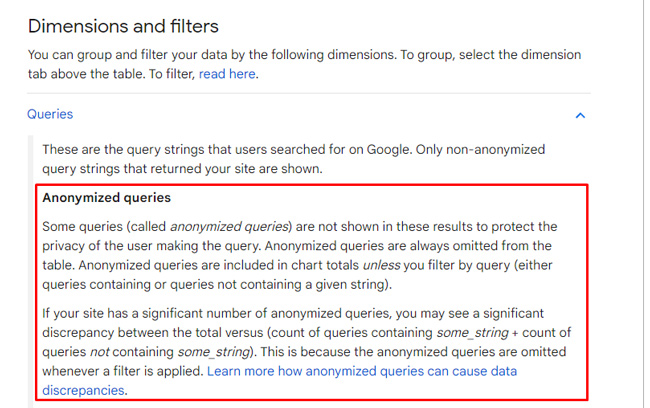

Alasannya adalah Google memfilter kueri berdasarkan masalah privasi. Dalam dokumentasinya, yang disempurnakan setelah penelitian Patrick, Google menjelaskan bahwa Google memfilter "kueri anonim" untuk melindungi privasi pengguna. Dan untuk beberapa situs, ini bisa menjadi satu ton data. Perlu dicatat bahwa mengekspor per halaman akan menghasilkan hasil lengkap (atau tutup), tetapi mengekspor dengan kueri menyoroti apa yang saya sebut kekosongan GSC.

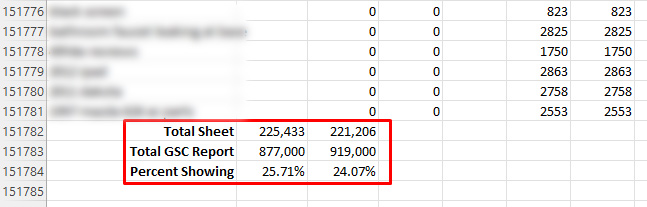

Kembali ke data pengguliran berkelanjutan… Untuk dua belas situs yang saya analisis, beberapa properti GSC hanya menyediakan 20-30% dari total data yang dilaporkan dalam pelaporan Performa karena pemfilteran. Anda membacanya dengan benar. Itu berarti 70-80% difilter untuk situs tersebut.

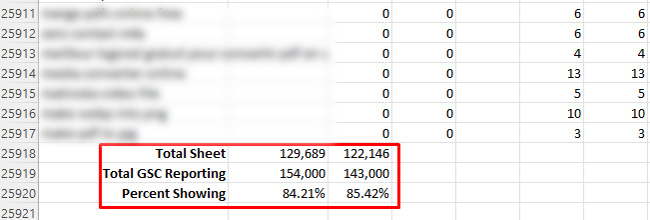

Di sisi lain, saya telah melihat setinggi 84% dari data yang ditampilkan (jadi 16% difilter), tetapi itu adalah yang paling banyak yang dapat saya temukan berdasarkan peninjauan sejumlah properti di GSC. Jangan salah paham, itu jauh lebih baik dari 24%!

Ketika saya melihat jumlah pemfilteran, saya tahu pekerjaan saya cocok untuk saya dengan mencoba menganalisis data. Saya berharap ada cukup banyak untuk melihat perubahan berdasarkan pengguliran terus menerus… Satu hal yang jelas, kekosongan GSC gelap dan keruh.

Gelap dan Keruh: Menganalisis dampak terhadap tayangan, klik, dan rasio klik-tayang.

Pertama, "Dark and Murky" bukanlah nama minuman baru yang trendi yang bisa Anda pesan di tepi kolam renang di sebuah resor. Itu hanya hal pertama yang saya katakan setelah melalui data di seluruh situs yang saya analisis. Ketika saya melewati halaman pertama hasil, angka di sebagian besar situs anjlok. Mereka turun begitu banyak sehingga hampir tidak mungkin untuk menarik kesimpulan apa pun tentang bagaimana pengguliran berkelanjutan memengaruhi klik dan rasio klik-tayang dari SERP desktop.

Dan dari sudut tayangan, saya tidak bisa melihat tren yang konsisten dengan peningkatan tayangan. Untuk beberapa kueri, tayangan memang meningkat. Bagi yang lain, mereka jatuh. Dan lagi, klik dan rasio klik-tayang sangat sulit untuk dianalisis karena angka yang sangat rendah di luar halaman satu.

Misalnya, segera setelah saya memeriksa spreadsheet untuk hasil halaman dua di beberapa situs, jumlah klik tidak penting. Omong-omong, itu menunjukkan kepada Anda berapa banyak data yang difilter… Di halaman pertama, beberapa kueri menghasilkan puluhan ribu klik, atau lebih. Lalu halaman dua turun hampir tidak ada? Jadi ya, kekosongan GSC itu nyata dan dapat sangat menghambat analisis Anda.

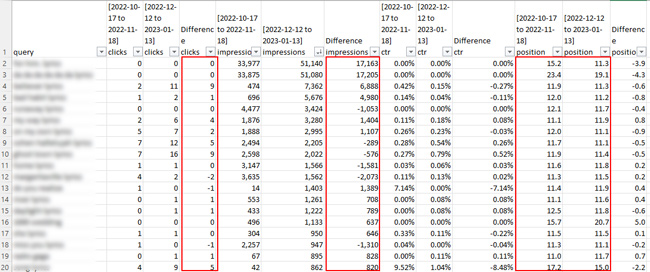

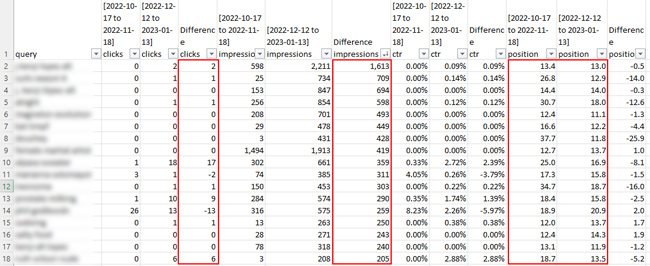

Berikut adalah beberapa tangkapan layar dari spreadsheet untuk halaman kedua dari hasil pencarian. Bersiaplah untuk menjadi underwhelmed dari sudut pandang klik. :)

Tapi, saya menyebutkan satu situs yang hanya memfilter 16% datanya (yang merupakan yang terbaik yang saya temukan dari dua belas). Untuk situs itu, Anda akan mengira saya memiliki cukup data untuk membuat beberapa kesimpulan… tetapi tidak juga. Klik sangat rendah setelah saya menganalisis halaman dua dan seterusnya. Saya dapat melihat bahwa tayangan meningkat untuk sejumlah kueri, tetapi klik tidak. Dan karena klik sangat rendah melebihi halaman satu, perbedaan rasio klik-tayang tidak ada gunanya untuk ditinjau.

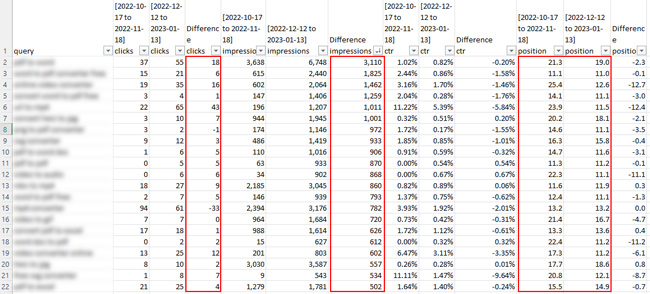

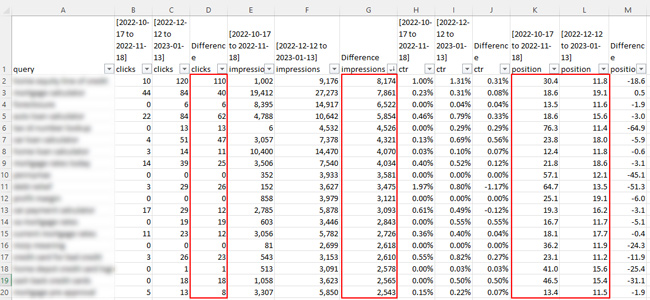

Berikut tangkapan layar dari situs yang hanya difilter 14%:

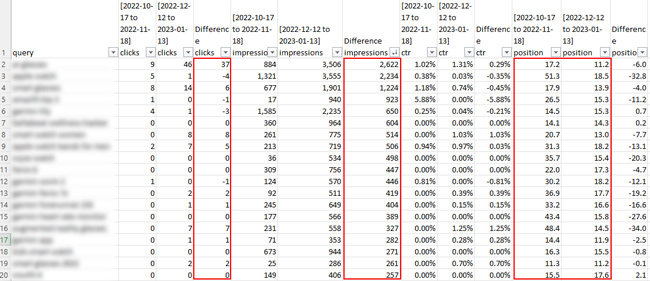

Misalnya, untuk satu kueri, jumlah tayangan melonjak sebesar 3.110, tetapi klik hanya meningkat sebesar 18. Posisi rata-rata naik dari 21,3 menjadi 19,0, mendekati, tetapi itu bisa berarti lompatan dari halaman tiga hasil ke dua. Jelas ini tidak cukup data untuk menarik kesimpulan apapun. Peningkatan tayangan adalah satu hal, tetapi kliknya sangat rendah sehingga tidak berarti banyak. Dan sejujurnya, siapa yang peduli dengan peningkatan tayangan jika klik tidak mengikuti. Bagi sebagian besar pemilik situs, ini sebenarnya bukan latihan branding. Mereka menginginkan klik dan konversi berikutnya! :)

Ini adalah situs lain yang mengalami peningkatan tayangan yang bagus untuk beberapa kueri, dan pastinya peningkatan klik untuk beberapa kueri. Konon, beberapa peningkatan disebabkan oleh peringkat situs yang jauh lebih kuat dalam jangka waktu terakhir. Ada peningkatan tayangan untuk beberapa kueri saat peringkat situs berada pada posisi yang sama, tetapi data klik tidak cukup untuk menarik kesimpulan yang serius...

Pengambilan kunci berdasarkan analisis Scroll Berkelanjutan di SERP desktop :

- Berdasarkan analisis saya di seluruh situs, TIDAK banyak data di halaman dua dan seterusnya untuk dianalisis… Itu bahkan berlaku untuk situs berskala besar dengan banyak lalu lintas organik Google. Itu didasarkan pada kueri anonim pemfilteran GSC.

- Saya dapat melihat peningkatan tayangan untuk beberapa kueri, tetapi sulit bagi saya untuk menarik kesimpulan karena ada banyak yang turun saat membandingkan kerangka waktu juga.

- Klik dan rasio klik-tayang bahkan lebih sulit untuk dianalisis. Tidak banyak klik untuk melaporkan secara keseluruhan di luar halaman satu, sehingga sangat sulit untuk menarik kesimpulan.

- Dari sudut pandang data GSC, saya memiliki data yang sangat terbatas berdasarkan pemfilteran GSC. Ini telah dilaporkan sebelumnya, dan penelitian ini menggarisbawahi seberapa banyak pemfilteran yang terjadi. Misalnya, beberapa ekspor hanya menghasilkan 20-30% dari data yang dilaporkan di GSC dalam pelaporan Performa (saat menganalisis dengan kueri).

- Saya merekomendasikan melalui proses ini untuk situs Anda sendiri menggunakan tutorial yang saya publikasikan (jika tidak ada alasan lain selain untuk melihat pemfilteran parah yang terjadi dengan data GSC saat mengekspor dengan kueri). Perhatikan, Anda harus dapat melihat data lengkap jika mengekspor berdasarkan halaman, tetapi ada banyak kueri yang mengarah ke halaman tertentu (yang dapat membuat analisis air berlumpur).

Rangkuman: Analisis Batas Kekosongan GSC dari Gulir Berkelanjutan di SERPs

Setelah pengguliran berkelanjutan diluncurkan di hasil pencarian desktop, saya sangat bersemangat untuk menganalisis dampaknya terhadap tayangan dan klik berdasarkan pengguna yang menggulir ke halaman dua dan seterusnya. Sayangnya, pemfilteran data GSC sangat menghambat upaya saya. Beberapa situs hanya mengembalikan 20-30% dari total data berdasarkan pemfilteran permintaan anonim GSC.

Saya pasti akan memperbarui posting ini jika saya menemukan temuan yang lebih kuat berdasarkan analisis pengguliran berkelanjutan di seluruh situs. Sementara itu, saya merekomendasikan melalui proses ini untuk situs Anda sendiri. Anda tidak pernah tahu, GSC mungkin tidak memfilter sebanyak mungkin data Anda… Semoga berhasil.

GG

– Glenn Gabe (@glenngabe) 11 Juli 2022

– Glenn Gabe (@glenngabe) 11 Juli 2022