Le défilement continu et le vide GSC : le lancement du défilement continu dans les résultats de recherche Google Desktop a-t-il eu un impact sur les impressions et les clics ? [Étudier]

Publié: 2023-01-25

Google a déployé le défilement continu dans les résultats de recherche sur ordinateur pour les requêtes en anglais aux États-Unis le 5 décembre 2022. Le défilement continu permet aux utilisateurs de continuer de manière transparente à la page deux et au-delà sans avoir à cliquer sur un bouton « Suivant » au bas des résultats. . Cela fait suite au déploiement par Google du défilement continu dans les résultats mobiles en octobre 2021 (encore une fois, uniquement aux États-Unis pour les requêtes en anglais).

Voici l'annonce de Google concernant le déploiement sur ordinateur début décembre (avec un gif de défilement continu en action) :

Après le déploiement sur ordinateur, beaucoup se sont demandé quel impact le défilement continu aurait sur la visibilité des classements au-delà de la première page. Par exemple, pour les sites dont les URL sont classées sur la page deux, et peut-être même en haut de la page deux, la possibilité pour les utilisateurs de faire défiler facilement des pages supplémentaires de résultats de recherche devrait entraîner davantage d'impressions, de clics et de conversions. C'est l'idée de toute façon, et quelque chose que j'ai entrepris d'analyser.

Avant le déploiement continu du défilement dans les SERP, le classement à la page deux et au-delà signifiait que vos annonces ne seraient probablement pas beaucoup vues. Bien sûr, certaines personnes s'aventureraient à la page deux et au-delà, mais la plupart s'en tiendraient à la première page (et affineraient simplement leur recherche si elles ne trouvaient pas ce dont elles avaient besoin après avoir scanné les résultats). Mais avec le défilement continu, les utilisateurs peuvent facilement passer à la deuxième page de résultats sans avoir à cliquer sur un bouton. Les nouveaux résultats s'affichent lorsque vous approchez du bas de l'ensemble initial de résultats.

Analyse du défilement continu dans les résultats de recherche de bureau aux États-Unis :

Juste après le déploiement du défilement continu sur ordinateur, j'ai publié un article expliquant comment analyser l'évolution des impressions, des clics et du taux de clics en fonction du fait que les utilisateurs peuvent afficher de manière transparente plus d'annonces dans les résultats de recherche. Mon didacticiel explique comment utiliser l'API GSC et Analytics Edge dans Excel pour exporter en masse des données depuis GSC, filtrer par ordinateur uniquement depuis les États-Unis, comparer les délais, puis filtrer par page deux et trois résultats. Les feuilles de travail qui en résultent fournissent rapidement les changements entre les métriques lors de la comparaison de la période avant et après le déploiement du défilement continu.

Après avoir publié cet article, j'attendais avec impatience que davantage de données soient créées afin d'approfondir les rapports sur les sites. Et c'est exactement ce que j'ai fait pour un certain nombre de sites à travers les marchés verticaux. Je savais que les sites auraient une tonne de données à analyser, et à travers les secteurs verticaux, il devrait donc être plus facile de voir les différences basées sur le déploiement continu du défilement dans les SERP de bureau aux États-Unis.

Ci-dessous, je couvrirai la méthodologie que j'ai utilisée, les données que j'ai analysées, certaines découvertes intéressantes (et effrayantes) sur les données de GSC et l'impact, ou son absence, du défilement continu dans les résultats de recherche sur ordinateur. Allons-y.

Méthodologie:

Tout d'abord, j'ai sélectionné douze sites différents qui génèrent un trafic constant et important de Google organique. Certaines des propriétés sont des sites à grande échelle générant beaucoup de clics à partir de Google organique, tandis que d'autres étaient des sites de niche générant moins de trafic (mais toujours une bonne quantité de clics). Je me suis assuré que les sites étaient à travers les verticales, et que ces verticales n'étaient pas fortement impactées par les vacances (autant que je le pouvais). De plus, je me suis assuré de me concentrer uniquement sur les résultats de bureau des États-Unis, car le défilement continu n'a pas encore été déployé à l'international.

Ensuite, j'ai utilisé le processus que j'ai tracé dans mon didacticiel pour analyser l'évolution des métriques en fonction de l'exportation de données de GSC en masse, du filtrage par ordinateur uniquement depuis les États-Unis, de la comparaison des délais, puis du filtrage par page deux et trois résultats. Vous pouvez consulter mon didacticiel pour savoir comment y parvenir à l'aide de l'API GSC, d'Excel et d'Analytics Edge.

Lors de l'analyse des données, je me suis assuré d'examiner les requêtes où la position moyenne était à peu près la même avant et après le déploiement du défilement continu. Par exemple, je n'examinerais pas une requête classée 24 avant la mise à jour, puis 16 après. C'est une grande différence et cela pourrait évidemment avoir un impact sur les données. J'ai recherché des requêtes où le site se classait à peu près à la même position afin de mieux analyser si le défilement continu avait un impact sur la visibilité et l'engagement.

En ce qui concerne le trafic de recherche organique de Google pour les douze sites, j'ai fourni le nombre de clics au cours des trois derniers mois pour chacun des sites que j'ai analysés (juste pour que vous ayez une idée du trafic qu'ils ont généré récemment depuis Google).

Les sites variaient de 89 millions de clics à 1,4 million de clics au cours des trois derniers mois et couvraient un certain nombre de secteurs verticaux :

- Site 1 : 89 millions de clics

- Site 2 : 31 millions de clics

- Site 3 : 8,6 millions de clics

- Site 4 : 4,8 millions de clics

- Site 5 : 3,8 millions de clics

- Site 6 : 3,4 millions de clics

- Site 7 : 2,8 millions de clics

- Site 8 : 1,4 million de clics

Le GSC Void : sombre, trouble et peu concluant

Tout d'abord, la réalité des données GSC filtrées a frappé durement après l'exportation de données basées sur une requête. Barry Schwartz a couvert cela en juillet 2022 après que Patrick Stox a écrit un article expliquant ce qu'il voyait sur les sites avec des données de filtrage GSC. C'était révélateur de voir combien de données étaient filtrées pour certains sites…

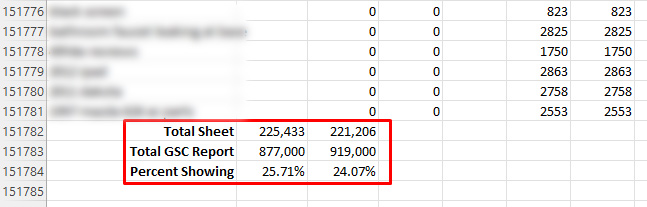

Lorsque j'ai vérifié à l'époque sur plusieurs sites, j'ai également constaté d'énormes lacunes dans les données lors de l'exportation en fonction de la requête. Par exemple, le total en haut du rapport sur les performances dans GSC peut être bien supérieur à ce que vous voyez après avoir exporté les données par requête (puis totalisé les clics et les impressions). Et je veux dire WAY OFF. Pour certains sites que j'ai analysés à l'époque, je ne voyais que 20 % du total après avoir exporté les données. Oui, cela signifie que 80 % des données ont été filtrées.

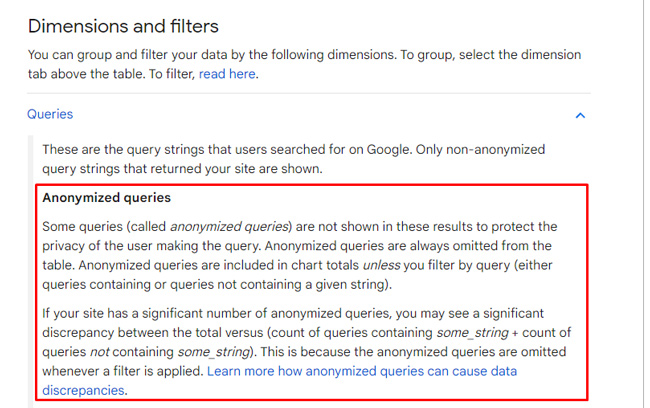

La raison en est que Google filtre les requêtes en fonction des problèmes de confidentialité. Dans sa documentation, qu'il a peaufinée après l'étude de Patrick, Google explique qu'il filtre les "requêtes anonymisées" pour protéger la vie privée des utilisateurs. Et pour certains sites, cela peut représenter une tonne de données. Il convient de noter que l'exportation par page donnera les résultats complets (ou proches), mais l'exportation par requête met en évidence ce que j'appelle le vide GSC.

Retour aux données de défilement continu… Pour les douze sites que j'ai analysés, certaines propriétés de GSC n'ont fourni que 20 à 30 % des données totales rapportées dans le rapport de performance en raison du filtrage. Vous avez bien lu. Cela signifie que 70 à 80 % ont été filtrés pour ces sites.

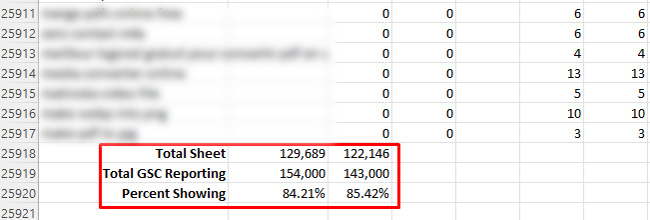

D'un autre côté, j'ai vu jusqu'à 84 % des données affichées (donc 16 % filtrées), mais c'est le maximum que j'ai pu trouver en examinant un certain nombre de propriétés dans GSC. Ne vous méprenez pas, c'est bien mieux que 24 % !

Quand j'ai vu la quantité de filtrage, j'ai su que j'avais du pain sur la planche en essayant d'analyser les données. J'espérais qu'il y en avait assez pour voir les changements basés sur le déploiement continu du défilement… Une chose était claire, le vide GSC était sombre et trouble.

Sombre et trouble : analyse de l'impact sur les impressions, les clics et le taux de clics.

Tout d'abord, "Dark and Murky" n'est pas le nom d'une nouvelle boisson à la mode que vous pouvez commander au bord de la piscine d'un complexe. C'est juste la première chose que j'ai dite après avoir parcouru les données des sites que j'ai analysés. Lorsque j'ai dépassé la première page de résultats, les chiffres sur la plupart des sites chutent. Ils chutent tellement qu'il est presque impossible de tirer des conclusions sur l'impact du défilement continu sur les clics et le taux de clics à partir des SERP de bureau.

Et du point de vue des impressions, je n'ai pas pu voir de tendance cohérente avec l'augmentation des impressions. Pour certaines requêtes, les impressions ont augmenté. Pour d'autres, ils ont chuté. Et encore une fois, les clics et le taux de clics étaient très difficiles à analyser en raison des chiffres incroyablement bas au-delà de la première page.

Par exemple, dès que j'ai vérifié la feuille de calcul pour les résultats de la page deux sur plusieurs sites, le nombre de clics était sans conséquence. Cela vous montre combien de données sont filtrées, soit dit en passant… Sur la première page, certaines requêtes génèrent des dizaines de milliers de clics, voire plus. Ensuite, la page deux tombe à presque rien ? Alors oui, le vide GSC est réel et il peut gravement entraver votre analyse.

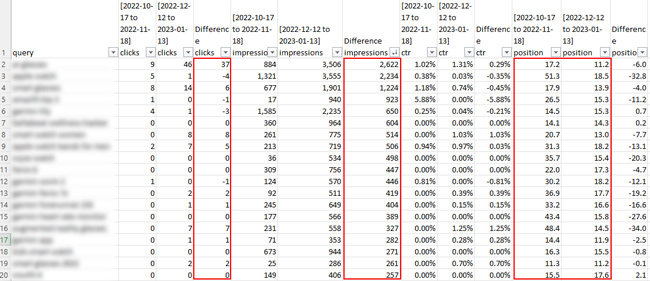

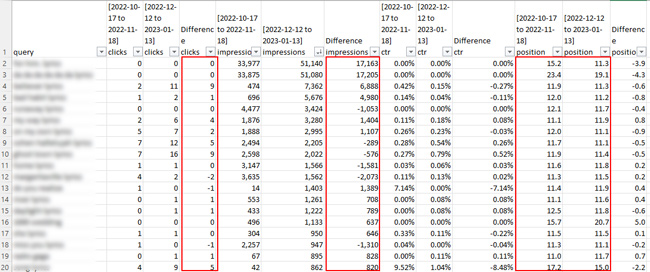

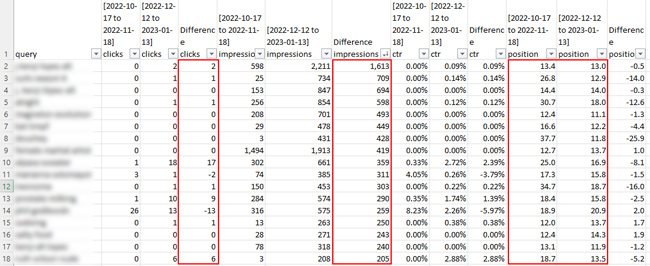

Voici quelques captures d'écran des feuilles de calcul pour la page deux des résultats de recherche. Préparez-vous à être déçu du point de vue des clics. :)

Mais, j'ai mentionné un site qui n'avait filtré que 16% de ses données (ce qui était le meilleur que j'ai rencontré sur les douze). Pour ce site, on pourrait penser que j'aurais suffisamment de données pour tirer des conclusions… mais pas vraiment. Les clics étaient très faibles une fois que j'ai analysé la page deux et au-delà. J'ai pu voir que les impressions ont augmenté pour un certain nombre de requêtes, mais pas les clics. Et comme les clics étaient si bas au-delà de la première page, la différence de taux de clics était inutile à examiner.

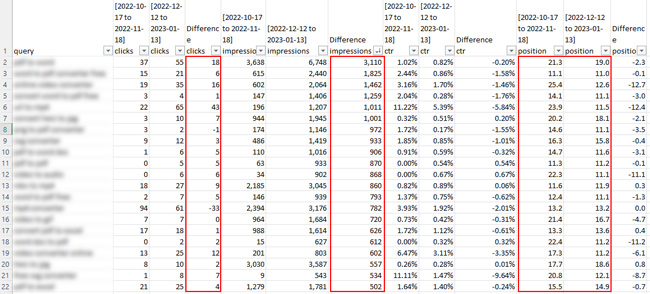

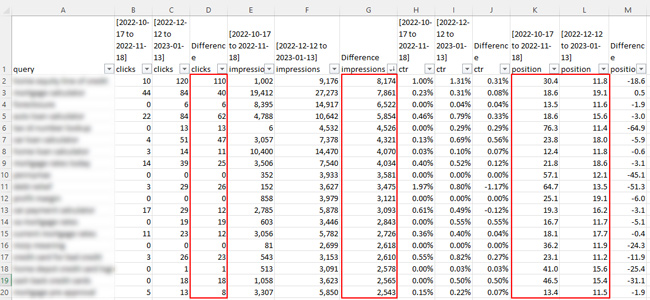

Voici une capture d'écran du site qui n'a été filtré qu'à 14 % :

Par exemple, pour une requête, le nombre d'impressions a bondi de 3 110, mais les clics n'ont augmenté que de 18. La position moyenne est passée de 21,3 à 19,0, ce qui est proche, mais cela aurait pu signifier un saut de la page trois des résultats à deux. Clairement, ce n'est pas assez de données pour tirer des conclusions. L'augmentation des impressions est une chose, mais les clics étaient si faibles que cela ne signifiait pas grand-chose. Et pour être honnête, qui se soucie vraiment d'une augmentation des impressions si les clics ne suivent pas. Pour la plupart des propriétaires de sites, ce n'est pas vraiment un exercice d'image de marque. Ils veulent les clics et les conversions subséquentes ! :)

Voici un autre site où il y a eu une belle augmentation des impressions pour certaines requêtes, et certainement une augmentation des clics pour certaines requêtes. Cela dit, certaines des augmentations étaient dues au classement du site beaucoup plus fort au cours de la dernière période. Il y a eu une augmentation des impressions pour certaines requêtes lorsque le site s'est classé à peu près à la même position, mais il n'y a tout simplement pas assez de données sur les clics pour tirer des conclusions sérieuses…

Points clés basés sur l'analyse du défilement continu dans les SERP de bureau :

- D'après mon analyse sur tous les sites, il n'y a PAS beaucoup de données sur la page deux et au-delà à analyser… C'est même le cas pour les sites à grande échelle avec une tonne de trafic organique Google. Cela est basé sur le filtrage GSC des requêtes anonymisées.

- J'ai pu constater une augmentation du nombre d'impressions pour certaines requêtes, mais il m'était difficile de tirer des conclusions car il y en avait beaucoup qui ont également chuté lors de la comparaison des délais.

- Les clics et le taux de clics étaient encore plus difficiles à analyser. Il n'y a pas eu beaucoup de clics pour signaler globalement au-delà de la première page, ce qui a rendu très difficile de tirer des conclusions.

- Du point de vue des données GSC, j'avais des données très limitées basées sur le filtrage GSC. Cela a déjà été signalé, et cette étude a souligné à quel point le filtrage est en cours. Par exemple, certaines des exportations ne produisaient que 20 à 30 % des données déclarées dans GSC dans les rapports sur les performances (lors de l'analyse par requête).

- Je recommande de suivre ce processus pour vos propres sites en utilisant le didacticiel que j'ai publié (si ce n'est pour aucune autre raison que de voir le filtrage sévère en cours avec les données GSC lors de l'exportation par requête). Notez que vous devriez être en mesure de voir les données complètes si vous exportez par page, mais il existe de nombreuses requêtes qui mènent à des pages spécifiques (ce qui peut compliquer l'analyse).

Résumé : L'analyse des limites de vide de GSC sur le défilement continu dans les SERP

Après le défilement continu déployé dans les résultats de recherche sur ordinateur, j'étais extrêmement enthousiaste à l'idée d'analyser l'impact sur les impressions et les clics en fonction du défilement des utilisateurs vers la page deux et au-delà. Malheureusement, le filtrage des données GSC a considérablement entravé mes efforts. Certains sites ne renvoyaient que 20 à 30 % des données totales sur la base du filtrage par GSC des requêtes anonymisées.

Je ne manquerai pas de mettre à jour ce message si je tombe sur des résultats plus solides basés sur l'analyse du défilement continu sur les sites. En attendant, je vous recommande de suivre ce processus pour vos propres sites. On ne sait jamais, GSC ne filtre peut-être pas autant de vos données… Bonne chance.

GG

– Glenn Gabe (@glenngabe) 11 juillet 2022

– Glenn Gabe (@glenngabe) 11 juillet 2022