As 5 principais coisas que podem prejudicar seus rankings de pesquisa

Publicados: 2022-06-01

Se você está lendo isso, é provável que a estratégia de aquisição de clientes da sua marca dependa muito da otimização de mecanismos de pesquisa (SEO). E você quer ter certeza de que não está perdendo dinheiro, aproveitando estratégias contra-intuitivas. Mas, como você pode identificar práticas que podem prejudicar seus rankings de busca?

Uma consideração com SEO é que o Google e outros mecanismos de busca não revelam diretamente como o algoritmo funciona. Em vez disso, os profissionais de SEO precisam estudar padrões, executar testes independentes e medir o crescimento para deduzir estratégias eficazes. Isso significa efetivamente que práticas que não deveriam ter sido feitas encontraram uma maneira de se infiltrar para “enganar os mecanismos de busca”.

Líderes na área coletaram evidências ao longo dos anos que confirmam que algumas práticas de SEO realmente prejudicam os rankings a longo prazo. Algumas das evidências para essas descobertas vêm diretamente das diretrizes para webmasters da Central de Pesquisa do Google. Isso aumenta a importância de ficar longe de tais práticas questionáveis.

Para ajudá-lo a restringir seus esforços de SEO para que você não sabote seus próprios rankings de pesquisa e incorra em penalidades manuais do Google, discutiremos os 5 principais fatores difundidos que podem prejudicar seus rankings de pesquisa.

Também vale a pena notar que nem todas as flutuações nos rankings de busca são causadas por algo que está errado em seu site. Coisas como atualizações não confirmadas do algoritmo do Google também podem levar a uma mudança nos rankings.

É por isso que é crucial que você seja capaz de identificar o problema exato para garantir que seu tempo e dinheiro sejam gastos em coisas que realmente precisam ser corrigidas.

Vamos explorar mais como você pode diagnosticar o problema, entender a gravidade dos riscos e, finalmente, tomar medidas para corrigir coisas que já podem ter dado errado.

1. Links manipuladores de baixa qualidade

Desde que a pesquisa do Google começou a usar o algoritmo PageRank para determinar as classificações de pesquisa, os backlinks têm sido um dos fatores mais críticos para ganhar nas páginas de resultados do mecanismo de pesquisa (SERPs).

No entanto, o algoritmo do Google faz uma distinção entre backlinks recebidos de fontes confiáveis e aqueles obtidos por meio de esquemas de links. O Google trata links de sites com spam ou aqueles obtidos por meio de métodos “não naturais”, como guest posts pagos, como manipuladores e de baixa qualidade.

Eles violam diretamente as diretrizes para webmasters do Google. Por sua vez, eles abrem seu site com o risco de serem desindexados do índice de pesquisa do Google ou incorrerem em uma ação manual.

Como identificar links de baixa qualidade

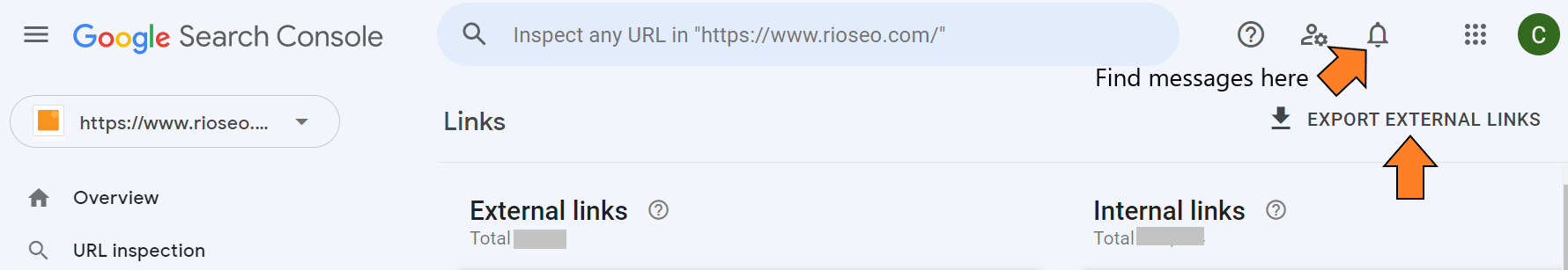

As mensagens do site do Google Search Console devem mostrar se o Google enviou uma mensagem solicitando a correção desses links.

Se você não recebeu uma mensagem, você deve navegar até Search Traffic > Links to Your Site. Você pode exportar a lista e identificar domínios com baixo tráfego e alta pontuação de spam. A própria documentação do Google deve servir como referência para os links que você mantém e dos quais se livra.

O conserto

Depois de identificar qualquer link não natural, você pode enviar um e-mail para cada um dos webmasters, solicitando que removam os links para seu site. Se esses links de baixa qualidade ainda estiverem presentes após 6 a 8 semanas, você poderá rejeitá-los, e isso deve resolver o problema.

Se você recebeu uma penalidade manual, precisa rejeitar links artificiais e enviar um pedido de reconsideração do Google Search Console.

2. Qualidade do conteúdo e intenção do usuário

Ao atualizar ou alterar o conteúdo do seu site, você precisa garantir uma qualidade excepcional e um conteúdo relevante que atenda à intenção de pesquisa da consulta na qual ele deve ser classificado.

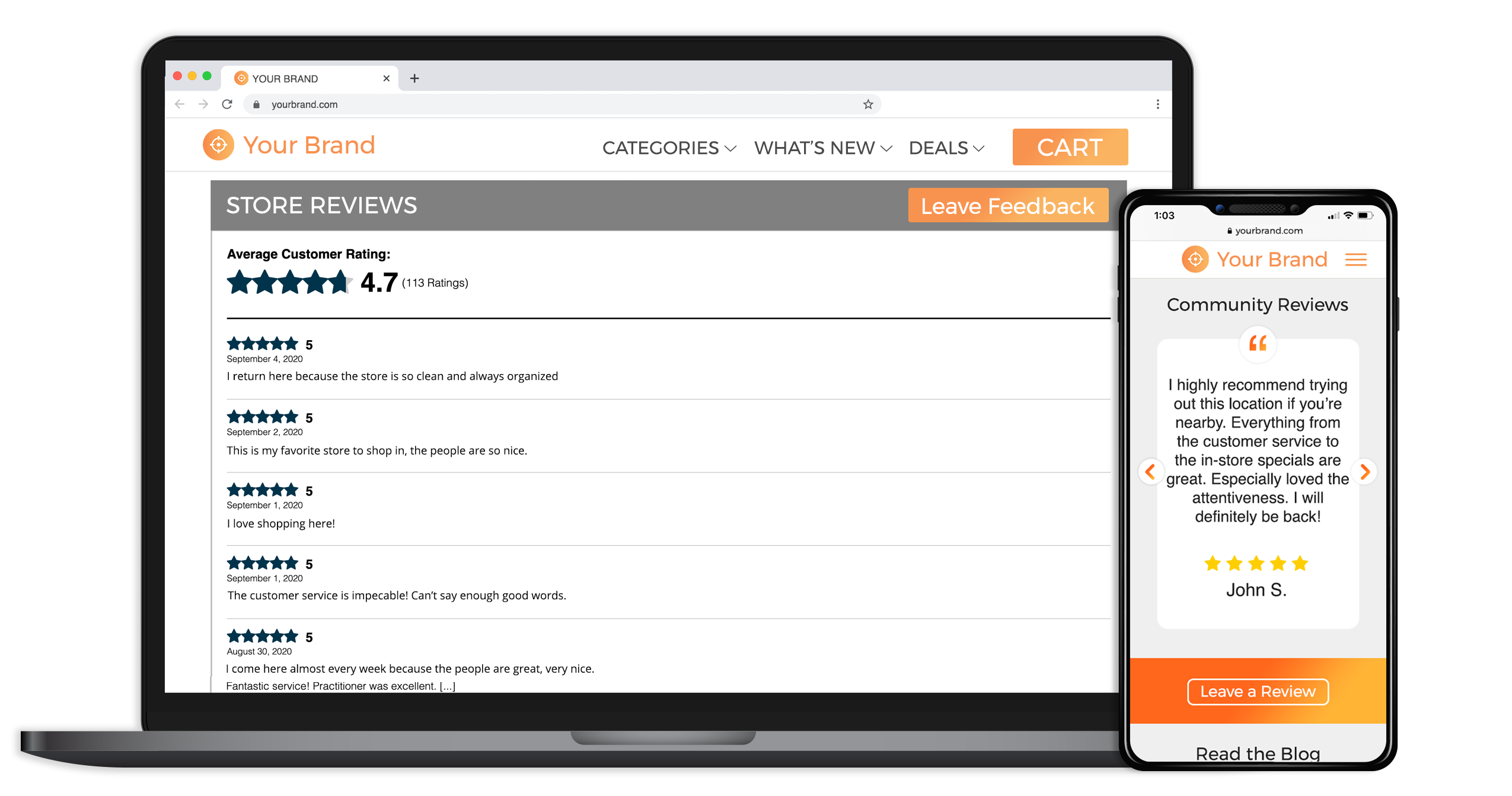

O Google define um conteúdo como “alta qualidade” quando possui as informações mais atualizadas, uma voz envolvente, provas sociais como avaliações ou depoimentos ou vem de recursos confiáveis na área. A segurança de uma página da web também pode influenciar como o Google e os usuários reais visualizam a qualidade do conteúdo, por isso é essencial focar nela.

Exemplo de prova social em uma página da web e celular

Em seguida, vem a intenção de pesquisa por trás do seu conteúdo, que é a essência de como o algoritmo do Google funciona. É assim que o Google mantém seu domínio como o mecanismo de pesquisa mais usado globalmente e se diferencia de empresas como o Bing, que pode mostrar resultados de pesquisa menos relevantes.

A intenção do usuário de pesquisa serve como o “porquê” por trás de uma consulta de pesquisa para qualquer palavra-chave de destino. Ele faz isso fazendo uma distinção sobre o que um usuário pode querer dizer quando digita algo como “café” na barra de pesquisa versus “cafés perto de mim”.

Uma rápida pesquisa no Google mostrará que ambas as palavras-chave tendem a exibir diferentes recursos de SERP, bem como o número de blogs versus lojas que aparecem diferem significativamente.

Como diagnosticar o problema de conteúdo

Se você perdeu a classificação após fazer alterações no conteúdo e determinou que não há outros fatores em jogo, você pode fazer o seguinte:

- Exporte todas as páginas classificadas do seu painel do Google Analytics e compare o conteúdo com um backup mais antigo do seu site.

- Instale uma ferramenta como OnWebChange que o notifique sobre quaisquer alterações feitas no design ou conteúdo do seu site (opção recomendada).

O conserto

Você pode usar o backup antigo do seu site para reescrever o texto problemático e criar conteúdo novo e de alta qualidade. Você também pode adicionar palavras-chave relevantes ausentes ao seu novo conteúdo e personalizar o conteúdo para ser mais adequado ao tipo de conteúdo que o Google prefere exibir na SERP para as palavras-chave de foco que você está segmentando.

3. Metadados

Os metadados ajudam o Googlebot a entender amplamente sobre o que é a página. Alterar ou usar uma tag de título errada, em particular, pode afetar negativamente a compreensão do Google sobre o conteúdo da página.

Como meta tags, como título e meta descrição, também são exibidas nas SERPs, não ter as corretas no lugar também pode afetar quantos cliques você recebe.

Em geral, os metadados podem afetar tanto a experiência do usuário quanto o SEO. Certificar-se de que o título da página é a descrição mais precisa do conteúdo da página é fundamental. Mesmo alterar sua tag de título de “SEO para empresas” para “Empresa de SEO para empresas” pode influenciar a forma como o algoritmo visualiza sua página.

Embora a meta descrição em si não seja um fator de classificação, como ter a tag de título correta, ela não pode ser negligenciada. Sem cliques adequados, quaisquer classificações de pesquisa são tornadas sem sentido de qualquer maneira. Trabalhar de acordo com as diretrizes especificadas pelo Google para metadados é fundamental para controlar como ele aparece na pesquisa.

É porque o Google ainda pode optar por mostrar outra coisa nos snippets em vez do que você prescreveu inicialmente, especialmente se você não especificou o comprimento de cada atributo de metadados. Garantir que você tenha o comprimento correto das tags de título e da meta descrição reduz a probabilidade de as SERPs do Google truncarem ou alterarem os metadados desejados para os usuários.

Como diagnosticar um problema de metadados

Seu SEO ou desenvolvedor da web deve ter uma lista de todas as alterações que foram feitas nos metadados das páginas da web recentemente. Se não, é hora de começar a documentar isso internamente.

Em seguida, use uma ferramenta como o Screaming Frog para rastrear o site para que você possa ter uma visão geral rápida das novas metatags na pesquisa orgânica. Você pode comparar essas alterações recentes com um backup mais antigo do site.

O conserto

Depois de ter as informações de metadados antigos e novos, inicie uma planilha e liste os metadados antigos e novos em colunas próximas umas das outras. Reverter seu site para os metadados antigos deve resolver o problema.

Você também pode adicionar quaisquer palavras-chave relevantes ausentes dos metadados antigos ao novo. Aguarde o Googlebot rastrear novamente a página e veja se isso corrige o problema.

4. Táticas de SEO manipuladoras

Assim como os esquemas de links, existem algumas outras táticas que os profissionais de SEO implantam para ganhos rápidos que podem facilmente sair pela culatra. Essas táticas são percebidas como spam e/ou tentativas de manipular os rankings de busca. Isso vai contra a missão do Google de mostrar primeiro o resultado de pesquisa mais relevante. Aqui estão algumas dessas táticas prejudiciais.

Preenchimento de palavras-chave

Muitas vezes, os SEOs enchem uma página com palavras-chave e transformam a cor na mesma cor de fundo para manipular os mecanismos de pesquisa. Outras vezes, o usuário acessa a página e lê um conteúdo que não faz sentido.

Alguns SEOs são conhecidos por adicionar essas palavras-chave como uma lista ou um grupo de uma maneira que está fora de contexto e desafia as regras padrão de linguagem e sintaxe.

Páginas de entrada e camuflagem

Você já pesquisou por um torrent e foi direcionado para um site de spam ou pornográfico?

Ao usar a camuflagem, os SEOs tentam manipular os mecanismos de pesquisa mostrando conteúdo diferente para usuários e mecanismos de pesquisa. Depois que o usuário clica no resultado da pesquisa, a página geralmente redireciona para uma página com spam ou inútil que não tem nada a ver com o que o usuário deseja ver.

A camuflagem geralmente é feita em conjunto com as páginas de entrada. Os SEOs criam várias páginas para classificar palavras-chave específicas e as usam como uma “porta” para a página de conteúdo principal – o que pode ser totalmente inútil para o usuário.

Ambos violam claramente as diretrizes para webmasters, e o Google vem implementando penalidades severas para combater seu uso.

Massas de conteúdo gerado por IA

De acordo com John Mueller, do Google, todo conteúdo gerado por IA é contra suas diretrizes.

“Para nós, eles ainda se enquadram na categoria de conteúdo gerado automaticamente, algo que temos nas Diretrizes para webmasters desde quase o início”, ele respondeu durante um hangout no horário comercial do Google Search Central SEO quando perguntado sobre o uso de ferramentas de escrita AI alimentadas por GPT-3.

Quando questionado sobre se o Google pode detectar automaticamente o uso de conteúdo de IA, ele acrescentou que não poderia afirmar isso. Ele deu a entender que apenas a equipe humana poderia encontrar e agir contra o conteúdo gerado pela IA.

Muitos SEOs, incluindo alguns dos principais nomes da área, acreditam fortemente que o conteúdo de IA totalmente gerado por IA é lixo. Mas muitos ainda defendem seu uso para verificação de fatos, revisão, edição e refinamento de conteúdo.

Miranda Miller, do Search Engine Journal, apoiou essa visão. “A Associated Press começou a usar a IA para geração de histórias em 2014. Colocar a IA para trabalhar na criação de conteúdo não é novidade, e o fator mais importante aqui é sua aplicação inteligente”, acrescentou, ressaltando que a IA pode ajudar os criadores de conteúdo a superar a linguagem e barreiras de alfabetização, melhorar a qualidade de sua escrita e muito mais.

5. Velocidade lenta do site

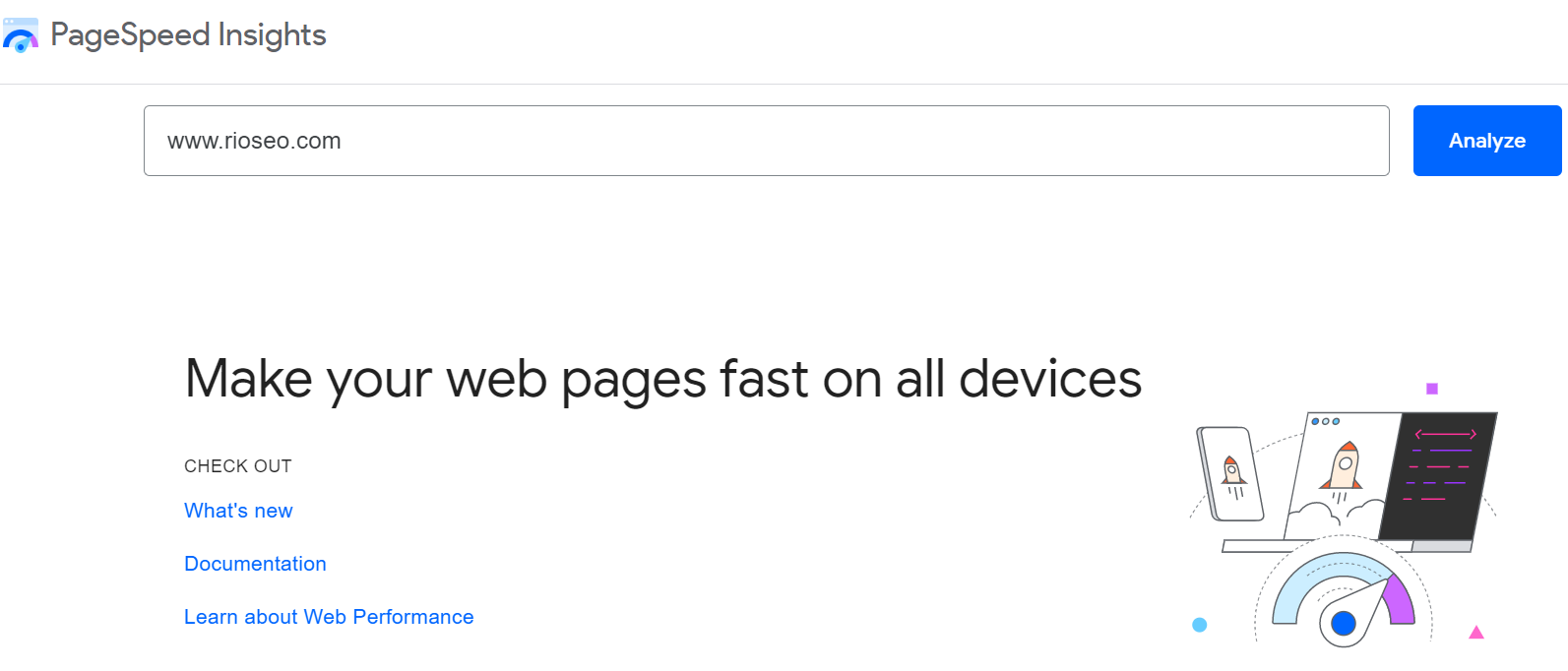

Desde um anúncio em 2010 em seu hub de desenvolvedores, o Google usou a velocidade do site e a experiência do usuário como fatores de classificação. Ele também oferece sua própria ferramenta PageSpeed Insight, apoiando ainda mais essa afirmação.

Nos últimos anos, a velocidade do site tem sido vista dentro do espectro mais amplo da “Experiência de página ideal”, que combina as principais características da Web com compatibilidade com dispositivos móveis, navegação segura, velocidade do site, segurança etc.

De acordo com o Google, este é um esforço para levar às pessoas a experiência mais útil e agradável na web.

Um trecho da Central de pesquisa do Google diz: "Incentivamos você a começar a observar a velocidade do seu site (as ferramentas acima fornecem um ótimo ponto de partida) - não apenas para melhorar sua classificação nos mecanismos de pesquisa, mas também para melhorar a experiência de todos na Internet .”

Além da classificação de pesquisa, a velocidade do site também afeta a taxa de rejeição. De acordo com Websitesetup.org, um tempo de carregamento de 6 segundos pode aumentar a taxa de rejeição em até 106%. Portanto, a esse respeito, vale a pena prestar atenção tanto nas classificações de pesquisa quanto nas conversões.

Como diagnosticar um problema de velocidade do site

Um tempo de carregamento de 0-2 segundos é recomendado. Você pode usar a ferramenta PageSpeedInsights ou GTMatrix para verificar o tempo de carregamento do seu site.

O conserto

Há muitas coisas que um desenvolvedor web ou SEO pode fazer para acelerar seu site. Isso inclui minimizar o Javascript, otimizar imagens e vídeos, melhorar o tempo de resposta do servidor e reduzir redirecionamentos.

Use o relatório gerado pela ferramenta que você usa como ponto de partida para começar a melhorar a velocidade do seu site e os Core Web Vitals.

Conclusão

O SEO pode ser complicado e demorado – portanto, restringir e jogar o jogo a longo prazo é a chave para obter um bom ROI.

No final das contas, o Google é claro sobre o que está procurando: a melhor resposta para as necessidades exclusivas de cada pesquisador. Portanto, tudo o que você pode fazer para posicionar sua página como a melhor resposta para consultas relevantes e evitar erros que contrariem esses esforços é mais um passo na escada dos rankings de pesquisa.

Se você estiver interessado em ler mais sobre os fatores que podem influenciar positivamente as classificações de pesquisa, recomendamos os seguintes recursos:

- Fatores de classificação da pesquisa local em 2021: um guia para marcas em 2022

- Como apoiar seus rankings locais com SEO orgânico

- O efeito do conteúdo duplicado no SEO para marcas de vários locais