Las 5 cosas principales que pueden dañar sus clasificaciones de búsqueda

Publicado: 2022-06-01

Si está leyendo esto, es probable que la estrategia de adquisición de clientes de su marca se base en gran medida en la optimización de motores de búsqueda (SEO). Y quiere asegurarse de no perder dinero aprovechando estrategias contrarias a la intuición. Pero, ¿cómo puede identificar las prácticas que pueden dañar sus clasificaciones de búsqueda?

Una consideración con SEO es que Google y otros motores de búsqueda no revelan directamente cómo funciona su algoritmo. En cambio, los profesionales de SEO tienen que estudiar patrones, ejecutar pruebas independientes y medir el crecimiento para deducir estrategias efectivas. Efectivamente, significa que las prácticas que no deberían haberse hecho han encontrado una manera de colarse para "jugar con los motores de búsqueda".

Los líderes en el campo han recopilado evidencia a lo largo de los años que confirma que algunas prácticas de SEO en realidad dañan las clasificaciones a largo plazo. Parte de la evidencia de estos hallazgos proviene directamente de las pautas para webmasters de Google Search Central. Esto promueve la importancia de mantenerse alejado de tales prácticas cuestionables.

Para ayudarlo a reducir sus esfuerzos de SEO para que, sin saberlo, no sabotee sus propios rankings de búsqueda e incurra en sanciones manuales de Google, discutiremos los 5 principales factores generalizados que pueden dañar sus rankings de búsqueda.

También vale la pena señalar que no todas las fluctuaciones en las clasificaciones de búsqueda son causadas por algo que está mal en su sitio web. Cosas como las actualizaciones de algoritmos de Google no confirmadas también pueden conducir a un cambio en las clasificaciones.

Esta es la razón por la que es crucial que pueda identificar el problema exacto para asegurarse de que tanto su tiempo como su dinero se gasten en cosas que realmente requieren reparación.

Exploremos más a fondo cómo puede diagnosticar el problema, comprender la gravedad de los riesgos y, finalmente, tomar medidas para solucionar las cosas que podrían haber salido mal.

1. Enlaces manipuladores de baja calidad

Desde que la búsqueda de Google comenzó a usar el algoritmo PageRank para determinar las clasificaciones de búsqueda, los vínculos de retroceso han sido uno de los factores más críticos para ganar en las páginas de resultados del motor de búsqueda (SERP).

Sin embargo, el algoritmo de Google distingue entre los backlinks recibidos de fuentes confiables y los obtenidos a través de esquemas de enlaces. Google trata los enlaces de sitios web fraudulentos o aquellos obtenidos a través de métodos "antinaturales", como publicaciones pagas de invitados, como manipuladores y de baja calidad.

Estos están directamente en violación de las directrices para webmasters de Google. A su vez, abren su sitio web con el riesgo de ser desindexado del índice de búsqueda de Google o incurrir en una acción manual.

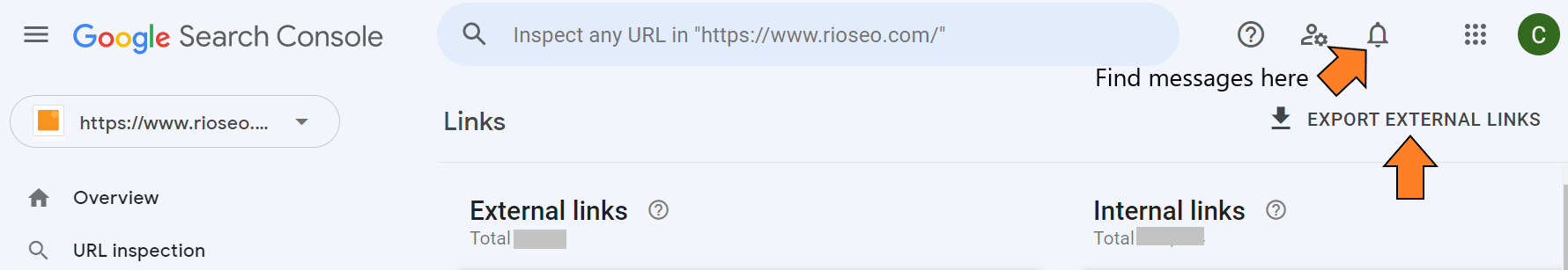

Cómo identificar enlaces de baja calidad

Los mensajes de su sitio de Google Search Console deberían mostrarle si Google le ha enviado un mensaje pidiéndole que corrija esos enlaces.

Si no ha recibido un mensaje, debe navegar a Tráfico de búsqueda > Enlaces a su sitio. Puede exportar la lista e identificar dominios con poco tráfico y alto puntaje de spam. La propia documentación de Google debería servir como referencia para los enlaces que conserva y los enlaces de los que se deshace.

La solución

Una vez que se haya concentrado en los enlaces no naturales, puede enviar un correo electrónico a cada uno de los webmasters, solicitándoles que eliminen los enlaces a su sitio web. Si esos enlaces de baja calidad siguen presentes después de 6 a 8 semanas, puede desautorizarlos y eso debería solucionar el problema.

Si recibió una sanción manual, debe desautorizar los enlaces no naturales y presentar una solicitud de reconsideración de Google Search Console.

2. Calidad del contenido e intención del usuario

Al actualizar o cambiar el contenido de su sitio web, debe asegurarse de tener una calidad excepcional y contenido relevante que cumpla con la intención de búsqueda de la consulta en la que se supone que debe clasificarse.

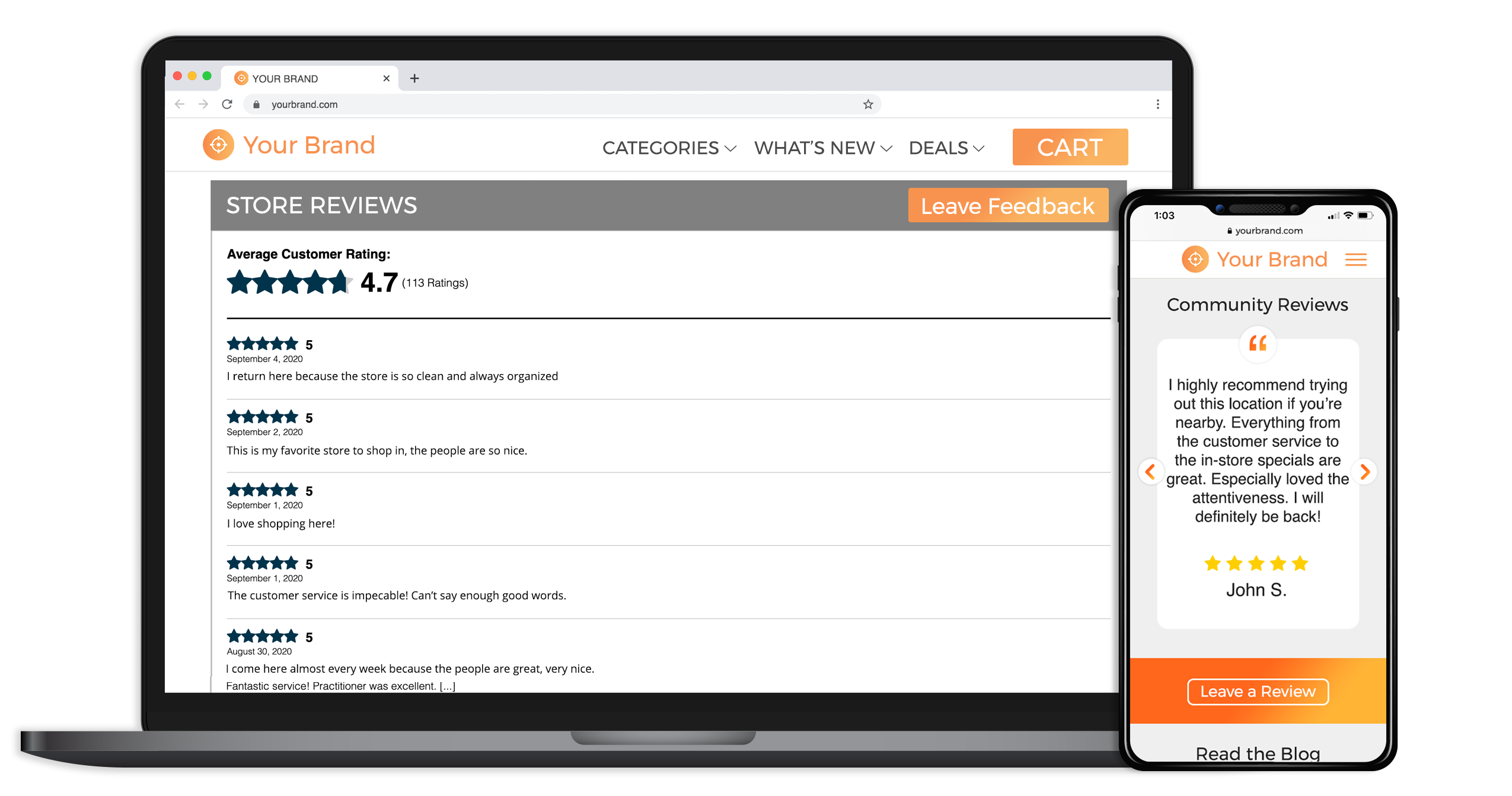

Google define una pieza de contenido como de "alta calidad" cuando tiene la información más actualizada, una voz atractiva, pruebas sociales como reseñas o testimonios, o proviene de recursos confiables en el campo. La seguridad de una página web también puede influir en la forma en que Google y los usuarios reales ven la calidad de su contenido, por lo que es esencial concentrarse en ella.

Ejemplo de prueba social en una página web y móvil

Luego viene la intención de búsqueda detrás de su contenido, que es la esencia de cómo funciona el algoritmo de Google. Así es como Google conserva su dominio como el motor de búsqueda más utilizado a nivel mundial y se diferencia de Bing, que puede mostrar resultados de búsqueda menos relevantes.

La intención de búsqueda del usuario sirve como el "por qué" detrás de una consulta de búsqueda para cualquier palabra clave de destino. Lo hace al hacer una distinción sobre lo que un usuario podría querer decir cuando escribe algo como "café" en la barra de búsqueda versus "cafeterías cerca de mí".

Una búsqueda rápida en Google mostrará que ambas palabras clave tienden a mostrar diferentes funciones SERP, así como la cantidad de blogs versus tiendas que aparecen difieren significativamente.

Cómo diagnosticar el problema de contenido

Si perdió clasificación después de realizar cambios en el contenido y ha determinado que no hay otros factores en juego, puede hacer una de las siguientes cosas:

- Exporte todas las páginas que se clasifican desde su panel de control de Google Analytics y compare el contenido con una copia de seguridad anterior de su sitio web.

- Instale una herramienta como OnWebChange que le notifique cualquier cambio realizado en el diseño o el contenido de su sitio web (opción recomendada).

La solución

Puede usar la copia de seguridad anterior de su sitio web para reescribir el texto problemático y luego crear contenido nuevo de alta calidad. También puede agregar palabras clave relevantes faltantes a su nuevo contenido y adaptar el contenido para que se adapte mejor al tipo de contenido que Google prefiere mostrar en SERP para las palabras clave de enfoque a las que se dirige.

3. Metadatos

Los metadatos ayudan a Googlebot a comprender ampliamente de qué se trata la página. Cambiar o usar una etiqueta de título incorrecta, en particular, puede afectar negativamente la comprensión de Google del contenido de la página.

Como las metaetiquetas, como el título y la metadescripción, también se muestran en las SERP, no tener las correctas en su lugar también puede afectar la cantidad de clics que obtienes.

En general, los metadatos pueden afectar tanto la experiencia del usuario como el SEO. Asegurarse de que el título de la página sea la descripción más precisa del contenido de la página es clave. Incluso cambiar su etiqueta de título de "SEO para empresas" a "Empresa de SEO empresarial" puede influir en cómo el algoritmo ve su página.

Si bien la meta descripción en sí misma no es un factor de clasificación, como tener la etiqueta de título correcta, no se puede pasar por alto. Sin los clics adecuados, las clasificaciones de búsqueda pierden sentido de todos modos. Trabajar de acuerdo con las pautas especificadas por Google para los metadatos es clave para controlar cómo aparece en la búsqueda.

Es porque Google aún puede optar por mostrar algo más en los fragmentos en lugar de lo que prescribió inicialmente, especialmente si no especificó la longitud de cada atributo de metadatos. Asegurarse de tener la longitud correcta tanto de las etiquetas de título como de la meta descripción reduce la probabilidad de que las SERP de Google trunquen o cambien los metadatos deseados para los usuarios.

Cómo diagnosticar un problema de metadatos

Su SEO o desarrollador web debe tener una lista de todos los cambios que se han realizado recientemente en los metadatos de las páginas web. Si no lo hacen, es hora de comenzar a documentarlo internamente.

A continuación, utilice una herramienta como Screaming Frog para rastrear el sitio web y así poder tener una visión general rápida de las nuevas metaetiquetas en la búsqueda orgánica. Puede comparar estos cambios recientes con una copia de seguridad anterior del sitio web.

La solución

Una vez que tenga la información de metadatos antigua y nueva, inicie una hoja de cálculo y enumere los metadatos antiguos y nuevos en columnas una al lado de la otra. Revertir su sitio web a los metadatos antiguos debería solucionar el problema.

También puede agregar cualquier palabra clave relevante que falte de los metadatos antiguos al nuevo. Espere a que Googlebot vuelva a rastrear la página y vea si esto soluciona el problema.

4. Tácticas SEO manipuladoras

Al igual que los esquemas de enlaces, existen otras tácticas que los profesionales de SEO implementan para obtener ganancias rápidas que pueden fracasar fácilmente. Estas tácticas se perciben como spam y/o intentos de manipular las clasificaciones de búsqueda. Esto va en contra de la misión de Google de mostrar primero el resultado de búsqueda más relevante. Estas son algunas de estas tácticas dañinas.

Relleno de palabras clave

A menudo, los SEO rellenan una página con palabras clave y cambian el color del mismo color que el color de fondo para manipular los motores de búsqueda. Otras veces, el usuario llega a la página y lee contenido que no tiene sentido.

Se sabe que algunos SEO agregan estas palabras clave como una lista o un grupo de una manera que está fuera de contexto y desafía las reglas estándar de lenguaje y sintaxis.

Páginas de entrada y encubrimiento

¿Alguna vez buscó un torrente y fue dirigido a un sitio web de spam o pornográfico?

Al usar el encubrimiento, los SEO intentan manipular los motores de búsqueda al mostrar contenido diferente a los usuarios y a los motores de búsqueda. Una vez que el usuario hace clic en el resultado de la búsqueda, la página suele redirigir a una página con spam o inútil que no tiene nada que ver con lo que el usuario quería ver.

El encubrimiento a menudo se realiza junto con las páginas de entrada. Los SEO crean múltiples páginas para clasificar por palabras clave específicas y las usan como una "puerta de entrada" a la página de contenido principal, lo que puede ser completamente inútil para el usuario.

Ambos infringen claramente las directrices para webmasters y Google ha estado implementando sanciones severas para abordar su uso.

Masas de contenido generado por IA

Según John Mueller de Google, todo el contenido generado por IA va en contra de sus pautas.

"Para nosotros, esto, esencialmente, seguiría entrando en la categoría de contenido generado automáticamente, que es algo que hemos tenido en las Directrices para webmasters desde casi el principio", respondió durante un hangout en el horario de oficina de SEO de Google Search Central cuando se le preguntó acerca de el uso de herramientas de escritura de IA con tecnología GPT-3.

Cuando se le preguntó si Google puede detectar automáticamente el uso de contenido de IA, agregó que no podía afirmar eso. Insinuó que solo el equipo humano podría encontrar y tomar medidas contra el contenido generado por IA.

Muchos SEO, incluidos algunos de los nombres más importantes en el campo, creen firmemente que el contenido de IA generado en su totalidad por IA es basura. Pero muchos aún defienden su uso para la verificación de hechos, la revisión, la edición y el perfeccionamiento del contenido.

Miranda Miller de Search Engine Journal apoyó esta opinión. “The Associated Press comenzó a usar IA para la generación de historias en 2014. Poner la IA a trabajar en la creación de contenido no es nuevo, y el factor más importante aquí es su aplicación inteligente”, agregó, señalando que la IA puede ayudar a los creadores de contenido a superar el lenguaje y barreras de alfabetización, mejorar la calidad de su escritura y más.

5. Velocidad lenta del sitio

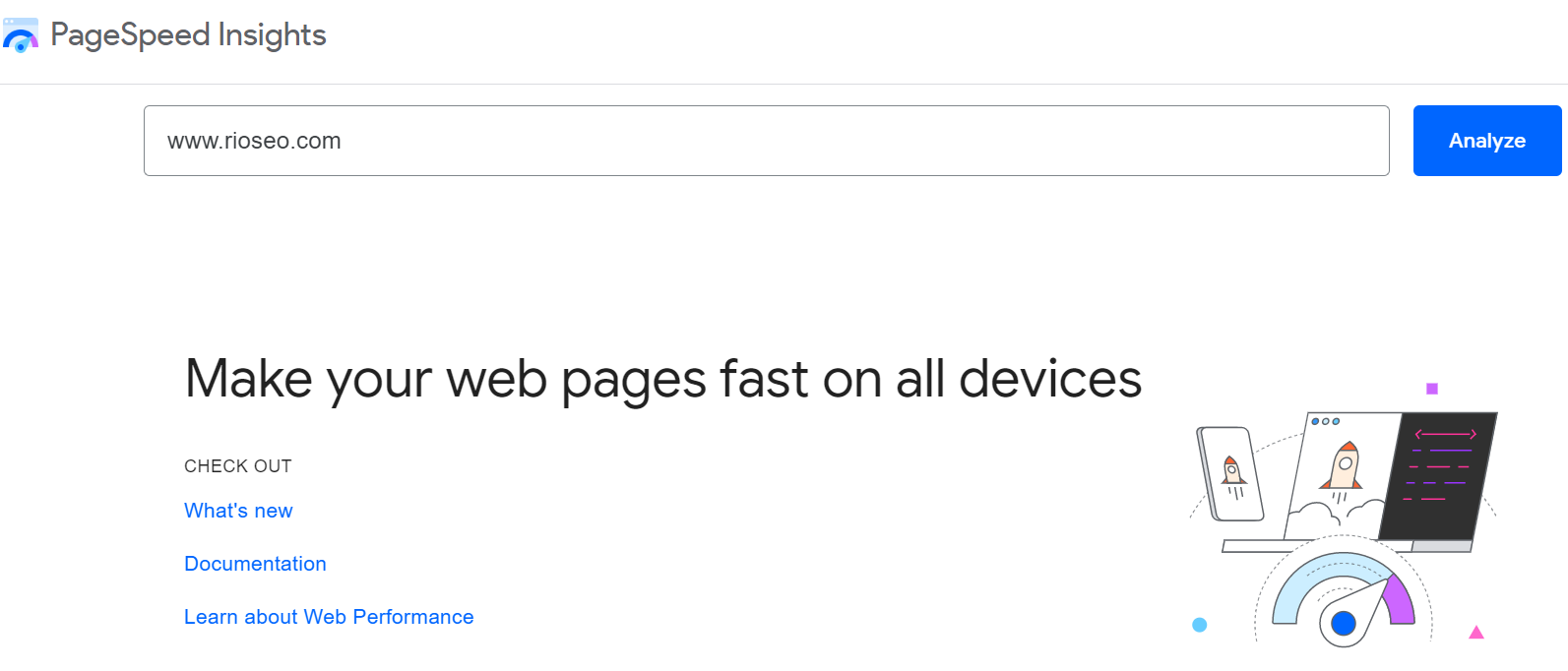

Desde un anuncio en 2010 en su centro de desarrolladores, Google ha utilizado la velocidad del sitio y la experiencia del usuario como factores de clasificación. También ofrece su propia herramienta PageSpeed Insight, que respalda aún más esta afirmación.

En los últimos años, la velocidad del sitio se ha visto dentro del espectro más amplio de "Experiencia de página ideal", que combina Core Web Vitals con compatibilidad con dispositivos móviles, navegación segura, velocidad del sitio, seguridad, etc.

Según Google, este es un esfuerzo para que las personas tengan la experiencia más útil y agradable en la web.

Un extracto de Google Search Central dice: “Lo alentamos a que comience a observar la velocidad de su sitio (las herramientas anteriores brindan un excelente punto de partida), no solo para mejorar su clasificación en los motores de búsqueda, sino también para mejorar la experiencia de todos en Internet. .”

Además del ranking de búsqueda, la velocidad del sitio también afecta la tasa de rebote. Según Websitesetup.org, un tiempo de carga de 6 segundos puede aumentar la tasa de rebote hasta en un 106%. Entonces, en ese sentido, vale la pena prestar atención tanto a las clasificaciones de búsqueda como a las conversiones.

Cómo diagnosticar un problema de velocidad del sitio

Se recomienda un tiempo de carga de 0-2 segundos. Puede usar la herramienta PageSpeedInsights o GTMatrix para verificar el tiempo de carga de su sitio web.

La solución

Hay muchas cosas que un desarrollador web o un SEO pueden hacer para acelerar su sitio web. Estos incluyen la minimización de Javascript, la optimización de imágenes y videos, la mejora del tiempo de respuesta del servidor y la reducción de redireccionamientos.

Use el informe generado por la herramienta que usa como punto de partida para comenzar a mejorar la velocidad de su sitio y Core Web Vitals.

Conclusión

El SEO puede ser complicado y llevar mucho tiempo, por lo que reducir y jugar el juego a largo plazo es la clave para obtener un buen retorno de la inversión.

Al final del día, Google tiene claro lo que está buscando: la mejor respuesta para las necesidades únicas de cada buscador. Por lo tanto, todo lo que pueda hacer para posicionar su página como la mejor respuesta a consultas relevantes y evitar errores que contrarresten esos esfuerzos es otro paso en la escala de clasificación de búsqueda.

Si está interesado en leer más sobre los factores que pueden influir positivamente en las clasificaciones de búsqueda, le recomendamos los siguientes recursos:

- Factores de clasificación de búsqueda local de 2021: una guía para las marcas en 2022

- Cómo respaldar sus clasificaciones locales con SEO orgánico

- El efecto del contenido duplicado en el SEO para marcas de ubicaciones múltiples