网络抓取服务外包比内部更好

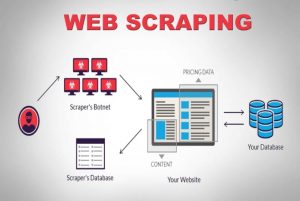

已发表: 2020-04-02我们生活在一个以数据为中心的世界中,数据是最强大的商品。 有了正确的数据,我们就能发挥作用。 它无处不在:机器学习、数据挖掘、市场研究、金融研究等等。 最大的问题仍然存在——您如何检索所有可供消费的数据? 为了获得如此规模和复杂的数据,我们爬取了源网站。 因此,网络抓取服务不再是可选的。 如果您有任何可以想象的数据驱动策略,它们是必不可少的。

关于数据抓取的一个有趣事实是它说明了它的作用,它不是一个开箱即用的解决方案。 那么,公司如何通过抓取网络来获取数据呢? 他们是建立内部团队还是外包给专门的网络抓取服务公司? 由于我们谈论的是抓取大量不同复杂性的数据,因此 DIY 抓取工具是不可能的。

让我们考虑第一个选项。 我们总是可以聘请该领域的专家团队来培训能够理解网络爬虫细微差别的内部团队。 这些公司不必担心被抓取数据的隐私。 虽然这听起来像是一个理想的选择,但也有一些缺点。

建立和维护一个专门的内部团队的绝对成本将是巨大的。 这可以通过将其完全外包给专业的数据抓取服务来完全绕过,该服务的专业知识主要在于网络抓取项目。 您可以节省时间、精力,最重要的是金钱。

还是不服气? 以下是选择专用网络抓取服务的其他一些原因。

一个)。 网站日益复杂:

需求法则也在这里发挥作用。 需求越多,爬取它所涉及的复杂性就越大。 这不仅难倒了可用的 DIY 工具选项,甚至难倒了最近接受过网络抓取培训的人员。 最重要的是,许多网站正在采用基于 AJAX 的无限滚动来改善用户体验。 这使得抓取更加复杂。

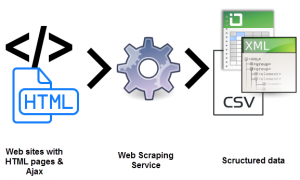

这种动态编码实践将使大多数 DIY 工具甚至一些内部团队变得低效和无用。 这里需要的是完全可定制的设置和专用方法。 手动和自动层的组合用于确定网站如何接收 AJAX 调用以使用定制的爬虫来模仿它们。 随着网站的复杂性随着时间的推移不断增加,对可定制解决方案的需求变得非常明显。

乙)。 提取过程的可扩展性:

许多企业家觉得有必要重新发明轮子。 他们有在内部执行流程而不是外包的冲动。 当然,有些流程最好在内部完成,客户支持就是一个很好的例子。 由于与大规模 Web 数据提取相关的复杂性太小而无法由不专门从事此操作的公司掌握,因此这可能不是一个好主意。 最大的公司外包属于技术领域的服务。 (s)

同时提取数百万个网页并将它们全部处理成结构化的机器可读数据是一项真正的挑战。 网络爬虫解决方案的 USP 之一是可扩展性。 由于高性能服务器集群分散在不同的地理位置, PromptCloud等服务已经建立了一个坚如磐石的基础设施来提取大规模的 Web 数据。

C)。 数据质量和维护:

提取数据是一回事。 另一个将非结构化数据转换为机器可读数据。 像PromptCloud这样的服务所提倡的是将抓取作为保持数据质量的一种手段。

如果数据不可读,那么抓取大量原始、非结构化数据将毫无意义。 同时,我们不能建立一个功能齐全的网络爬虫设置和放松。 万维网是高度动态的。

保持数据质量需要持续努力并使用手动和自动层进行密切监控。 网站经常更改其结构,这会导致爬虫出现故障或停止,这两者都会影响输出数据。 数据质量保证和及时维护对于运行网络爬虫设置是不可或缺的。 寻找对这些方面具有端到端所有权的服务。

d)。 借助 Web Scraping 轻松提取数据:

企业需要将全部精力集中在其核心产品上。 因此,需要聘请网络抓取服务,将其全部精力集中在您所寻求的内容上。

Web 数据提取带来的设置、持续维护和所有其他复杂性很容易占用您的内部资源,从而对您的业务造成影响。 陷阱实在太多了。

e)。 跨越技术壁垒:

Web 抓取需要一组开发人员在优化的服务器上设置和部署爬虫以进行提取。 这对技术要求很高。 为什么要在可以雇用时进行培训? 成本的十分之一。 凭借在网络数据提取领域多年的专业知识,专门的服务可以承担任何复杂性和规模的网站抓取项目。 这是一篇展示可用于任何项目的 Web 抓取服务模板的文章。

结论:

公司不可避免地要探索有效获取大量数据和强大数据的方法。 有数据,有信息,然后是单数,知识。 知识是我们理解和组织信息的地方,这些信息是我们从随机、非结构化和其他(看似)无用的数据中拼凑而成的。 为此和其他一切,有Promptcloud 。