Serviço de Web Scraping terceirizado melhor do que internamente

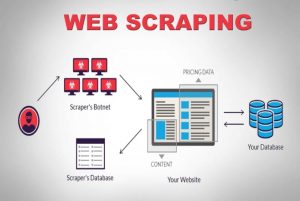

Publicados: 2020-04-02Estamos vivendo em um mundo centrado em dados, onde os dados são a mercadoria mais poderosa de todas. Com os dados certos, exercemos o poder. É onipresente: aprendizado de máquina, mineração de dados, pesquisa de mercado, pesquisa financeira, para citar alguns. A grande questão permanece – Como você recupera todos os dados que estão disponíveis para consumo? Para obter dados de tal escala e complexidade, rastreamos os sites de origem. Portanto, os serviços de raspagem da web não são mais opcionais. Eles são essenciais se você tiver qualquer estratégia baseada em dados concebível.

Um fato interessante sobre o rastreamento de dados é que ele diz o que faz, não é uma solução pronta para uso. Então, como as empresas raspam a web como meio de obtenção de dados? Eles constroem uma equipe interna ou terceirizam para empresas dedicadas de serviços de web scraping? Como estamos falando de raspar grandes quantidades de dados de complexidade variável, as ferramentas de raspagem DIY estão fora de questão.

Vamos considerar a primeira opção. Sempre podemos contratar uma equipe de especialistas na área para treinar uma equipe interna que possa entender as nuances do rastreamento da web. As empresas não precisam se preocupar com a privacidade dos dados que estão sendo raspados. Embora pareça a opção ideal logo de cara, também existem algumas desvantagens.

O custo total de configurar e manter uma equipe interna dedicada será gigantesco. Isso pode ser totalmente contornado terceirizando-o inteiramente para um serviço profissional de raspagem de dados, cuja experiência está em projetos de raspagem da web em geral. Você economiza tempo, energia e, o mais importante, dinheiro.

Ainda não está convencido? Aqui estão algumas outras razões para escolher um serviço de web scraping dedicado.

uma). A crescente complexidade dos sites:

A lei da demanda também funciona aqui. Quanto maior a demanda, maior a complexidade envolvida no rastreamento. Isso atrapalha não apenas as opções de ferramentas de bricolage disponíveis, mas até mesmo o pessoal que foi treinado recentemente na raspagem da web. Além disso, muitos sites estão adotando a rolagem infinita baseada em AJAX para melhorar a experiência do usuário. Isso torna a raspagem mais complexa.

Essas práticas de codificação dinâmicas tornariam a maioria das ferramentas de bricolage e até mesmo algumas equipes internas ineficientes e inúteis. O que é necessário aqui é uma configuração totalmente personalizável e uma abordagem dedicada. Uma combinação de camadas manuais e automatizadas é usada para descobrir como o site recebe chamadas AJAX para imitá-las usando o rastreador personalizado. À medida que a complexidade dos sites aumenta ao longo do tempo, a necessidade de uma solução personalizável torna-se óbvia.

b). Escalabilidade do processo de extração:

Muitos empreendedores sentem a necessidade de reinventar a roda. Eles têm o desejo de realizar um processo internamente, em vez de terceirizar. Claro, alguns processos são melhor executados internamente e um ótimo exemplo disso é o suporte ao cliente. Como as complexidades associadas à extração de dados da Web em grande escala são muito específicas para serem dominadas por uma empresa que não faz isso exclusivamente, provavelmente não é uma boa ideia. A maior das empresas terceiriza serviços que se enquadram no nicho técnico. (s)

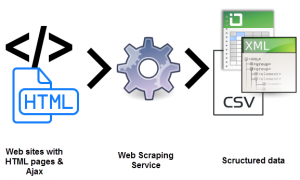

Extrair milhões de páginas da Web simultaneamente e processar todas elas em dados estruturados legíveis por máquina é um verdadeiro desafio. Um dos USPs de uma solução de web scraper é a escalabilidade. Com clusters de servidores de alto desempenho espalhados por regiões geográficas, serviços como o PromptCloud construíram uma infraestrutura sólida para extrair dados da Web em grande escala.

c). Qualidade de dados e manutenção:

Uma coisa é extrair dados. E outro para converter dados não estruturados em dados legíveis por máquina. A raspagem como meio de manter a qualidade dos dados é o que serviços como o PromptCloud defendem.

Rastrear uma enorme quantidade de dados brutos e não estruturados não fará sentido se não for legível. Ao mesmo tempo, não podemos configurar uma configuração de rastreamento da Web totalmente funcional e relaxar. A rede mundial é altamente dinâmica.

A manutenção da qualidade dos dados requer esforço consistente e monitoramento próximo usando camadas manuais e automatizadas. Os sites alteram suas estruturas com bastante frequência, o que tornaria o rastreador defeituoso ou o interromperia, o que afetaria os dados de saída. A garantia da qualidade dos dados e a manutenção oportuna são essenciais para executar uma configuração de rastreamento da Web. Procure serviços que tenham propriedade de ponta a ponta desses aspectos.

d). Extração de dados sem complicações com a ajuda do Web Scraping:

As empresas precisam canalizar toda a força de energia sobre qual é sua oferta principal. Daí a necessidade de contratar um serviço de web scraping que tenha canalizado toda a sua força de energia exatamente para o que você procura.

A configuração, a manutenção constante e todas as outras complicações que acompanham a extração de dados da Web podem facilmente sobrecarregar seus recursos internos, prejudicando seus negócios. As armadilhas são muitas.

e). Cruzando a barreira técnica:

A raspagem da Web exige que uma equipe de desenvolvedores configure e implante os rastreadores em servidores otimizados para extração. É tecnicamente exigente. Por que treinar quando você pode contratar? A um décimo do custo. Com anos de experiência no espaço de extração de dados da Web, os serviços dedicados podem assumir projetos de raspagem de sites de qualquer complexidade e escala. Aqui está um artigo que mostra o modelo para um serviço de web scraping que pode ser usado em qualquer projeto.

Conclusão:

É inevitável que as empresas explorem maneiras de adquirir dados poderosos e imensamente poderosos. Há dados, há informações e há o uno-numero, conhecimento. O conhecimento é onde damos sentido e organizamos as informações que reunimos a partir do que era apenas dados aleatórios, não estruturados e de outra forma (e aparentemente) inúteis. Para isso e tudo mais, existe o Promptcloud .