Web Kazıma Hizmeti, Şirket İçinden Daha İyi Dış Kaynaklı

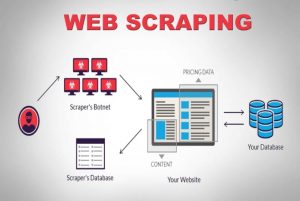

Yayınlanan: 2020-04-02Verinin en güçlü meta olduğu veri merkezli bir dünyada yaşıyoruz. Doğru verilerle gücü kullanırız. Her yerde mevcuttur: makine öğrenimi, veri madenciliği, pazar araştırması, finansal araştırma, bunlardan birkaçı. Geriye büyük soru kalıyor: Tüketim için mevcut olan tüm verileri nasıl alırsınız? Bu ölçekte ve karmaşıklıkta veriler elde etmek için kaynak web sitelerini tarıyoruz. Bu nedenle, web kazıma hizmetleri artık isteğe bağlı değildir. Akla gelebilecek herhangi bir veriye dayalı stratejiniz varsa, bunlar çok önemlidir.

Veri taramayla ilgili ilginç bir gerçek, ne yaptığını söylemesidir, kullanıma hazır bir çözüm değildir. Peki şirketler veri elde etmek için web'i nasıl sıyırıyor? Şirket içi bir ekip mi kuruyorlar yoksa özel web kazıma hizmetleri şirketlerine dış kaynak mı sağlıyorlar? Değişken karmaşıklıktaki çok miktarda veriyi kazımaktan bahsettiğimiz için, DIY kazıma araçları söz konusu değildir.

İlk seçeneği ele alalım. Web taramasının nüanslarını anlayabilen bir kurum içi ekibi eğitmek için her zaman alanında uzman bir ekip tutabiliriz. Şirketlerin, kazınan verilerin gizliliği konusunda endişelenmelerine gerek yok. İlk bakışta ideal seçenek gibi görünse de, birkaç dezavantajı da var.

Özel bir dahili ekip kurmanın ve sürdürmenin katıksız maliyeti devasa olacaktır. Bu, uzmanlığı genel olarak web kazıma projelerinde yatan profesyonel bir veri kazıma hizmetine dış kaynak sağlayarak tamamen atlanabilir. Zamandan, enerjiden ve en önemlisi paradan tasarruf edersiniz.

Hala ikna olmadınız mı? İşte özel bir web kazıma hizmeti seçmenin diğer bazı nedenleri.

a). Web Sitelerinin Artan Karmaşıklığı:

Talep yasası burada da oynuyor. Talep ne kadar fazlaysa, onu taramanın karmaşıklığı da o kadar fazladır. Bu, yalnızca mevcut Kendin Yap aracı seçeneklerini değil, aynı zamanda web'i kazıma konusunda yakın zamanda eğitim almış personeli bile engeller. Bunun da ötesinde, birçok site, kullanıcı deneyimini geliştirmek için AJAX tabanlı sonsuz kaydırmayı benimsiyor. Bu, kazımayı daha karmaşık hale getirir.

Bu tür dinamik kodlama uygulamaları, çoğu DIY aracını ve hatta bazı şirket içi ekipleri verimsiz ve işe yaramaz hale getirecektir. Burada ihtiyaç duyulan, tamamen özelleştirilebilir bir kurulum ve özel bir yaklaşımdır. Web sitesinin özel olarak oluşturulmuş tarayıcıyı kullanarak onları taklit etmek için AJAX çağrılarını nasıl aldığını anlamak için manuel ve otomatik katmanların bir kombinasyonu kullanılır. Web sitelerinin karmaşıklığı zamanla artmaya devam ettikçe, özelleştirilebilir bir çözüme duyulan ihtiyaç bariz bir şekilde ortaya çıkıyor.

b). Çıkarma Sürecinin Ölçeklenebilirliği:

Birçok girişimci tekerleği yeniden icat etme ihtiyacı hisseder. Bir süreci dışarıdan temin etmek yerine kurum içinde yürütme dürtüsüne sahiptirler. Tabii ki, bazı işlemler şirket içinde daha iyi yapılır ve buna harika bir örnek müşteri desteğidir. Büyük ölçekli web veri çıkarma ile ilgili karmaşıklıklar, bunu özel olarak yapmayan bir şirket tarafından yönetilemeyecek kadar niş olduğundan, bu muhtemelen harika bir fikir değildir. Şirketlerin en büyüğü, teknik niş parantez içine giren hizmetleri dış kaynak olarak kullanır. (s)

Milyonlarca web sayfasını aynı anda ayıklamak ve hepsini yapılandırılmış makine tarafından okunabilir verilere dönüştürmek gerçek bir zorluktur. Bir web kazıyıcı çözümünün USP'lerinden biri ölçeklenebilirliktir. Coğrafyalara dağılmış yüksek performanslı sunucu kümeleri ile PromptCloud gibi hizmetler, büyük ölçekli web verilerini çıkarmak için kaya gibi sağlam bir altyapı oluşturdu.

c). Veri Kalitesi ve Bakımı:

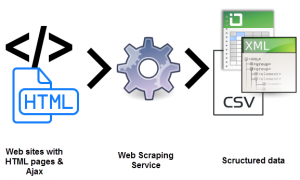

Verileri çıkarmak bir şeydir. Ve yapılandırılmamış verileri makine tarafından okunabilir verilere dönüştürmek için bir tane daha. Veri kalitesini korumanın bir yolu olarak kazıma, PromptCloud gibi hizmetlerin savunduğu şeydir.

Ezici miktarda ham, yapılandırılmamış veriyi taramak, okunabilir değilse bir anlam ifade etmeyecektir. Aynı zamanda, tam olarak işleyen bir web tarama kurulumu yapıp rahatlayamıyoruz. Dünya çapındaki web son derece dinamiktir.

Veri kalitesini korumak, hem manuel hem de otomatik katmanları kullanarak tutarlı bir çaba ve yakın izleme gerektirir. Web siteleri yapılarını oldukça sık değiştirir, bu da tarayıcıyı hatalı hale getirir veya durdurur, her ikisi de çıktı verilerini etkiler. Veri kalitesi güvencesi ve zamanında bakım, bir web tarama kurulumunu çalıştırmanın ayrılmaz bir parçasıdır. Bu yönlerin uçtan uca sahipliğini alan hizmetleri arayın.

d). Web Scraping Yardımıyla Sorunsuz Veri Çıkarma:

İşletmelerin tüm enerji gücünü temel tekliflerinin ne olduğuna kanalize etmesi gerekiyor. Bu nedenle, tüm enerjisini tam olarak aradığınız şeye kanalize eden bir web kazıma hizmeti kiralama ihtiyacı.

Kurulum, sürekli bakım ve web verilerinin çıkarılmasıyla birlikte gelen diğer tüm komplikasyonlar, dahili kaynaklarınızı kolayca tüketebilir ve işinize zarar verebilir. Tuzaklar çok fazla.

e). Teknik Engeli Aşmak:

Web kazıma, bir geliştirici ekibinin tarayıcıları çıkarma için optimize edilmiş sunucularda kurmasını ve dağıtmasını gerektirir. Teknik olarak talepkardır. İşe alabilecekken neden antrenman yapasın? Maliyetinin onda biri. Web veri çıkarma alanındaki yılların uzmanlığıyla, özel hizmetler, herhangi bir karmaşıklık ve ölçekte web sitesi kazıma projelerini üstlenebilir. İşte herhangi bir projede kullanılabilecek bir web kazıma hizmeti şablonunu gösteren bir makale.

Çözüm:

Şirketlerin son derece dökümlü ve güçlü verileri verimli bir şekilde elde etmenin yollarını keşfetmeleri kaçınılmazdır. Veri var, bilgi var ve sonra sayısal olmayan bilgi var. Bilgi, rastgele, yapılandırılmamış ve başka türlü (ve görünüşte) yararsız verilerden bir araya getirdiğimiz bilgileri anlamlandırdığımız ve düzenlediğimiz yerdir. Bunun ve diğer her şey için Promptcloud var.