Web スクレイピング サービスは社内よりアウトソーシングのほうが優れている

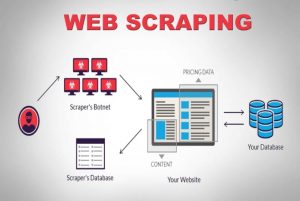

公開: 2020-04-02私たちは、データが最も強力な商品であるデータ中心の世界に住んでいます。 適切なデータがあれば、私たちは力を発揮します。 ごく一部を挙げると、機械学習、データ マイニング、市場調査、金融調査など、どこにでもあります。 大きな疑問が残ります — 利用可能なすべてのデータをどのように取得するのでしょうか? このような規模と複雑さのデータを取得するために、ソース Web サイトをクロールします。 したがって、Web スクレイピング サービスはもはやオプションではありません。 考えられるデータ駆動型の戦略がある場合、これらは不可欠です。

データ クロールに関する興味深い事実は、それが何をするかということです。それはすぐに使えるソリューションではありません。 では、企業はどのようにしてデータを取得する手段として Web をスクレイピングするのでしょうか? 社内チームを構築するか、専用の Web スクレイピング サービス会社に外部委託しますか? さまざまな複雑さの膨大な量のデータをスクレイピングすることについて話しているので、DIY スクレイピング ツールは問題外です。

最初のオプションを考えてみましょう。 ウェブクロールのニュアンスを理解できる社内チームをトレーニングするために、常にその分野の専門家チームを雇うことができます。 企業は、スクレイピングされるデータのプライバシーについて心配する必要はありません。 すぐに理想的なオプションのように思えますが、いくつかの欠点もあります。

専任の社内チームを立ち上げて維持するためのコストは莫大なものになります。 これは、Web スクレイピング プロジェクトを専門とするプロのデータ スクレイピング サービスに完全にアウトソーシングすることで、完全に回避できます。 時間、エネルギー、そして最も重要なお金を節約できます。

まだ納得できませんか? 専用の Web スクレイピング サービスを選択するその他の理由を次に示します。

a)。 ますます複雑化するウェブサイト:

ここでも需要の法則が働きます。 需要が多いほど、クロールに伴う複雑さが増します。 これは、利用可能な DIY ツール オプションだけでなく、最近 Web スクレイピングのトレーニングを受けた担当者でさえも困惑させます。 その上、多くのサイトがAJAX ベースの無限スクロールを採用して、ユーザー エクスペリエンスを向上させています。 これにより、スクレイピングがより複雑になります。

このような動的なコーディングの慣行は、ほとんどの DIY ツールや一部の社内チームでさえ非効率的で役に立たないものにしてしまいます。 ここで必要なのは、完全にカスタマイズ可能なセットアップと専用のアプローチです。 手動レイヤーと自動レイヤーの組み合わせを使用して、Web サイトが AJAX 呼び出しを受け取り、カスタム構築されたクローラーを使用してそれらを模倣する方法を把握します。 Web サイトの複雑さが時間の経過とともに増加し続けるにつれて、カスタマイズ可能なソリューションの必要性が明らかになります。

b)。 抽出プロセスのスケーラビリティ:

多くの起業家は、車輪の再発明の必要性を感じています。 彼らはプロセスを外部委託するのではなく、社内で実行したいという衝動に駆られています。 もちろん、一部のプロセスは社内で行う方が適切であり、その好例がカスタマー サポートです。 大規模な Web データ抽出に関連する複雑さはニッチすぎて、それを独占的に行っていない企業が習得することはできないため、これはおそらく優れたアイデアではありません。 大企業は、技術的なニッチ ブラケットに分類されるサービスを外部委託しています。 (s)

何百万もの Web ページを同時に抽出し、それらすべてを構造化された機械可読データに処理することは、非常に困難です。 Web スクレイパー ソリューションの USP の 1 つはスケーラビリティです。 PromptCloudなどのサービスは、地理的に分散した高性能サーバーのクラスターにより、大規模な Web データを抽出するための堅固なインフラストラクチャを構築しました。

c)。 データの品質とメンテナンス:

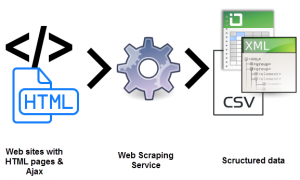

データを抽出することは 1 つのことです。 もう 1 つは、非構造化データを機械可読データに変換するものです。 データの品質を維持する手段としてのスクレイピングは、 PromptCloudのようなサービスが提唱するものです。

膨大な量の生の非構造化データをクロールしても、読み取り可能でなければ意味がありません。 同時に、完全に機能するWeb クローリングのセットアップをセットアップしてリラックスすることはできません。 ワールドワイド ウェブは非常に動的です。

データ品質を維持するには、手動レイヤーと自動レイヤーの両方を使用して、一貫した努力と綿密な監視が必要です。 Web サイトは頻繁に構造を変更するため、クローラーが故障したり停止したりします。どちらも出力データに影響します。 データ品質の保証とタイムリーなメンテナンスは、Web クローリングのセットアップを実行するために不可欠です。 これらの側面をエンドツーエンドで所有できるサービスを探してください。

d)。 Web スクレイピングを利用した手間のかからないデータ抽出:

企業は、中核となる製品に全エネルギーを注ぎ込む必要があります。 したがって、まさにあなたが求めているものに全エネルギーを向けたWebスクレイピングサービスを雇う必要があります.

セットアップ、定期的なメンテナンス、および Web データ抽出に伴うその他すべての複雑さは、内部リソースを簡単に占有し、ビジネスに大きな打撃を与える可能性があります。 落とし穴が多すぎる。

e)。 技術的な障壁を越える:

Web スクレイピングでは、開発者のチームがクローラーを設定し、最適化されたサーバーに展開して抽出する必要があります。 技術的に厳しいです。 雇用できるのに、なぜ訓練する必要があるのでしょうか。 10分の1のコストで。 Web データ抽出分野における長年の専門知識を備えた専用サービスは、複雑さと規模に関係なく、Web サイト スクレイピング プロジェクトを引き受けることができます。 これは、あらゆるプロジェクトで使用できるWeb スクレイピング サービスのテンプレートを紹介する記事です。

結論:

企業が非常に多くのキャストと強力なデータを効率的に取得する方法を模索することは避けられません. そこにはデータがあり、情報があり、それから膨大な数の知識があります。 ナレッジとは、無作為で構造化されていない (そして一見) 役に立たないデータからつなぎ合わせた情報を理解して整理する場所です。 それと他のすべてのために、 Promptcloudがあります。