บริการ Web Scraping Outsource ดีกว่า In-House

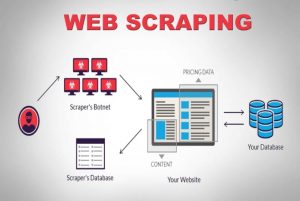

เผยแพร่แล้ว: 2020-04-02เรากำลังอยู่ในโลกที่มีข้อมูลเป็นศูนย์กลางซึ่งข้อมูลเป็นสินค้าที่ทรงพลังที่สุด ด้วยข้อมูลที่ถูกต้อง เรามีอำนาจ มีอยู่ทั่วไปทุกหนทุกแห่ง: การเรียนรู้ของเครื่อง, การทำเหมืองข้อมูล, การวิจัยตลาด, การวิจัยทางการเงิน เป็นต้น คำถามใหญ่ยังคงอยู่ - คุณจะดึงข้อมูลทั้งหมดที่มีสำหรับการบริโภคได้อย่างไร? เพื่อให้ได้ข้อมูลที่มีขนาดและความซับซ้อนดังกล่าว เราจะรวบรวมข้อมูลจากเว็บไซต์ต้นทาง ดังนั้นบริการขูดเว็บจึงไม่เป็นทางเลือกอีกต่อไป สิ่งเหล่านี้มีความสำคัญหากคุณมี กลยุทธ์ที่ขับเคลื่อนด้วยข้อมูลที่ เป็นไปได้

ข้อเท็จจริงที่น่าสนใจเกี่ยวกับการรวบรวมข้อมูลคือมันบอกว่ามันทำอะไร มันไม่ใช่วิธีแก้ปัญหาแบบสำเร็จรูป แล้วบริษัทต่างๆ ขูดเว็บเพื่อหาข้อมูลได้อย่างไร? พวกเขาสร้างทีมในองค์กรหรือจ้างบริษัทที่ให้บริการขูดเว็บโดยเฉพาะหรือไม่? เนื่องจากเรากำลังพูดถึงการขูดข้อมูลจำนวนมหาศาลที่มีความซับซ้อนต่างกัน เครื่องมือขูด DIY จึงไม่เป็นปัญหา

ให้เราพิจารณาตัวเลือกแรกสุด เราสามารถจ้างทีมผู้เชี่ยวชาญในสาขาเพื่อฝึกอบรมทีมงานภายในองค์กรที่สามารถเข้าใจความแตกต่างของการรวบรวมข้อมูลเว็บได้ บริษัทไม่จำเป็นต้องกังวลเกี่ยวกับความเป็นส่วนตัวของข้อมูลที่ถูกคัดลอกมา แม้ว่าจะฟังดูเป็นตัวเลือกที่เหมาะสมที่สุด แต่ก็มีข้อเสียอยู่บ้างเช่นกัน

ค่าใช้จ่ายในการจัดตั้งและบำรุงรักษาทีมงานภายในที่ทุ่มเทจะมีค่าใช้จ่ายมหาศาล สิ่งนี้สามารถข้ามได้ทั้งหมดโดยการเอาต์ซอร์ซทั้งหมดไปยังบริการขูดข้อมูลแบบมืออาชีพที่มีความเชี่ยวชาญในโครงการขูดเว็บโดยมาก คุณประหยัดเวลา พลังงาน ที่สำคัญที่สุดคือเงิน

ยังไม่มั่นใจ? ต่อไปนี้คือเหตุผลอื่นๆ ในการเลือกบริการขูดเว็บโดยเฉพาะ

ก) ความซับซ้อนที่เพิ่มขึ้นของเว็บไซต์:

กฎความต้องการเล่นที่นี่เช่นกัน ยิ่งมีความต้องการมากเท่าไร ก็ยิ่งมีความซับซ้อนในการรวบรวมข้อมูลมากขึ้นเท่านั้น สิ่งนี้ทำให้ไม่เพียงแค่ตัวเลือกเครื่องมือ DIY เท่านั้น แต่ยังรวมถึงบุคลากรที่เพิ่งได้รับการฝึกอบรมในการขูดเว็บด้วย ยิ่งไปกว่านั้น เว็บไซต์หลายแห่งยังใช้ การเลื่อนแบบอนันต์บน AJAX เพื่อปรับปรุงประสบการณ์ผู้ใช้ ทำให้การขูดมีความซับซ้อนมากขึ้น

แนวทางปฏิบัติในการเขียนโค้ดแบบไดนามิกดังกล่าวจะทำให้เครื่องมือ DIY ส่วนใหญ่และแม้แต่ทีมภายในองค์กรบางส่วนไม่มีประสิทธิภาพและไร้ประโยชน์ สิ่งที่จำเป็นในที่นี้คือการตั้งค่าที่ปรับแต่งได้อย่างเต็มที่และแนวทางเฉพาะ การผสมผสานระหว่างเลเยอร์แบบแมนนวลและแบบอัตโนมัติถูกใช้เพื่อค้นหาวิธีที่เว็บไซต์ได้รับการเรียก AJAX เพื่อเลียนแบบโดยใช้โปรแกรมรวบรวมข้อมูลที่สร้างขึ้นเอง เนื่องจากความซับซ้อนของเว็บไซต์เพิ่มขึ้นเรื่อยๆ ความต้องการโซลูชันที่ปรับแต่งได้จึงชัดเจนขึ้นอย่างเห็นได้ชัด

ข) ความสามารถในการปรับขนาดของกระบวนการสกัด:

ผู้ประกอบการจำนวนมากรู้สึกว่าจำเป็นต้องสร้างวงล้อใหม่ พวกเขามีความต้องการที่จะดำเนินการตามกระบวนการภายในองค์กรมากกว่าที่จะจ้างภายนอก แน่นอน กระบวนการบางอย่างทำได้ดีกว่าภายในบริษัท และตัวอย่างที่ดีคือการสนับสนุนลูกค้า เนื่องจากความซับซ้อนที่เกี่ยวข้องกับการดึงข้อมูลเว็บขนาดใหญ่นั้นมีความเฉพาะเจาะจงเกินกว่าจะเชี่ยวชาญโดยบริษัทที่ไม่ได้ทำเพียงผู้เดียว จึงอาจไม่ใช่ความคิดที่ดี บริการเอาท์ซอร์สของบริษัทที่ใหญ่ที่สุดซึ่งอยู่ในกลุ่มเฉพาะด้านเทคนิค (ส)

การแยกหน้าเว็บหลายล้านหน้าพร้อมกันและประมวลผลทั้งหมดเป็นข้อมูลที่มีโครงสร้างที่เครื่องอ่านได้ถือเป็นความท้าทายที่แท้จริง หนึ่งใน USP ของโซลูชันมีดโกนเว็บคือความสามารถในการปรับขนาดได้ ด้วยคลัสเตอร์ของเซิร์ฟเวอร์ประสิทธิภาพสูงที่กระจัดกระจายไปตามภูมิภาค บริการต่างๆ เช่น PromptCloud ได้สร้างโครงสร้างพื้นฐานที่แข็งแกร่งเพื่อดึงข้อมูลเว็บขนาดใหญ่

ค). คุณภาพข้อมูลและการบำรุงรักษา:

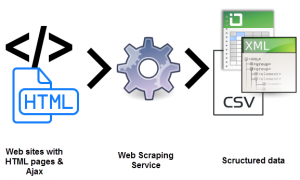

เป็นการดึงข้อมูลอย่างหนึ่ง และอีกวิธีในการแปลงข้อมูลที่ไม่มีโครงสร้างเป็นข้อมูลที่เครื่องอ่านได้ การขูดเพื่อรักษาคุณภาพของข้อมูลคือสิ่งที่บริการอย่าง PromptCloud สนับสนุน

การรวบรวมข้อมูลดิบจำนวนมากที่ไม่มีโครงสร้างจะไม่สมเหตุสมผลหากไม่สามารถอ่านได้ ในขณะเดียวกัน เราไม่สามารถตั้งค่าการ รวบรวมข้อมูลเว็บ ที่ทำงานได้อย่างสมบูรณ์และผ่อนคลาย เว็บทั่วโลกมีไดนามิกสูง

การรักษาคุณภาพของข้อมูลต้องใช้ความพยายามอย่างสม่ำเสมอและการตรวจสอบอย่างใกล้ชิดโดยใช้เลเยอร์ทั้งแบบแมนนวลและแบบอัตโนมัติ เว็บไซต์เปลี่ยนโครงสร้างค่อนข้างบ่อย ซึ่งจะทำให้โปรแกรมรวบรวมข้อมูลผิดพลาดหรือหยุดการทำงาน ซึ่งทั้งสองอย่างนี้จะส่งผลต่อข้อมูลผลลัพธ์ การประกันคุณภาพข้อมูลและการบำรุงรักษาตามกำหนดเวลาเป็นส่วนสำคัญในการเรียกใช้การตั้งค่าการรวบรวมข้อมูลเว็บ มองหาบริการที่มีความเป็นเจ้าของแบบ end-to-end ในด้านเหล่านี้

ง) การดึงข้อมูลที่ไม่ยุ่งยากด้วยความช่วยเหลือของ Web Scraping:

ธุรกิจจำเป็นต้องกำหนดทิศทางของพลังงานทั้งหมดเกี่ยวกับข้อเสนอหลักของพวกเขา ดังนั้น ความจำเป็นในการจ้างบริการขูดเว็บที่กระจายพลังงานทั้งหมดไปยังสิ่งที่คุณต้องการอย่างแท้จริง

การตั้งค่า การบำรุงรักษาอย่างต่อเนื่อง และความยุ่งยากอื่นๆ ทั้งหมดที่มาพร้อมกับการดึงข้อมูลเว็บสามารถดึงทรัพยากรภายในของคุณไปได้อย่างง่ายดาย ส่งผลเสียต่อธุรกิจของคุณ หลุมพรางมีมากมายเหลือเกิน

จ) ข้ามสิ่งกีดขวางทางเทคนิค:

การขูดเว็บต้องใช้ทีมนักพัฒนาในการตั้งค่าและปรับใช้โปรแกรมรวบรวมข้อมูลบนเซิร์ฟเวอร์ที่ปรับให้เหมาะสมสำหรับการดึงข้อมูล เป็นความต้องการทางเทคนิค ทำไมต้องฝึกเมื่อคุณสามารถจ้างได้? ในราคาหนึ่งในสิบ ด้วยความเชี่ยวชาญหลายปีในด้านพื้นที่การดึงข้อมูลเว็บ บริการเฉพาะสามารถใช้โครงการขูดเว็บไซต์ที่มีความซับซ้อนและขนาดใดก็ได้ นี่คือบทความที่แสดง เทมเพลตสำหรับบริการขูดเว็บ ที่สามารถใช้ในโปรเจ็กต์ใดก็ได้

บทสรุป:

เป็นสิ่งที่หลีกเลี่ยงไม่ได้สำหรับบริษัทต่างๆ ในการสำรวจวิธีการรับข้อมูลที่ส่งเข้ามาอย่างมหาศาลและทรงพลังอย่างมีประสิทธิภาพ มีข้อมูล มีข้อมูล แล้วก็มีตัวเลข ความรู้ ความรู้เป็นที่ที่เราเข้าใจและจัดระเบียบข้อมูลที่เราได้รวมเข้าด้วยกันจากข้อมูลที่สุ่ม ไม่มีโครงสร้าง และอื่นๆ (และดูเหมือน) ไร้ประโยชน์ สำหรับสิ่งนั้นและอย่างอื่น มี Promptcloud