Ausgelagerter Web-Scraping-Service besser als intern

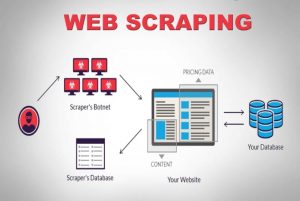

Veröffentlicht: 2020-04-02Wir leben in einer datenzentrierten Welt, in der Daten das mächtigste Gut von allen sind. Mit den richtigen Daten üben wir Macht aus. Sie ist allgegenwärtig: Machine Learning, Data Mining, Marktforschung, Finanzforschung, um nur einige zu nennen. Die große Frage bleibt: Wie ruft man alle Daten ab, die für den Verbrauch verfügbar sind? Um Daten dieses Umfangs und dieser Komplexität zu erhalten, crawlen wir die Quell-Websites. Daher sind Web-Scraping-Dienste nicht mehr optional. Sie sind unerlässlich, wenn Sie eine denkbare datengesteuerte Strategie haben.

Eine interessante Tatsache beim Daten-Crawling ist, dass es sagt, was es tut, es ist keine sofort einsatzbereite Lösung. Wie nutzen Unternehmen also das Internet, um an Daten zu gelangen? Bauen sie ein internes Team auf oder lagern sie an spezialisierte Web-Scraping-Dienstleister aus? Da wir über das Scraping großer Datenmengen unterschiedlicher Komplexität sprechen, kommen die DIY-Scraping-Tools nicht in Frage.

Betrachten wir die allererste Option. Wir können jederzeit ein Team von Experten auf diesem Gebiet einstellen, um ein internes Team zu schulen, das die Nuancen des Web-Crawling verstehen kann. Die Unternehmen müssen sich keine Sorgen um die Privatsphäre der zu kratzenden Daten machen. Während es auf Anhieb nach der idealen Option klingt, gibt es auch ein paar Nachteile.

Die reinen Kosten für den Aufbau und die Pflege eines engagierten internen Teams werden gigantisch sein. Dies kann vollständig umgangen werden, indem man es vollständig an einen professionellen Data-Scraping-Dienst auslagert, dessen Expertise im Großen und Ganzen in Web-Scraping-Projekten liegt. Sie sparen Zeit, Energie und vor allem Geld.

Immer noch nicht überzeugt? Hier sind einige weitere Gründe, warum Sie sich für einen dedizierten Web-Scraping-Dienst entscheiden sollten.

a). Die zunehmende Komplexität von Websites:

Auch hier spielt das Gesetz der Nachfrage eine Rolle. Je höher die Nachfrage, desto komplexer wird das Crawling. Dies überfordert nicht nur die verfügbaren DIY-Tool-Optionen, sondern sogar das Personal, das kürzlich im Scraping des Webs geschult wurde. Darüber hinaus setzen viele Websites AJAX-basiertes unendliches Scrollen ein, um die Benutzererfahrung zu verbessern. Dies macht das Schaben komplexer.

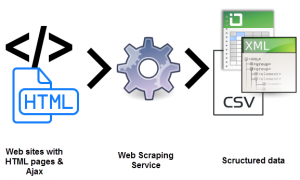

Solche dynamischen Codierungspraktiken würden die meisten DIY-Tools und sogar einige interne Teams ineffizient und nutzlos machen. Was hier benötigt wird, ist ein vollständig anpassbares Setup und ein dedizierter Ansatz. Eine Kombination aus manuellen und automatisierten Ebenen wird verwendet, um herauszufinden, wie die Website AJAX-Aufrufe empfängt, um sie mit dem benutzerdefinierten Crawler nachzuahmen. Da die Komplexität von Websites im Laufe der Zeit immer weiter zunimmt, wird die Notwendigkeit einer anpassbaren Lösung deutlich.

b). Skalierbarkeit des Extraktionsprozesses:

Viele Unternehmer haben das Bedürfnis, das Rad neu zu erfinden. Sie haben den Drang, einen Prozess intern durchzuführen, anstatt ihn auszulagern. Natürlich werden einige Prozesse besser intern durchgeführt, und ein gutes Beispiel dafür ist der Kundensupport. Da die mit der groß angelegten Webdatenextraktion verbundenen Komplexitäten zu nischenhaft sind, um von einem Unternehmen gemeistert zu werden, das dies nicht ausschließlich tut, ist dies wahrscheinlich keine gute Idee. Die größten Unternehmen lagern Dienstleistungen aus, die in die technische Nische fallen. (s)

Millionen von Webseiten gleichzeitig zu extrahieren und sie alle zu strukturierten maschinenlesbaren Daten zu verarbeiten, ist eine echte Herausforderung. Einer der USPs einer Web-Scraper-Lösung ist die Skalierbarkeit. Mit Clustern von Hochleistungsservern, die über geografische Regionen verstreut sind, haben Dienste wie PromptCloud eine felsenfeste Infrastruktur aufgebaut, um umfangreiche Webdaten zu extrahieren.

c). Datenqualität und -pflege:

Es ist eine Sache, Daten zu extrahieren. Und eine andere, um unstrukturierte Daten in maschinenlesbare Daten umzuwandeln. Scraping als Mittel zur Aufrechterhaltung der Datenqualität wird von Diensten wie PromptCloud befürwortet.

Das Crawlen einer überwältigenden Menge an rohen, unstrukturierten Daten macht keinen Sinn, wenn sie nicht lesbar sind. Gleichzeitig können wir kein voll funktionsfähiges Web-Crawling-Setup einrichten und uns entspannen. Das World Wide Web ist hochdynamisch.

Die Aufrechterhaltung der Datenqualität erfordert konsequente Bemühungen und eine genaue Überwachung sowohl auf manueller als auch auf automatisierter Ebene. Websites ändern häufig ihre Struktur, was den Crawler fehlerhaft machen oder zum Stillstand bringen würde, was sich auf die Ausgabedaten auswirkt. Datenqualitätssicherung und rechtzeitige Wartung sind wesentliche Bestandteile für den Betrieb eines Web-Crawling-Setups. Suchen Sie nach Diensten, die diese Aspekte von Anfang bis Ende übernehmen.

d). Problemlose Datenextraktion mit Hilfe von Web Scraping:

Unternehmen müssen ihre gesamte Energie auf ihr Kernangebot lenken. Daher die Notwendigkeit, einen Web-Scraping-Dienst zu beauftragen, der seine gesamte Energie auf genau das kanalisiert hat, was Sie suchen.

Die Einrichtung, die ständige Wartung und all die anderen Komplikationen, die mit der Extraktion von Webdaten einhergehen, können Ihre internen Ressourcen leicht in Anspruch nehmen und Ihr Unternehmen belasten. Die Fallstricke sind viel zu viele.

e). Überqueren der technischen Barriere:

Web Scraping erfordert ein Team von Entwicklern, um die Crawler auf optimierten Servern für die Extraktion einzurichten und bereitzustellen. Es ist technisch anspruchsvoll. Warum ausbilden, wenn Sie mieten können? Zu einem Zehntel der Kosten. Mit jahrelanger Erfahrung im Bereich der Webdatenextraktion können dedizierte Dienste Website-Scraping-Projekte jeder Komplexität und Größenordnung übernehmen. Hier ist ein Artikel, der die Vorlage für einen Web-Scraping -Dienst zeigt, der in jedem Projekt verwendet werden kann.

Fazit:

Für Unternehmen ist es unvermeidlich, nach Wegen zu suchen, um immens gegossene und aussagekräftige Daten effizient zu erfassen. Es gibt Daten, es gibt Informationen, und dann gibt es das Uno-Numero, Wissen. Wissen ist der Ort, an dem wir Informationen, die wir aus zufälligen, unstrukturierten und ansonsten (und scheinbar) nutzlosen Daten zusammengesetzt haben, sinnvoll auswerten und organisieren. Dafür und für alles andere gibt es Promptcloud .