Serviciul Web Scraping este externalizat mai bine decât în casă

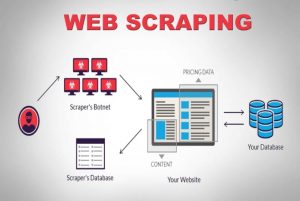

Publicat: 2020-04-02Trăim într-o lume centrată pe date în care datele sunt cea mai puternică marfă dintre toate. Cu datele potrivite, deținem puterea. Este omniprezent: machine learning, data mining, cercetare de piață, cercetare financiară, pentru a numi câteva. Marea întrebare rămâne — Cum recuperezi toate datele disponibile pentru consum? Pentru a obține date de o asemenea amploare și complexitate, accesăm cu crawlere site-urile web sursă. Prin urmare, serviciile de web scraping nu mai sunt opționale. Ele sunt esențiale dacă aveți orice strategie imaginabilă bazată pe date.

Un fapt interesant despre crawling-ul datelor este că spune ce face, nu este o soluție ieșită din cutie. Așadar, cum răzuiesc companiile web-ul ca mijloc de obținere a datelor? Construiesc o echipă internă sau externalizează către companii de servicii de web scraping dedicate? Deoarece vorbim despre răzuirea unor cantități mari de date de o complexitate diferită, instrumentele de răzuire DIY nu sunt puse în discuție.

Să luăm în considerare chiar prima opțiune. Putem angaja oricând o echipă de experți în domeniu pentru a pregăti o echipă internă care poate înțelege nuanțele accesării cu crawling pe web. Companiile nu trebuie să-și facă griji cu privire la confidențialitatea datelor care sunt răzuite. Deși pare opțiunea ideală de la început, există și câteva dezavantaje.

Costul absolut al înființării și menținerii unei echipe interne dedicate va fi gigantic. Acest lucru poate fi ocolit complet prin externalizarea acestuia către un serviciu profesional de scraping de date a cărui expertiză se află în proiecte de web scraping în general. Economisiți timp, energie, cel mai important bani.

Inca nu esti convins? Iată câteva alte motive pentru a alege un serviciu de web scraping dedicat.

A). Complexitatea tot mai mare a site-urilor web:

Legea cererii joacă și aici. Cu cât cererea este mai mare, cu atât este mai mare complexitatea implicată în accesarea cu crawlere. Acest lucru împiedică nu numai opțiunile de instrumente DIY disponibile, ci chiar și personalul care a fost recent instruit în răzuirea rețelei. În plus, multe site-uri adoptă derulare infinită bazată pe AJAX pentru a îmbunătăți experiența utilizatorului. Acest lucru face răzuirea mai complexă.

Astfel de practici de codare dinamică ar face ca majoritatea instrumentelor de bricolaj și chiar unele echipe interne să fie ineficiente și inutile. Ceea ce este nevoie aici este o configurație complet personalizabilă și o abordare dedicată. O combinație de straturi manuale și automate este folosită pentru a afla modul în care site-ul web primește apeluri AJAX pentru a le imita folosind crawler-ul personalizat. Pe măsură ce complexitatea site-urilor web continuă să crească în timp, nevoia unei soluții personalizabile devine evident.

b). Scalabilitate a procesului de extracție:

Mulți antreprenori simt nevoia să reinventeze roata. Au dorința de a efectua un proces intern, mai degrabă decât de a-l externaliza. Desigur, unele procese sunt mai bine realizate în interior și un exemplu excelent în acest sens este asistența pentru clienți. Deoarece complexitățile asociate cu extragerea datelor web la scară largă sunt prea de nișă pentru a fi stăpânite de o companie care nu o face exclusiv, probabil că nu este o idee grozavă. Cele mai mari companii externalizează servicii care se încadrează în categoria de nișă tehnică. (e)

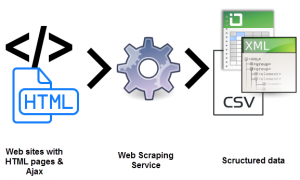

Extragerea simultană a milioane de pagini web și procesarea tuturor în date structurate care pot fi citite de mașină reprezintă o adevărată provocare. Unul dintre USP-urile unei soluții web scraper este scalabilitatea. Cu grupuri de servere de înaltă performanță împrăștiate în zone geografice, servicii precum PromptCloud au construit o infrastructură solidă pentru a extrage date web la scară largă.

c). Calitatea și întreținerea datelor:

Un lucru este să extragi date. Și alta pentru a converti datele nestructurate în date care pot fi citite de mașină. Scrapingul ca mijloc de menținere a calității datelor este ceea ce susțin serviciile precum PromptCloud .

Explorarea cu crawlere a unei cantități copleșitoare de date brute, nestructurate, nu va avea sens dacă nu este lizibilă. În același timp, nu putem configura o configurare complet funcțională de accesare cu crawlere pe web și nu ne putem relaxa. Web-ul mondial este extrem de dinamic.

Menținerea calității datelor necesită un efort constant și o monitorizare atentă folosind atât straturi manuale, cât și automate. Site-urile web își schimbă structurile destul de frecvent, ceea ce ar face crawler-ul defect sau îl va opri, ambele vor afecta datele de ieșire. Asigurarea calității datelor și întreținerea la timp sunt esențiale pentru rularea unei configurații de crawling pe web. Căutați servicii care preiau dreptul de proprietate asupra acestor aspecte.

d). Extragerea de date fără probleme cu ajutorul web scraping:

Companiile trebuie să canalizeze întreaga forță a energiei asupra ofertei lor de bază. De aici, necesitatea de a angaja un serviciu de web scraping care și-a canalizat întreaga forță de energie exact pe ceea ce căutați.

Configurarea, întreținerea constantă și toate celelalte complicații care vin cu extragerea datelor de pe web vă pot acapara cu ușurință resursele interne, afectând afacerea dvs. Capcanele sunt mult prea multe.

e). Trecerea barierei tehnice:

Web scraping necesită ca o echipă de dezvoltatori să configureze și să implementeze crawlerele pe servere optimizate pentru extracție. Este solicitant din punct de vedere tehnic. De ce să te antrenezi când te poți angaja? La o zecime din cost. Cu ani de experiență în spațiul de extracție a datelor web, serviciile dedicate pot prelua proiecte de scraping site de orice complexitate și scară. Iată un articol care prezintă șablonul pentru un serviciu de web scraping care poate fi utilizat în orice proiect.

Concluzie:

Este inevitabil ca companiile să exploreze modalități de a achiziționa în mod eficient date foarte puternice și puternice. Sunt date, sunt informații și apoi există un-numero, cunoaștere. Cunoașterea este locul în care înțelegem și organizăm informațiile pe care le-am adunat din ceea ce erau doar date aleatorii, nestructurate și altfel (și aparent) inutile. Pentru asta și orice altceva, există Promptcloud .