사내보다 아웃소싱된 웹 스크래핑 서비스

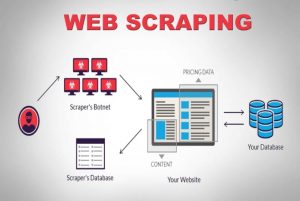

게시 됨: 2020-04-02우리는 데이터가 가장 강력한 상품인 데이터 중심 세계에 살고 있습니다. 올바른 데이터로 우리는 권력을 휘두릅니다. 기계 학습, 데이터 마이닝, 시장 조사, 금융 조사 등 편재합니다. 가장 큰 질문은 남아 있습니다. 사용할 수 있는 모든 데이터를 어떻게 검색합니까? 그러한 규모와 복잡성의 데이터를 얻기 위해 우리는 소스 웹사이트를 크롤링합니다. 따라서 웹 스크래핑 서비스는 더 이상 선택 사항이 아닙니다. 생각할 수 있는 데이터 기반 전략이 있는 경우 필수적입니다.

데이터 크롤링에 대한 흥미로운 사실은 그것이 하는 일을 말하며 즉시 사용 가능한 솔루션이 아니라는 것입니다. 그렇다면 기업은 어떻게 데이터를 수집하는 수단으로 웹을 스크랩할까요? 사내 팀을 구성합니까, 아니면 전용 웹 스크래핑 서비스 회사에 아웃소싱합니까? 우리는 다양한 복잡성의 방대한 양의 데이터를 긁는 것에 대해 이야기하고 있기 때문에 DIY 스크레이핑 도구는 의심의 여지가 없습니다.

첫 번째 옵션을 고려해 보겠습니다. 우리는 웹 크롤링의 미묘한 차이를 이해할 수 있는 사내 팀을 훈련시키기 위해 항상 현장의 전문가 팀을 고용할 수 있습니다. 회사는 스크랩되는 데이터의 개인 정보 보호에 대해 걱정할 필요가 없습니다. 바로 이상적인 옵션처럼 들리지만 몇 가지 단점도 있습니다.

전담 내부 팀을 구성하고 유지하는 데 드는 엄청난 비용이 들 것입니다. 이것은 웹 스크래핑 프로젝트 전반에 걸쳐 전문 지식을 보유한 전문 데이터 스크래핑 서비스에 완전히 아웃소싱함으로써 완전히 우회할 수 있습니다. 시간, 에너지, 가장 중요한 돈을 절약할 수 있습니다.

아직도 확신이 서지 않습니까? 다음은 전용 웹 스크래핑 서비스를 선택해야 하는 몇 가지 다른 이유입니다.

ㅏ). 웹사이트의 복잡성 증가:

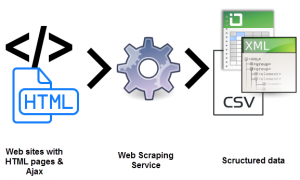

여기에도 수요의 법칙이 작용합니다. 수요가 많을수록 크롤링과 관련된 복잡성이 커집니다. 이것은 사용 가능한 DIY 도구 옵션뿐만 아니라 최근에 웹 스크래핑에 대해 교육을 받은 직원에게도 곤혹스럽습니다. 또한 많은 사이트에서 사용자 경험을 개선하기 위해 AJAX 기반 무한 스크롤 을 채택하고 있습니다. 이것은 스크래핑을 더 복잡하게 만듭니다.

이러한 동적 코딩 방식은 대부분의 DIY 도구와 심지어 일부 사내 팀을 비효율적이고 쓸모없게 만들 것입니다. 여기에 필요한 것은 완전히 사용자 정의 가능한 설정과 전용 접근 방식입니다. 수동 및 자동 레이어의 조합은 웹사이트가 맞춤형 크롤러를 사용하여 이를 모방하기 위해 AJAX 호출을 수신하는 방법을 파악하는 데 사용됩니다. 웹 사이트의 복잡성이 시간이 지남에 따라 계속 증가함에 따라 사용자 지정 가능한 솔루션의 필요성이 명백해졌습니다.

비). 추출 과정의 확장성:

많은 기업가들은 바퀴를 재발명할 필요성을 느낍니다. 그들은 프로세스를 아웃소싱하기보다 사내에서 수행하려는 충동이 있습니다. 물론 일부 프로세스는 사내에서 더 잘 수행되며 그 좋은 예가 고객 지원입니다. 대규모 웹 데이터 추출과 관련된 복잡성은 독점하지 않는 회사가 마스터하기에는 너무 틈새 시장이기 때문에 아마도 좋은 생각이 아닐 것입니다. 가장 큰 회사는 기술 틈새 브래킷에 속하는 서비스를 아웃소싱합니다. (에스)

수백만 개의 웹 페이지를 동시에 추출하고 이를 모두 기계가 읽을 수 있는 구조화된 데이터로 처리하는 것은 정말 어려운 일입니다. 웹 스크레이퍼 솔루션의 USP 중 하나는 확장성입니다. 지리적으로 분산된 고성능 서버 클러스터로 PromptCloud 와 같은 서비스는 대규모 웹 데이터를 추출하기 위해 견고한 인프라를 구축했습니다.

씨). 데이터 품질 및 유지 관리:

데이터를 추출하는 것입니다. 또 다른 하나는 비정형 데이터를 기계가 읽을 수 있는 데이터로 변환하는 것입니다. 데이터 품질을 유지하기 위한 수단으로 스크래핑은 PromptCloud 와 같은 서비스가 옹호하는 것입니다.

압도적인 양의 구조화되지 않은 원시 데이터를 크롤링하는 것은 읽을 수 없다면 의미가 없습니다. 동시에 완전히 작동하는 웹 크롤링 설정 을 설정하고 휴식을 취할 수 없습니다. 월드 와이드 웹은 매우 역동적입니다.

데이터 품질을 유지하려면 수동 및 자동화 계층을 모두 사용하여 일관된 노력과 면밀한 모니터링이 필요합니다. 웹 사이트는 구조를 매우 자주 변경하여 크롤러에 결함이 생기거나 중단되며, 둘 다 출력 데이터에 영향을 미칩니다. 데이터 품질 보증 및 시기 적절한 유지 관리는 웹 크롤링 설정을 실행하는 데 필수적입니다. 이러한 측면의 종단 간 소유권을 갖는 서비스를 찾으십시오.

디). 웹 스크래핑을 통한 간편한 데이터 추출:

기업은 핵심 제품이 무엇인지에 대한 전체 에너지의 힘을 채널화해야 합니다. 따라서 정확히 당신이 찾는 것에 에너지의 전체 힘을 집중시킨 웹 스크래핑 서비스를 고용할 필요가 있습니다.

설정, 지속적인 유지 관리 및 웹 데이터 추출과 관련된 기타 모든 복잡성으로 인해 내부 리소스가 쉽게 소모되어 비즈니스에 피해를 줄 수 있습니다. 함정이 너무 많습니다.

이자형). 기술 장벽을 넘어:

웹 스크래핑을 사용하려면 개발자 팀이 추출을 위해 최적화된 서버에 크롤러를 설정하고 배포해야 합니다. 기술적으로 까다롭습니다. 고용할 수 있는데 왜 훈련을 합니까? 10분의 1 비용. 웹 데이터 추출 공간에서 수년간의 전문 지식을 바탕으로 전용 서비스는 모든 복잡성과 규모의 웹 사이트 스크래핑 프로젝트를 수행할 수 있습니다. 다음은 모든 프로젝트에서 사용할 수 있는 웹 스크래핑 서비스의 템플릿을 보여주는 기사입니다.

결론:

기업이 엄청나게 캐스팅되고 강력한 데이터를 효율적으로 획득하는 방법을 모색하는 것은 불가피합니다. 데이터가 있고 정보가 있으며 그 다음에는 숫자가 없는 지식이 있습니다. 지식은 무작위적이고 구조화되지 않은 다른(그리고 겉보기에는) 쓸모없는 데이터에서 조합한 정보를 이해하고 구성하는 곳입니다. 그것과 다른 모든 것을 위해 Promptcloud 가 있습니다.