Outsourcing usług pozyskiwania danych z sieci lepiej niż w firmie

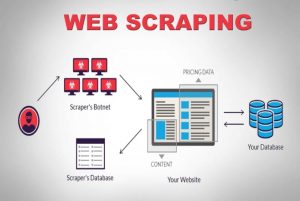

Opublikowany: 2020-04-02Żyjemy w świecie zorientowanym na dane, w którym dane są najpotężniejszym towarem ze wszystkich. Dzięki odpowiednim danym mamy władzę. Jest wszechobecny: uczenie maszynowe, eksploracja danych, badania rynku, badania finansowe, żeby wymienić tylko kilka. Pozostaje wielkie pytanie — jak pobrać wszystkie dane, które są dostępne do spożycia? Aby uzyskać dane o takiej skali i złożoności, indeksujemy strony źródłowe. W związku z tym usługi skrobania sieci nie są już opcjonalne. Są niezbędne, jeśli masz jakąkolwiek wyobrażalną strategię opartą na danych.

Ciekawostką dotyczącą indeksowania danych jest to, że mówi to, co robi, a nie jest rozwiązaniem gotowym do użycia. W jaki więc sposób firmy zbierają dane z sieci jako sposobu pozyskiwania danych? Czy tworzą własny zespół, czy zlecają je firmom zajmującym się wyspecjalizowanymi usługami web scrapingu? Ponieważ mówimy o skrobaniu ogromnych ilości danych o różnej złożoności, narzędzia do samodzielnego skrobania nie wchodzą w rachubę.

Rozważmy pierwszą opcję. Zawsze możemy wynająć zespół ekspertów w tej dziedzinie, aby przeszkolić wewnętrzny zespół, który rozumie niuanse indeksowania sieci. Firmy nie muszą się martwić o prywatność zbieranych danych. Chociaż brzmi to jak idealna opcja od samego początku, istnieje również kilka wad.

Sam koszt utworzenia i utrzymania dedykowanego zespołu wewnętrznego będzie gigantyczny. Można to całkowicie ominąć, zlecając to całkowicie profesjonalnej firmie zajmującej się zbieraniem danych, której doświadczenie polega w dużej mierze na projektach zgarniania sieci. Oszczędzasz czas, energię, a co najważniejsze pieniądze.

Nadal nie jesteś przekonany? Oto kilka innych powodów, dla których warto wybrać dedykowaną usługę web scrapingu.

a). Rosnąca złożoność stron internetowych:

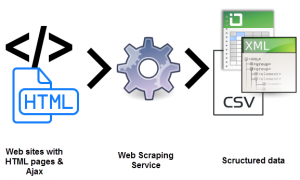

Tu również gra prawo popytu. Im większy popyt, tym większa złożoność jego przeszukiwania. To kwestionuje nie tylko dostępne opcje narzędzi do majsterkowania, ale nawet personel, który został niedawno przeszkolony w skrobaniu sieci. Ponadto wiele witryn stosuje nieskończone przewijanie oparte na technologii AJAX, aby poprawić wrażenia użytkownika. To sprawia, że skrobanie jest bardziej złożone.

Takie dynamiczne praktyki kodowania sprawiłyby, że większość narzędzi do majsterkowania, a nawet niektóre wewnętrzne zespoły byłyby nieefektywne i bezużyteczne. Potrzebna jest tutaj w pełni konfigurowalna konfiguracja i dedykowane podejście. Połączenie warstw ręcznych i automatycznych służy do ustalenia, w jaki sposób witryna odbiera wywołania AJAX, aby je naśladować za pomocą niestandardowego robota indeksującego. Ponieważ złożoność witryn internetowych stale rośnie, potrzeba dostosowania rozwiązania staje się coraz bardziej oczywista.

b). Skalowalność procesu ekstrakcji:

Wielu przedsiębiorców odczuwa potrzebę ponownego wynalezienia koła. Mają ochotę przeprowadzić proces we własnym zakresie, a nie zlecać go na zewnątrz. Oczywiście, niektóre procesy lepiej wykonywać we własnym zakresie, czego doskonałym przykładem jest obsługa klienta. Ponieważ zawiłości związane z ekstrakcją danych internetowych na dużą skalę są zbyt niszowe do opanowania przez firmę, która nie zajmuje się tym wyłącznie, prawdopodobnie nie jest to świetny pomysł. Największe firmy zlecają na zewnątrz usługi, które mieszczą się w przedziale nisz technicznych. (s)

Wyodrębnianie milionów stron jednocześnie i przetwarzanie ich wszystkich w ustrukturyzowane dane do odczytu maszynowego to prawdziwe wyzwanie. Jednym z USP rozwiązania web scrapera jest skalowalność. Dzięki klastrom wysokowydajnych serwerów rozproszonych w różnych lokalizacjach geograficznych usługi takie jak PromptCloud zbudowały solidną infrastrukturę do wydobywania danych internetowych na dużą skalę.

c). Jakość i konserwacja danych:

Wydobywanie danych to jedno. I kolejny do konwersji danych nieustrukturyzowanych na dane do odczytu maszynowego. Skrobanie jako sposób na utrzymanie jakości danych jest tym, co promują usługi takie jak PromptCloud .

Przeszukiwanie przytłaczającej ilości nieprzetworzonych, nieustrukturyzowanych danych nie będzie miało sensu, jeśli nie będzie można ich odczytać. Jednocześnie nie możemy skonfigurować w pełni działającej konfiguracji indeksowania sieci i zrelaksować się. Światowa sieć jest bardzo dynamiczna.

Utrzymanie jakości danych wymaga stałego wysiłku i ścisłego monitorowania przy użyciu zarówno warstw ręcznych, jak i zautomatyzowanych. Strony internetowe dość często zmieniają swoje struktury, co może spowodować awarię przeszukiwacza lub jego zatrzymanie, co wpłynie na dane wyjściowe. Zapewnienie jakości danych i terminowa konserwacja są integralną częścią konfiguracji indeksowania sieci. Poszukaj usług, które zapewniają pełną odpowiedzialność za te aspekty.

d). Bezproblemowe wyodrębnianie danych za pomocą narzędzia do pobierania danych z sieci:

Firmy muszą kierować całą siłę energii na to, co jest ich podstawową ofertą. Stąd potrzeba wynajęcia serwisu internetowego, który skieruje całą swoją energię na dokładnie to, czego szukasz.

Konfiguracja, ciągła konserwacja i wszystkie inne komplikacje związane z ekstrakcją danych z sieci mogą z łatwością obciążać Twoje wewnętrzne zasoby, wpływając na Twoją firmę. Pułapek jest zbyt wiele.

mi). Przekraczanie bariery technicznej:

Web scraping wymaga zespołu programistów do skonfigurowania i wdrożenia przeszukiwaczy na zoptymalizowanych serwerach do ekstrakcji. Jest technicznie wymagająca. Po co trenować, kiedy można zatrudnić? Za jedną dziesiątą kosztów. Dzięki wieloletniemu doświadczeniu w dziedzinie ekstrakcji danych internetowych, dedykowane usługi mogą zająć się projektami scrapingu witryn o dowolnej złożoności i skali. Oto artykuł przedstawiający szablon usługi web scrapingu , który można wykorzystać w dowolnym projekcie.

Wniosek:

Nieuniknione jest, aby firmy szukały sposobów na efektywne pozyskiwanie obszernych i potężnych danych. Są dane, są informacje i jest jeszcze uno-numero, wiedza. Wiedza to miejsce, w którym nadajemy sens i organizujemy informacje, które zebraliśmy razem z danych losowych, nieustrukturyzowanych i w inny sposób (i pozornie) bezużytecznych. Do tego i wszystkiego innego jest Promptcloud .