Проиндексирован, но заблокирован Robots.txt: все, что вам нужно знать

Опубликовано: 2021-07-01Если на вашем веб-сайте есть страницы, которые были проиндексированы Google, но не могут быть просканированы, вы получите сообщение «Проиндексировано, но заблокировано Robots.txt» в вашей консоли поиска Google (GSC).

Хотя Google может просматривать эти страницы, он не будет отображать их как часть страниц результатов поисковой системы по целевым ключевым словам.

Если это так, вы упустите возможность получить органический трафик для этих страниц.

Это особенно важно для страниц, генерирующих тысячи органических посетителей в месяц только для того, чтобы столкнуться с этой проблемой.

На данный момент у вас, вероятно, есть много вопросов об этом сообщении об ошибке. Почему вы его получили? Как это случилось? И, что более важно, как вы можете это исправить и восстановить трафик, если это произошло со страницей, которая уже хорошо ранжируется.

Этот пост ответит на все эти вопросы и покажет, как избежать повторения этой проблемы на вашем сайте.

Как узнать, есть ли на вашем сайте эта проблема

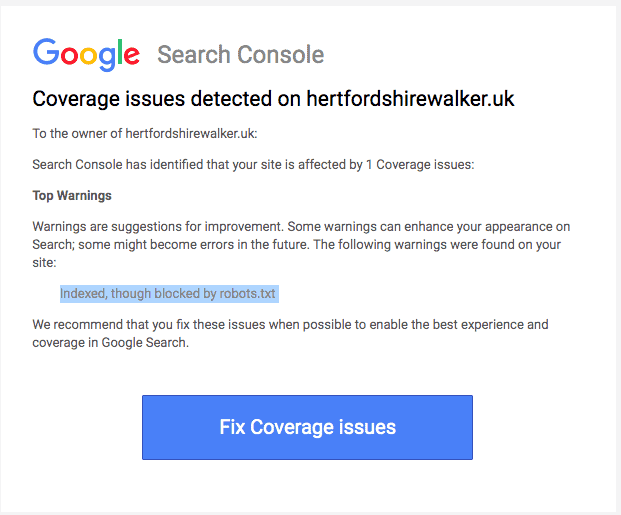

Обычно вы должны получать электронное письмо от Google, информирующее вас о «проблеме индексации» на вашем сайте. Вот как выглядит электронное письмо:

В электронном письме не будут указаны точные затронутые страницы или URL-адреса. Вам нужно будет войти в консоль поиска Google, чтобы выяснить это самостоятельно.

Если вы не получили электронное письмо, лучше все же увидеть его самостоятельно, чтобы убедиться, что ваш сайт находится в отличной форме.

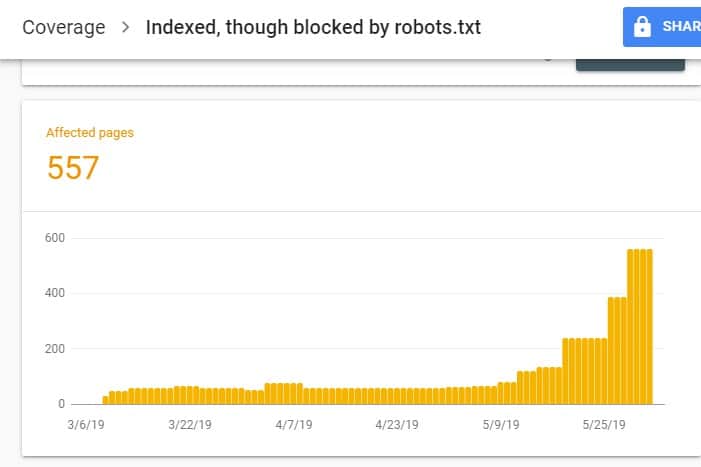

После входа в GSC перейдите к отчету о покрытии индекса, нажав «Покрытие» в разделе «Индекс». Затем на следующей странице прокрутите вниз, чтобы просмотреть проблемы, о которых сообщает GSC.

«Проиндексировано, но заблокировано robots.txt» помечено как «Действительно с предупреждением». Это означает, что в самом URL-адресе нет ничего плохого, но поисковые системы не будут отображать страницы в результатах поиска.

Почему на вашем сайте возникла эта проблема (и как ее исправить)?

Прежде чем вы начнете думать о решении, вы должны сначала знать, какие страницы должны быть проиндексированы и должны отображаться в результатах поиска.

Возможно, URL-адреса, которые вы видите в GSC с ошибкой «Проиндексировано, но заблокировано robots.txt», не предназначены для привлечения органического трафика на ваш сайт. Например, целевые страницы для ваших платных рекламных кампаний. Поэтому исправление страниц может не стоить вашего времени и усилий.

Ниже приведены причины, по которым на некоторых ваших страницах возникает эта проблема, и следует ли ее исправить:

Запретить правило для вашего robots.txt и метатега Noindex в HTML страницы

Наиболее распространенная причина, по которой возникает эта проблема, заключается в том, что вы или кто-либо, управляющий вашим сайтом, включает правило Disallow для этого конкретного URL-адреса в файле robots.txt вашего сайта и добавляет метатег noindex к тому же URL-адресу.

Во-первых, владельцы сайтов используют robots.txt, чтобы информировать сканеры поисковых систем о том, как обрабатывать URL-адреса вашего сайта. В этом случае вы добавили правило запрета на страницы и папки вашего сайта в robots.txt вашего сайта.

Вот что вы можете увидеть, открыв файл robots.txt вашего сайта:

Пользователь-агент: * Запретить: /

В приведенном выше примере эта строка кода запрещает всем поисковым роботам (*) сканировать страницы вашего сайта (запретить), включая вашу домашнюю страницу (/). В результате все поисковые системы не будут ни сканировать, ни индексировать страницы вашего сайта.

Вы можете отредактировать файл robots.txt, чтобы выделить поисковые роботы (Googlebot, msnbot, magpie-crawler и т. д.) и указать, какую страницу или страницы вы не хотите трогать поисковыми роботами (/page1, /page2, /page3 и т. д. ).

Однако, если у вас нет корневого доступа к вашему серверу, вы можете запретить ботам поисковых систем индексировать страницы вашего сайта, используя тег noindex.

Этот метод имеет тот же эффект, что и правило запрета в файле robots.txt. Однако вместо того, чтобы перечислять различные страницы и папки на вашем сайте в файле robots.txt, которые вы хотите предотвратить от появления в поисковой выдаче, вам нужно ввести метатег noindex на каждой странице вашего сайта, которую вы не хотите для отображения в результатах поиска.

Это гораздо более трудоемкий процесс, чем предыдущий метод, но он дает вам более детальный контроль над тем, какой URL блокировать. Это также означает, что с вашей стороны меньше вероятность ошибки.

Исправление: Опять же, проблема в GSC возникает, когда страницы вашего сайта имеют правило запрета в файле robots.txt и тег noindex.

Чтобы поисковые системы знали, индексировать страницу или нет, они должны иметь возможность сканировать ее с вашего сайта. Но если запретить поисковым системам делать это через файл robots.txt, они не будут знать, что делать с этой страницей.

Используя robots.txt и тег noindex, чтобы дополнять друг друга, а не конкурировать друг с другом, ваш сайт будет иметь гораздо более четкие и прямые правила, которым роботы поисковых систем должны следовать при обработке своих страниц.

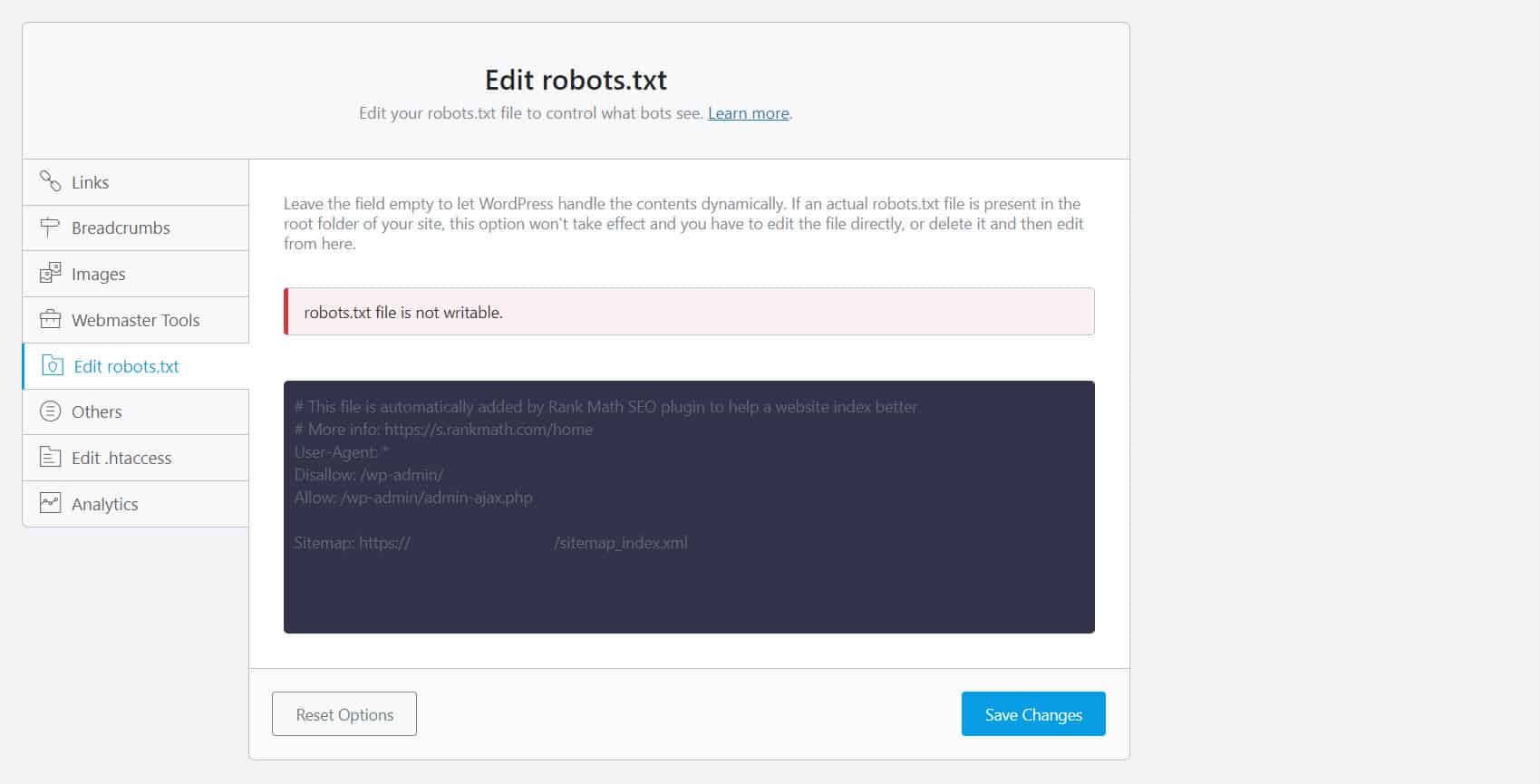

Для этого необходимо отредактировать файл robots.txt. Для владельцев сайтов WordPress наиболее удобным является использование SEO-плагинов с редактором robots.txt, таким как Yoast SEO или Rank Math.

Если robots.txt не доступен для записи с вашей стороны, вы должны обратиться к своему хостинг-провайдеру, чтобы внести изменения в права доступа к вашим файлам и папкам.

Другой способ — войти в свой FTP-клиент или файловый менеджер вашего хостинг-провайдера. Это предпочтительный метод среди разработчиков, потому что они имеют полный контроль над тем, как редактировать файл, среди прочего.

Неверный формат URL

URL-адреса на вашем сайте, которые на самом деле не являются «страницами» в самом строгом смысле, могут получить сообщение «Проиндексировано, хотя и заблокировано robots.txt».

Например, https://example.com?s=what+is+seo — это страница на сайте, которая показывает результаты поиска по запросу «что такое SEO». Этот URL-адрес распространен среди сайтов WordPress, где функция поиска включена для всего сайта.

Исправление: обычно нет необходимости решать эту проблему, если предположить, что URL-адрес безвреден и не сильно влияет на ваш поисковый трафик.

Страницы, которые вы не хотите индексировать, имеют внутренние ссылки

Даже если у вас есть тег noindex на странице, которую вы не хотите индексировать, Google может рассматривать их как предложения, а не как правила. Это очевидно, когда вы ссылаетесь на страницы с директивой noindex или правилом запрета на страницах вашего сайта, которые поисковые системы сканируют и индексируют.

Таким образом, вы можете увидеть эти страницы в поисковой выдаче, даже если вы этого не хотите.

Исправление : вы должны удалить ссылки, указывающие на эту конкретную страницу, и вместо этого вести их на аналогичную страницу.

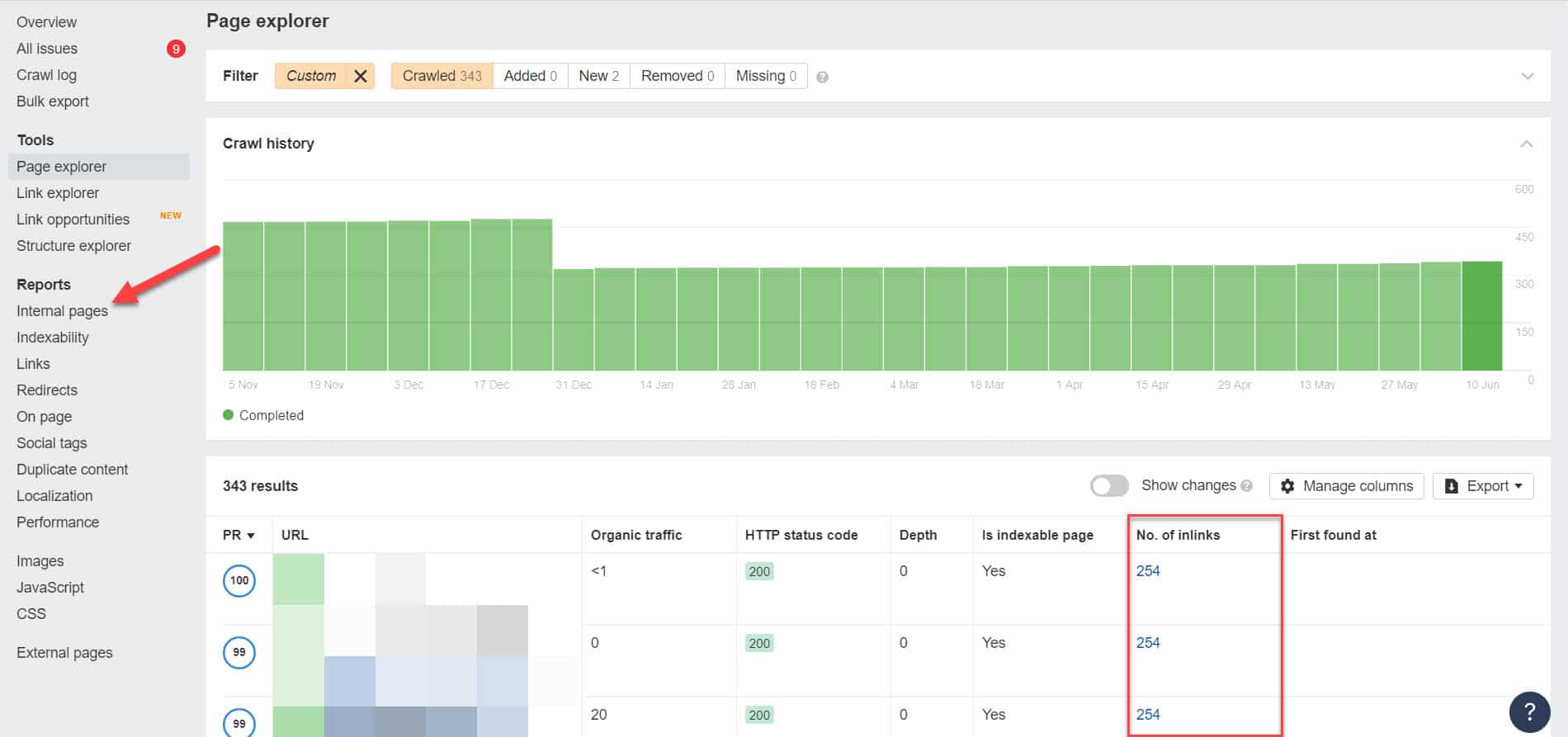

Для этого вы должны определить его внутренние ссылки, запустив SEO-аудит с помощью такого инструмента, как Screaming Frog (бесплатно для веб-сайтов с 500 URL-адресами) или инструментов для веб-мастеров Ahrefs (гораздо лучшая бесплатная альтернатива), чтобы определить, какие страницы ссылаются на ваши заблокированные страницы.

Используя Ahrefs, перейдите в «Отчеты» > «Внутренние страницы» после проведения аудита. Найдите страницы, которые вы заблокировали от поисковых роботов и не проиндексировали, и посмотрите, какие страницы ссылаются на них, в столбце «Количество внутренних ссылок».

Отсюда редактируйте ссылки с этих страниц по одной. Или вы можете заменить их ссылкой на свою страницу с тегом noindex.

Указание на цепочку перенаправления

Если ссылка на вашем сайте ведет к бесконечному потоку перенаправлений, робот Googlebot прекратит переход по каждой ссылке, прежде чем найдет фактический URL-адрес страницы.

Эти цепочки перенаправлений также могут вызывать проблемы с дублированным контентом, что в дальнейшем может привести к более серьезным проблемам с SEO. Единственный способ решить эту проблему — указать предпочтительную и каноническую страницу с помощью канонического тега, чтобы Google знал, какую из многих страниц следует сканировать и индексировать.

Кроме того, учтите, что ссылка на перенаправление вместо канонической страницы израсходует ваш краулинговый бюджет. Если ссылка перенаправления указывает на несколько перенаправлений, вы не сможете использовать краулинговый бюджет на важных страницах вашего сайта. К тому времени, когда он доберется до самых важных страниц, Google не сможет должным образом просканировать и проиндексировать их через некоторое время.

Исправление: Удалите ссылки перенаправления с вашего сайта и вместо этого ссылайтесь на каноническую страницу.

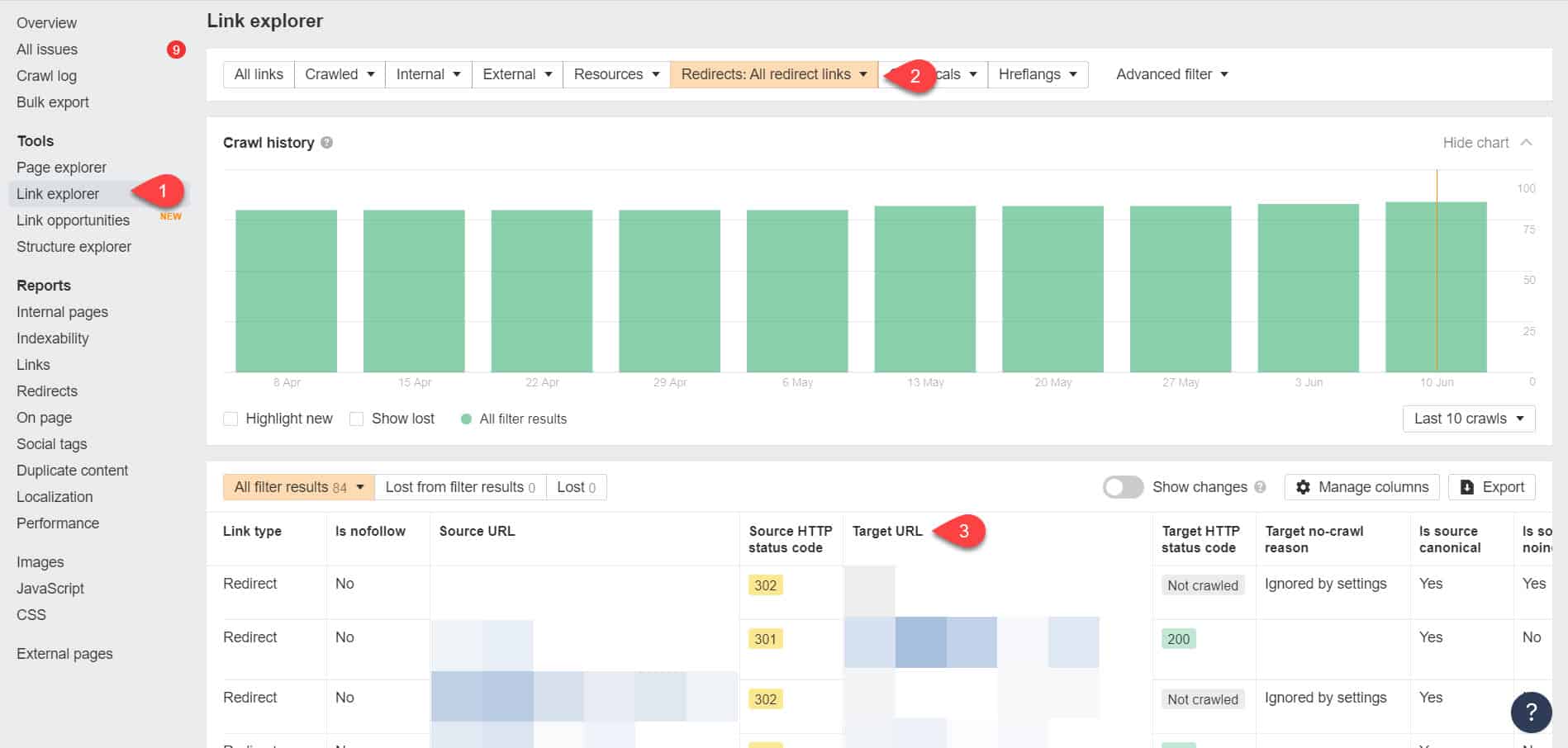

Снова воспользовавшись Инструментами для веб-мастеров Ahrefs, вы сможете просмотреть свои ссылки перенаправления на странице Инструменты > Обозреватель ссылок. Затем отфильтруйте результаты, чтобы показывать только ссылки перенаправления на вашем сайте.

По результатам определите, какие ссылки образуют бесконечную цепочку переадресации. Затем разорвите цепочку, найдя правильную страницу, на которую должна ссылаться каждая страница, ссылающаяся на переадресацию.

Что делать после устранения этой проблемы

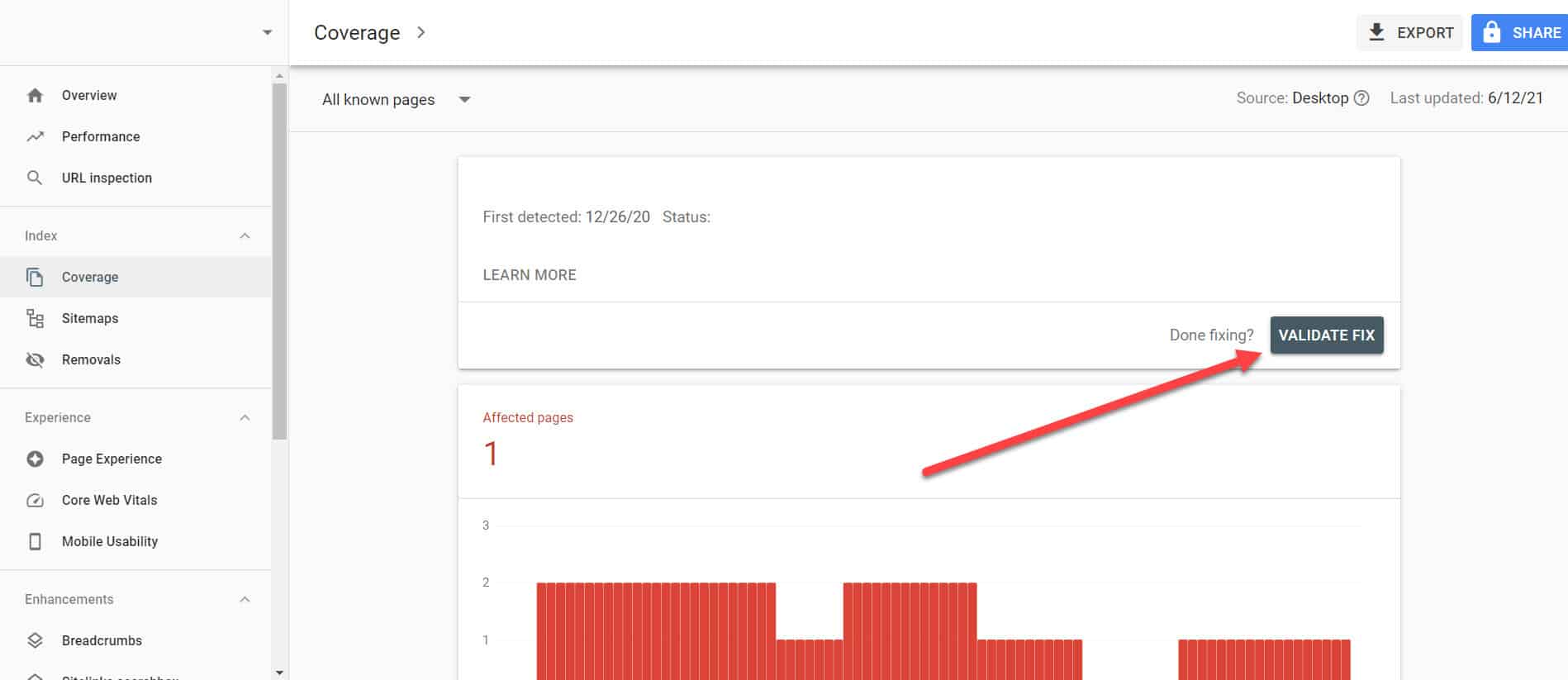

После того как вы реализовали приведенные выше решения для важных страниц с проблемой «Проиндексировано, но заблокировано Robots.txt», вам необходимо проверить изменения, чтобы Google Search Console мог пометить их как решенные.

Вернувшись к отчету об индексировании в GSC, нажмите на ссылки с исправленной проблемой. На следующем экране нажмите кнопку «Подтвердить исправление».

Это попросит Google проверить, устранена ли проблема на странице.

Вывод

В отличие от других проблем, обнаруженных Google Search Console, «Проиндексировано, но заблокировано robots.txt» может показаться каплей в море. Однако эти падения могут накапливаться в потоке проблем для всего вашего сайта, что не позволит ему генерировать органический трафик.

Следуя приведенным выше рекомендациям о том, как решить проблему на самых важных страницах, вы можете предотвратить потерю ценного трафика на своем веб-сайте, оптимизировав свой веб-сайт для Google для правильного сканирования и индексирования.