Diindeks, Meskipun Diblokir oleh Robots.txt: Semua yang Perlu Anda Ketahui

Diterbitkan: 2021-07-01Jika Anda memiliki halaman di situs web Anda yang diindeks oleh Google tetapi tidak dapat dirayapi, Anda akan menerima pesan “Diindeks, Meskipun Diblokir oleh Robots.txt” di Google Search Console (GSC).

Meskipun Google dapat melihat halaman ini, itu tidak akan menampilkannya sebagai bagian dari halaman hasil mesin pencari untuk kata kunci target mereka.

Jika ini masalahnya, Anda akan kehilangan kesempatan untuk mendapatkan lalu lintas organik untuk halaman-halaman ini.

Ini sangat penting untuk halaman yang menghasilkan ribuan pengunjung organik bulanan hanya untuk menghadapi masalah ini.

Pada titik ini, Anda mungkin memiliki banyak pertanyaan tentang pesan kesalahan ini. Mengapa Anda menerimanya? Bagaimana hal itu terjadi? Dan, yang lebih penting, bagaimana Anda bisa memperbaikinya dan memulihkan lalu lintas jika ini terjadi pada halaman yang sudah berperingkat baik.

Posting ini akan menjawab semua pertanyaan ini dan menunjukkan kepada Anda bagaimana menghindari masalah ini terjadi lagi di situs Anda.

Bagaimana Mengetahui apakah Situs Anda Memiliki Masalah Ini

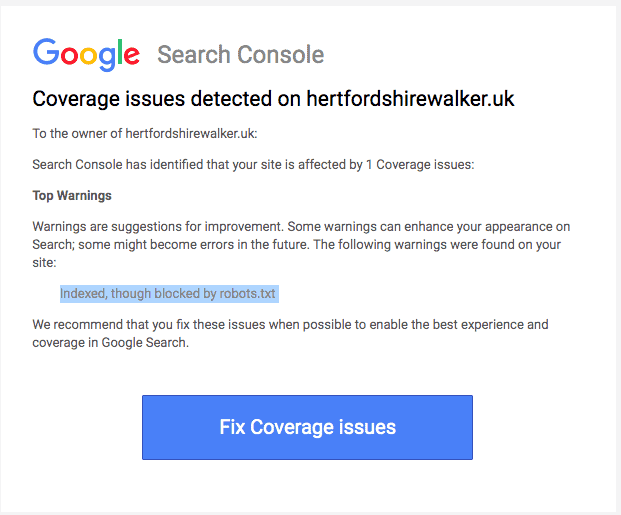

Biasanya, Anda akan menerima email dari Google yang memberi tahu Anda tentang "masalah cakupan indeks" di situs Anda. Berikut tampilan emailnya:

Email tidak akan menentukan halaman atau URL yang terpengaruh. Anda harus masuk ke Google Search Console untuk mencari tahu sendiri.

Jika Anda tidak menerima email, sebaiknya Anda tetap melihatnya sendiri untuk memastikan situs Anda dalam kondisi prima.

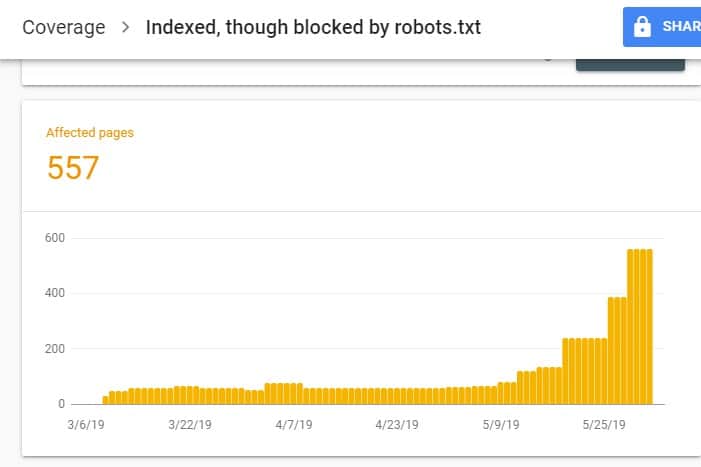

Setelah masuk ke GSC, buka Laporan Cakupan Indeks dengan mengklik Cakupan di bawah Indeks. Kemudian, pada halaman berikutnya, gulir ke bawah untuk melihat masalah yang dilaporkan oleh GSC.

"Diindeks, Meskipun Diblokir oleh robots.txt" diberi label di bawah "Valid dengan peringatan". Ini berarti tidak ada yang salah dengan URL itu sendiri, tetapi mesin pencari tidak akan menampilkan halaman pada hasil mesin pencari.

Mengapa Situs Anda Memiliki Masalah Ini (dan Bagaimana Cara Memperbaikinya)?

Sebelum mulai memikirkan solusi, Anda harus tahu dulu halaman mana yang perlu diindeks dan harus muncul di hasil pencarian.

Ada kemungkinan bahwa URL yang Anda lihat di GSC dengan masalah "Diindeks, Meskipun Diblokir oleh robots.txt" tidak dimaksudkan untuk mengarahkan lalu lintas organik ke situs Anda. Misalnya, halaman arahan untuk kampanye iklan berbayar Anda. Oleh karena itu, memperbaiki halaman mungkin tidak sepadan dengan waktu dan usaha Anda.

Berikut adalah alasan mengapa beberapa halaman Anda mengalami masalah ini dan apakah Anda harus memperbaikinya atau tidak:

Aturan Larang di Robots.txt dan Meta Tag Noindex Anda di HTML Halaman

Alasan paling umum mengapa masalah ini terjadi adalah ketika Anda atau seseorang yang mengelola situs Anda mengaktifkan aturan Larang untuk URL tertentu tersebut di robots.txt situs Anda dan menambahkan tag meta noindex pada URL yang sama.

Pertama, pemilik situs menggunakan robots.txt untuk memberi tahu perayap mesin telusur tentang cara menangani URL situs Anda. Dalam hal ini, Anda menambahkan Aturan Disallow pada halaman dan folder situs Anda di robots.txt situs web Anda.

Berikut yang mungkin Anda lihat saat membuka file robots.txt situs Anda:

Agen-pengguna: * Larang: /

Pada contoh di atas, baris kode ini mencegah semua perayap web (*) merayapi halaman situs Anda (Larang) menyertakan beranda Anda (/). Akibatnya, semua mesin pencari tidak akan merayapi atau mengindeks halaman situs Anda.

Anda dapat mengedit robots.txt untuk memilih perayap web (Googlebot, msnbot, magpie-crawler, dll.) dan menentukan halaman atau halaman mana yang tidak boleh disentuh oleh perayap (/page1, /page2, /page3, dll. ).

Namun, jika Anda tidak memiliki akses root ke server, Anda dapat mencegah bot mesin telusur mengindeks halaman situs Anda menggunakan tag noindex.

Metode ini memiliki efek yang sama seperti aturan disallow pada robots.txt. Namun, alih-alih mencantumkan halaman dan folder yang berbeda di situs Anda dalam file robots.txt yang ingin Anda cegah agar tidak muncul di SERP, Anda harus memasukkan tag meta noindex pada setiap halaman situs Anda yang tidak Anda inginkan. untuk muncul di hasil pencarian.

Ini adalah proses yang jauh lebih memakan waktu daripada metode sebelumnya, tetapi ini memberi Anda kontrol yang lebih terperinci untuk URL mana yang akan diblokir. Ini juga berarti ada margin kesalahan yang lebih rendah di pihak Anda.

Perbaiki: Sekali lagi, masalah di GSC muncul ketika halaman di situs Anda memiliki aturan larangan pada file robots.txt dan tag noindex.

Agar mesin telusur mengetahui apakah akan mengindeks halaman atau tidak, mesin telusur harus dapat merayapinya dari situs Anda. Tetapi jika Anda mencegah mesin pencari melakukannya melalui robots.txt Anda, itu tidak akan tahu apa yang harus dilakukan dengan halaman itu.

Dengan menggunakan robots.txt dan tag noindex untuk melengkapi dan tidak bersaing satu sama lain, situs Anda akan memiliki aturan yang lebih jelas dan lebih langsung untuk diikuti oleh bot mesin telusur saat merawat halamannya.

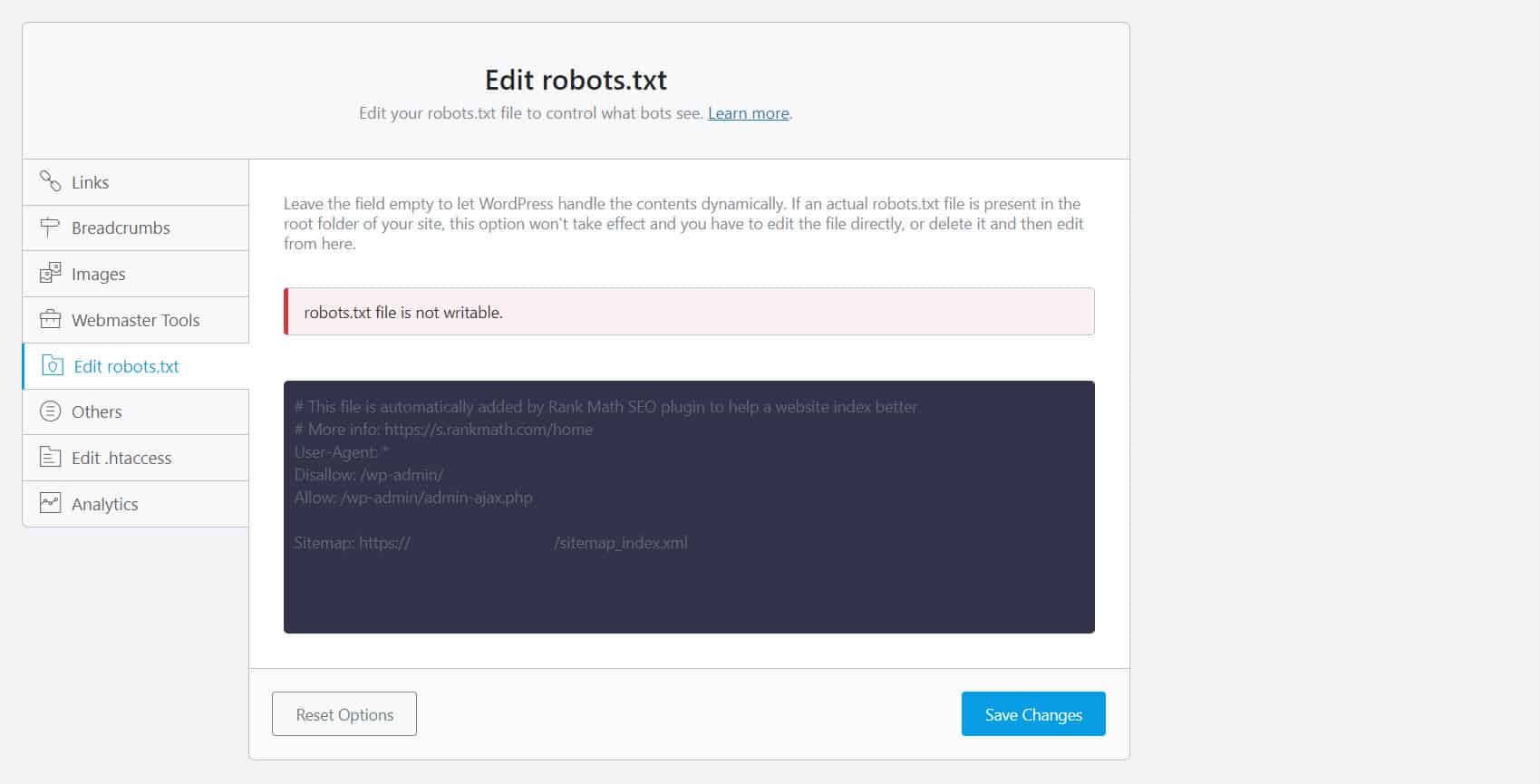

Untuk melakukannya, Anda harus mengedit file robots.txt Anda. Untuk pemilik situs WordPress, menggunakan plugin SEO dengan editor robots.txt seperti Yoast SEO atau Rank Math adalah yang paling nyaman.

Jika robots.txt tidak dapat ditulis di pihak Anda, Anda harus menghubungi penyedia hosting Anda untuk membuat perubahan izin pada file dan folder Anda.

Cara lain adalah masuk ke klien FTP Anda atau Manajer File dari penyedia hosting Anda. Ini adalah metode yang disukai di antara pengembang karena mereka memiliki kontrol penuh atas cara mengedit file antara lain.

Format URL Salah

URL di situs Anda yang sebenarnya bukan "laman" dalam arti sempit mungkin menerima pesan "Diindeks, Meskipun Diblokir oleh robots.txt".

Misalnya, https://example.com?s=what+is+seo adalah laman di situs yang menampilkan hasil penelusuran untuk kueri “apa itu seo.” URL ini lazim di antara situs WordPress di mana fitur pencarian diaktifkan di seluruh situs.

Fix: Biasanya, tidak ada kebutuhan untuk mengatasi masalah ini, dengan asumsi bahwa URL tidak berbahaya dan tidak terlalu mempengaruhi lalu lintas pencarian Anda.

Halaman yang Tidak Ingin Diindeks Memiliki Tautan Internal

Bahkan jika Anda memiliki tag noindex pada halaman yang tidak ingin Anda indeks, Google dapat memperlakukannya sebagai saran, bukan aturan. Ini terbukti saat Anda menautkan ke halaman dengan arahan noindex atau aturan larangan pada halaman di situs Anda yang dirayapi dan diindeks oleh mesin telusur.

Oleh karena itu, Anda mungkin melihat halaman-halaman ini muncul di SERP meskipun Anda tidak menginginkannya.

Perbaiki : Anda harus menghapus tautan yang mengarah ke halaman khusus ini dan mengarahkannya ke halaman serupa.

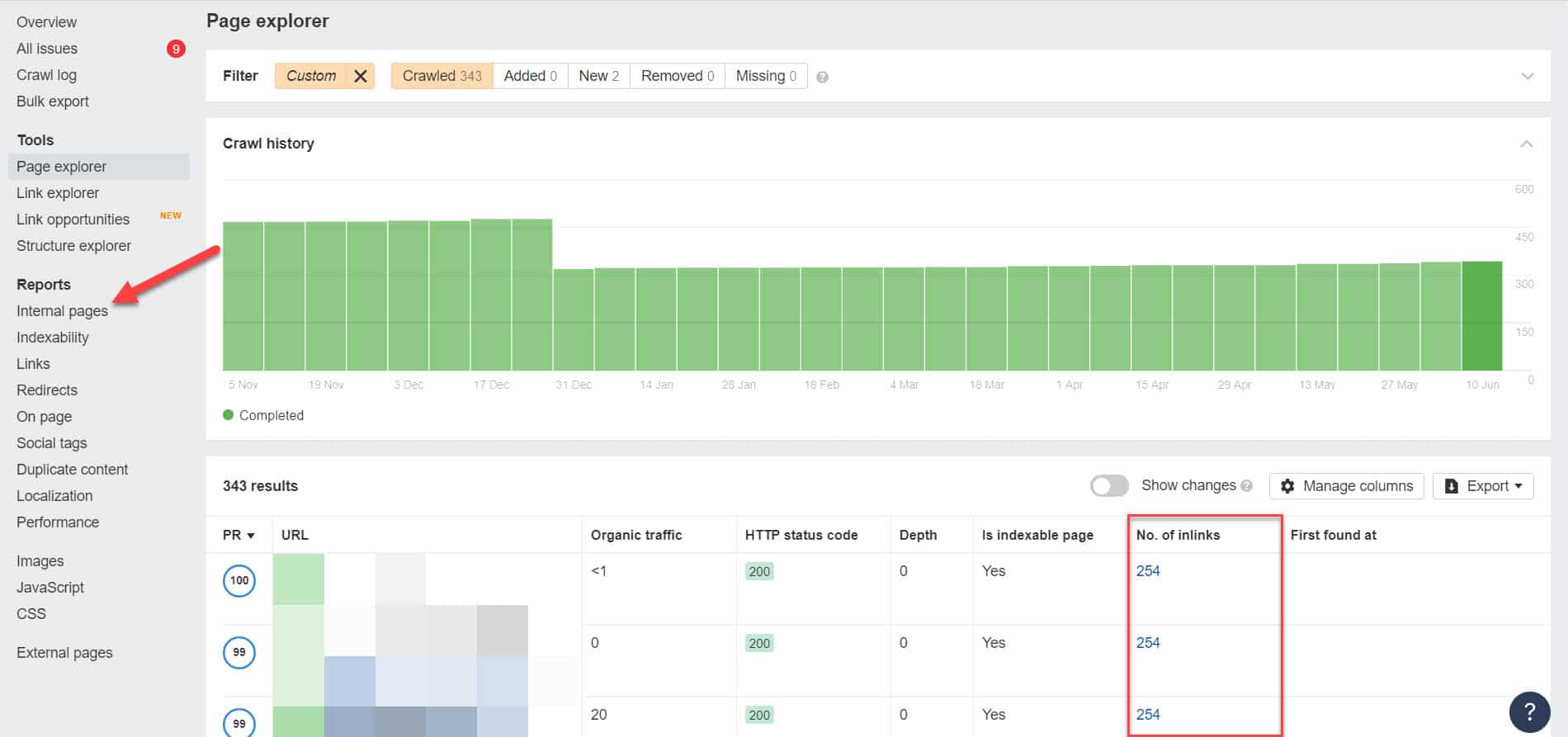

Untuk melakukan ini, Anda harus mengidentifikasi tautan internalnya dengan menjalankan audit SEO menggunakan alat seperti Screaming Frog (gratis untuk situs web dengan 500 URL) atau Alat Webmaster Ahrefs (alternatif gratis yang jauh lebih baik) untuk mengidentifikasi halaman mana yang tertaut ke halaman Anda yang diblokir.

Menggunakan Ahrefs, buka Laporan > Halaman internal setelah menjalankan audit. Temukan halaman yang telah Anda blokir dari perayap web dan tidak diindeks dan lihat halaman mana yang tertaut ke halaman tersebut di kolom Jumlah Tautan.

Dari sini, edit tautan dari halaman ini satu per satu. Atau Anda dapat menggantinya dengan tautan ke halaman Anda dengan tag noindex.

Menunjuk ke Rantai Pengalihan

Jika tautan di situs Anda mengarah ke aliran pengalihan tanpa akhir, Googlebot akan berhenti melewati setiap tautan sebelum menemukan URL sebenarnya ke laman tersebut.

Rantai pengalihan ini juga dapat menyebabkan masalah konten duplikat yang dapat menyebabkan masalah SEO yang lebih besar. Satu-satunya cara untuk mengatasinya adalah dengan mengidentifikasi halaman pilihan dan kanonik Anda dengan tag kanonik sehingga Google mengetahui halaman mana di antara banyak halaman yang harus dirayapi dan diindeks.

Juga, pertimbangkan bahwa menautkan ke pengalihan alih-alih halaman kanonik menghabiskan anggaran perayapan Anda. Jika tautan pengalihan mengarah ke beberapa pengalihan, Anda tidak dapat menggunakan anggaran perayapan pada laman yang penting di situs Anda. Pada saat sampai ke halaman yang paling penting, Google tidak akan dapat meng-crawl dan mengindeksnya dengan benar setelah suatu periode.

Fix: Hilangkan link redirect dari situs Anda dan link ke halaman kanonik sebagai gantinya.

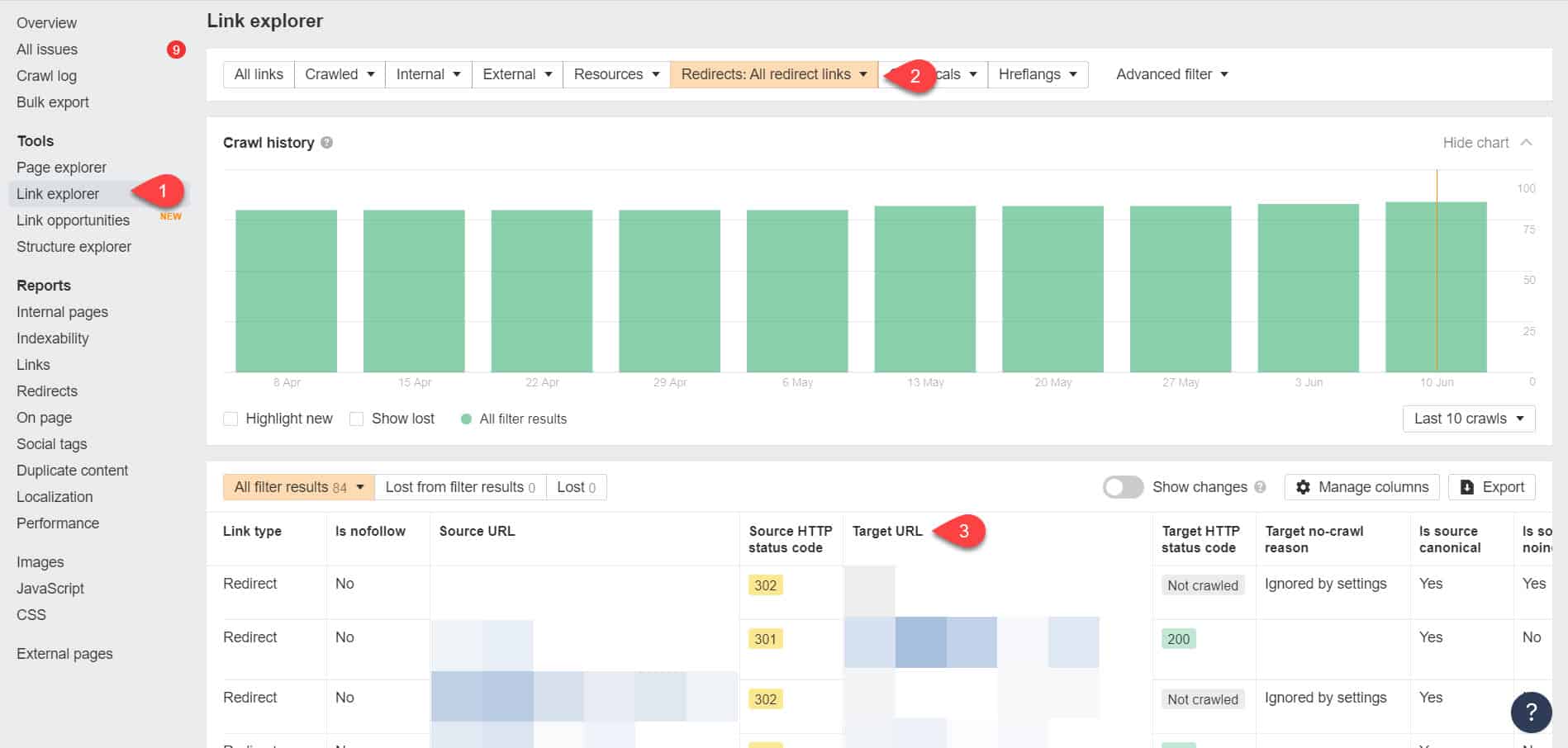

Dengan menggunakan Alat Webmaster Ahrefs lagi, Anda dapat melihat tautan pengalihan di halaman Alat > Penjelajah Tautan. Kemudian filter hasilnya untuk hanya menampilkan tautan pengalihan di situs Anda.

Dari hasil, identifikasi tautan mana yang membentuk rantai pengalihan tanpa akhir. Kemudian putuskan rantai dengan menemukan halaman yang benar yang harus ditautkan ke setiap halaman yang tertaut ke pengalihan.

Apa yang Harus Dilakukan Setelah Memperbaiki Masalah Ini

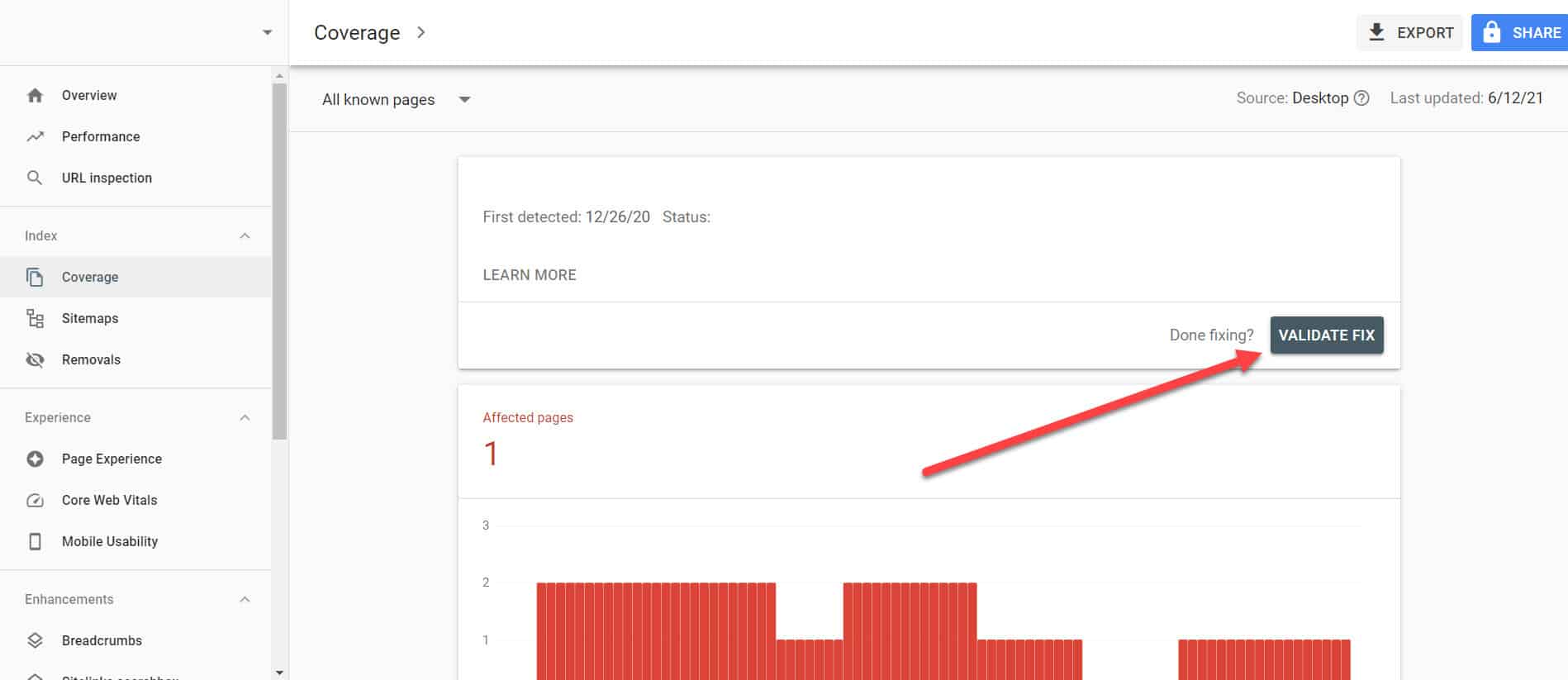

Setelah Anda menerapkan solusi di atas ke halaman penting dengan masalah “Diindeks, Meskipun Diblokir oleh Robots.txt”, Anda perlu memverifikasi perubahan agar Google Search Console dapat menandainya sebagai terselesaikan.

Kembali ke Laporan Cakupan Indeks di GSC, klik tautan dengan masalah ini yang telah Anda perbaiki. Pada layar berikutnya, klik tombol Validasi Fix.

Ini akan meminta Google untuk memverifikasi jika halaman tidak lagi memiliki masalah.

Kesimpulan

Tidak seperti masalah lain yang ditemukan oleh Google Search Console, "Diindeks, Meskipun Diblokir oleh robots.txt" mungkin tampak seperti masalah kecil. Namun, penurunan ini dapat terakumulasi menjadi semburan masalah ke seluruh situs Anda yang akan mencegahnya menghasilkan lalu lintas organik.

Dengan mengikuti panduan di atas tentang cara mengatasi masalah pada halaman terpenting Anda, Anda dapat mencegah situs web Anda kehilangan lalu lintas yang berharga dengan mengoptimalkan situs web Anda agar Google dapat merayapi dan mengindeks dengan benar.