Indicizzato, sebbene bloccato da Robots.txt: tutto ciò che devi sapere

Pubblicato: 2021-07-01Se sul tuo sito web sono presenti pagine che Google ha indicizzato ma non è possibile eseguire la scansione, riceverai un messaggio "Indicizzato, sebbene bloccato da Robots.txt" su Google Search Console (GSC).

Sebbene Google possa visualizzare queste pagine, non le mostrerà come parte delle pagine dei risultati dei motori di ricerca per le loro parole chiave di destinazione.

In questo caso, perderai l'opportunità di ottenere traffico organico per queste pagine.

Ciò è particolarmente cruciale per le pagine che generano migliaia di visitatori organici mensili solo per incontrare questo problema.

A questo punto, probabilmente hai molte domande su questo messaggio di errore. Perché l'hai ricevuto? Come è successo? E, soprattutto, come puoi risolverlo e recuperare il traffico se ciò è accaduto a una pagina che era già ben classificata.

Questo post risponderà a tutte queste domande e ti mostrerà come evitare che questo problema si ripresenti sul tuo sito.

Come sapere se il tuo sito ha questo problema

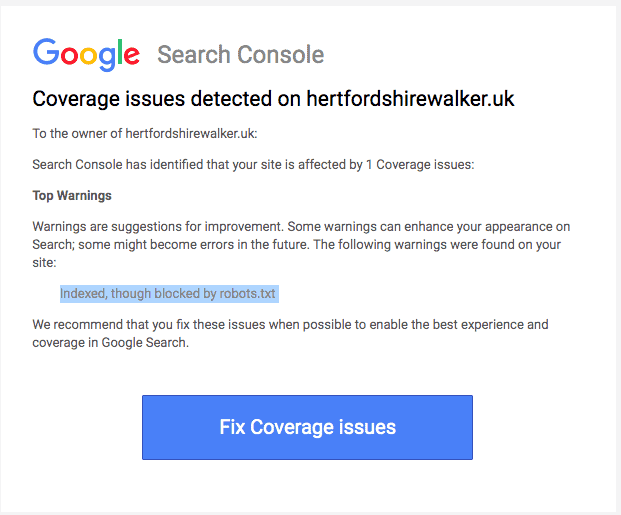

Normalmente, dovresti ricevere un'email da Google che ti informa di un "problema di copertura dell'indice" sul tuo sito. Ecco come appare l'e-mail:

L'e-mail non specificherà quali sono le pagine o l'URL interessati. Dovrai accedere alla tua Google Search Console per scoprirlo.

Se non hai ricevuto un'e-mail, è meglio comunque vederla di persona per assicurarti che il tuo sito sia in perfetta forma.

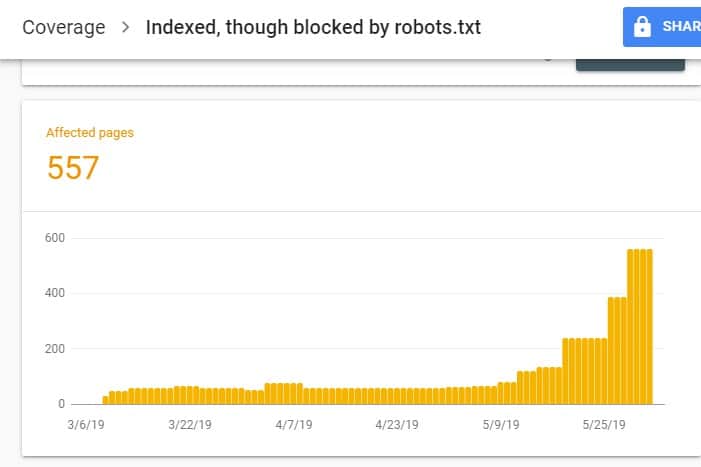

Dopo aver effettuato l'accesso a GSC, vai al rapporto sulla copertura dell'indice facendo clic su Copertura sotto l'indice. Quindi, nella pagina successiva, scorrere verso il basso per visualizzare i problemi segnalati da GSC.

"Indicizzato, sebbene bloccato da robots.txt" è etichettato in "Valido con avviso". Ciò significa che non c'è niente di sbagliato nell'URL di per sé, ma i motori di ricerca non mostreranno le pagine sui risultati dei motori di ricerca.

Perché il tuo sito presenta questo problema (e come risolverlo)?

Prima di iniziare a pensare a una soluzione, devi prima sapere quali pagine devono essere indicizzate e devono apparire nei risultati di ricerca.

È possibile che gli URL che vedi su GSC con il problema "Indicizzato, sebbene bloccato da robots.txt" non siano destinati a indirizzare traffico organico al tuo sito. Ad esempio, pagine di destinazione per le tue campagne pubblicitarie a pagamento. Pertanto, riparare le pagine potrebbe non valere il tuo tempo e fatica.

Di seguito sono riportati i motivi per cui alcune delle tue pagine presentano questo problema e se dovresti risolverli o meno:

Regola di non consentire sul tuo Robots.txt e Meta tag Noindex nell'HTML della pagina

Il motivo più comune per cui si verifica questo problema è quando tu o qualcuno che gestisce il tuo sito abilita la regola Non consentire per quell'URL specifico sul robots.txt del tuo sito e aggiungi il meta tag noindex sullo stesso URL.

Innanzitutto, i proprietari dei siti utilizzano robots.txt per informare i crawler dei motori di ricerca su come trattare gli URL del tuo sito. In questo caso, hai aggiunto la regola di non autorizzazione su pagine e cartelle del tuo sito nel file robots.txt del tuo sito web.

Ecco cosa potresti vedere quando apri il file robots.txt del tuo sito:

User-agent: * Disallow: /

Nell'esempio sopra, questa riga di codice impedisce a tutti i web crawler (*) di eseguire la scansione delle pagine del tuo sito (Disallow) inclusa la tua home page (/). Di conseguenza, tutti i motori di ricerca non eseguiranno la scansione né indicizzeranno le pagine del tuo sito.

Puoi modificare robots.txt per individuare i crawler web (Googlebot, msnbot, magpie-crawler, ecc.) e specificare quale pagina o pagine non desideri vengano toccate dai crawler (/page1, /page2, /page3, ecc. ).

Tuttavia, se non disponi dell'accesso come root al tuo server, puoi impedire ai bot dei motori di ricerca di indicizzare le pagine del tuo sito utilizzando il tag noindex.

Questo metodo ha lo stesso effetto della regola di non autorizzazione su robots.txt. Tuttavia, invece di elencare le diverse pagine e cartelle del tuo sito in un file robots.txt che vuoi impedire che appaiano sulle SERP, devi inserire il meta tag noindex su ogni pagina del tuo sito che non vuoi per apparire nei risultati di ricerca.

Questo è un processo che richiede molto più tempo rispetto al metodo precedente, ma offre un controllo più granulare su quale URL bloccare. Ciò significa anche che c'è un margine di errore più basso da parte tua.

Correzione: ancora una volta, il problema in GSC si verifica quando le pagine del tuo sito hanno una regola di non autorizzazione sul file robots.txt e un tag noindex.

Affinché i motori di ricerca sappiano se indicizzare una pagina o meno, dovrebbero essere in grado di scansionarla dal tuo sito. Ma se impedisci ai motori di ricerca di farlo tramite il tuo robots.txt, non saprebbe cosa fare con quella pagina.

Utilizzando robots.txt e il tag noindex per integrarsi e non competere tra loro, il tuo sito avrà regole molto più chiare e dirette che i bot dei motori di ricerca devono seguire quando trattano le sue pagine.

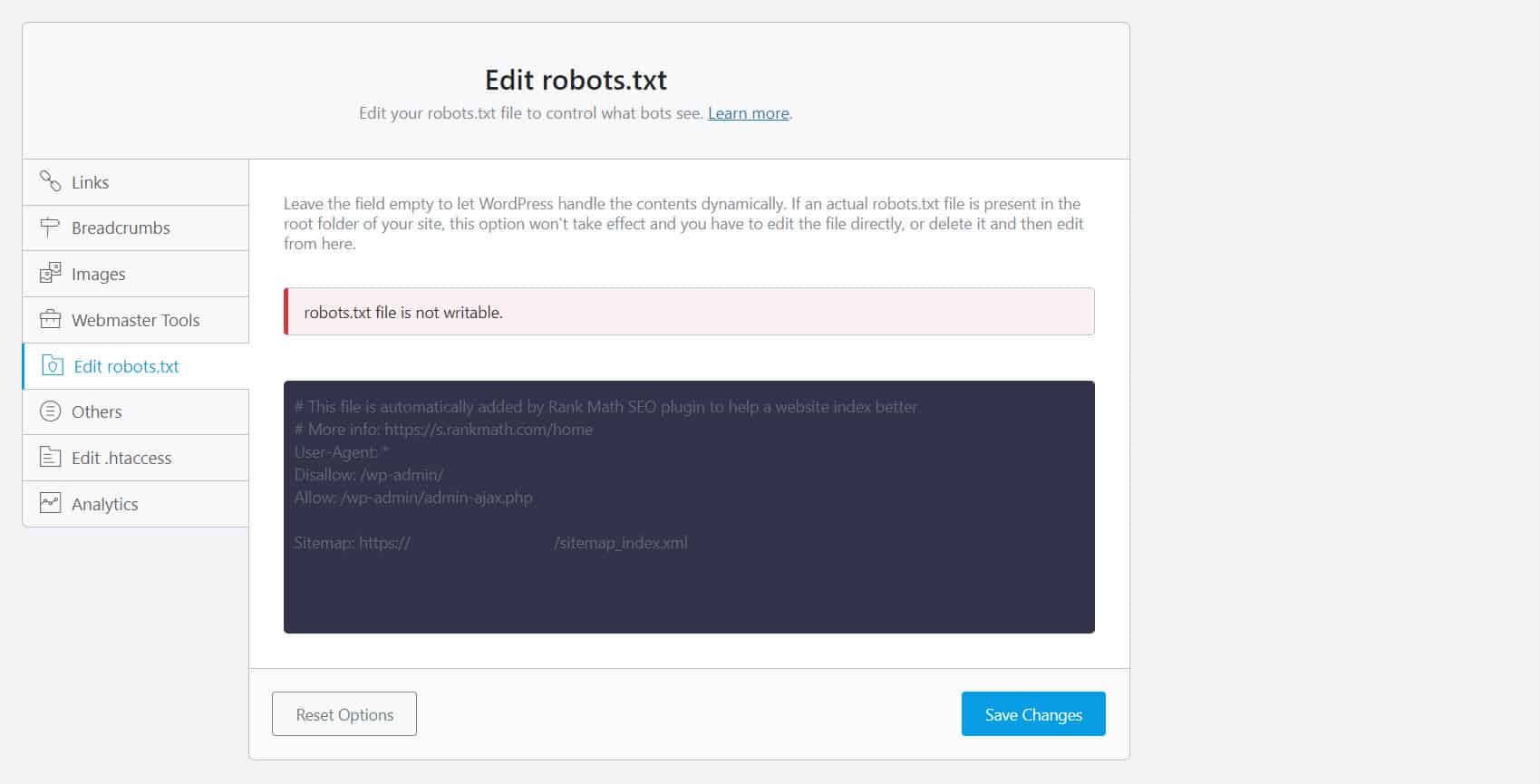

Per fare ciò, devi modificare il tuo file robots.txt. Per i proprietari di siti WordPress, l'utilizzo di plug-in SEO con un editor robots.txt come Yoast SEO o Rank Math è il più conveniente.

Se il file robots.txt non è scrivibile da parte tua, devi contattare il tuo provider di hosting per apportare modifiche alle autorizzazioni ai tuoi file e cartelle.

Un altro modo è accedere al tuo client FTP o al File Manager del tuo provider di hosting. Questo è il metodo preferito dagli sviluppatori perché hanno il controllo completo su come modificare il file, tra le altre cose.

Formato URL errato

Gli URL del tuo sito che non sono realmente "pagine" in senso stretto possono ricevere il messaggio "Indicizzato, sebbene bloccato da robots.txt".

Ad esempio, https://example.com?s=what+is+seo è una pagina di un sito che mostra i risultati della ricerca per la query "cos'è seo". Questo URL è prevalente tra i siti WordPress in cui la funzione di ricerca è abilitata a livello di sito.

Correzione: normalmente, non è necessario risolvere questo problema, presupponendo che l'URL sia innocuo e non influisca profondamente sul traffico di ricerca.

Le pagine che non vuoi indicizzare hanno collegamenti interni

Anche se hai un tag noindex sulla pagina che non desideri indicizzare, Google potrebbe trattarli come suggerimenti anziché come regole. Ciò è evidente quando ti colleghi a pagine con una direttiva noindex o non consenti la regola sulle pagine del tuo sito che i motori di ricerca scansionano e indicizzano.

Pertanto, potresti vedere queste pagine apparire sulle SERP anche se non lo desideri.

Correzione : è necessario rimuovere i collegamenti che puntano a questa particolare pagina e condurli invece a una pagina simile.

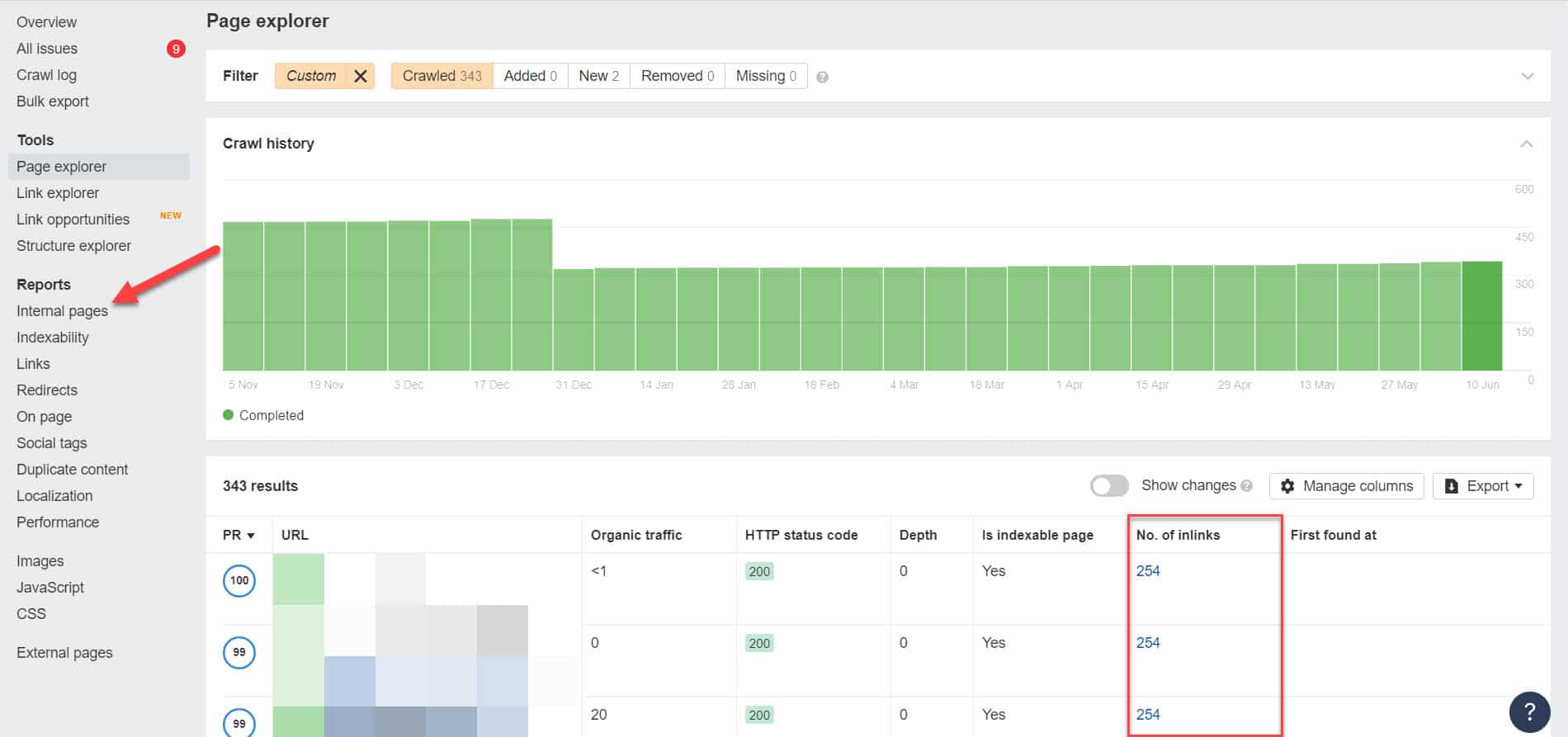

Per fare ciò, devi identificare i suoi collegamenti interni eseguendo un audit SEO utilizzando uno strumento come Screaming Frog (gratuito per siti Web con 500 URL) o Ahrefs Webmaster Tools (un'alternativa gratuita molto migliore) per identificare quali pagine rimandano alle tue pagine bloccate.

Usando Ahrefs, vai su Rapporti > Pagine interne dopo aver eseguito un controllo. Trova le pagine che hai bloccato da web crawler e noindexed e guarda quali pagine si collegano ad esse nella colonna No. of Inlinks.

Da qui, modifica i collegamenti da queste pagine uno alla volta. Oppure puoi sostituirli con un link alla tua pagina con un tag noindex.

Puntando a una catena di reindirizzamento

Se un link sul tuo sito punta a un flusso infinito di reindirizzamenti, Googlebot smetterà di passare attraverso ogni link prima che trovi l'URL effettivo della pagina.

Queste catene di reindirizzamento potrebbero anche causare problemi di contenuto duplicato che potrebbero causare problemi SEO più grandi su tutta la linea. L'unico modo per risolvere questo problema è identificare la tua pagina preferita e canonica con il tag canonico in modo che Google sappia quale pagina tra le tante dovrebbe scansionare e indicizzare.

Inoltre, considera che il collegamento per reindirizzare anziché la pagina canonica esaurisce il budget di scansione. Se il link di reindirizzamento punta a più reindirizzamenti, non puoi utilizzare il budget di scansione sulle pagine importanti del tuo sito. Quando raggiunge le pagine più importanti, Google non sarà in grado di scansionarle e indicizzarle correttamente dopo un certo periodo.

Correzione: elimina i collegamenti di reindirizzamento dal tuo sito e collega invece alla pagina canonica.

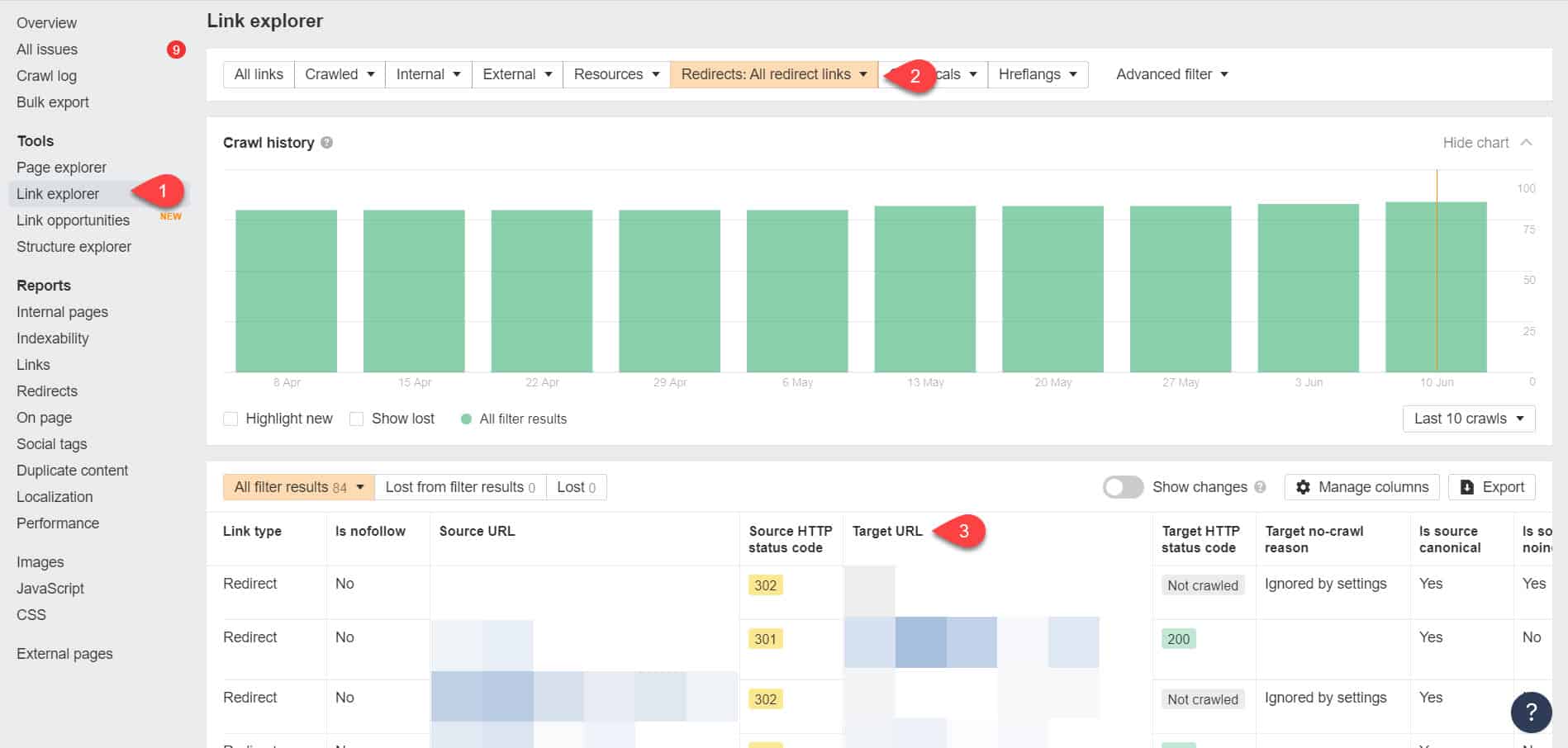

Utilizzando di nuovo gli Strumenti per i Webmaster di Ahrefs, puoi visualizzare i tuoi link di reindirizzamento nella pagina Strumenti > Esplora link. Quindi filtra i risultati per mostrarti solo i link di reindirizzamento nel tuo sito.

Dai risultati, identifica quali collegamenti formano una catena di reindirizzamento infinita. Quindi interrompi la catena trovando la pagina corretta a cui dovrebbe collegarsi ogni pagina collegata ai reindirizzamenti.

Cosa fare dopo aver risolto questo problema

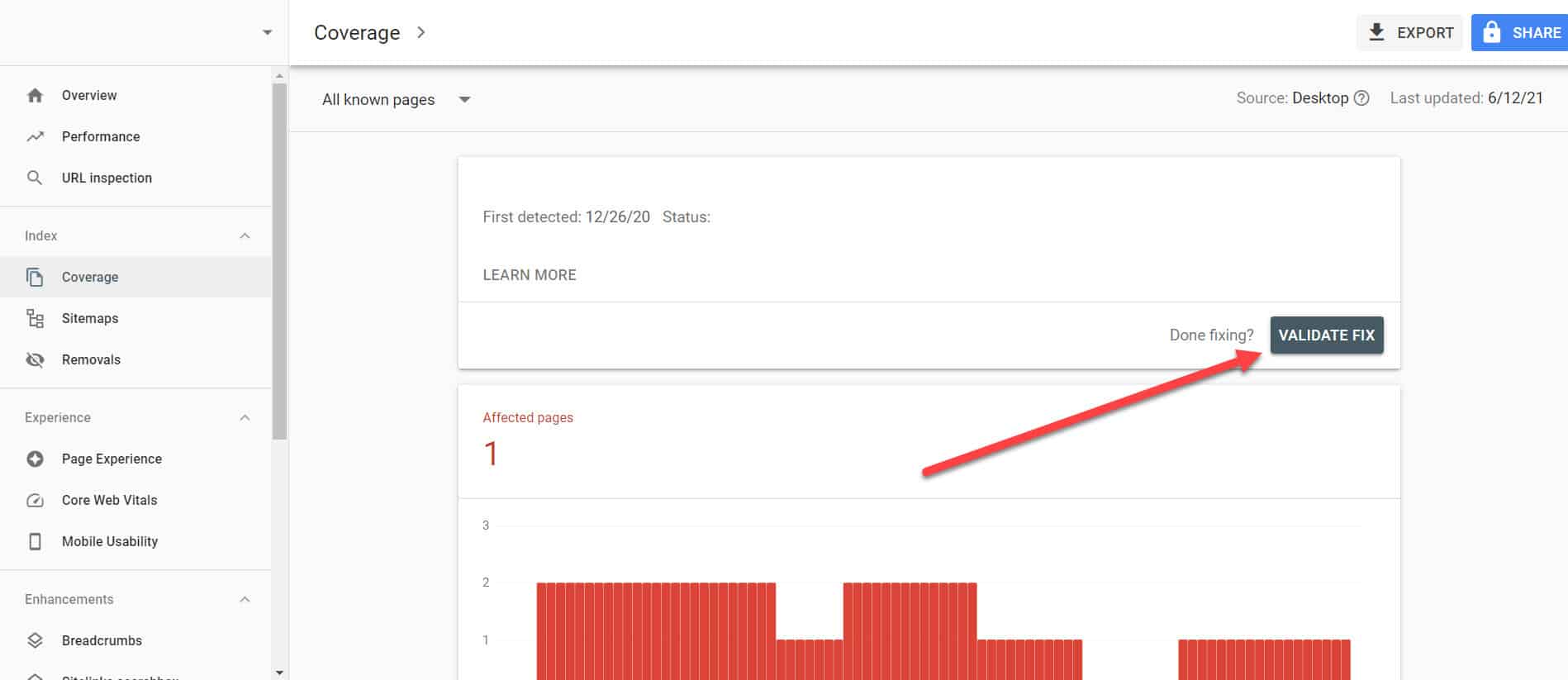

Dopo aver implementato le soluzioni precedenti in pagine importanti con il problema "Indicizzato, sebbene bloccato da Robots.txt", devi verificare le modifiche in modo che Google Search Console possa contrassegnarle come risolte.

Tornando al rapporto sulla copertura dell'indice in GSC, fai clic sui collegamenti con questo problema che hai risolto. Nella schermata successiva, fare clic sul pulsante Convalida correzione.

Ciò richiederà a Google di verificare se la pagina non presenta più il problema.

Conclusione

A differenza di altri problemi scoperti da Google Search Console, "Indicizzato, sebbene bloccato da robots.txt" può sembrare una goccia nel mare. Tuttavia, queste gocce potrebbero accumularsi in un torrente di problemi per l'intero sito che gli impedirà di generare traffico organico.

Seguendo le linee guida di cui sopra su come risolvere il problema sulle tue pagine più importanti, puoi evitare che il tuo sito web perda traffico prezioso ottimizzando il tuo sito web per consentire a Google di eseguire correttamente la scansione e l'indicizzazione.