Robots.txtによってブロックされていますが、インデックスが作成されています:知っておくべきことすべて

公開: 2021-07-01ウェブサイトにGoogleがインデックスを作成したがクロールできないページがある場合、Google検索コンソール(GSC)に「インデックスが作成されましたがRobots.txtによってブロックされています」というメッセージが表示されます。

Googleはこれらのページを表示できますが、ターゲットキーワードの検索エンジン結果ページの一部としては表示されません。

この場合、これらのページのオーガニックトラフィックを獲得する機会を逃してしまいます。

これは、この問題に遭遇するだけで毎月何千ものオーガニックビジターを生成するページにとって特に重要です。

この時点で、おそらくこのエラーメッセージについて多くの質問があります。 なぜ受け取ったのですか? どうやってそうなった? そして、さらに重要なことは、これがすでにランク付けされているページに発生した場合、どのように修正してトラフィックを回復できるかです。

この投稿では、これらすべての質問に回答し、この問題がサイトで再発しないようにする方法を示します。

サイトにこの問題があるかどうかを知る方法

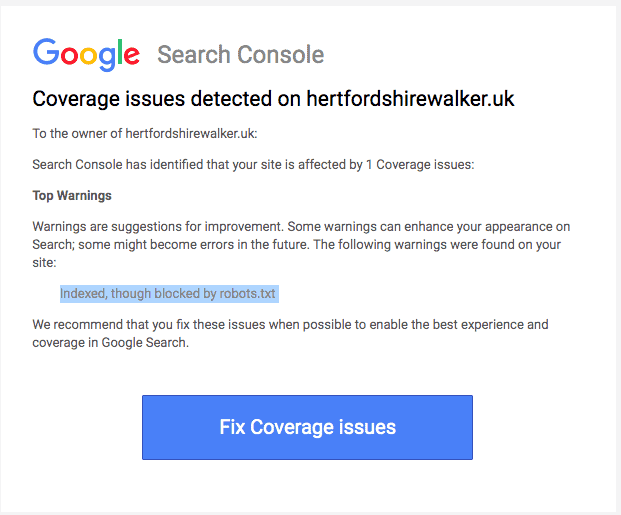

通常、サイトの「インデックスカバレッジの問題」を通知するメールがGoogleから届きます。 メールは次のようになります。

電子メールには、影響を受ける正確なページまたはURLが何であるかが指定されていません。 自分自身を見つけるには、Google検索コンソールにログインする必要があります。

メールを受信しなかった場合でも、自分でメールを確認して、サイトが最高の状態になっていることを確認することをお勧めします。

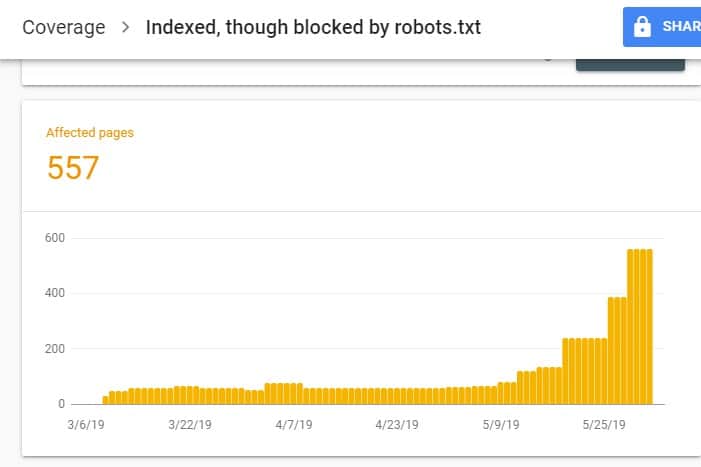

GSCにログインしたら、[インデックス]の下の[カバレッジ]をクリックして、[インデックスカバレッジレポート]に移動します。 次に、次のページで下にスクロールして、GSCによって報告されている問題を確認します。

「インデックスが作成されましたが、robots.txtによってブロックされています」には、「警告付きで有効」というラベルが付いています。 これは、URL自体には何の問題もないことを意味しますが、検索エンジンは検索エンジンの結果にページを表示しません。

なぜあなたのサイトにこの問題があるのですか(そしてどのように修正するのですか)?

解決策を考える前に、最初にどのページにインデックスを付ける必要があり、検索結果に表示する必要があるかを知っておく必要があります。

「robots.txtによってブロックされていますが、インデックスが作成されています」という問題でGSCに表示されるURLは、サイトへのオーガニックトラフィックを促進するためのものではない可能性があります。 たとえば、有料広告キャンペーンのランディングページ。 したがって、ページを修正することはあなたの時間と労力の価値がないかもしれません。

一部のページでこの問題が発生する理由と、それらを修正する必要があるかどうかを以下に示します。

ページのHTMLでRobots.txtとNoindexメタタグのルールを禁止する

この問題が発生する最も一般的な理由は、あなたまたはあなたのサイトを管理している誰かがあなたのサイトのrobots.txtでその特定のURLに対して不許可ルールを有効にし、同じURLにnoindexメタタグを追加した場合です。

まず、サイトの所有者はrobots.txtを使用して、サイトのURLの処理方法を検索エンジンのクローラーに通知します。 この場合、Webサイトのrobots.txtのサイトのページとフォルダーに禁止ルールを追加しました。

サイトのrobots.txtファイルを開いたときに表示される内容は次のとおりです。

ユーザーエージェント:*禁止:/

上記の例では、このコード行は、すべてのWebクローラー(*)がホームページ(/)を含むサイトページをクロールするのを防ぎます(禁止)。 その結果、すべての検索エンジンがサイトページをクロールしたりインデックスに登録したりすることはありません。

robots.txtを編集して、ウェブクローラー(Googlebot、msnbot、magpie-crawlerなど)を選び出し、クローラーにアクセスさせたくないページ(/ page1、/ page2、/ page3など)を指定できます。 )。

ただし、サーバーへのルートアクセス権がない場合は、検索エンジンボットがnoindexタグを使用してサイトページにインデックスを付けるのを防ぐことができます。

この方法は、robots.txtの禁止ルールと同じ効果があります。 ただし、SERPに表示されないようにするrobots.txtファイルにサイトのさまざまなページやフォルダを一覧表示する代わりに、サイトの各ページに不要なnoindexメタタグを入力する必要があります。検索結果に表示されます。

これは、以前の方法よりもはるかに時間のかかるプロセスですが、ブロックするURLをよりきめ細かく制御できます。 これは、エラーの許容誤差が少ないことも意味します。

修正: GSCの問題は、サイトのページにrobots.txtファイルとnoindexタグの禁止ルールがある場合に発生します。

検索エンジンがページにインデックスを付けるかどうかを知るためには、サイトからページをクロールできる必要があります。 しかし、robots.txtを介して検索エンジンがそうするのを防ぐと、そのページをどう処理するかがわかりません。

robots.txtとnoindexタグを使用して相互に補完し、競合しないようにすることで、サイトは、ページを処理するときに検索エンジンボットが従うべきより明確で直接的なルールを持つことになります。

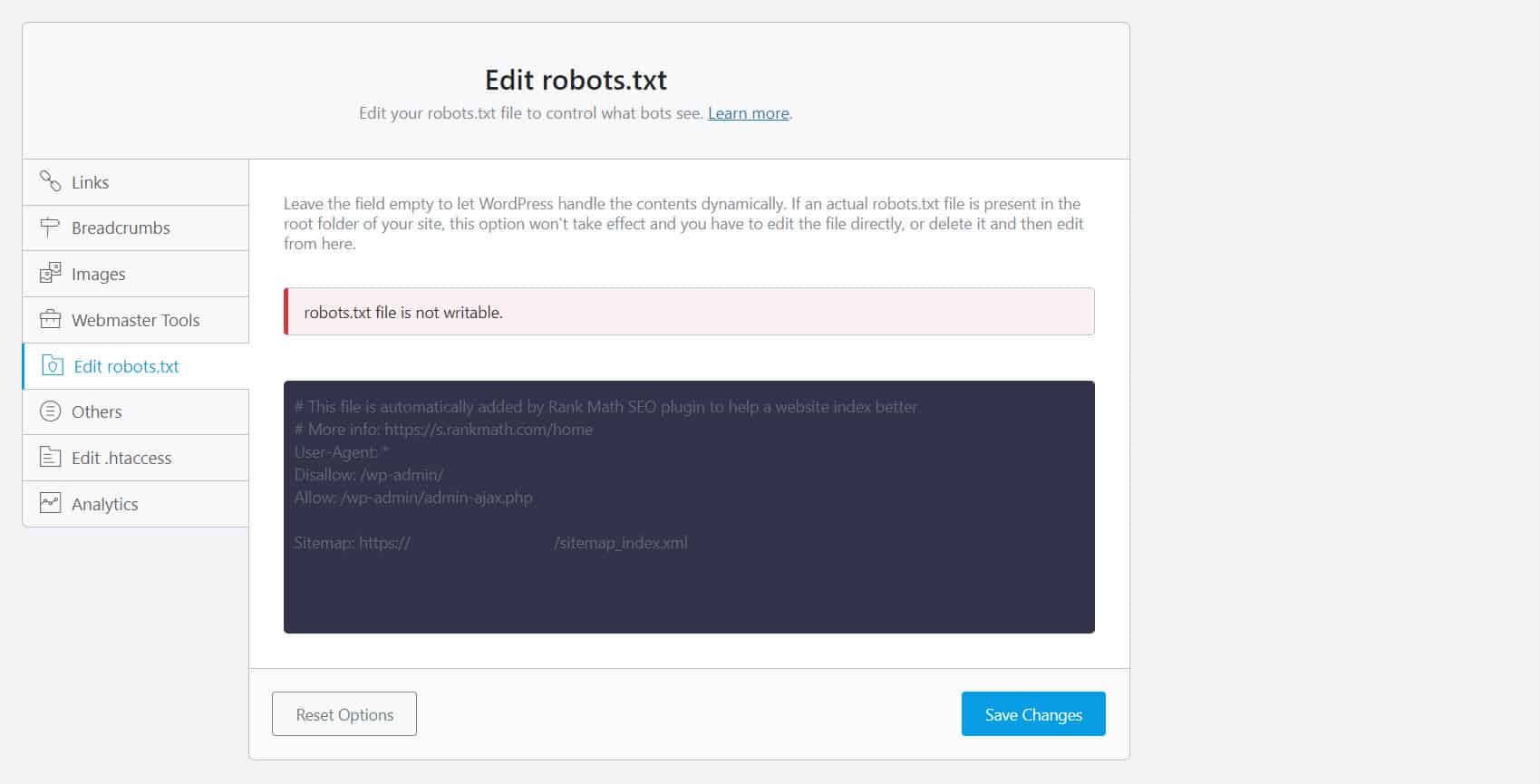

これを行うには、robots.txtファイルを編集する必要があります。 WordPressサイトの所有者にとっては、YoastSEOやRankMathなどのrobots.txtエディターでSEOプラグインを使用するのが最も便利です。

robots.txtが書き込み可能でない場合は、ホスティングプロバイダーに連絡して、ファイルとフォルダーのアクセス許可を変更する必要があります。

もう1つの方法は、FTPクライアントまたはホスティングプロバイダーのファイルマネージャーにログインすることです。 これは、特にファイルの編集方法を完全に制御できるため、開発者の間で推奨される方法です。

間違ったURL形式

厳密な意味で実際には「ページ」ではないサイト内のURLは、「robots.txtによってブロックされていますが、インデックスに登録されています」というメッセージを受け取る場合があります。

たとえば、https://example.com?s = what + is + seoは、「whatisseo」というクエリの検索結果を表示するサイト上のページです。 このURLは、検索機能がサイト全体で有効になっているWordPressサイトで広く使用されています。

修正:通常、URLが無害であり、検索トラフィックに深刻な影響を与えていないことを前提として、この問題に対処する必要はありません。

インデックスに登録したくないページには内部リンクがあります

インデックスに登録したくないページにnoindexタグがある場合でも、Googleはそれらをルールではなく提案として扱う場合があります。 これは、検索エンジンがクロールしてインデックスを作成するサイトのページで、noindexディレクティブまたはdisallowルールを使用してページにリンクする場合に明らかです。

したがって、必要がない場合でも、これらのページがSERPに表示される場合があります。

修正:この特定のページを指すリンクを削除し、代わりに同様のページに誘導する必要があります。

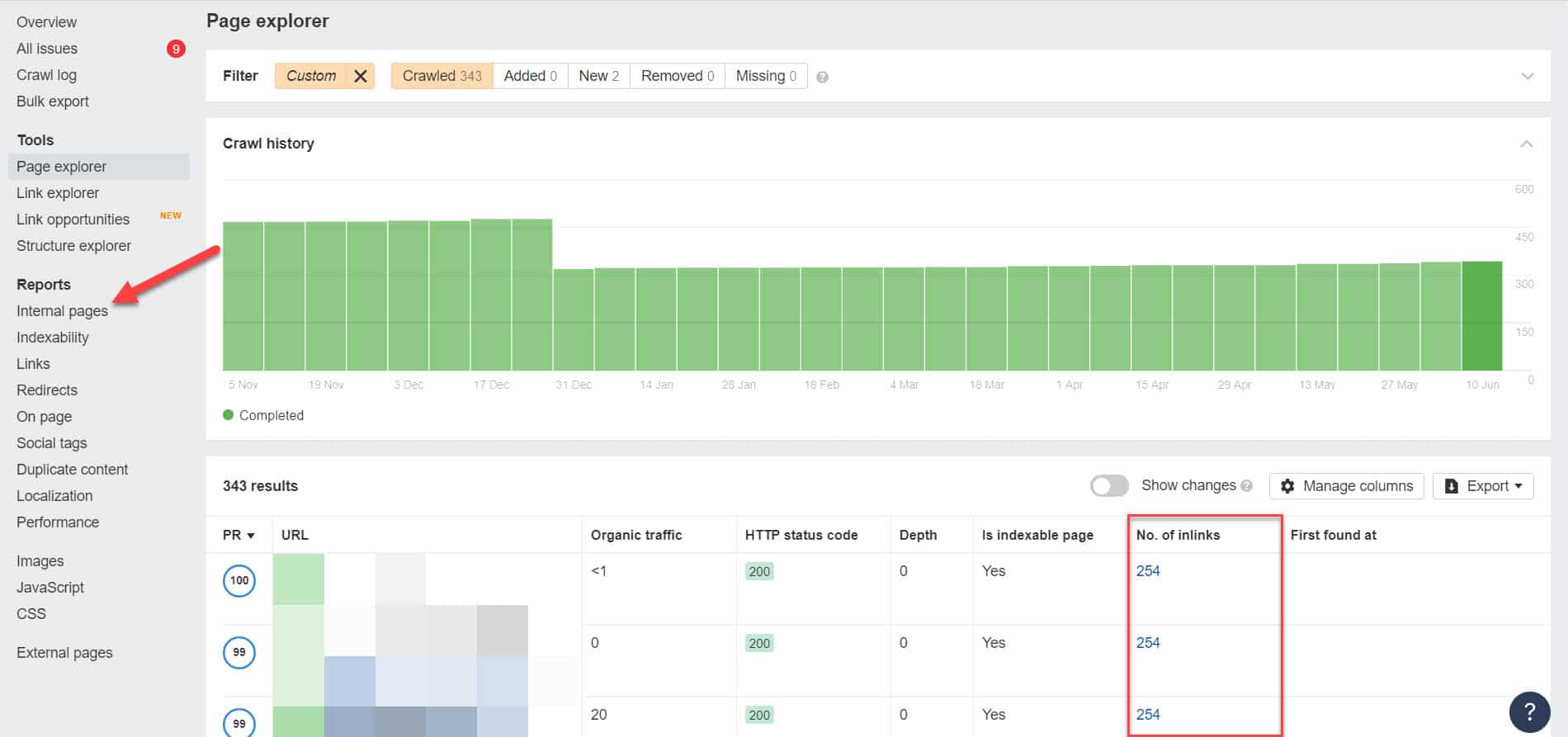

これを行うには、Screaming Frog(500のURLを持つWebサイトでは無料)やAhrefs Webmaster Tools(はるかに優れた無料の代替手段)などのツールを使用してSEO監査を実行し、ブロックされたページにリンクしているページを特定して、内部リンクを特定する必要があります。

Ahrefsを使用して、監査の実行後に[レポート]>[内部ページ]に移動します。 Webクローラーからブロックし、インデックスが作成されていないページを見つけて、[リンク数]列でそれらにリンクしているページを確認します。

ここから、これらのページのリンクを1つずつ編集します。 または、noindexタグを使用してページへのリンクに置き換えることもできます。

リダイレクトチェーンを指す

サイト上のリンクがリダイレクトの無限のストリームを指している場合、Googlebotはページへの実際のURLを見つける前に各リンクの通過を停止します。

これらのリダイレクトチェーンはまた、重複したコンテンツの問題を引き起こす可能性があり、将来的にはより大きなSEOの問題を引き起こす可能性があります。 これを解決する唯一の方法は、正規タグを使用して優先する正規ページを識別することです。これにより、Googleは、多くのページのうち、クロールしてインデックスを作成する必要があるページを認識します。

また、正規のページではなくリダイレクトにリンクすると、クロールの予算が使い果たされることを考慮してください。 リダイレクトリンクが複数のリダイレクトを指している場合、サイトで重要なページでクロール予算を使用することはできません。 最も重要なページに到達するまでに、Googleは一定期間後にそれらを適切にクロールしてインデックスに登録することができなくなります。

修正:サイトからリダイレクトリンクを削除し、代わりに正規ページにリンクします。

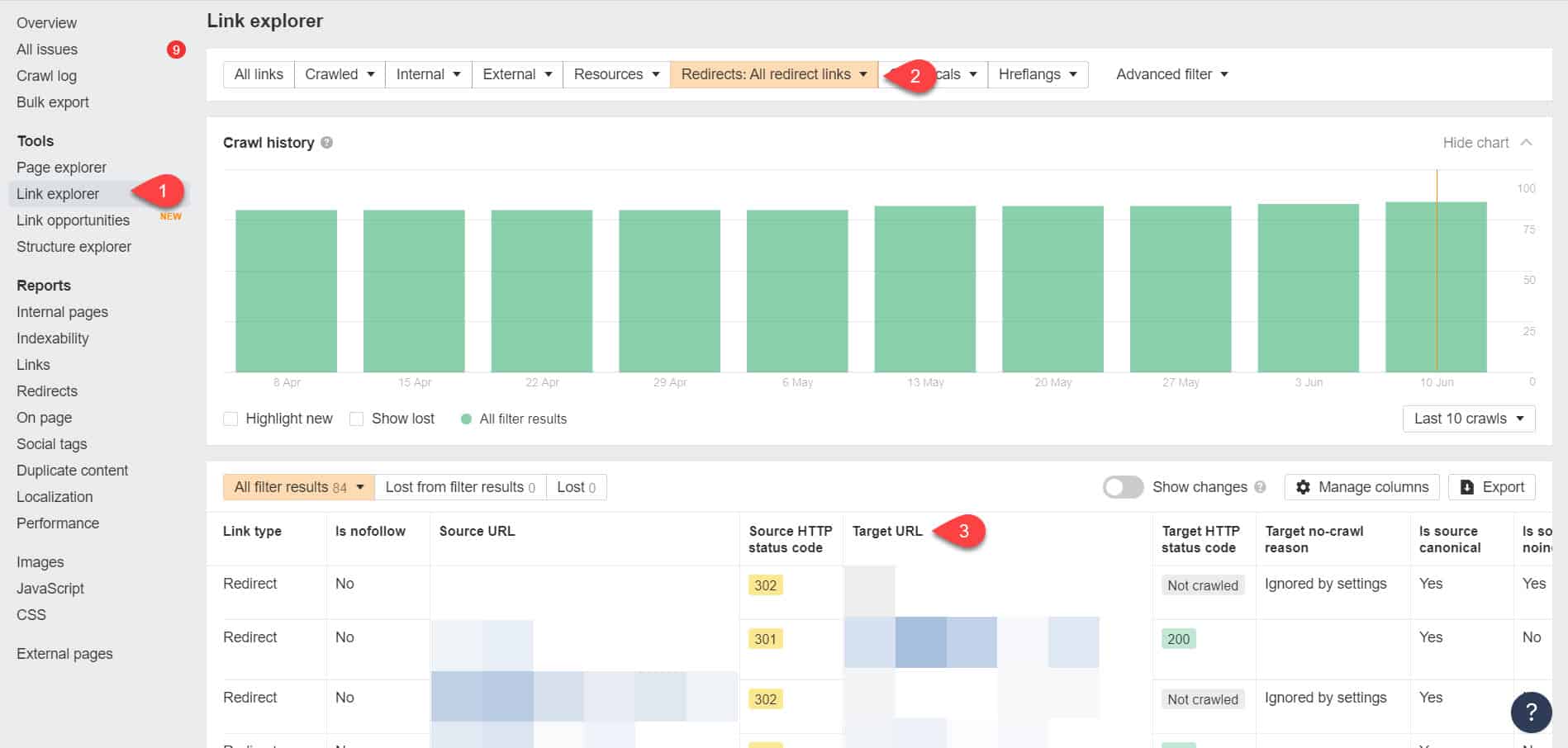

Ahrefs Webmaster Toolsを再度使用すると、[ツール]>[リンクエクスプローラー]ページでリダイレクトリンクを表示できます。 次に、結果をフィルタリングして、サイト内のリダイレクトリンクのみを表示します。

結果から、どのリンクが無限のリダイレクトチェーンを形成しているかを特定します。 次に、リダイレクトにリンクしている各ページがリンクする必要がある正しいページを見つけて、チェーンを切断します。

この問題を修正した後の対処方法

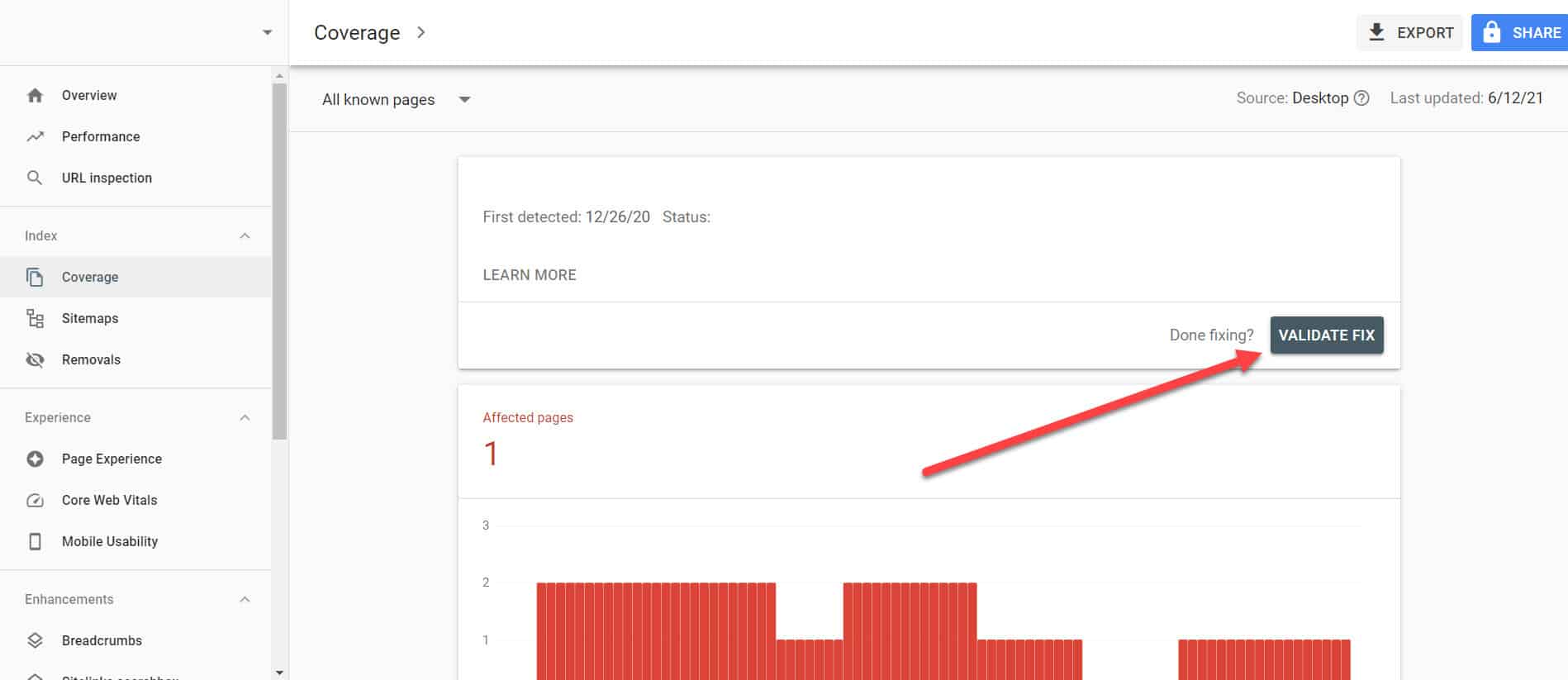

「インデックスが作成されましたが、Robots.txtによってブロックされています」という問題のある重要なページに上記のソリューションを実装したら、Google検索コンソールがそれらを解決済みとしてマークできるように変更を確認する必要があります。

GSCのインデックスカバレッジレポートに戻り、修正したこの問題のリンクをクリックします。 次の画面で、[修正の検証]ボタンをクリックします。

これにより、ページに問題がなくなったかどうかを確認するようGoogleに要求されます。

結論

Google Search Consoleで発見された他の問題とは異なり、「インデックスが作成されましたが、robots.txtによってブロックされました」は、バケツのドロップのように見える場合があります。 ただし、これらのドロップは、サイト全体の問題の急流に蓄積され、オーガニックトラフィックの生成を妨げる可能性があります。

最も重要なページの問題を解決する方法に関する上記のガイドラインに従うことで、Googleが適切にクロールしてインデックスを作成できるようにウェブサイトを最適化することで、ウェブサイトが貴重なトラフィックを失うのを防ぐことができます。