จัดทำดัชนี แม้ว่าจะถูกบล็อกโดย Robots.txt: ทุกสิ่งที่คุณต้องรู้

เผยแพร่แล้ว: 2021-07-01หากคุณมีหน้าเว็บบนเว็บไซต์ที่ Google จัดทำดัชนีแต่ไม่สามารถรวบรวมข้อมูลได้ คุณจะได้รับข้อความ “จัดทำดัชนี แม้ว่าจะถูกบล็อกโดย Robots.txt” บน Google Search Console (GSC)

แม้ว่า Google สามารถดูหน้าเหล่านี้ได้ แต่จะไม่แสดงหน้าดังกล่าวเป็นส่วนหนึ่งของหน้าผลลัพธ์ของเครื่องมือค้นหาสำหรับคำหลักเป้าหมาย

หากเป็นกรณีนี้ คุณจะพลาดโอกาสที่จะได้รับการเข้าชมแบบออร์แกนิกสำหรับหน้าเหล่านี้

นี่เป็นสิ่งสำคัญอย่างยิ่งสำหรับหน้าเว็บที่สร้างผู้เข้าชมอินทรีย์รายเดือนจำนวนหลายพันคนเท่านั้นที่จะพบปัญหานี้

ณ จุดนี้ คุณอาจมีคำถามมากมายเกี่ยวกับข้อความแสดงข้อผิดพลาดนี้ ทำไมคุณถึงได้รับมัน? มันเกิดขึ้นได้อย่างไร? และที่สำคัญกว่านั้น คุณจะแก้ไขและกู้คืนการเข้าชมได้อย่างไร หากสิ่งนี้เกิดขึ้นกับหน้าเว็บที่มีการจัดอันดับดีอยู่แล้ว

โพสต์นี้จะตอบคำถามเหล่านี้ทั้งหมดและแสดงวิธีหลีกเลี่ยงปัญหานี้ไม่ให้เกิดขึ้นบนไซต์ของคุณอีก

จะทราบได้อย่างไรว่าเว็บไซต์ของคุณมีปัญหานี้หรือไม่

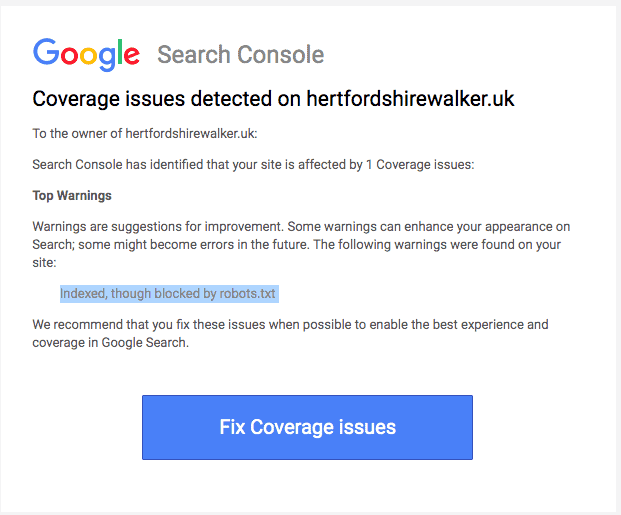

โดยปกติ คุณควรได้รับอีเมลจาก Google เพื่อแจ้งเกี่ยวกับ “ปัญหาความครอบคลุมของดัชนี” บนไซต์ของคุณ นี่คือลักษณะของอีเมล:

อีเมลจะไม่ระบุว่าหน้าหรือ URL ที่ได้รับผลกระทบคืออะไร คุณจะต้องลงชื่อเข้าใช้ Google Search Console เพื่อค้นหาตัวเอง

หากคุณไม่ได้รับอีเมล วิธีที่ดีที่สุดคือยังคงเห็นอีเมลนั้นด้วยตาคุณเองเพื่อให้แน่ใจว่าไซต์ของคุณอยู่ในรูปแบบที่ดีที่สุด

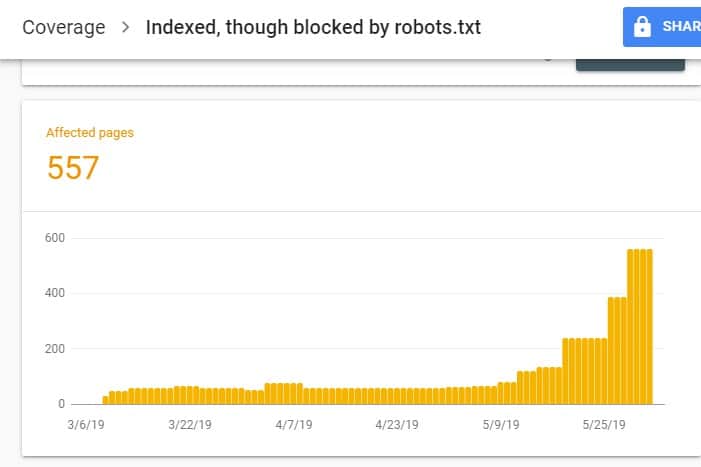

เมื่อเข้าสู่ระบบ GSC ให้ไปที่รายงานความครอบคลุมของดัชนีโดยคลิกที่ความครอบคลุมภายใต้ดัชนี จากนั้น ในหน้าถัดไป ให้เลื่อนลงเพื่อดูปัญหาที่ GSC รายงาน

“จัดทำดัชนี แม้ว่าจะถูกบล็อกโดย robots.txt” อยู่ภายใต้ “ถูกต้องพร้อมคำเตือน” ซึ่งหมายความว่าไม่มีอะไรผิดปกติกับ URL ต่อตัว แต่เครื่องมือค้นหาจะไม่แสดงหน้าในผลลัพธ์ของเครื่องมือค้นหา

เหตุใดไซต์ของคุณจึงมีปัญหานี้ (และวิธีแก้ไข)

ก่อนที่คุณจะเริ่มคิดหาวิธีแก้ไข คุณต้องทราบก่อนว่าหน้าใดที่จำเป็นต้องจัดทำดัชนี และ ต้องปรากฏในผลการค้นหา

เป็นไปได้ว่า URL ที่คุณเห็นใน GSC ที่มีปัญหา "จัดทำดัชนี แม้ว่าจะถูกบล็อกโดย robots.txt" ไม่ได้มีวัตถุประสงค์เพื่อดึงดูดการเข้าชมที่เกิดขึ้นเองมายังไซต์ของคุณ ตัวอย่างเช่น หน้า Landing Page สำหรับแคมเปญโฆษณาที่เสียค่าใช้จ่าย ดังนั้น การแก้ไขหน้าอาจไม่คุ้มค่ากับเวลาและความพยายามของคุณ

ด้านล่างนี้คือสาเหตุที่บางหน้าของคุณมีปัญหานี้ และคุณควรแก้ไขหรือไม่:

ไม่อนุญาตกฎใน Robots.txt และ Noindex Meta Tag ของคุณใน HTML . ของหน้า

สาเหตุที่พบบ่อยที่สุดที่ทำให้เกิดปัญหานี้คือเมื่อคุณหรือผู้ที่จัดการไซต์ของคุณเปิดใช้กฎ Disallow สำหรับ URL นั้นใน robots.txt ของไซต์ของคุณ และเพิ่มเมตาแท็ก noindex ใน URL เดียวกัน

อันดับแรก เจ้าของเว็บไซต์ใช้ robots.txt เพื่อแจ้งโปรแกรมรวบรวมข้อมูลของเครื่องมือค้นหาเกี่ยวกับวิธีจัดการ URL ของเว็บไซต์ของคุณ ในกรณีนี้ คุณได้เพิ่ม Disallow Rule บนหน้าและโฟลเดอร์ของไซต์ของคุณใน robots.txt ของเว็บไซต์ของคุณ

นี่คือสิ่งที่คุณอาจเห็นเมื่อเปิดไฟล์ robots.txt ของเว็บไซต์:

ตัวแทนผู้ใช้: * ไม่อนุญาต: /

ในตัวอย่างข้างต้น โค้ดบรรทัดนี้จะป้องกันไม่ให้โปรแกรมรวบรวมข้อมูลเว็บทั้งหมด (*) รวบรวมข้อมูลหน้าเว็บไซต์ของคุณ (Disallow) รวมถึงหน้าแรกของคุณ (/) ด้วยเหตุนี้ เครื่องมือค้นหาทั้งหมดจะไม่รวบรวมข้อมูลหรือจัดทำดัชนีหน้าเว็บไซต์ของคุณ

คุณสามารถแก้ไข robots.txt เพื่อแยกโปรแกรมรวบรวมข้อมูลเว็บ (Googlebot, msnbot, magpie-crawler เป็นต้น) และระบุหน้าหรือหน้าที่คุณไม่ต้องการให้โปรแกรมรวบรวมข้อมูลแตะ (/page1, /page2, /page3 เป็นต้น) ).

อย่างไรก็ตาม หากคุณไม่มีสิทธิ์เข้าถึงระดับรากในเซิร์ฟเวอร์ของคุณ คุณสามารถป้องกันบอทของเครื่องมือค้นหาไม่ให้สร้างดัชนีหน้าเว็บไซต์ของคุณโดยใช้แท็ก noindex

เมธอดนี้มีผลเช่นเดียวกับกฎ disallow ใน robots.txt อย่างไรก็ตาม แทนที่จะระบุหน้าและโฟลเดอร์ต่างๆ ในไซต์ของคุณในไฟล์ robots.txt ที่คุณต้องการป้องกันไม่ให้ปรากฏบน SERP คุณต้องป้อนเมตาแท็ก noindex ในแต่ละหน้าของไซต์ที่คุณไม่ต้องการ ให้ปรากฏในผลการค้นหา

นี่เป็นกระบวนการที่ใช้เวลานานกว่าวิธีการก่อนหน้านี้มาก แต่จะช่วยให้คุณควบคุมได้ละเอียดยิ่งขึ้นว่าจะบล็อก URL ใด นี่ก็หมายความว่ามีส่วนต่างที่ต่ำกว่าสำหรับข้อผิดพลาดในส่วนของคุณ

แก้ไข: อีกครั้ง ปัญหาใน GSC เกิดขึ้นเมื่อหน้าในไซต์ของคุณมีกฎไม่อนุญาตในไฟล์ robots.txt และแท็ก noindex

เพื่อให้เสิร์ชเอ็นจิ้นรู้ว่าควรสร้างดัชนีหน้าหรือไม่ มันควรจะสามารถรวบรวมข้อมูลจากไซต์ของคุณได้ แต่ถ้าคุณป้องกันไม่ให้เสิร์ชเอ็นจิ้นทำเช่นนั้นผ่าน robots.txt ของคุณจะไม่รู้ว่าต้องทำอย่างไรกับหน้านั้น

ด้วยการใช้ robots.txt และแท็ก noindex เพื่อเสริมและไม่แข่งขันกันเอง ไซต์ของคุณจะมีกฎที่ชัดเจนและตรงกว่ามากสำหรับบอทของเครื่องมือค้นหาที่จะต้องปฏิบัติตามเมื่อดำเนินการกับหน้าเว็บ

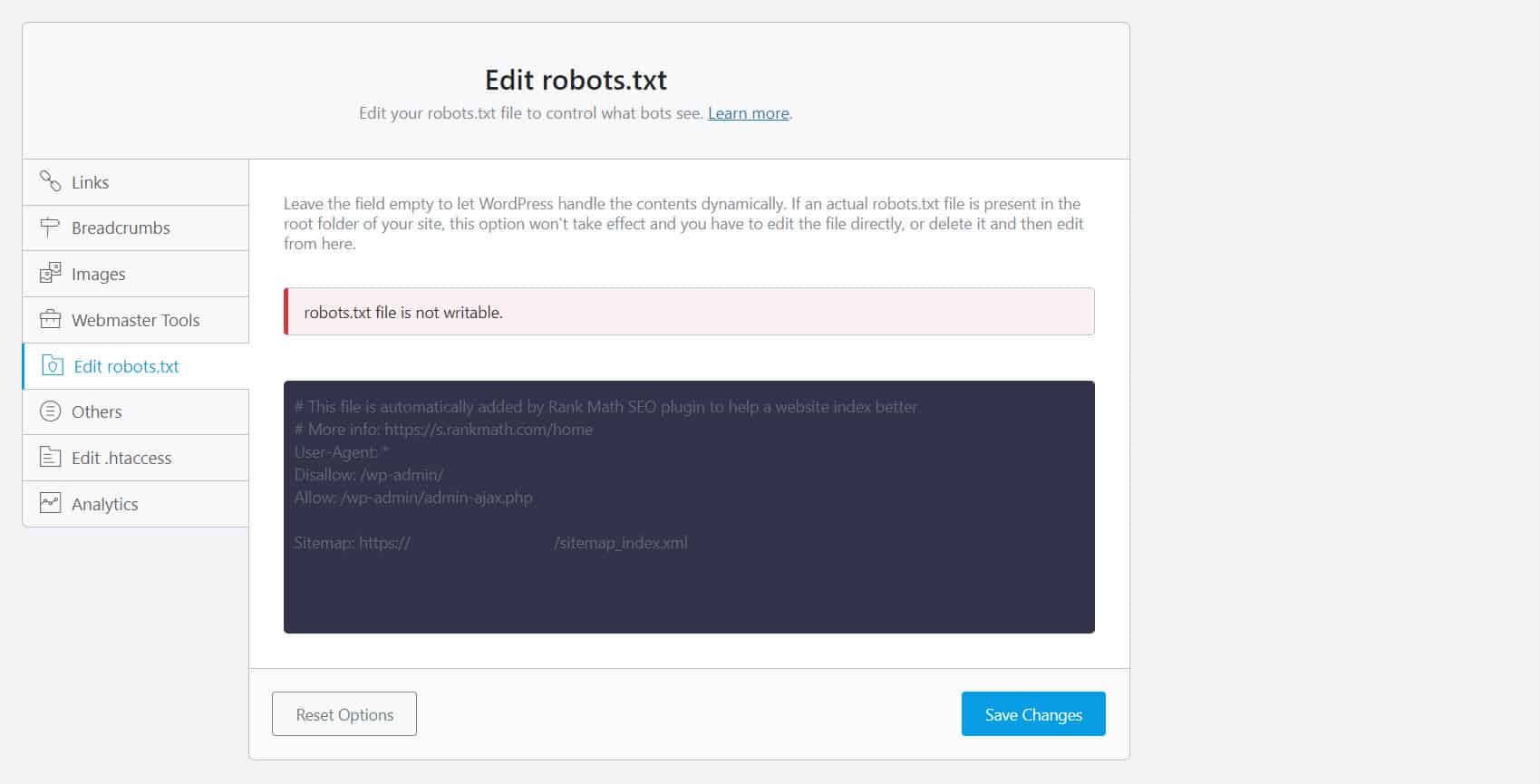

ในการดำเนินการนี้ คุณต้องแก้ไขไฟล์ robots.txt สำหรับเจ้าของไซต์ WordPress การใช้ปลั๊กอิน SEO กับโปรแกรมแก้ไข robots.txt เช่น Yoast SEO หรือ Rank Math จะสะดวกที่สุด

หากระบบของคุณไม่สามารถเขียน robots.txt ได้ คุณต้องติดต่อผู้ให้บริการโฮสติ้งเพื่อทำการเปลี่ยนแปลงสิทธิ์ในไฟล์และโฟลเดอร์ของคุณ

อีกวิธีหนึ่งคือการเข้าสู่ระบบไคลเอนต์ FTP ของคุณหรือตัวจัดการไฟล์ของผู้ให้บริการโฮสต์ของคุณ นี่เป็นวิธีการที่นิยมในหมู่นักพัฒนา เพราะพวกเขาสามารถควบคุมวิธีการแก้ไขไฟล์ได้อย่างสมบูรณ์เหนือสิ่งอื่นใด

รูปแบบ URL ไม่ถูกต้อง

URL ในไซต์ของคุณซึ่งไม่ใช่ "หน้า" ตามความหมายที่เข้มงวดที่สุดอาจได้รับข้อความ "จัดทำดัชนี แม้ว่าจะถูกบล็อกโดย robots.txt"

ตัวอย่างเช่น https://example.com?s=what+is+seo เป็นหน้าในไซต์ที่แสดงผลการค้นหาสำหรับข้อความค้นหา "seo คืออะไร" URL นี้แพร่หลายในไซต์ WordPress ที่เปิดใช้งานคุณลักษณะการค้นหาทั่วทั้งไซต์

การ แก้ไข: โดยปกติ ไม่จำเป็นต้องแก้ไขปัญหานี้ สมมติว่า URL นั้นไม่เป็นอันตรายและไม่ส่งผลกระทบอย่างลึกซึ้งต่อปริมาณการค้นหาของคุณ

หน้าที่คุณไม่ต้องการให้สร้างดัชนีมีลิงก์ภายใน

แม้ว่าคุณจะมีแท็ก noindex บนหน้าเว็บที่คุณไม่ต้องการให้มีการทำดัชนี Google อาจถือว่าแท็กเหล่านี้เป็นคำแนะนำแทนที่จะเป็นกฎ สิ่งนี้ชัดเจนเมื่อคุณเชื่อมโยงไปยังหน้าที่มีคำสั่ง noindex หรือกฎที่ไม่อนุญาตบนหน้าในเว็บไซต์ของคุณที่เครื่องมือค้นหารวบรวมข้อมูลและจัดทำดัชนี

ดังนั้น คุณอาจเห็นหน้าเหล่านี้ปรากฏบน SERP แม้ว่าคุณจะไม่ต้องการก็ตาม

แก้ไข : คุณต้องลบลิงก์ที่ชี้ไปยังหน้านี้และนำไปยังหน้าที่คล้ายกันแทน

ในการทำเช่นนี้ คุณต้องระบุลิงก์ภายในโดยเรียกใช้การตรวจสอบ SEO โดยใช้เครื่องมือเช่น Screaming Frog (ฟรีสำหรับเว็บไซต์ที่มี 500 URL) หรือ Ahrefs Webmaster Tools (ทางเลือกฟรีที่ดีกว่ามาก) เพื่อระบุว่าหน้าใดลิงก์ไปยังหน้าที่ถูกบล็อกของคุณ

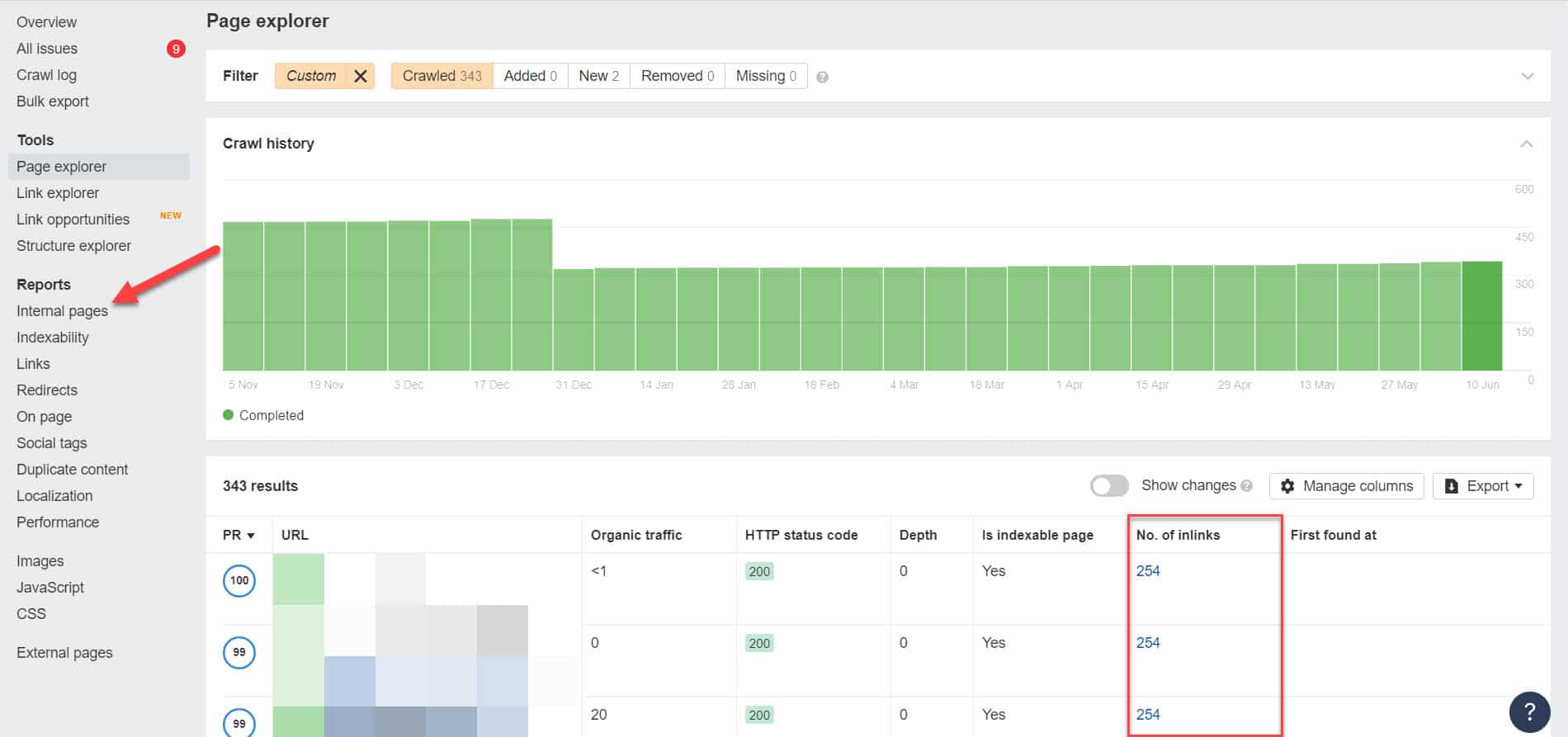

ใช้ Ahrefs ไปที่รายงาน > หน้าภายในหลังจากเรียกใช้การตรวจสอบ ค้นหาหน้าที่คุณบล็อกจากโปรแกรมรวบรวมข้อมูลเว็บและไม่มีการจัดทำดัชนี และดูว่าหน้าใดเชื่อมโยงไปยังหน้าเหล่านั้นในคอลัมน์ No. of Inlinks

จากที่นี่ ให้แก้ไขลิงก์จากหน้าเหล่านี้ทีละหน้า หรือคุณสามารถแทนที่ด้วยลิงก์ไปยังหน้าของคุณด้วยแท็ก noindex

ชี้ไปที่เชนเปลี่ยนเส้นทาง

หากลิงก์ในไซต์ของคุณชี้ไปยังกระแสการเปลี่ยนเส้นทางที่ไม่สิ้นสุด Googlebot จะหยุดส่งผ่านแต่ละลิงก์ก่อนที่จะพบ URL จริงของหน้า

ห่วงโซ่การเปลี่ยนเส้นทางเหล่านี้อาจทำให้เกิดปัญหาเนื้อหาที่ซ้ำกันซึ่งอาจทำให้เกิดปัญหา SEO ที่ใหญ่ขึ้นได้ วิธีเดียวที่จะแก้ไขปัญหานี้คือการระบุหน้าที่ต้องการและหน้า Canonical ด้วยแท็ก Canonical เพื่อให้ Google รู้ว่าหน้าใดควรรวบรวมข้อมูลและจัดทำดัชนีหน้าใด

นอกจากนี้ ให้พิจารณาว่าการลิงก์เพื่อเปลี่ยนเส้นทางแทนหน้า Canonical จะใช้งบประมาณการรวบรวมข้อมูลของคุณจนหมด หากลิงก์เปลี่ยนเส้นทางชี้ไปที่การเปลี่ยนเส้นทางหลายครั้ง คุณจะไม่ต้องใช้งบประมาณการรวบรวมข้อมูลในหน้าที่มีความสำคัญในไซต์ของคุณ เมื่อไปถึงหน้าที่สำคัญที่สุด Google จะไม่สามารถรวบรวมข้อมูลและจัดทำดัชนีได้อย่างถูกต้องหลังจากช่วงเวลาหนึ่ง

แก้ไข: กำจัดลิงก์เปลี่ยนเส้นทางจากไซต์ของคุณและลิงก์ไปยังหน้าตามรูปแบบบัญญัติแทน

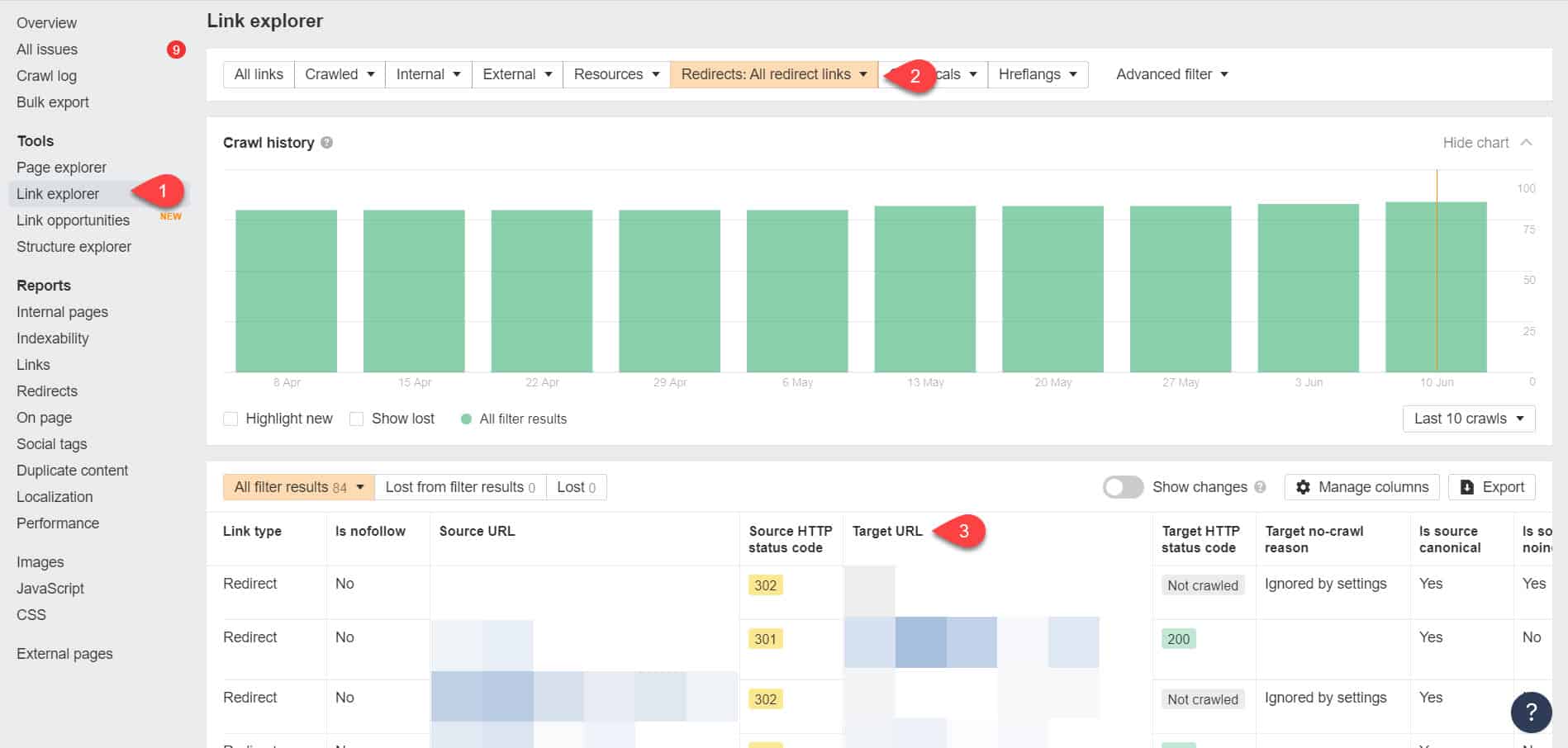

การใช้ Ahrefs Webmaster Tools อีกครั้ง คุณสามารถดูลิงก์เปลี่ยนเส้นทางของคุณได้ที่หน้า เครื่องมือ > Link Explorer จากนั้นกรองผลลัพธ์เพื่อแสดงเฉพาะลิงก์เปลี่ยนเส้นทางในไซต์ของคุณ

จากผลลัพธ์ ให้ระบุว่าลิงก์ใดสร้างห่วงโซ่การเปลี่ยนเส้นทางไม่รู้จบ จากนั้นให้ทำลายห่วงโซ่โดยค้นหาหน้าที่ถูกต้องซึ่งแต่ละหน้าที่เชื่อมโยงไปยังการเปลี่ยนเส้นทางควรเชื่อมโยงไป

จะทำอย่างไรหลังจากแก้ไขปัญหานี้

เมื่อคุณได้ใช้วิธีแก้ปัญหาข้างต้นกับหน้าสำคัญที่มีปัญหา "จัดทำดัชนี แม้ว่าจะถูกบล็อกโดย Robots.txt" แล้ว คุณต้องยืนยันการเปลี่ยนแปลงเพื่อให้ Google Search Console สามารถทำเครื่องหมายว่าแก้ไขแล้วได้

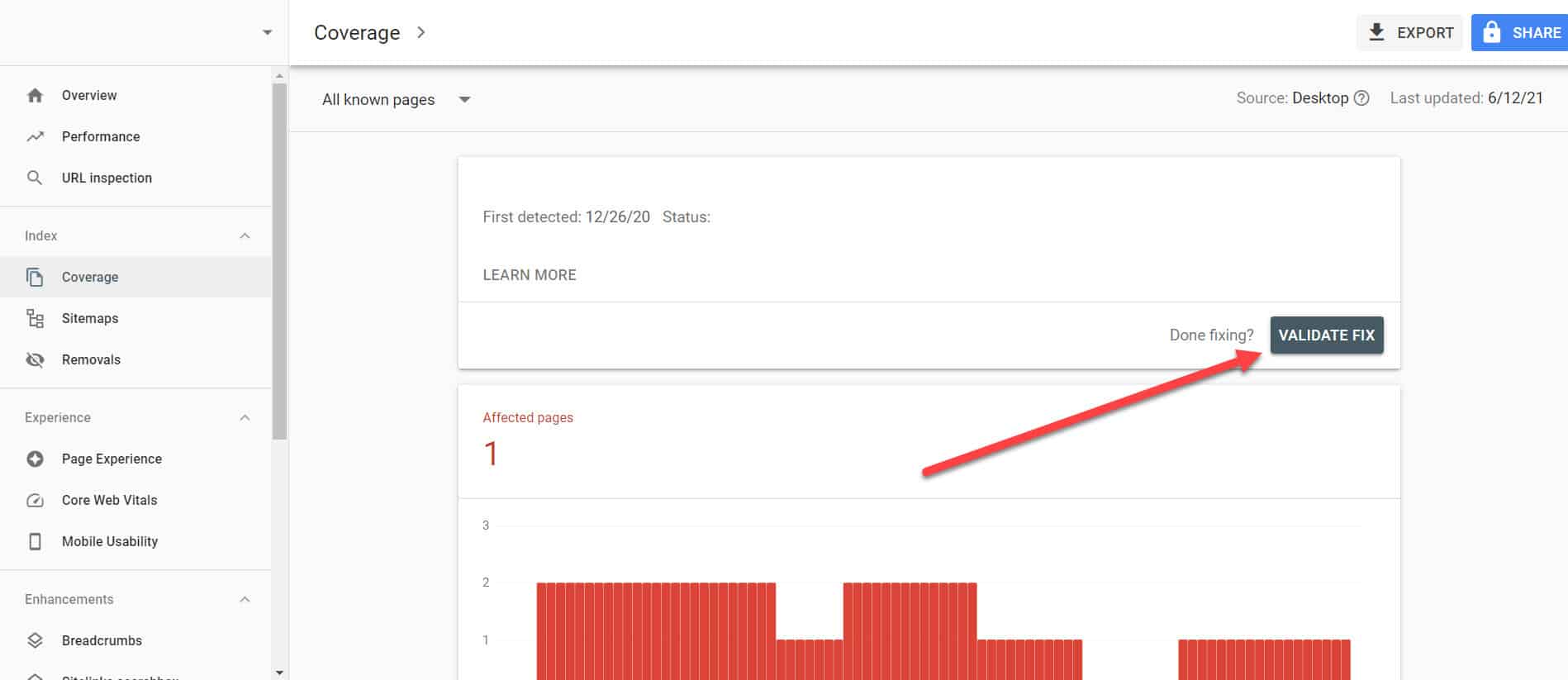

กลับไปที่รายงานการครอบคลุมดัชนีใน GSC คลิกที่ลิงก์ของปัญหานี้ที่คุณได้แก้ไข ในหน้าจอถัดไป ให้คลิกที่ปุ่ม ตรวจสอบการแก้ไข

การดำเนินการนี้จะขอให้ Google ตรวจสอบว่าหน้าไม่มีปัญหาอีกต่อไป

บทสรุป

ต่างจากปัญหาอื่นๆ ที่ Google Search Console เปิดเผย “จัดทำดัชนี แม้ว่าจะถูกบล็อกโดย robots.txt” อาจดูเหมือนลดลงในที่เก็บข้อมูล อย่างไรก็ตาม การลดลงเหล่านี้อาจสะสมเป็นปัญหามากมายในไซต์ของคุณ ซึ่งจะทำให้ไม่สามารถสร้างการเข้าชมแบบออร์แกนิกได้

เมื่อปฏิบัติตามหลักเกณฑ์ข้างต้นเกี่ยวกับวิธีแก้ปัญหาในหน้าที่สำคัญที่สุด คุณจะป้องกันเว็บไซต์ไม่ให้สูญเสียการเข้าชมที่มีคุณค่าได้ด้วยการเพิ่มประสิทธิภาพเว็บไซต์ของคุณเพื่อให้ Google รวบรวมข้อมูลและจัดทำดัชนีอย่างเหมาะสม