Penguin Update 4.0 – Nossa análise de impacto

Publicados: 2016-10-22O Google está afrouxando suas correntes: graças ao Penguin 4.0, vários sites, que anteriormente eram alvos do filtro de spam na web ou de sua estrutura de backlinks, agora viram um aumento considerável em sua visibilidade de SEO. Auditoria de backlinks, SEO negativo e revisões de links – essas são as áreas em que podemos esperar que o Penguin, agora integrado ao algoritmo central do Google, tenha impacto a longo prazo.

As atualizações do Penguin, a primeira delas lançada em 2012, sempre chamaram a atenção dos webmasters. No passado, sites que eram penalizados pela Penguin por spam de links às vezes demoravam muito para se recuperar. Houve alguns domínios que foram capazes de alterar sua estrutura de links e rapidamente voltar ao normal, mas houve tantos que foram obrigados a esperar até a última atualização do Penguin - o que significa que, em alguns casos, sua punição durou mais de 3 anos …

O que é o Pinguim 4.0?

A nova versão torna essas reações atrasadas uma coisa do passado. O Penguin 4.0 é agora, de acordo com o Google, parte do algoritmo central do mecanismo de busca. Isso significa que os dados do Penguin, que o Google Bot identifica para determinados links ao rastrear um site, agora são atualizados em tempo real. O Google descreve “sinais de spam” que o rastreador capta – além dos links, eles também podem estar relacionados ao preenchimento ou camuflagem de palavras-chave. Isso significa que o Google agora coleta sinais de outros paradigmas de atualização, como o Panda.

Maior flexibilidade e impacto em tempo real

Com o Penguin 4.0, o Google parece estar dando um último adeus à sua prática de anunciar grandes atualizações. Agora que todos os componentes mais importantes que o Google usa para avaliar sites foram incorporados ao seu algoritmo central, todos eles são calculados em tempo real. Com o Hummingbird e o RankBrain, o algoritmo já era capaz de refletir uma compreensão em tempo real da intenção do usuário nos resultados da pesquisa. O Panda seguiu o exemplo e agora o Penguin também se tornou parte do algoritmo central do Google, que é baseado em aprendizado de máquina orientado a dados. Este desenvolvimento está ocorrendo em linha com uma das áreas mais importantes de pesquisa do Google. Em sua busca pela perfeição na identificação dos resultados de pesquisa mais relevantes, o Google continua avançando no campo da Inteligência Artificial (IA).

Efeitos baseados em URL substituem penalidades em todo o domínio

Outro desenvolvimento significativo é que o Penguin 4.0 agora é baseado em URL, enquanto as iterações anteriores visavam domínios como entidades únicas. Esses sites que foram arrumados desde as iterações anteriores agora foram liberados das garras do Pinguim e receberam um impulso por esta última atualização. No entanto, alguns sites, mesmo aqueles que não melhoraram a estrutura de seus backlinks, também tiveram um aumento na visibilidade de seus domínios. Este é um resultado do Penguin 4.0 agora penalizando apenas a classificação de URLs individuais e não de todo o domínio. Portanto, agora há menos perdedores claros, pois esses sites não estão mais sujeitos a um filtro em todo o domínio.

Análise do impacto do Penguin 4.0

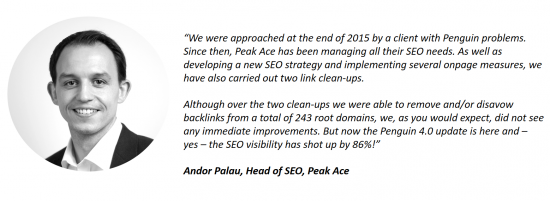

Os clientes da Searchmetrics já entraram em contato sobre o impacto da atualização mais recente. Um exemplo é Andor Palau, chefe de SEO da agência Peak Ace, com sede em Berlim, que faz uso do software Searchmetrics. Ele nos contou sobre um cliente que abordou a Peak Ace com problemas relacionados ao Penguin. Meses depois de limpar a estrutura de links do site, sem ver nenhuma melhoria, o lançamento do Penguin 4.0 fez com que a visibilidade de SEO do site aumentasse significativamente:

Em nossos dados de 16 de outubro de 2016, também podemos observar o impacto do lançamento do Penguin 4.0. Neste post, estamos nos abstendo de postar nossas listas tradicionais dos maiores vencedores e perdedores da semana. Isso ocorre porque, apesar do rastreamento extensivo de nossa parte, é impossível saber com certeza quais links foram rejeitados por um site. Esta informação está disponível exclusivamente para os SEOs ou webmasters e para o Google. Podemos dizer uma coisa: entre os principais vencedores, existem vários domínios que poderiam ter tido um aumento de visibilidade em conexão com a atualização do Penguin, mas isso continua sendo um palpite e não uma certeza clara.

Os antigos perdedores do Penguin se recuperaram

Em vez de uma lista de vencedores e perdedores, selecionamos alguns domínios de exemplo e mostramos como eles foram afetados pela atualização mais recente do Penguin. Uma conexão com o Penguin pode ser estabelecida analisando o impacto das atualizações anteriores do Penguin na visibilidade do domínio.

Queda significativa na visibilidade após o Penguin 3.0, aumento após a atualização 4.0

Queda significativa na visibilidade após o Penguin 3.0, aumento após a atualização 4.0

Queda na visibilidade após o Penguin 2.0, agora melhorada após o Penguin 4.0

Queda na visibilidade após o Penguin 2.0, agora melhorada após o Penguin 4.0

Várias quedas na visibilidade conectadas ao Penguin (2.0, 2.1), grande recuperação após a atualização 4.0

Várias quedas na visibilidade conectadas ao Penguin (2.0, 2.1), grande recuperação após a atualização 4.0

O aumento do rastreamento do Google Bot indicou a próxima atualização

Antes da ativação da atualização em tempo real, o Google parece ter realizado uma análise completa das estruturas de links e páginas existentes na web. O Google Bot foi visto como muito mais ativo em seu rastreamento no período imediatamente anterior ao anúncio oficial da atualização.

Nossa avaliação é que o Google queria definir uma espécie de status quo para estruturas de links e páginas na internet. Isso forneceu uma base válida para a próxima atualização, após a qual ele poderia soltar seu pinguim em tempo real.

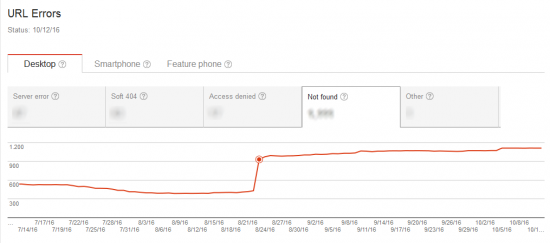

O Google Bot rastreia os sinais penalizados de atualizações anteriores do Penguin

O que parece inicialmente surpreendente é que o número de páginas rastreadas é grande e, ainda assim, o tempo de download é comparativamente baixo, o que é particularmente evidente no exemplo à direita na imagem acima. Isso pode ser explicado por um aumento no rastreamento de URLs “antigos”. Antes de lançar a atualização, o Google Bot rastreou os sinais penalizados ou os URLs específicos que levaram a penalidades do Penguin no passado.

A captura de tela mostra a conexão entre um aumento na atividade de rastreamento e um aumento no número de erros 404. Uma página inexistente obviamente pode ser rastreada em muito pouco tempo.

Pós-Penguin 4.0: a auditoria de backlink será mais difícil, mas não menos importante

O Penguin 4.0 significa que o Google Bot agora marcará links ruins para um URL específico com um sinal negativo assim que forem descobertos, pelo menos em teoria. No entanto, a avaliação negativa afetará apenas a URL individual e não todo o domínio, como foi o caso das atualizações anteriores do Penguin.

A partir de agora, isso tornará mais difícil identificar backlinks como a causa raiz de uma queda na visibilidade. Se for observada uma queda na classificação para uma determinada URL, é aconselhável otimizar a página em termos de conteúdo, intenção do usuário e estrutura. Se, apesar dessas medidas de otimização, nenhuma melhoria for detectada, a queda pode ser resultado do perfil de backlink puxar o URL específico para baixo – sem que isso seja aparente à primeira ou à segunda vista. As possíveis causas podem ser a criação de links de uma URL um pouco exagerada, um concorrente espalhando links ruins ou um jovem “SEO” escolhendo a URL afetada como alvo para seus testes. A partir de agora, será mais difícil determinar com precisão como o Google está avaliando os links de um site. O que está claro é que o “SEO negativo” agora deve se tornar menos prevalente, pois os domínios não podem mais ser “abatidos” pela criação de links ruins para o site de um “oponente”.

O Penguin 4.0 consigna a tática inicial de SEO de construir backlinks ou palavras-chave individuais para a pilha de sucata. As medidas de longo prazo continuam a crescer em importância. Além disso, uma auditoria regular dos backlinks de uma página deve agora se tornar um ponto fixo no plano anual de atividade de SEO de um domínio, para garantir a proteção adequada contra esses sinais negativos.

Da mesma forma, o foco agora deve estar no estabelecimento de uma estratégia de conteúdo e na produção de conteúdo relevante, de alta qualidade, exclusivo, que atenda perfeitamente à intenção do usuário. Essa é a única maneira de garantir que um site seja realmente consumido pelos usuários, vinculado, curtido e compartilhado – tudo isso convencerá o algoritmo do Google a recompensá-lo a longo prazo com posições altas no ranking.

Este post foi atualizado em 27 de outubro de 2016.