Penguin Update 4.0: nuestro análisis de impacto

Publicado: 2016-10-22Google está aflojando sus cadenas: gracias a Penguin 4.0, numerosos sitios web, que anteriormente habían sido objetivo del filtro de spam web o su estructura de backlinks, ahora han visto un aumento considerable en su visibilidad SEO. Auditoría de backlinks, SEO negativo y revisiones de enlaces: estas son las áreas en las que podemos esperar que Penguin, ahora integrado en el algoritmo central de Google, tenga un impacto a largo plazo.

Las actualizaciones de Penguin, la primera de las cuales se introdujo en 2012, siempre han llamado la atención de los webmasters. En el pasado, los sitios web que Penguin penalizaba por spam de enlaces a veces podían tardar mucho en recuperarse. Hubo algunos dominios que pudieron cambiar la estructura de sus enlaces y volver rápidamente a la normalidad, pero hubo muchos a los que se les hizo esperar hasta la última actualización de Penguin, lo que significa que, en algunos casos, su castigo duró más de 3 años. …

¿Qué es Pingüino 4.0?

La nueva versión hace que esas reacciones retrasadas sean cosa del pasado. Penguin 4.0 es ahora, según Google, parte del algoritmo central del motor de búsqueda. Esto significa que los datos de Penguin, que Google Bot identifica para ciertos enlaces al rastrear un sitio web, ahora se actualizan en tiempo real. Google describe las "señales de spam" que capta el rastreador; además de los enlaces, también pueden relacionarse con el relleno o el encubrimiento de palabras clave. Esto significa que Google ahora recopila señales de otros paradigmas de actualización, como Panda.

Mayor flexibilidad e impacto en tiempo real

Con Penguin 4.0, Google parece estar diciendo un último adiós a su práctica de anunciar actualizaciones importantes. Ahora que todos los componentes más importantes que usa Google para evaluar sitios web se han incorporado a su algoritmo central, todos se calculan en tiempo real. Con Hummingbird y RankBrain, el algoritmo ya podía reflejar una comprensión en tiempo real de la intención del usuario en los resultados de búsqueda. Panda hizo lo mismo y ahora Penguin también se ha convertido en parte del algoritmo central de Google, que se basa en el aprendizaje automático basado en datos. Este desarrollo está teniendo lugar en línea con una de las áreas más importantes de investigación de Google. En su búsqueda de la perfección en la identificación de los resultados de búsqueda más relevantes, Google continúa avanzando en el campo de la Inteligencia Artificial (IA).

Los efectos basados en URL reemplazan las penalizaciones en todo el dominio

Otro desarrollo significativo es que Penguin 4.0 ahora está basado en URL, mientras que las iteraciones anteriores apuntaban a los dominios como entidades únicas. Esos sitios web que se han arreglado desde iteraciones anteriores ahora se han liberado de las garras de Penguin y han recibido un impulso con esta última actualización. Sin embargo, algunos sitios web, incluso aquellos que no han mejorado la estructura de sus backlinks, también han visto un aumento en la visibilidad de su dominio. Este es el resultado de que Penguin 4.0 ahora solo penaliza la clasificación de URL individuales y no de todo el dominio. Por lo tanto, ahora hay menos perdedores claros, ya que estos sitios web ya no están sujetos a un filtro de todo el dominio.

Análisis del impacto de Penguin 4.0

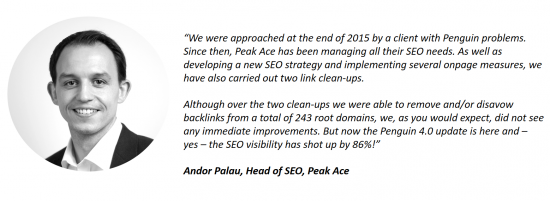

Los clientes de Searchmetrics ya se han puesto en contacto con respecto al impacto de la última actualización. Un ejemplo es Andor Palau, director de SEO de la agencia con sede en Berlín Peak Ace, que utiliza el software de Searchmetrics. Nos ha hablado de un cliente que se acercó a Peak Ace con problemas relacionados con Penguin. Meses después de limpiar la estructura de enlaces del sitio web, sin ver ninguna mejora, la implementación de Penguin 4.0 ahora ha provocado que la visibilidad SEO del sitio aumente significativamente:

En nuestros datos del 16 de octubre de 2016, también podemos observar el impacto del lanzamiento de Penguin 4.0. En esta publicación, nos abstenemos de publicar nuestras listas tradicionales de los mayores ganadores y perdedores de la semana. Esto se debe a que, a pesar de un extenso rastreo de nuestra parte, es imposible saber con certeza qué enlaces han sido desautorizados por un sitio web. Esta información está disponible exclusivamente para los SEOs o webmasters y para Google. Podemos decir una cosa: entre los principales ganadores, hay numerosos dominios que podrían haber tenido un aumento de visibilidad en relación con la actualización de Penguin, pero esto sigue siendo una suposición fundamentada en lugar de una certeza clara.

Los perdedores pasados de Penguin se han recuperado

En lugar de una lista de ganadores y perdedores, hemos seleccionado algunos dominios de ejemplo y mostramos cómo se han visto afectados por la actualización más reciente de Penguin. Se puede establecer una conexión con Penguin analizando el impacto de las actualizaciones anteriores de Penguin en la visibilidad del dominio.

Caída significativa en la visibilidad después de Penguin 3.0, aumento después de la actualización 4.0

Caída significativa en la visibilidad después de Penguin 3.0, aumento después de la actualización 4.0

Caída de visibilidad después de Penguin 2.0, ahora mejorado después de Penguin 4.0

Caída de visibilidad después de Penguin 2.0, ahora mejorado después de Penguin 4.0

Varias caídas en la visibilidad relacionadas con Penguin (2.0, 2.1), gran recuperación después de la actualización 4.0

Varias caídas en la visibilidad relacionadas con Penguin (2.0, 2.1), gran recuperación después de la actualización 4.0

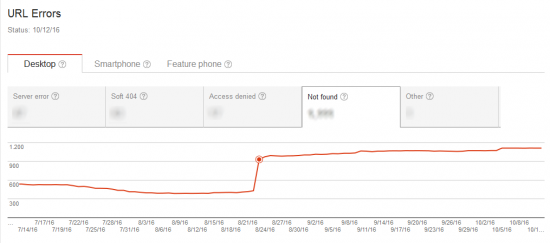

El aumento del rastreo de Google Bot indicó una próxima actualización

Antes de que se activara la actualización en tiempo real, Google parece haber realizado un análisis exhaustivo de las estructuras de enlaces y páginas existentes en la web. Se vio que Google Bot era mucho más activo en su rastreo en el período de tiempo justo antes del anuncio oficial de la actualización.

Nuestra evaluación es que Google quería definir una especie de statu quo para las estructuras de enlaces y páginas en Internet. Esto proporcionó una base válida para la próxima actualización, después de la cual podría liberar a su pingüino en tiempo real.

Google Bot rastrea las señales penalizadas de actualizaciones anteriores de Penguin

Lo que inicialmente parece sorprendente es que la cantidad de páginas rastreadas es grande y, sin embargo, el tiempo de descarga es comparativamente bajo, lo que es particularmente evidente en el ejemplo de la derecha en la imagen de arriba. Esto podría explicarse por un aumento en el rastreo de URL "antiguas". Antes de lanzar la actualización, Google Bot rastreó las señales penalizadas o las URL específicas que habían dado lugar a penalizaciones de Penguin en el pasado.

La captura de pantalla muestra la conexión entre un aumento en la actividad de rastreo y un aumento en la cantidad de errores 404. Obviamente, una página inexistente se puede rastrear en muy poco tiempo.

Post-Penguin 4.0: la auditoría de backlinks será más difícil, pero no menos importante

Penguin 4.0 significa que Google Bot ahora marcará los enlaces malos a una URL específica con una señal negativa tan pronto como se descubran, al menos en teoría. Sin embargo, la evaluación negativa solo afectará a la URL individual y no a todo el dominio, como ocurría con las actualizaciones anteriores de Penguin.

De ahora en adelante, esto hará que sea más difícil identificar los backlinks como la causa principal de una disminución de la visibilidad. Si se observa una caída en la clasificación de una URL en particular, es recomendable optimizar la página en términos de contenido, intención del usuario y estructura. Si, a pesar de estas medidas de optimización, no se detectan mejoras, entonces la caída podría deberse a que el perfil de vínculo de retroceso tira hacia abajo de la URL específica, sin que esto sea evidente a primera o segunda vista. Las posibles causas podrían ser haber creado los enlaces de una URL con demasiado entusiasmo, un competidor difundiendo enlaces malos o un "SEO" joven que eligió la URL afectada como objetivo para sus pruebas. A partir de ahora, será más difícil determinar con precisión cómo evalúa Google los enlaces de un sitio web. Lo que está claro es que el "SEO negativo" ahora debería volverse menos frecuente, ya que los dominios ya no pueden ser "derribados" mediante la creación de enlaces incorrectos al sitio web de un "oponente".

Penguin 4.0 consigna la táctica inicial de SEO de construir vínculos de retroceso o palabras clave individuales al montón de chatarra. Las medidas a largo plazo continúan creciendo en importancia. Además, una auditoría periódica de los backlinks de una página ahora debería convertirse en un punto fijo en el plan anual de actividad de SEO de un dominio, para garantizar una protección adecuada contra estas señales negativas.

Del mismo modo, el enfoque ahora debe estar en establecer una estrategia de contenido y en la producción de contenido único, relevante y de alta calidad, que sirva perfectamente a la intención del usuario. Esta es la única forma de garantizar que los usuarios consuman un sitio web, lo vinculen, le gusten y lo compartan, todo lo cual convencerá al algoritmo de Google para que lo recompense a largo plazo con posiciones altas en el ranking.

Esta publicación se actualizó el 27 de octubre de 2016.