Penguin Update 4.0 – Unsere Wirkungsanalyse

Veröffentlicht: 2016-10-22Google lockert seine Ketten: Dank Penguin 4.0 konnten zahlreiche Webseiten, die zuvor vom Filter auf Webspam oder deren Backlinkstruktur angegriffen wurden, nun eine deutliche Steigerung ihrer SEO-Sichtbarkeit erfahren. Backlink-Audit, Negativ-SEO und Link-Reviews – das sind die Bereiche, in denen wir erwarten können, dass Penguin, das jetzt in den Kernalgorithmus von Google integriert ist, langfristige Auswirkungen haben wird.

Penguin-Updates, von denen das erste 2012 eingeführt wurde, haben immer die Aufmerksamkeit von Webmastern auf sich gezogen. In der Vergangenheit konnten Websites, die von Penguin wegen Link-Spam bestraft wurden, manchmal lange brauchen, um sich zu erholen. Es gab einige Domains, die ihre Linkstruktur ändern konnten und schnell wieder normal wurden, aber genauso viele mussten bis zum neuesten Penguin-Update warten – was bedeutet, dass ihre Bestrafung in einigen Fällen mehr als 3 Jahre dauerte …

Was ist Pinguin 4.0?

Mit der neuen Version gehören solche verzögerten Reaktionen der Vergangenheit an. Penguin 4.0 ist laut Google nun Teil des Kernalgorithmus der Suchmaschine. Das bedeutet, dass Penguin-Daten, die der Google Bot beim Crawlen einer Website für bestimmte Links identifiziert, nun in Echtzeit aktualisiert werden. Google beschreibt „Spam-Signale“, die der Crawler aufgreift – neben Links können dies auch Keyword-Stuffing oder Cloaking sein. Das bedeutet, dass Google jetzt Signale von anderen Update-Paradigmen wie Panda sammelt.

Erhöhte Flexibilität und Auswirkungen in Echtzeit

Mit Penguin 4.0 scheint sich Google endgültig von seiner Praxis zu verabschieden, große Updates anzukündigen. Nachdem alle wichtigen Komponenten, die Google zur Bewertung von Websites verwendet, in seinen Kernalgorithmus integriert wurden, werden sie alle in Echtzeit berechnet. Bei Hummingbird und RankBrain war der Algorithmus bereits in der Lage, ein Echtzeit-Verständnis der Nutzerabsicht in den Suchergebnissen abzubilden. Panda zog nach und jetzt ist Penguin auch Teil von Googles Kernalgorithmus geworden, der auf datengetriebenem maschinellem Lernen basiert. Diese Entwicklung erfolgt im Einklang mit einem der wichtigsten Bereiche der Google-Forschung. In seinem Streben nach Perfektion bei der Identifizierung der relevantesten Suchergebnisse macht Google weiterhin Fortschritte im Bereich der künstlichen Intelligenz (KI).

URL-basierte Effekte ersetzen domänenweite Strafen

Eine weitere wichtige Entwicklung ist, dass Penguin 4.0 jetzt URL-basiert ist, während frühere Iterationen auf Domänen als einzelne Entitäten abzielten. Diese Websites, die seit früheren Iterationen aufgeräumt wurden, wurden nun aus dem Griff des Pinguins befreit und durch dieses neueste Update aufgewertet. Einige Websites, auch diejenigen, die die Struktur ihrer Backlinks nicht verbessert haben, konnten jedoch auch eine Steigerung der Sichtbarkeit ihrer Domain feststellen. Dies liegt daran, dass Penguin 4.0 nur noch das Ranking einzelner URLs und nicht der gesamten Domain bestraft. Daher gibt es jetzt weniger eindeutige Verlierer, da diese Websites nicht mehr einem domänenweiten Filter unterliegen.

Analyse der Auswirkungen von Penguin 4.0

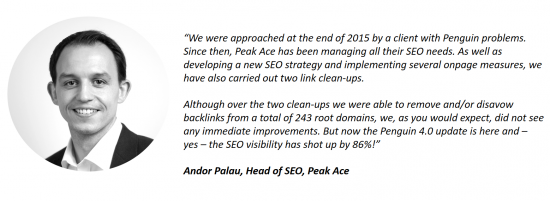

Die Kunden von Searchmetrics haben sich bereits bezüglich der Auswirkungen des neuesten Updates gemeldet. Ein Beispiel ist Andor Palau, Head of SEO bei der Berliner Agentur Peak Ace, die auf die Software von Searchmetrics zurückgreift. Er hat uns von einem Kunden erzählt, der sich mit Problemen im Zusammenhang mit Pinguin an Peak Ace gewandt hat. Monate nachdem die Linkstruktur der Website bereinigt wurde, ohne dass Verbesserungen zu sehen waren, hat die Einführung von Penguin 4.0 nun dazu geführt, dass die SEO-Sichtbarkeit der Website erheblich gestiegen ist:

In unseren Daten vom 16. Oktober 2016 können wir auch die Auswirkungen des Rollouts von Penguin 4.0 beobachten. In diesem Beitrag verzichten wir darauf, unsere traditionellen Listen der größten Gewinner und Verlierer der Woche zu veröffentlichen. Denn trotz umfangreichem Crawling unsererseits lässt sich nicht mit Sicherheit feststellen, welche Links von einer Website disavowed wurden. Diese Informationen stehen ausschließlich den SEOs bzw. Webmastern und Google zur Verfügung. Eines können wir sagen: Unter den Top-Gewinnern gibt es zahlreiche Domains, die im Zusammenhang mit dem Penguin-Update einen Sichtbarkeitsschub hätten bekommen können, aber das bleibt eher eine fundierte Vermutung als eine eindeutige Gewissheit.

Frühere Pinguin-Verlierer haben sich erholt

Anstelle einer Liste von Gewinnern und Verlierern haben wir daher einige Beispieldomains ausgewählt und gezeigt, wie sie vom letzten Penguin-Update betroffen sind. Eine Verbindung zu Penguin kann hergestellt werden, indem die Auswirkungen früherer Penguin-Updates auf die Sichtbarkeit der Domain analysiert werden.

Signifikanter Rückgang der Sichtbarkeit nach Penguin 3.0, Anstieg nach Update 4.0

Signifikanter Rückgang der Sichtbarkeit nach Penguin 3.0, Anstieg nach Update 4.0

Verringerte Sichtbarkeit nach Penguin 2.0, jetzt verbessert nach Penguin 4.0

Verringerte Sichtbarkeit nach Penguin 2.0, jetzt verbessert nach Penguin 4.0

Verschiedene Sichtbarkeitsverluste im Zusammenhang mit Penguin (2.0, 2.1), große Erholung nach Update 4.0

Verschiedene Sichtbarkeitsverluste im Zusammenhang mit Penguin (2.0, 2.1), große Erholung nach Update 4.0

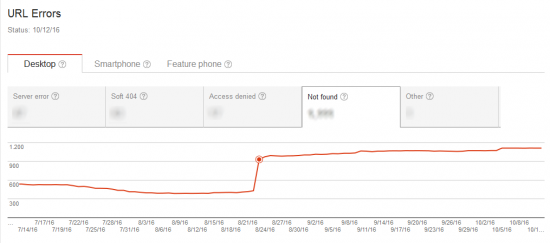

Das verstärkte Crawling des Google Bot deutete auf ein bevorstehendes Update hin

Bevor die Echtzeit-Aktualisierung aktiviert wurde, scheint Google eine gründliche Analyse der bestehenden Link- und Seitenstrukturen im gesamten Web durchgeführt zu haben. Der Google Bot war im Zeitraum kurz vor der offiziellen Ankündigung des Updates weitaus aktiver beim Crawlen.

Unsere Einschätzung ist, dass Google eine Art Status quo für Link- und Seitenstrukturen im Internet definieren wollte. Dies lieferte eine valide Grundlage für das kommende Update, nach dem es seinen Pinguin in Echtzeit loslassen konnte.

Der Google Bot crawlt die bestraften Signale früherer Penguin-Updates

Was zunächst überrascht, ist, dass die Anzahl der gecrawlten Seiten groß und die Downloadzeit dennoch vergleichsweise gering ist, was besonders am Beispiel rechts im Bild oben deutlich wird. Dies könnte durch ein vermehrtes Crawlen „alter“ URLs erklärt werden. Vor dem Start des Updates hat der Google Bot die abgestraften Signale oder die spezifischen URLs gecrawlt, die in der Vergangenheit zu Penguin-Strafen geführt hatten.

Der Screenshot zeigt den Zusammenhang zwischen einer Zunahme der Crawling-Aktivität und einer Zunahme der Anzahl von 404-Fehlern. Eine nicht vorhandene Seite kann offensichtlich in kürzester Zeit gecrawlt werden.

Post-Penguin 4.0: Backlink Auditing wird schwieriger, aber nicht weniger wichtig

Penguin 4.0 bedeutet, dass der Google Bot schlechte Links zu einer bestimmten URL nun mit einem negativen Signal markiert, sobald sie entdeckt werden, zumindest theoretisch. Allerdings betrifft die negative Bewertung nur die einzelne URL und nicht die gesamte Domain, wie es bei früheren Penguin-Updates der Fall war.

Dadurch wird es von nun an schwieriger, Backlinks als Ursache für einen Rückgang der Sichtbarkeit zu identifizieren. Wird für eine bestimmte URL ein Ranking-Rückgang beobachtet, empfiehlt es sich, die Seite hinsichtlich Inhalt, Nutzerintention und Struktur zu optimieren. Sollten trotz dieser Optimierungsmaßnahmen keine Verbesserungen festgestellt werden, könnte der Rückgang darauf zurückzuführen sein, dass das Backlink-Profil die jeweilige URL nach unten zieht – ohne dass dies auf den ersten oder zweiten Blick erkennbar wäre. Mögliche Ursachen können ein zu starker Linkaufbau einer URL sein, ein Konkurrent, der schlechte Links verbreitet, oder ein junger „SEO“, der sich zufällig die betroffene URL als Ziel für seine Tests heraussucht. Von nun an wird es daher schwieriger, genau zu bestimmen, wie Google die Links einer Website bewertet. Klar ist, dass „negatives SEO“ jetzt weniger verbreitet sein sollte, da Domains nicht mehr „abgeschossen“ werden können, indem schlechte Links auf die Website eines „Gegners“ erstellt werden.

Penguin 4.0 wirft die frühe SEO-Taktik, Backlinks oder einzelne Keywords aufzubauen, auf den alten Haufen. Langfristige Maßnahmen gewinnen weiter an Bedeutung. Zudem sollte ein regelmäßiges Audit der Backlinks einer Seite mittlerweile ein fester Punkt im jährlichen SEO-Aktivitätenplan einer Domain werden, um einen angemessenen Schutz vor diesen negativen Signalen zu gewährleisten.

Ebenso sollte der Fokus nun auf der Etablierung einer Content-Strategie und der Produktion relevanter, qualitativ hochwertiger und einzigartiger Inhalte liegen, die die User-Intention perfekt bedienen. Nur so wird sichergestellt, dass eine Website tatsächlich von Nutzern konsumiert, verlinkt, geliked und geteilt wird – all das überzeugt den Algorithmus von Google, Sie langfristig mit hohen Ranking-Positionen zu belohnen.

Dieser Beitrag wurde am 27. Oktober 2016 aktualisiert.