Actualizarea Penguin 4.0 – Analiza noastră de impact

Publicat: 2016-10-22Google își slăbește lanțurile: Datorită Penguin 4.0, numeroase site-uri web, care anterior fuseseră vizate de filtrul de spam web sau de structura lor de backlink, au înregistrat acum o creștere considerabilă a vizibilității lor SEO. Auditul backlink, SEO negativ și recenzii link-uri – acestea sunt domeniile în care ne putem aștepta ca Penguin, acum integrat în algoritmul de bază al Google, să aibă un impact pe termen lung.

Actualizările Penguin, dintre care prima a fost introdusă în 2012, au atras întotdeauna atenția webmasterilor. În trecut, site-urile web care au fost penalizate de Penguin pentru spam de linkuri puteau să dureze uneori mult timp pentru a se recupera. Au fost unele domenii care au putut să-și schimbe structura legăturilor și să revină rapid la normal, dar au fost la fel de mulți care au fost nevoiți să aștepte până la ultima actualizare Penguin – ceea ce înseamnă, în unele cazuri, că pedeapsa lor a durat mai mult de 3 ani. …

Ce este Penguin 4.0?

Noua versiune face ca astfel de reacții întârziate să treacă din trecut. Penguin 4.0 este acum, conform Google, parte a algoritmului de bază al motorului de căutare. Aceasta înseamnă că datele Penguin, pe care Google Bot le identifică pentru anumite link-uri atunci când accesează cu crawlere un site web, sunt acum actualizate în timp real. Google descrie „semnalele de spam” pe care crawler-ul le preia – pe lângă link-uri, acestea se pot referi și la umplerea sau demascarea cuvintelor cheie. Aceasta înseamnă că acum Google adună semnale de la alte paradigme de actualizare, cum ar fi Panda.

Flexibilitate sporită și impact în timp real

Cu Penguin 4.0, Google pare să își ia un ultim rămas bun de la practica sa de a anunța actualizări majore. Acum că toate cele mai importante componente pe care Google le folosește pentru a evalua site-urile web au fost încorporate în algoritmul său de bază, toate sunt calculate în timp real. Cu Hummingbird și RankBrain, algoritmul a fost deja capabil să reflecte o înțelegere în timp real a intenției utilizatorului în rezultatele căutării. Panda a urmat exemplul, iar acum Penguin a devenit, de asemenea, parte a algoritmului de bază al Google, care se bazează pe învățarea automată bazată pe date. Această dezvoltare are loc în conformitate cu unul dintre cele mai importante domenii ale cercetării Google. În căutarea perfecțiunii în identificarea celor mai relevante rezultate de căutare, Google continuă să facă progrese în domeniul inteligenței artificiale (AI).

Efectele bazate pe URL înlocuiesc penalitățile la nivelul întregului domeniu

O altă dezvoltare semnificativă este că Penguin 4.0 este acum bazat pe URL, în timp ce iterațiile anterioare vizau domenii ca entități unice. Acele site-uri web care s-au aranjat de la iterațiile anterioare au fost acum eliberate din strânsoarea Pinguinului și au primit un impuls de această ultimă actualizare. Cu toate acestea, unele site-uri web, chiar și cele care nu și-au îmbunătățit structura backlink-urilor, au înregistrat și o creștere a vizibilității domeniului lor. Acesta este un rezultat al Penguin 4.0 care penalizează acum doar clasarea adreselor URL individuale și nu a întregului domeniu. Prin urmare, acum există mai puțini perdanți clari, deoarece aceste site-uri web nu mai sunt supuse unui filtru la nivelul întregului domeniu.

Analiza impactului Penguin 4.0

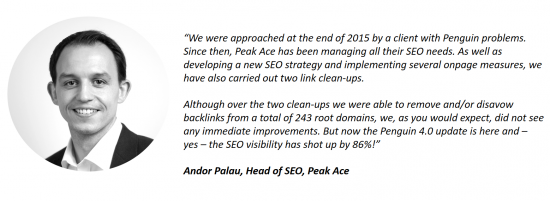

Clienții Searchmetrics au luat deja legătura cu privire la impactul celei mai recente actualizări. Un exemplu este Andor Palau, șeful SEO la agenția din Berlin, Peak Ace, care folosește software-ul Searchmetrics. Ne-a povestit despre un client care a abordat Peak Ace cu probleme legate de Pinguin. La câteva luni după curățarea structurii link-urilor site-ului, fără a observa îmbunătățiri, lansarea Penguin 4.0 a făcut acum să crească semnificativ vizibilitatea SEO a site-ului:

În datele noastre din 16 octombrie 2016, putem observa și impactul lansării Penguin 4.0. În această postare, ne abținem să postăm listele noastre tradiționale cu cei mai mari câștigători și învinși ai săptămânii. Acest lucru se datorează faptului că, în ciuda accesării cu crawlere extinse din partea noastră, este imposibil să știm cu siguranță care link-uri au fost respinse de un site web. Aceste informații sunt disponibile exclusiv pentru SEO sau webmasteri și pentru Google. Putem spune un lucru: printre primii câștigători, există numeroase domenii care ar fi putut avea un spor de vizibilitate în legătură cu actualizarea Penguin, dar aceasta rămâne mai degrabă o presupunere educată decât o certitudine clară.

Învinșii Pinguini din trecut și-au revenit

În loc de o listă de câștigători și învinși, am selectat, prin urmare, câteva exemple de domenii și am arătat cum au fost afectate de cea mai recentă actualizare Penguin. O conexiune cu Penguin poate fi stabilită analizând impactul actualizărilor anterioare Penguin asupra vizibilității domeniului.

Scădere semnificativă a vizibilității după Penguin 3.0, creștere după actualizarea 4.0

Scădere semnificativă a vizibilității după Penguin 3.0, creștere după actualizarea 4.0

Scăderea vizibilității după Penguin 2.0, acum îmbunătățită după Penguin 4.0

Scăderea vizibilității după Penguin 2.0, acum îmbunătățită după Penguin 4.0

Diferite scăderi ale vizibilității conectate la Penguin (2.0, 2.1), recuperare mare după actualizarea 4.0

Diferite scăderi ale vizibilității conectate la Penguin (2.0, 2.1), recuperare mare după actualizarea 4.0

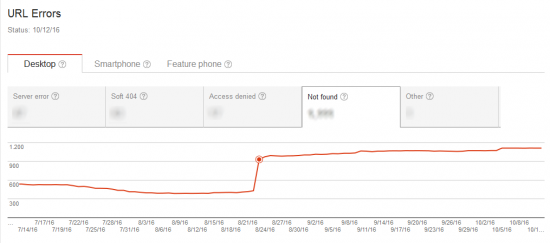

Creșterea accesului cu crawlere a Google Bot a indicat o actualizare viitoare

Înainte ca actualizarea în timp real să fie activată, Google pare să fi efectuat o analiză amănunțită a structurilor de linkuri și pagini existente pe web. Google Bot a fost văzut a fi mult mai activ în accesarea cu crawlere în perioada de timp înainte de anunțul oficial al actualizării.

Evaluarea noastră este că Google a dorit să definească un fel de status quo pentru structurile de link-uri și pagini de pe internet. Acest lucru a oferit o bază validă pentru viitoarea actualizare, după care și-a putut lăsa pinguinul să se desprindă în timp real.

Google Bot accesează cu crawlere semnalele penalizate din actualizările anterioare Penguin

Ceea ce pare inițial surprinzător este faptul că numărul de pagini accesate cu crawlere este mare și, totuși, timpul de descărcare este relativ scăzut, ceea ce este evident în special în exemplul din dreapta din imaginea de mai sus. Acest lucru ar putea fi explicat printr-o creștere a accesării cu crawlere a adreselor URL „vechi”. Înainte de lansarea actualizării, Google Bot a accesat cu crawlere semnalele penalizate sau adresele URL specifice care au dus la penalizări Penguin în trecut.

Captura de ecran arată legătura dintre o creștere a activității de crawling și o creștere a numărului de erori 404. O pagină inexistentă poate fi accesată cu crawlere în foarte puțin timp.

Post-Penguin 4.0: auditarea backlink-urilor va fi mai dificilă, dar nu mai puțin importantă

Penguin 4.0 înseamnă că Google Bot va marca acum link-urile proaste către o anumită adresă URL cu un semnal negativ de îndată ce sunt descoperite, cel puțin în teorie. Cu toate acestea, evaluarea negativă va afecta numai adresa URL individuală și nu întregul domeniu, așa cum a fost cazul actualizărilor anterioare Penguin.

De acum înainte, acest lucru va face mai dificilă identificarea backlink-urilor ca cauza principală a unei scăderi a vizibilității. Dacă se observă o scădere a clasamentului pentru o anumită adresă URL, este recomandabil să optimizați pagina în ceea ce privește conținutul, intenția utilizatorului și structura. Dacă, în ciuda acestor măsuri de optimizare, nu sunt detectate îmbunătățiri, atunci scăderea ar putea fi rezultatul faptului că profilul de backlink trage în jos adresa URL specifică – fără ca acest lucru să fie evident la prima sau a doua vedere. Cauzele posibile ar putea fi crearea de legături către un URL puțin prea intens, un concurent care răspândește link-uri proaste sau un „SEO” tânăr să aleagă URL-ul afectat ca țintă pentru testele lor. De acum înainte, va deveni, prin urmare, mai dificil să se determine cu exactitate modul în care Google evaluează linkurile unui site web. Ceea ce este clar este că „SEO negativ” ar trebui acum să devină mai puțin răspândit, deoarece domeniile nu mai pot fi „doborâte” prin crearea de link-uri proaste către site-ul unui „adversar”.

Penguin 4.0 trimite tactica SEO timpurie de a construi backlink-uri sau cuvinte cheie individuale la grămada de resturi. Măsurile pe termen lung continuă să crească în importanță. În plus, un audit regulat al backlink-urilor unei pagini ar trebui să devină acum un punct fix în planul anual de activitate SEO al unui domeniu, pentru a asigura o protecție adecvată împotriva acestor semnale negative.

În mod similar, accentul ar trebui să fie acum pe stabilirea unei strategii de conținut și pe producerea de conținut relevant, de înaltă calitate, unic, care să servească perfect intenției utilizatorului. Acesta este singurul mod de a vă asigura că un site web este efectiv consumat de utilizatori, legat la, apreciat și distribuit – toate acestea vor convinge algoritmul Google să vă răsplătească pe termen lung cu poziții înalte.

Această postare a fost actualizată la 27 octombrie 2016.