Penguin Update 4.0 – Notre analyse d'impact

Publié: 2016-10-22Google desserre ses chaînes : Grâce à Penguin 4.0, de nombreux sites web, qui étaient auparavant ciblés par le filtre anti-spam web ou leur structure de backlinks, ont désormais vu leur visibilité SEO augmenter considérablement. Audit des backlinks, référencement négatif et revues de liens - ce sont les domaines dans lesquels nous pouvons nous attendre à ce que Penguin, désormais intégré à l'algorithme de base de Google, ait un impact à long terme.

Les mises à jour de Penguin, dont la première a été introduite en 2012, ont toujours attiré l'attention des webmasters. Dans le passé, les sites Web pénalisés par Penguin pour le spam de liens pouvaient parfois prendre beaucoup de temps à se rétablir. Certains domaines ont pu changer leur structure de liens et revenir rapidement à la normale, mais il y en avait tout autant qui ont dû attendre la dernière mise à jour de Penguin - ce qui signifie, dans certains cas, que leur punition a duré plus de 3 ans …

Qu'est-ce que Pingouin 4.0 ?

La nouvelle version fait de ces réactions tardives une chose du passé. Penguin 4.0 fait désormais, selon Google, partie de l'algorithme de base du moteur de recherche. Cela signifie que les données Penguin, que le Google Bot identifie pour certains liens lors de l'exploration d'un site Web, sont désormais mises à jour en temps réel. Google décrit des "signaux de spam" que le robot d'exploration capte - outre les liens, ceux-ci peuvent également être liés au bourrage de mots clés ou au cloaking. Cela signifie que Google rassemble désormais les signaux d'autres paradigmes de mise à jour, tels que Panda.

Flexibilité accrue et impact en temps réel

Avec Penguin 4.0, Google semble dire un dernier adieu à sa pratique consistant à annoncer des mises à jour majeures. Maintenant que tous les composants les plus importants que Google utilise pour évaluer les sites Web ont été intégrés à son algorithme de base, ils sont tous calculés en temps réel. Avec Hummingbird et RankBrain, l'algorithme était déjà capable de refléter une compréhension en temps réel de l'intention de l'utilisateur dans les résultats de recherche. Panda a emboîté le pas et maintenant Penguin fait également partie de l'algorithme de base de Google, qui est basé sur l'apprentissage automatique basé sur les données. Ce développement s'inscrit dans l'un des domaines de recherche les plus importants de Google. Dans sa quête de perfection pour identifier les résultats de recherche les plus pertinents, Google continue de faire des progrès dans le domaine de l'intelligence artificielle (IA).

Les effets basés sur les URL remplacent les pénalités à l'échelle du domaine

Un autre développement important est que Penguin 4.0 est désormais basé sur les URL, tandis que les itérations précédentes ciblaient les domaines en tant qu'entités uniques. Les sites Web qui ont été rangés depuis les précédentes itérations ont maintenant été libérés de l'emprise du Penguin et ont reçu un coup de pouce grâce à cette dernière mise à jour. Cependant, certains sites, même ceux qui n'ont pas amélioré la structure de leurs backlinks, ont également vu une augmentation de la visibilité de leur domaine. C'est le résultat du fait que Penguin 4.0 ne pénalise désormais que le classement des URL individuelles et non de l'ensemble du domaine. Par conséquent, il y a maintenant moins de perdants évidents, car ces sites Web ne sont plus soumis à un filtre à l'échelle du domaine.

Analyse de l'impact de Penguin 4.0

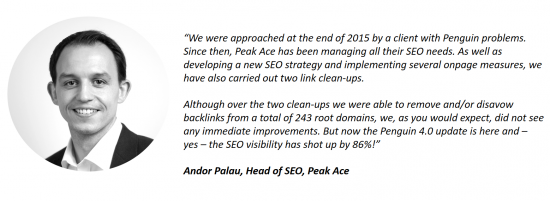

Les clients de Searchmetrics ont déjà été en contact concernant l'impact de la dernière mise à jour. Un exemple est Andor Palau, responsable du référencement de l'agence berlinoise Peak Ace, qui utilise le logiciel de Searchmetrics. Il nous a parlé d'un client qui a approché Peak Ace avec des problèmes liés à Penguin. Des mois après avoir nettoyé la structure des liens du site Web, sans voir aucune amélioration, le déploiement de Penguin 4.0 a maintenant fait bondir considérablement la visibilité SEO du site :

Dans nos données du 16 octobre 2016, nous pouvons également observer l'impact du déploiement de Penguin 4.0. Dans cet article, nous nous abstenons de publier nos listes traditionnelles des plus grands gagnants et perdants de la semaine. En effet, malgré un crawling intensif de notre part, il est impossible de savoir avec certitude quels liens ont été désavoués par un site Web. Ces informations sont exclusivement disponibles pour les référenceurs ou webmasters et pour Google. On peut dire une chose : parmi les grands gagnants, il y a de nombreux domaines qui auraient pu bénéficier d'un gain de visibilité lié à la mise à jour Penguin, mais cela reste une supposition éclairée plutôt qu'une certitude absolue.

Les anciens perdants de Penguin se sont rétablis

Au lieu d'une liste de gagnants et de perdants, nous avons donc sélectionné quelques exemples de domaines et montré comment ils ont été affectés par la dernière mise à jour de Penguin. Une connexion à Penguin peut être établie en analysant l'impact des mises à jour précédentes de Penguin sur la visibilité du domaine.

Baisse significative de la visibilité après Penguin 3.0, augmentation après la mise à jour 4.0

Baisse significative de la visibilité après Penguin 3.0, augmentation après la mise à jour 4.0

Baisse de la visibilité après Penguin 2.0, désormais améliorée après Penguin 4.0

Baisse de la visibilité après Penguin 2.0, désormais améliorée après Penguin 4.0

Diverses baisses de visibilité liées à Penguin (2.0, 2.1), grosse reprise suite à la mise à jour 4.0

Diverses baisses de visibilité liées à Penguin (2.0, 2.1), grosse reprise suite à la mise à jour 4.0

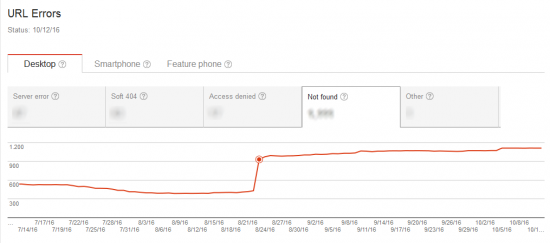

L'augmentation de l'exploration de Google Bot a indiqué une prochaine mise à jour

Avant l'activation de la mise à jour en temps réel, Google semble avoir effectué une analyse approfondie des structures de liens et de pages existantes sur le Web. Le Google Bot a été considéré comme beaucoup plus actif dans son exploration dans la période juste avant l'annonce officielle de la mise à jour.

Notre évaluation est que Google voulait définir une sorte de statu quo pour les structures de liens et de pages sur Internet. Cela a fourni une base valable pour la prochaine mise à jour, après quoi il pourrait lâcher son pingouin en temps réel.

Google Bot explore les signaux pénalisés des mises à jour précédentes de Penguin

Ce qui semble surprenant au départ, c'est que le nombre de pages explorées est important, et pourtant le temps de téléchargement est relativement faible, ce qui est particulièrement évident dans l'exemple à droite dans l'image ci-dessus. Cela pourrait s'expliquer par une augmentation du crawling des "anciennes" URL. Avant de lancer la mise à jour, le Google Bot a exploré les signaux pénalisés ou les URL spécifiques qui avaient conduit à des sanctions Penguin dans le passé.

La capture d'écran montre le lien entre une augmentation de l'activité d'exploration et une augmentation du nombre d'erreurs 404. Une page inexistante peut évidemment être crawlée en très peu de temps.

Post-Penguin 4.0 : l'audit des backlinks sera plus difficile, mais pas moins important

Penguin 4.0 signifie que Google Bot marquera désormais les mauvais liens vers une URL spécifique avec un signal négatif dès qu'ils seront découverts, du moins en théorie. Cependant, l'évaluation négative n'affectera que l'URL individuelle et non l'ensemble du domaine, comme c'était le cas avec les mises à jour précédentes de Penguin.

Désormais, cela rendra plus difficile l'identification des backlinks comme cause profonde d'une baisse de visibilité. Si une baisse de classement est constatée pour une URL particulière, il convient d'optimiser la page en termes de contenu, d'intention de l'utilisateur et de structure. Si, malgré ces mesures d'optimisation, aucune amélioration n'est détectée, la baisse pourrait être le résultat du profil de backlink tirant l'URL spécifique vers le bas - sans que cela soit apparent au premier ou au deuxième coup d'œil. Les causes possibles peuvent être d'avoir construit les liens d'une URL un peu trop intensément, un concurrent diffusant de mauvais liens ou un jeune "SEO" qui choisit l'URL affectée comme cible pour ses tests. Désormais, il deviendra donc plus difficile de déterminer précisément comment Google évalue les liens d'un site web. Ce qui est clair, c'est que le « SEO négatif » devrait désormais devenir moins répandu, car les domaines ne peuvent plus être « abattus » en créant de mauvais liens vers le site Web d'un « adversaire ».

Penguin 4.0 confie la première tactique de référencement consistant à créer des backlinks ou des mots-clés individuels à la ferraille. Les mesures à long terme continuent de gagner en importance. De plus, un audit régulier des backlinks d'une page devrait désormais devenir un point fixe du plan d'activité SEO annuel d'un domaine, pour assurer une protection adéquate contre ces signaux négatifs.

De même, l'accent doit désormais être mis sur l'établissement d'une stratégie de contenu et sur la production de contenus pertinents, de qualité, uniques, qui servent parfaitement l'intention de l'utilisateur. C'est le seul moyen de s'assurer qu'un site Web est réellement consommé par les utilisateurs, lié, aimé et partagé - tout cela convaincra l'algorithme de Google de vous récompenser à long terme avec des positions de haut niveau.

Cet article a été mis à jour le 27 octobre 2016.