Web Scraping คืออะไรและเหตุใดธุรกิจจึงต้องการมัน

เผยแพร่แล้ว: 2021-01-07การใช้งานทั่วไปของการขูดเว็บนั้นจำกัดด้วยจินตนาการของเราเองเท่านั้น มันรวบรวมข้อมูลและดึงข้อมูลจำนวนมากจากเว็บไซต์ทั้งหมดอย่างแท้จริงเพื่อการใช้งานมากมาย เช่น การตรวจสอบราคา การสไปเดอร์ข้อมูลทางการเงิน การวิเคราะห์การรวมข่าว เป็นต้น การขูดและการรวบรวมข้อมูลช่วยให้ธุรกิจสามารถสร้างผลิตภัณฑ์ใหม่และสร้างสรรค์ได้เร็วและดีขึ้น

เช่นเดียวกับเว็บไซต์ราคาเทียบเคียงเช่น Kayak ผลิตภัณฑ์ SEO เช่น Botify หรือเครื่องมือรวบรวมงานที่สร้างขึ้นจากหลายแหล่ง เว็บไซต์เหล่านี้สร้างขึ้นจากเว็บไซต์ขูดเท่านั้น ด้วยการรับประกันความง่ายในการเข้าถึงข้อมูล เว็บแครปเปอร์ช่วยเพิ่มคุณค่าให้กับคุณ ก่อนที่เราจะไขความลึกลับว่าทำไมการขูดเว็บจึงเป็นตัวเปลี่ยนเกมและอุตสาหกรรมใดต้องการมันมากที่สุด ให้เราแนะนำคุณว่าจริงๆ แล้วการขูดเว็บไซต์คืออะไร

Web Scraping คืออะไร?

การขูดเว็บ (และการรวบรวมข้อมูลเว็บ) เป็นการระบุและดึงข้อมูลจากเว็บไซต์โดยอัตโนมัติ ความโดดเด่นและความจำเป็นในการรวบรวมได้ทวีคูณเกินกว่าจะวัดได้ ยิ่งไปกว่านั้น ความต้องการข้อมูลที่มีคุณภาพสำหรับอุตสาหกรรมการวิเคราะห์ยังไม่เพียงพอ เครื่องขูดเว็บเป็นสไปเดอร์และให้ข้อมูลทุกอย่างที่มีอยู่ ไม่ว่าคุณจะอยู่ในอุตสาหกรรมใด การดึงข้อมูลจะเป็นวิธีแก้ปัญหาของคุณอย่างน้อยหนึ่งปัญหา

การใช้งานบริการขูดเว็บไซต์

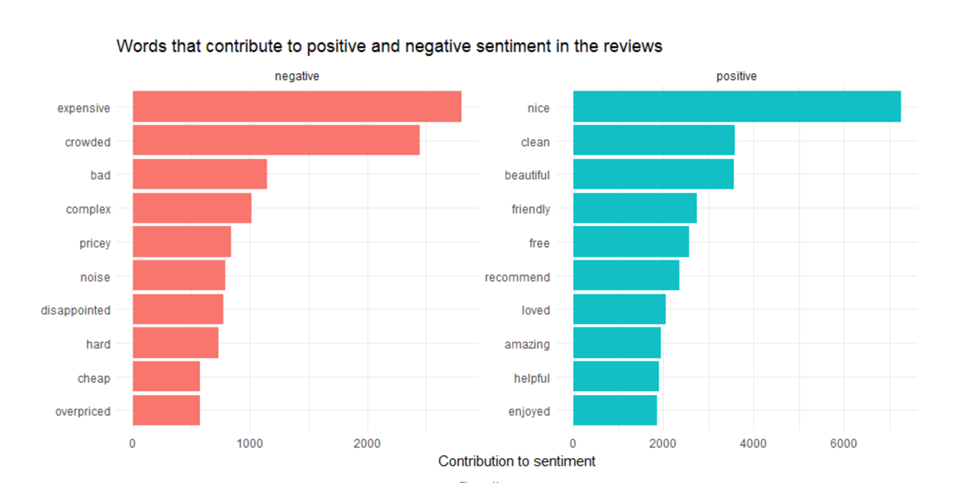

ก) การวิเคราะห์ความเชื่อมั่น

ทุกโพสต์บนโซเชียลมีเดียที่เผยแพร่ในช่วงเวลาที่กำหนดจะเผยให้เห็นภาพที่ใหญ่ขึ้นอย่างสม่ำเสมอ และช่วยให้นักวิเคราะห์เข้าใจความรู้สึกและพฤติกรรมของผู้บริโภค API ที่สร้างขึ้นในแพลตฟอร์มโซเชียลมีเดียทั้งหมดอาจไม่เพียงพอ จำเป็นต้องมีการรวบรวมข้อมูลจากโซเชียลมีเดียเพื่อทำความเข้าใจว่าการสนทนาดำเนินไปในทิศทางใด และแนวโน้มย่อยใดที่รวบรวมสายตาส่วนใหญ่ กล่าวโดย การวิเคราะห์การใช้แฮชแท็ก

ข). การกำหนดราคาอีคอมเมิร์ซและการตรวจสอบราคา

สงครามราคาได้มาถึงสัมผัสใหม่ด้วยการขูดข้อมูลอีคอมเมิร์ซ ในตลาดที่มีผู้ค้าน้อยรายและอ่อนไหวต่อราคา สิ่งสำคัญคือต้องจับตาดู ว่าผลิตภัณฑ์มีการกำหนดราคาอย่างไรทั่วทั้งกระดาน ในฐานะผู้ขาย คุณสามารถดูได้ว่าแพลตฟอร์มใดเสนอส่วนต่างที่ดีที่สุดสำหรับผลิตภัณฑ์ของคุณ

ค). ผู้รวบรวมงาน

ผู้รวบรวมงาน ใช้บริการขูดเพื่อรวบรวมข้อมูลหน้าเว็บอาชีพทั้งหมดและรวมไว้ในที่เดียว โดยทั่วไปแล้วพวกเขาทำงานเป็นเสิร์ชเอ็นจิ้นสำหรับโฆษณางานด้วยฟังก์ชันการค้นหาขั้นสูง การขูดเกิดขึ้นเป็นประจำเพื่อให้แน่ใจว่ามีเพียงช่องเปิดตามเวลาจริงและที่เกี่ยวข้องเท่านั้นที่จะแสดงต่อกลุ่มผู้มีความสามารถ

ง) การเรียนรู้ของเครื่อง

ปัญญาประดิษฐ์และ แมชชีนเลิ ร์นนิงต้องการฟีดข้อมูลที่มีคุณภาพอย่างต่อเนื่อง เพื่อให้สามารถเลียนแบบและทำซ้ำมนุษย์ได้ พวกเขาจำเป็นต้องได้รับข้อมูลล่าสุดอย่างต่อเนื่องเพื่อให้สามารถปรับตัวได้ บริการรวบรวมข้อมูลเว็บขูดจุดข้อมูล ข้อความ และรูปภาพจำนวนมากเพื่อช่วยในเรื่องนี้ ML กำลังขับเคลื่อนความมหัศจรรย์ทางเทคโนโลยี เช่น รถยนต์ไร้คนขับ แว่นตาอัจฉริยะ รูปภาพ และการจดจำคำพูด อย่างไรก็ตาม เพื่อให้สามารถขยายขนาดได้แบบทวีคูณ โมเดลเหล่านี้จำเป็นต้องมีการอัปเดตข้อมูลเป็นประจำเพื่อปรับปรุงความแม่นยำและความน่าเชื่อถือ

จ) การตรวจสอบแบรนด์

ผู้เล่นอีคอมเมิร์ซส่วนใหญ่ (ดูที่ Amazon คุณ) ทำงานเฉพาะกับบทวิจารณ์และการให้คะแนน ผู้บริโภคไว้วางใจผู้บริโภครายอื่นอย่างลึกซึ้งยิ่งขึ้น คุณเป็นแบรนด์ที่จ่ายเงินเพื่อผลักดันภาพลักษณ์และการประชาสัมพันธ์ดิจิทัลของคุณอย่างไร?

คุณสามารถ ขูดบทวิจารณ์และการให้คะแนนผลิตภัณฑ์ จากแต่ละเว็บไซต์ที่แสดงรายการผลิตภัณฑ์ของคุณแล้วรวมเข้าด้วยกัน คุณสามารถเพิ่มระดับได้ด้วยการตรวจสอบแพลตฟอร์มโซเชียลมีเดียและรวมเข้ากับการวิเคราะห์ความรู้สึกเพื่อตอบสนองต่อผู้ที่ปฏิเสธอย่างรวดเร็วหรือให้รางวัลและสร้างแรงจูงใจให้ผู้ใช้ที่รักคุณ อุตสาหกรรมที่ต้องการสิ่งนี้ไม่มีที่สิ้นสุด: การท่องเที่ยว, การต้อนรับ, อีคอมเมิร์ซ, ผู้รวบรวมออนไลน์ทั้งหมด, นักพัฒนาแอพ

ฉ). SEO

หากไม่อยู่ในหน้าแรกของ Google แสดงว่าไม่มีอยู่ ดังนั้น SEO และถ้าคุณกำลังทำงานเพื่อ SEO คุณอาจใช้เครื่องมือเช่น SEMrush หรือ Ubersuggest ข้อเท็จจริงที่น่าสนุก: เครื่องมือเหล่านี้จะไม่มีอยู่จริงหากไม่ได้มีไว้สำหรับการรวบรวมข้อมูลเว็บและการขูด

เครื่องมือที่คุณสามารถใช้เพื่อค้นหาคู่แข่ง SEO ของคุณสำหรับข้อความค้นหาหนึ่งๆ คุณสามารถคิดแท็กชื่อและคำหลักที่พวกเขากำหนดเป้าหมายเพื่อค้นหาสิ่งที่เปลี่ยนเส้นทางการเข้าชมไปยังเว็บไซต์ของตนและกระตุ้นยอดขาย

เราจะตั้งค่าโครงการ Web Mining ได้อย่างไร?

ก) ระบุเป้าหมาย

นี้เป็นเกมง่ายๆ คิดออกว่าคุณต้องการอะไร คุณทำอย่างนั้นได้อย่างไร? ตอบคำถามชุดต่อไปนี้

ก) คุณต้องการข้อมูลประเภทใด

ข) คุณคาดหวังอะไรจากผลลัพธ์?

ค). ข้อมูลที่คุณค้นหามักจะเผยแพร่อยู่ที่ไหน

ง) ข้อมูลนี้มีไว้เพื่อใคร?

จ) ข้อมูลนี้ควรนำเสนอต่อผู้ใช้ปลายทางในรูปแบบใด

ฉ) อายุการเก็บรักษาโดยทั่วไปของข้อมูล? คุณต้องทำกิจกรรมนี้บ่อยแค่ไหน?

ข). การวิเคราะห์บริการรวบรวมข้อมูลเว็บ

เนื่องจากการขูดข้อมูลเป็นไปโดยอัตโนมัติอย่างมาก ประเภทของบริการขูดเว็บที่คุณใช้จึงเป็นสิ่งสำคัญยิ่ง นี่คือสิ่งที่คุณควรจำไว้ก่อนที่จะเลือกบริการขูด:

ก) ขนาดโครงการ

ข) OS ที่รองรับ

ค). รองรับข้อกำหนดขององค์กรของคุณหรือไม่?

ง) รองรับภาษาสคริปต์

จ) รองรับการจัดเก็บข้อมูลในตัว

ค). การออกแบบสคีมาการขูด

บางทีงานขูดของเราคือรวบรวมข้อมูลจากไซต์งานเกี่ยวกับตำแหน่งงานว่างที่โพสต์โดยนายหน้า แหล่งที่มาของข้อมูลจะเป็นตัวกำหนดแอตทริบิวต์ของสคีมา มันจะมีลักษณะเช่นนี้:

ก) ชื่อ

ข) หมายเลขประจำตัวประชาชน

ค). คำอธิบาย

ง) URL ที่ใช้ในการสมัครตำแหน่งโดยผู้สมัคร

จ) ที่ตั้ง

ฉ) ค่าตอบแทน

กรัม) ประเภทงาน

ชม). ประสบการณ์ที่จำเป็น

ง) การตรวจสอบความเป็นไปได้และการดำเนินการนำร่อง

การดำเนินการนำร่องเป็นความคิดที่ดีเสมอก่อนที่จะดำเนินโครงการขูดรีดอย่างเต็มรูปแบบ คุณทำอย่างนั้นได้อย่างไร?

ก) ตรวจสอบความเป็นไปได้ในการขูดของเว็บไซต์ต้นทาง

ข) ขูด HTML

ค). รับของที่ต้องการ

ง) ระบุ URL ที่นำไปสู่หน้าถัดไป

หากคุณพอใจกับผลลัพธ์ของคุณ คุณสามารถก้าวไปข้างหน้าด้วยการขูดที่ใหญ่ขึ้น คุณอาจต้องจับ Xpaths ที่แก้ไขแล้วแทนที่ด้วยค่าที่ฮาร์ดโค้ด อาจจำเป็นต้องใช้ไลบรารีภายนอกเพื่อทำหน้าที่เป็นอินพุตสำหรับแหล่งที่มา

ตอนนี้เราได้แนะนำคุณเกี่ยวกับการรวบรวมข้อมูลและการขูดเว็บแล้ว โดยส่วนใหญ่ คุณอาจคิดว่ามันเป็นงานที่ใหญ่โตซึ่งต้องการการดูแลด้านเทคนิค ใช่และไม่ใช่ ในขณะที่คุณสามารถเลือกทำสิ่งนี้ได้ภายในองค์กรโดยการเพิ่มทักษะให้กับพนักงานของคุณ หรือโดยการใช้เครื่องมือ DIY ที่มีอยู่มากมาย แต่เว็บไซต์มีความซับซ้อนมากขึ้นทุกวัน ความจำเป็นในการเอาต์ซอร์ซเว็บขูดไปยัง ผู้ให้บริการระดับพรีเมียม น่าจะเป็นวิธีที่ดีที่สุดในการขูดข้อมูลตามขนาด