Ce este Web Scraping și de ce au nevoie companiile de el?

Publicat: 2021-01-07Utilizările tipice ale web scraping sunt limitate doar de propria noastră imaginație. Acesta accesează cu crawlere și extrage cantități mari de date de pe literalmente toate site-urile web pentru o multitudine de utilizări, cum ar fi monitorizarea prețurilor, analizarea datelor financiare, analiza agregarii de știri, pentru a numi câteva. Scrapingul și crawling-ul dă putere întreprinderilor să creeze produse noi și să inoveze mai rapid și mai bine.

De exemplu, într-un site web de juxtapunere a prețurilor precum Kayak, un produs SEO precum Botify sau un agregator de locuri de muncă care este construit din mai multe surse, aceste site-uri web sunt construite exclusiv pe site-uri web de scraping. Garantând ușurința de acces la date, web scraper-urile vă sporesc propunerea de valoare. Înainte de a dezvălui misterul de ce web scraping schimbă atât de mult jocul și care industrii au cel mai mult nevoie de el, permiteți-ne să vă ghidăm prin ce este cu adevărat scrapingul site-ului.

Ce este Web Scraping?

Web scraping (și web crawling) este identificarea și preluarea automată a datelor de pe site-uri web. Proeminența și nevoia de agregare s-au înmulțit peste măsură. Mai mult decât atât, lipsa de date de calitate pentru industria analitică este insuficientă. Web scrapers sunt în esență păianjeni și oferă toate informațiile disponibile acolo. Indiferent de industria în care vă aflați, data scraping va fi soluția la cel puțin una dintre problemele dvs.

Aplicații ale Serviciilor de răzuire a site-urilor web

A). Analiza sentimentelor

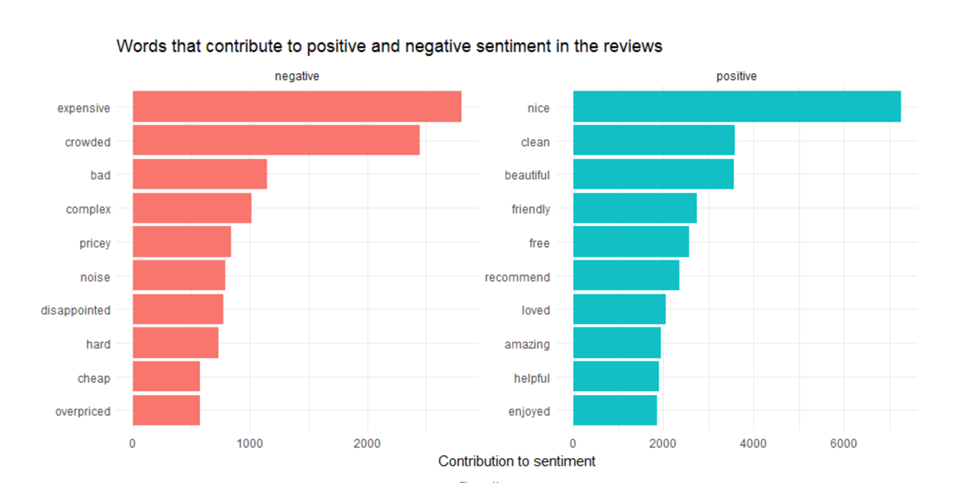

Fiecare postare pe rețelele de socializare publicată într-o perioadă de timp prevăzută dezvăluie invariabil o imagine mai largă și îi ajută pe analiști să înțeleagă sentimentul și comportamentul consumatorilor. API-urile încorporate în toate platformele de social media pot fi inadecvate. Este necesară accesarea cu crawlere a rețelelor sociale pentru a înțelege încotro se îndreaptă conversația și ce micro tendințe adună cele mai multe ochi, să zicem prin analizarea utilizării hashtag-urilor .

B). Prețurile comerțului electronic și monitorizarea prețurilor

Războaiele prețurilor au atins o nouă tangentă cu eliminarea datelor de comerț electronic. Într-o piață oligopolistică și sensibilă la preț, este foarte important să urmăriți cum este prețul produsului în general . În calitate de vânzător, puteți vedea și ce platformă oferă cea mai bună marjă pentru produsele dvs.

C). Agregatori de locuri de muncă

Agregatorii de locuri de muncă folosesc servicii de scraping pentru a accesa cu crawlere toate paginile web de carieră și pentru a le consolida pe toate într-un singur loc. Ele funcționează practic ca motoare de căutare pentru anunțurile de locuri de muncă datorită funcționalității lor avansate de căutare. Scrapingul are loc în mod regulat pentru a vă asigura că doar deschiderile relevante și în timp real sunt afișate grupului de talente.

D). Învățare automată

Inteligența artificială și învățarea automată au nevoie de fluxuri continue de date de calitate, astfel încât să poată emula și reproduce un om. Ei trebuie să fie hrăniți în mod constant cu cele mai recente informații, astfel încât să se poată adapta în continuare. Serviciile de accesare cu crawlere pe web răzuiesc un număr mare de puncte de date, text și imagini pentru a ajuta acest lucru. ML propulsează minuni tehnologice, cum ar fi mașinile fără șofer, ochelarii inteligenți, imaginea și recunoașterea vorbirii. Cu toate acestea, pentru a-l putea extinde exponențial, aceste modele au nevoie de actualizare regulată a datelor pentru a-și îmbunătăți acuratețea și fiabilitatea.

E). Monitorizarea mărcii

Majoritatea jucătorilor de comerț electronic (aici te uită la Amazon) lucrează exclusiv la recenzii și evaluări. Consumatorii au încredere în alți consumatori într-un mod mai intrinsec. Cum profitați de acest lucru, ca marcă, pentru a vă impulsiona imaginea și publicitatea digitală?

Puteți analiza recenzii și evaluări ale produselor de pe fiecare site web care listează produsele dvs. și apoi le puteți agrega. Ați putea să o ridicați la un nivel superior prin monitorizarea platformelor de rețele sociale și combinând-o cu analiza sentimentelor pentru a răspunde rapid celor dezamăgitori sau a recompensa și a stimula utilizatorii care vă iubesc. Industriile care au nevoie de acest lucru sunt nenumărate: turism, ospitalitate, comerț electronic, toți agregatorii online, dezvoltatori de aplicații.

F). SEO

Dacă nu este pe prima pagină a Google, nu există. Prin urmare, SEO. Și dacă lucrați pentru SEO, probabil că utilizați instrumente precum SEMrush sau Ubersuggest. Fapt distractiv: aceste instrumente nu ar exista literalmente dacă nu ar fi crawling și răzuire pe web.

Instrumentele pe care le puteți folosi pentru a vă afla concurenții SEO pentru un anumit termen de căutare. Vă puteți da seama de etichetele de titlu și de cuvintele cheie pe care le vizează pentru a afla ce anume redirecționează traficul către site-urile lor web și generează vânzări.

Cum creăm un proiect de web mining?

A). Identificați scopul

Aceasta este o idee. Aflați de ce aveți nevoie. Cum faci asta? Răspunde la următorul set de întrebări.

A). Ce fel de informații căutați?

b). La ce vă așteptați ca rezultat?

c). Unde sunt publicate de obicei datele pe care le căutați?

d). Pentru cine sunt aceste date?

e). În ce format ar trebui să fie prezentate aceste date utilizatorilor finali?

f). Durata de valabilitate tipică a datelor? Cât de des trebuie să efectuați această activitate?

B). Analiza serviciului de crawling pe web

Deoarece data scraping este extrem de automatizată, tipul de serviciu de web scraping pe care îl utilizați este primordial. Acestea sunt ceea ce ar trebui să țineți cont înainte de a selecta serviciul de răzuire:

A). Dimensiunile proiectului

b). Sistem de operare acceptat

c). Susține cerințele întreprinderii dvs.?

d). Suport limbaj de scripting

e). Suport încorporat pentru stocarea datelor

C). Proiectarea schemei de răzuire

Poate că munca noastră de scraping este să colectăm date de pe site-urile de locuri de muncă despre posturile vacante postate de recrutori. Sursa datelor ar determina atributele schemei. Ar arata asa:

A). Titlu

b). numar de identificare

c). Descriere

d). Adresa URL utilizată pentru a aplica pentru postul de către candidat

e). Locație

f). Remuneraţie

g). Tipul postului

h). Experiență necesară

D). Verificarea fezabilității și rularea pilot

O rulare pilot este întotdeauna o idee bună înainte de a începe un proiect de răzuire în întregime. Cum faci asta?

A). Verificați fezabilitatea răzuirii site-urilor web sursă

b). Răzuiți codul HTML

c). Preluați elementul dorit

d). Identificați adresele URL care duc la paginile ulterioare

Dacă sunteți mulțumit de rezultatele dvs., puteți continua cu o zgârietură mai mare. S-ar putea să fie nevoie să capturați Xpath-urile corectate și să le înlocuiți cu valori codificate. Poate fi necesară și o bibliotecă externă pentru a acționa ca intrări pentru sursă.

Acum că v-am ghidat prin crawling și răzuire web, în general, puteți crede că este o sarcină uriașă, care necesită supraveghere tehnică. Ei bine, da și nu. În timp ce puteți alege să faceți acest lucru în interior, perfecționându-vă personalul. Sau folosind multitudinea de instrumente DIY disponibile. Dar site-urile web devin din ce în ce mai complexe pe zi ce trece. Necesitatea de a externaliza web scraping către un furnizor de servicii premium este probabil cea mai bună modalitate de a scraping datele la scară.