Что такое веб-скрейпинг и зачем он нужен бизнесу?

Опубликовано: 2021-01-07Типичное использование парсинга веб-страниц ограничено только нашим воображением. Он сканирует и извлекает большие объемы данных буквально со всех веб-сайтов для множества применений, таких как мониторинг цен, поиск финансовых данных, анализ агрегации новостей и многие другие. Скрапинг и сканирование позволяют компаниям создавать новые продукты и внедрять инновации быстрее и лучше.

Например, на веб-сайте сопоставления цен, таком как Kayak, SEO-продукте, таком как Botify, или агрегаторе вакансий, созданном из нескольких источников, эти веб-сайты построены исключительно на парсинге веб-сайтов. Гарантируя простоту доступа к данным, парсеры улучшают ваше ценностное предложение. Прежде чем мы разгадаем тайну того, почему парсинг веб-сайтов меняет правила игры и какие отрасли в нем нуждаются больше всего, давайте познакомим вас с тем, что на самом деле представляет собой парсинг веб-сайтов.

Что такое веб-скрейпинг?

Веб-скрапинг (и веб-сканирование) — это автоматизированная идентификация и извлечение данных с веб-сайтов. Известность и потребность в агрегировании увеличились сверх всякой меры. Более того, потребности в качественных данных для аналитической отрасли не удовлетворяются. Веб-скраперы, по сути, являются пауками и предоставляют всю доступную информацию. Независимо от того, в какой отрасли вы работаете, парсинг данных станет решением как минимум одной из ваших проблем.

Применение сервисов парсинга веб-сайтов

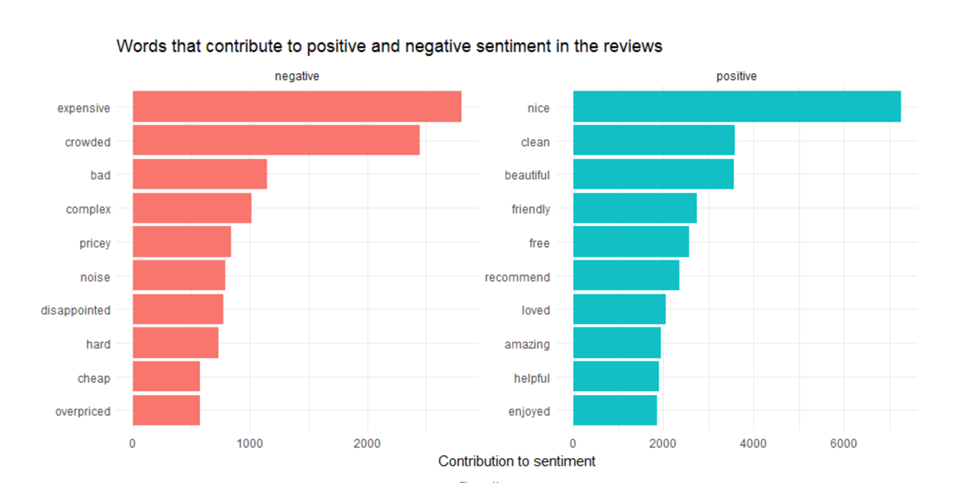

А). Анализ настроений

Каждая публикация в социальных сетях, размещенная в определенный период времени, неизменно раскрывает более широкую картину и помогает аналитикам понять настроения и поведение потребителей. Встроенные API во всех платформах социальных сетей могут быть неадекватными. Сканирование социальных сетей необходимо, чтобы понять, куда идет разговор и какие микротренды привлекают наибольшее внимание, скажем, путем анализа использования хэштегов .

Б). Ценообразование и мониторинг цен в электронной коммерции

Ценовые войны достигли новой точки со скрейпингом данных электронной коммерции. На олигополистическом и чувствительном к цене рынке очень важно следить за тем, как оценивается продукт по всем направлениям . Как продавец, вы также можете увидеть, какая платформа предлагает наилучшую маржу для ваших продуктов.

С). Агрегаторы вакансий

Агрегаторы вакансий используют службы парсинга для сканирования всех веб-страниц с вакансиями и их объединения в одном месте. В основном они работают как поисковые системы для объявлений о работе благодаря своим расширенным функциям поиска. Скрапинг происходит регулярно, чтобы убедиться, что в кадровом резерве отображаются только актуальные и актуальные вакансии.

Д). Машинное обучение

Искусственный интеллект и машинное обучение нуждаются в непрерывной подаче качественных данных, чтобы они могли эмулировать и воспроизводить человека. Им нужно постоянно получать самую свежую информацию, чтобы они могли продолжать адаптироваться. Службы веб-сканирования очищают большое количество точек данных, текста и изображений, чтобы помочь в этом. Машинное обучение продвигает технологические чудеса, такие как беспилотные автомобили, умные очки, распознавание изображений и речи. Однако, чтобы масштабировать их в геометрической прогрессии, эти модели нуждаются в регулярном обновлении данных для повышения их точности и надежности.

Е). Мониторинг бренда

Большинство игроков электронной коммерции (вот вам Амазон) работают исключительно на обзорах и рейтингах. Потребители больше доверяют другим потребителям. Как вы, как бренд, зарабатываете на этом, чтобы продвигать свой имидж и цифровую рекламу?

Вы можете собирать обзоры продуктов и рейтинги с каждого веб-сайта, на котором перечислены ваши продукты, а затем объединять их. Вы можете поднять его на ступеньку выше, отслеживая платформы социальных сетей и сочетая его с анализом настроений, чтобы быстро реагировать на скептиков или вознаграждать и стимулировать пользователей, которые вас любят. Отрасли, которым это нужно, безграничны: туризм, гостиничный бизнес, электронная коммерция, все онлайн-агрегаторы, разработчики приложений.

Ф). SEO

Если его нет на первой странице Google, его не существует. Следовательно, SEO. И если вы работаете над SEO, вы, вероятно, используете такие инструменты, как SEMrush или Ubersuggest. Забавный факт: эти инструменты буквально не существовали бы, если бы не сканирование и парсинг веб-страниц.

Те самые инструменты, которые вы можете использовать, чтобы узнать своих SEO-конкурентов по определенному поисковому запросу. Вы можете понять теги заголовков и ключевые слова, на которые они ориентируются, чтобы понять, что перенаправляет трафик на их веб-сайты и стимулирует продажи.

Как мы настраиваем проект веб-майнинга?

А). Определите цель

Это не ежу понятно. Разберитесь, что именно вам нужно. Как ты это делаешь? Ответьте на следующий блок вопросов.

а). Какую информацию вы ищете?

б). Что вы ожидаете в результате?

в). Где обычно публикуются искомые данные?

г). Для кого эти данные?

д). В каком формате эти данные должны быть представлены конечным пользователям?

е). Типичный срок хранения данных? Как часто вам приходится выполнять это действие?

Б). Анализ службы веб-сканирования

Поскольку парсинг данных является высокоавтоматизированным, первостепенное значение имеет тип службы веб-скрейпинга, которую вы используете. Вот что вы должны иметь в виду, прежде чем выбрать услугу парсинга:

а). Размеры проекта

б). Поддерживаемые ОС

в). Поддерживает ли он требования вашего предприятия?

г). Поддержка языка сценариев

д). Встроенная поддержка хранения данных

С). Разработка схемы парсинга

Возможно, наша работа по парсингу заключается в сборе данных с сайтов по трудоустройству о вакансиях, размещенных рекрутерами. Источник данных будет определять атрибуты схемы. Это будет выглядеть так:

а). Заголовок

б). идентификационный номер

в). Описание

г). URL-адрес, используемый кандидатом для подачи заявки на должность

д). Расположение

е). Вознаграждение

грамм). Тип вакансии

час). Требуется опыт

Д). Проверка осуществимости и пилотный запуск

Пилотный запуск — это всегда хорошая идея, прежде чем приступать к полномасштабному проекту парсинга. Как ты это делаешь?

а). Проверьте возможность парсинга исходных веб-сайтов

б). Очистить HTML

в). Получить нужный предмет

г). Определите URL-адреса, ведущие на последующие страницы

Если вы довольны своими результатами, вы можете перейти к более крупной очистке. Возможно, вам придется поймать исправленные Xpaths и заменить их жестко запрограммированными значениями. Внешняя библиотека также может быть необходима в качестве входных данных для источника.

Теперь, когда мы провели вас через веб-сканирование и парсинг, в общем и целом, вы можете подумать, что это гигантская задача, требующая технического надзора. Ну да и нет. Хотя вы можете сделать это самостоятельно, повысив квалификацию своего персонала. Или с помощью множества доступных инструментов DIY. Но веб-сайты с каждым днем становятся все более и более сложными. Необходимость аутсорсинга веб-скрапинга у поставщика услуг премиум -класса, вероятно, является лучшим способом для очистки данных в масштабе.