Veri Normalleştirmenin Önemi

Yayınlanan: 2021-02-04Şirketler her zaman zirvede kalmak için verileri kullandılar. İşletmeler tuğla ve harç depolarından çıktıklarında, veri kümeleri daha küçük olduğu için bu veri sıkıştırmanın çoğu çevrimdışıydı. Daha fazla şirket işlerini çevrimiçi ortama (veya en azından bir kısmına) taşıdıkça, veri kümelerinin boyutları büyüdü ve şimdi terabayt ve petabayt boyutlarına ulaşıyor. Bu veri kümeleri şunlardan oluşur:

a). Ürün ayrıntılarını, çalışan bilgilerini, iş ortağı sözleşmelerini, depo-stok güncellemelerini ve daha fazlasını içerebilecek dahili veriler

b). GPS sensörleri, akıllı robotlar, izleme sensörleri ve dijital ikizler gibi IoT cihazlarından gelen veriler

c). Web'den alınan rakip verileri gibi harici veriler

Farklı kaynaklardan gelen verilerin tümü aynı şekil ve biçimde olmayabilir. Metin, ses, video ve hatta tablo biçiminde verilere sahip olabilirsiniz. Hepsini tek bir yapılandırılmış biçime dönüştürdükten sonra, hepsinin aynı başlıklara sahip olmadığını fark edeceksiniz. Olsalar bile, birimler aynı olmayabilir. Verilerde yinelenen satırlar da olabilir.

Veri Normalleştirme nedir?

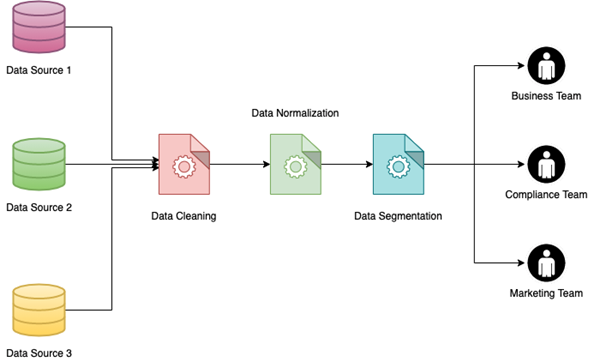

Tüm bu tür veri konularının birlikte işlenmesi toplanır ve topluca Veri Normalleştirme olarak adlandırılır. Esas olarak, farklı kaynaklardan derlenen verilerin yeniden düzenlenmesine ve birlikte kullanılmasına yardımcı olur. Ayrıca iş ekibi için verilerin okunabilirliğini artırır ve böylece veri görselleştirmeleri oluşturmaya yönelik daha tak ve çalıştır yaklaşımı sağlar.

Veri Normalleştirme, her aşamanın ayrıca farklı veri kaynakları için farklı adımlara bölünebildiği birden fazla aşama içerebilir. En yaygın veri normalleştirme teknikleri veya aşamaları şunları içerir:

a). Yinelenen girişlerin kaldırılması

b). Verileri mantıksal gruplama metodolojisine göre gruplama

c). İlgili veri noktaları arasında ilişkilendirmeler oluşturma

d). Çakışan veri girişlerini çözme

e). Farklı veri kümelerini tek bir formata dönüştürme

f). Yarı yapılandırılmış veya yapılandırılmamış verilerin anahtar/değer kümelerine dönüştürülmesi

g). Birden çok kaynaktan gelen verilerin konsolidasyonu

h). Bir sütundaki tüm satırların aynı birimlere dönüştürülmesi

i). Büyük sayısal değerlere sahip sütunları 10'un katları ile bölme

j). Kategorik sütunlara sayısal değerler atama

Bu tür çabalar birlikte genel olarak veri kalitesinin iyileştirilmesine yol açar ve ayrıca bu veri kümelerinin sonunda kullanıldığı iş akışlarında gerekli olan işlemenin azaltılmasına yardımcı olur. Bu tür işlemler, adlar, adresler, telefon numaraları, pin kodları, para birimi değerleri, iki nokta arasındaki mesafe ve daha fazlası gibi farklı alan türlerini işlemek için kullanılabilir. Her şirket, veri akışına giren tüm veri kümelerinin normalleştirildiği bir dizi standart biçim ve kural tanımlar.

Ham Veriler, yürürlükteki standardizasyon kurallarına göre farklı şekillerde işlenebilir. Bazı veri standardizasyonu örnekleri aşağıdaki tabloda gösterilmektedir.

| İşlenmemiş veri | Normalleştirilmiş Veri |

| 25 güney parkı | 25 Güney Parkı |

| Kıdemli Başkan Yardımcısı Reklamı | Kıdemli Reklam Başkan Yardımcısı |

| 1 santimetre | 1 cm |

| 1 ayak | 30.48cm |

| Erkek/Kadın/Diğerleri | M/F/O |

| 25 dolar | ₹1850 |

Verilerinizi Normalleştirmezseniz ne olur?

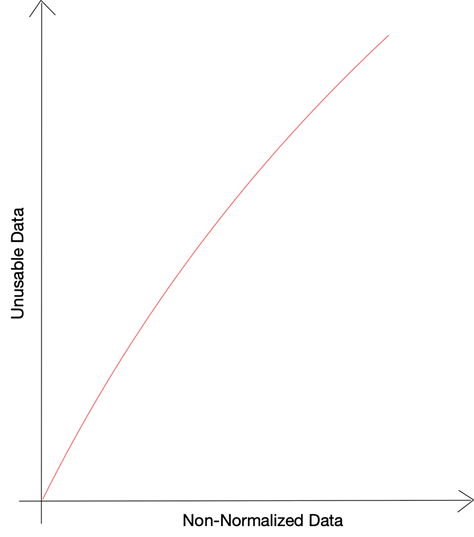

Gartner tarafından yürütülen araştırmaya göre, düşük veri kalitesi nedeniyle tüm iş çabalarının neredeyse %40'ı kaybediliyor . Kötü veriler veya kötü biçimlendirilmiş veriler, iş süreçlerindeki farklı aşamaları etkiler ve operasyonel verimliliğin yanı sıra risk yönetimini de bozar. Veriye dayalı kararlar hatalı verilere dayandığında, işletmenin verileri kendi avantajına kullanma yeteneği tehlikeye girer. Standartlaştıramadığınızda ve farklı veri kaynaklarına sığdıramadığınızda, iş kararları için büyük veri kullanmanın faydaları kaybolur.

Kullanılabilir verilerin en büyük düşmanlarından biri, eksik veya bozuk verilerdir - tüm veri noktalarının doğru şekilde mevcut olmadığı satırlar. Bu tür sorunlar, ham verilerin yanlış işlenmesinden veya kaynak verilerdeki tutarsızlıklardan kaynaklanabilir. Verileri kullanılamaz hale getiren diğer önemli veri sorunu, kullanılabilir bitlere bölünmemiş yapılandırılmamış veri miktarıdır.

Priceonomics tarafından yapılan bir araştırmaya göre, şirketler tarafından toplanan verilerin %55 kadarı kullanılmamaktadır . Firmalar tarafından toplanan ancak belirli kısıtlamalar nedeniyle kullanılamayan bu veriler karanlık veri olarak adlandırılmaktadır. Verilerin bu kadar büyük bir bölümünün kullanılamamasının nedenleri sorulduğunda, yanıt verenlerin %66'sı cevap olarak “eksik veya bozuk veri”yi seçerken, %25'i yapılandırılmamış formatlardan şikayet etmeyi tercih etti.

Şirketler hem iç hem de dış kaynaklardan veri toplamaya devam ettikçe, net veri boyutu artmaya devam ediyor. Bugün çoğu şirket, AWS veya GCP gibi hizmetler tarafından bulut depolama hizmetlerini kullanıyor ve altyapı faturalarınızın ne kadar büyüdüğünü unutmak kolaydır. Çoğu hizmet sizden, depolanan verilerin boyutuna değil, gerçekleştirdiğiniz sorgulara göre ücret alırken, yine de üç şeyi göz önünde bulundurmanız gerekir:

a). Veri hacmi büyüdükçe, sorguların daha fazla veriyi ayrıştırması gerekecek ve yürütülmesi daha uzun sürecektir.

b). Yürütülmesi daha uzun süren sorguların bir etkisi olarak, aynı anda çalışan birden çok sorgu zaman aşımı hatasına neden olabilir

c). Her sorgu için ayrıştırılan veri miktarı arttıkça, bulut hizmetleri için katlanılan maliyetler istikrarlı bir şekilde artacaktır.

Veri Normalleştirmenin Faydaları

Veri Normalleştirmenin en büyük avantajlarından biri, Veri Segmentasyonunu uygulama yeteneğidir. Veri Segmentasyonu, verileri farklı dahili ekipler tarafından daha kolay kullanılabilecek şekilde farklı parametrelere dayalı olarak gruplama yeteneğidir. Veriler, müşterilerin cinsiyeti, konum (kentsel veya kırsal), endüstri türü ve daha fazlası gibi farklı faktörlere göre bölümlere ayrılabilir.

Özellikle birden fazla veri kaynağının birleştirilmesiyle derlenen büyük bir veri setinde Veri Bölümlemeyi uygulamak göz korkutucu bir görev olabilir. Veriler zaten normalleştirilmişse, birçok kez daha kolay olacaktır. Bunun faydaları çok yönlüdür:

a). Veriler normalleştirilir ve bölümlere ayrılırsa, farklı ekipler, temiz olmayan veya bozuk verileri filtreleme ihtiyacından endişe duymadan farklı verileri çıkarabilir.

b). Şirketler, sınırlı pazarlama bütçelerinde daha iyi dönüşüm oranları elde etmek için segmentlere ayrılmış verileri kullanarak hedefli bir reklamcılık ve pazarlama yaklaşımı kullanabilir.

c). Segmentlere ayrılmış veriler ayrıca şirketlerin sonuçlarını ve müşteri geri bildirimlerini analiz etmelerine ve neyin doğru, neyin yokuş aşağı gittiğini anlamalarına yardımcı olabilir. Bu bilgi tüketilmesine veya masada bırakılmasına göre bir şirket yapabilir veya bozabilir.

Müşteri davranışını tahmin etmek ve anormallikleri tespit etmek, büyük hacimli verileri analiz eden ve tahmine dayalı modeller oluşturmaya çalışan büyük kuruluşlar için ana hedeflerden bazılarıdır. Normalleştirme ve standardizasyondan sonra ham verilerin kendisi depolanmışsa, bu tür çabaların arkasındaki çabalar büyük ölçüde en aza indirilebilir. Veri Bilimi ekibiniz ister yeni bir makine öğrenimi modeli üzerinde çalışıyor olsun, isterse iş ekibiniz Netflix'inkiyle karşılaştırılabilecek bir öneri sistemi oluşturmaya çalışıyor olsun, başlangıç noktası olarak temiz ve normalleştirilmiş veriler mutlak bir zorunluluktur.

İşler Ne Kadar Kötüleşebilir?

Veri Normalleştirme, birden fazla ekip aynı veri kaynağını kullandığında veya veriler aracılığıyla kendi aralarında iletişim kurduğunda yardımcı olabilir. Veri kaynağı sayısı ne kadar yüksekse ve dahil olan ekip ve kişi sayısı ne kadar fazlaysa, normalleştirilmemiş verilerin riskleri de o kadar yüksek olur. Normalleştirilmemiş verilerde meydana gelen en önemli tarihsel olaylardan biri, mühendislerin değerleri İngilizce'den Metrik Sisteme çeviremedikleri için kaybedilen 125 milyon dolarlık Mars Sondası'ydı . Tekdüzeliği korumak için birim dönüştürmeleri, temel Veri Normalleştirme Tekniklerinden biri olmaya devam etmektedir.

Kayıplarınız bu kadar yüksek bir değeri karşılamayabilir, ancak dağınık verilerden kaynaklanan kayıpları hesaplayamayabilirsiniz. Yavaş yavaş veri kullanılamazlığının ana nedenlerinden birine sızacaktı. Dolaylı olarak, şirketinizde kullanılmayan verilerin yüzdesi, verileri normalleştirme çabalarına girmeme nedeniyle kaybı ifade eder.

Verilerin normalleştirilmesi ve standartlaştırılması hakkında çok şey konuşmuş olsak da, verileri düzgün bir şekilde getirmek, yapılan işin yarısıdır. Verileri dış kaynaklardan temiz bir şekilde sıyırırsanız, normalleştirme çabalarınız büyük ölçüde azaltılabilir. PromptCloud'daki ekibimiz, şirketlerin web kazıma gereksinimlerini bize sağlayabilecekleri bir DaaS (Hizmet olarak Veri) çözümü sunmaktan gurur duyuyor ve verileri tak ve çalıştır biçiminde sunuyoruz. Birden fazla web sitesinden verileri sıyırabilir ve her birinden farklı kapsayıcılarda veya farklı API'ler aracılığıyla veri sağlayabiliriz. Bu yapıldıktan sonra, verileri toplamak ve zenginleştirmek için Veri Normalleştirme modüllerinizi yazabilir ve böylece ekibinizin veri destekli kararlar almasını sağlayabilirsiniz.