Atualização do Google BERT: histórico e análise

Publicados: 2019-10-29É a maior mudança no algoritmo do Google em cinco anos, afetando uma em cada dez consultas de pesquisa. Com o Google BERT Update, o Google visa melhorar a interpretação de consultas de pesquisa complexas de cauda longa e exibir resultados de pesquisa mais relevantes. Ao usar o Processamento de linguagem natural, o Google melhorou muito sua capacidade de entender o contexto semântico do termo de pesquisa.

Se você estiver procurando por suporte com a otimização do mecanismo de pesquisa do seu site, poderá obter mais informações e análises de nossos especialistas:

Agende um horário!

Dois centavos da Searchmetrics na atualização do Google BERT

“Bert é um desenvolvimento lógico para o Google, seguindo os passos de Panda, Hummingbird e RankBrain. No entanto, desta vez não estamos analisando uma mudança na forma como os dados são indexados ou classificados. Em vez disso, o Google está tentando identificar o contexto de uma consulta de pesquisa e fornecer resultados de acordo. Esta é uma adição empolgante ao que os modelos livres de contexto, como Word2Vec e GloVe, podem oferecer. Para Pesquisa por Voz e Pesquisa Conversacional, espero ver avanços significativos na qualidade dos resultados em um futuro próximo.” – Malte Landwehr, vice-presidente de produtos, Searchmetrics

“Bert é um desenvolvimento lógico para o Google, seguindo os passos de Panda, Hummingbird e RankBrain. No entanto, desta vez não estamos analisando uma mudança na forma como os dados são indexados ou classificados. Em vez disso, o Google está tentando identificar o contexto de uma consulta de pesquisa e fornecer resultados de acordo. Esta é uma adição empolgante ao que os modelos livres de contexto, como Word2Vec e GloVe, podem oferecer. Para Pesquisa por Voz e Pesquisa Conversacional, espero ver avanços significativos na qualidade dos resultados em um futuro próximo.” – Malte Landwehr, vice-presidente de produtos, Searchmetrics

Onde o BERT foi implementado?

Enquanto o BERT inicialmente usava apenas os resultados de pesquisa orgânica do Google.com, desde dezembro de 2019 o BERT lançou mais de 70 idiomas em todo o mundo. Para Featured Snippets, que são exibidos sobre os resultados da pesquisa orgânica como posição 0 com texto, tabela ou lista, o BERT já foi usado em todos os 25 idiomas para os quais o Google também exibe Featured Snippets.

O BERT está sendo implementado para o cálculo dos resultados de pesquisa orgânica em: africâner, albanês, amárico, árabe, armênio, azeri, basco, bielorrusso, búlgaro, catalão, chinês (simplificado e Taiwan), croata, tcheco, dinamarquês, holandês, inglês , Estoniano, Farsi, Finlandês, Francês, Galego, Georgiano, Alemão, Grego, Gujarati, Hebraico, Hindi, Húngaro, Islandês, Indonésio, Italiano, Japonês, Javanês, Kannada, Cazaque, Khmer, Coreano, Curdo, Quirguistão, Lao, Letão , lituano, macedônio malaio (Brunei Darussalam e Malásia), malaiala, maltês, marata, mongol, nepalês, norueguês, polonês, português, punjabi, romeno, russo, sérvio, cingalês, eslovaco, esloveno, espanhol suaíli, sueco, tagalo, tadjique , Tamil, Telugu, Tailandês, Turco, Ucraniano, Urdu, Uzbeque e Vietnamita.

Neste tweet, o Google anunciou o lançamento global do BERT:

O BERT, nossa nova maneira de a Pesquisa Google entender melhor o idioma, está sendo implementado em mais de 70 idiomas em todo o mundo. Ele foi lançado inicialmente em outubro para o inglês dos EUA. Você pode ler mais sobre o BERT abaixo e uma lista completa de idiomas está neste tópico…. https://t.co/NuKVdg6HYM

— Google SearchLiaison (@searchliaison) 9 de dezembro de 2019

Enquanto isso, o analista do Webmaster Trends, John Mueller, falou em um de seus hangouts do Google Webmaster depois que um usuário relatou um declínio de 40% no tráfego e suspeitou que o BERT fosse a causa. Mueller explicou que o BERT não era responsável por tais classificações e diminuições de tráfego, mas uma das atualizações regulares ou uma atualização principal. De acordo com quais critérios são feitas as alterações do algoritmo, Mueller explica detalhadamente como funciona o desenvolvimento no Google a partir de 30:46 minutos no vídeo:

O que significa BERT?

A abreviatura, 'BERT', significa Bidirectional Encoder Representations from Transformers e refere-se a um modelo de algoritmo baseado em redes neurais. Com a ajuda do Processamento de Linguagem Natural (NLP), os sistemas de máquina tentam interpretar a complexidade da linguagem humana. Você pode encontrar uma documentação detalhada do BERT no blog de IA do Google.

Simplificando, o Google usa o BERT para tentar entender melhor o contexto de uma consulta de pesquisa e interpretar com mais precisão o significado das palavras individuais. Esse avanço é construído em modelos matemáticos chamados Transformers: eles analisam uma palavra em relação a todas as outras palavras da frase – ou no caso da busca no Google a consulta de pesquisa – e não olham simplesmente para o significado das palavras isoladamente. Isso é particularmente útil ao interpretar o significado de preposições e a posição de palavras individuais em uma consulta de pesquisa.

Por que a atualização do BERT é tão importante para o Google?

De acordo com o Google, cerca de 15% de todas as consultas de pesquisa são novas – isso significa que estão sendo pesquisadas pela primeira vez. Além disso, o fraseado das consultas de pesquisa está se aproximando cada vez mais da comunicação humana real – em parte sob a influência de avanços técnicos como a Pesquisa por voz. O serviço de estatísticas Comscore estima que a proporção de pesquisas por voz atingirá 50% em dois anos. Outro fator é o aumento da duração das consultas de pesquisa – hoje, 70% das pesquisas podem ser consideradas de cauda longa. As pessoas recorrem ao Google com perguntas totalmente formuladas e esperam respostas precisas em uma fração de segundo – e o BERT agora representa uma parte significativa da tecnologia que torna isso possível.

Há muitos anos, o Google trabalha em redes neurais que podem responder corretamente a novas consultas de pesquisa e melhorar a interpretação do conteúdo:

- Hummingbird: Em 2013, o Hummingbird foi incorporado ao algoritmo do Google. Essa atualização do algoritmo tornou possível interpretar melhor as consultas de pesquisa inteiras, em vez de apenas pesquisar as palavras individuais em uma consulta.

- RankBrain : Em 2015, o RankBrain passou a fazer parte do algoritmo do Google e foi declarado o terceiro fator de classificação mais importante. Isso tornou possível processar termos de pesquisa com vários significados ou consultas complexas que vão além da pesquisa normal de cauda longa. Com o RankBrain, também foi possível processar buscas iniciais, coloquialismos, diálogos e neologismos.

Quais consultas de pesquisa são afetadas pelo BERT?

O impacto do BERT afeta as consultas de pesquisa de cauda longa. BERT melhora a interpretação do contexto para consultas mais longas que são inseridas (ou faladas para Pesquisa por Voz) na barra de pesquisa como uma pergunta ou um grupo de palavras.

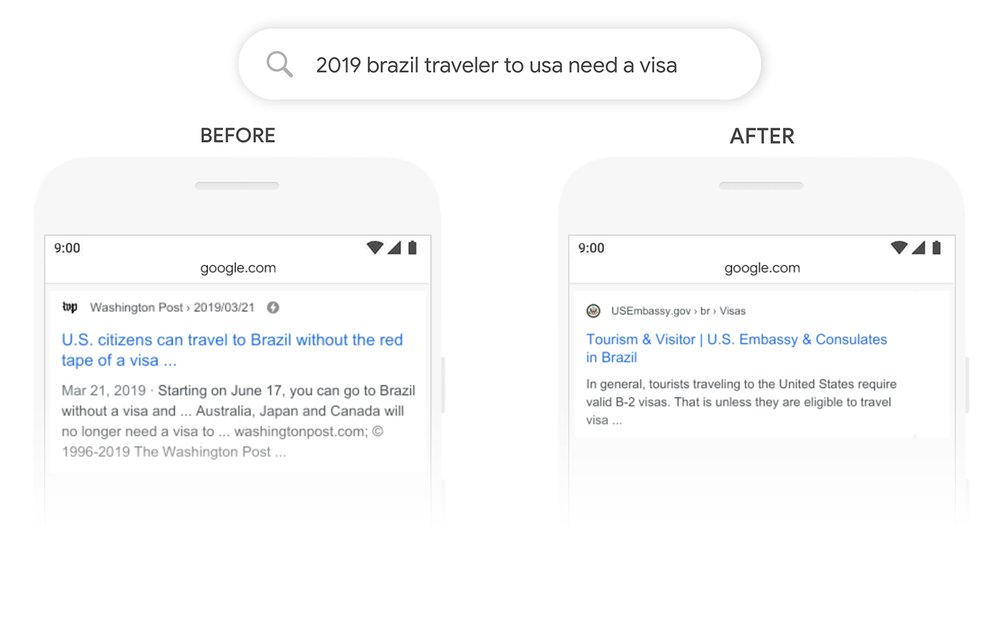

Em seu blog, o Google forneceu alguns exemplos de consultas de pesquisa que o BERT ajuda a entender melhor e para as quais o mecanismo de pesquisa agora fornece resultados mais relevantes.

Neste exemplo para um resultado de busca orgânica, segundo o Google, a importância da palavra “para” e sua relação com outras palavras foram anteriormente subestimadas. No entanto, a palavra “para” desempenha um papel integral no significado da frase. Estamos lidando com alguém do Brasil que quer viajar para os EUA – e não o contrário. O novo modelo BERT permite que o Google entenda corretamente essa distinção e forneça resultados que correspondam à verdadeira intenção de pesquisa.

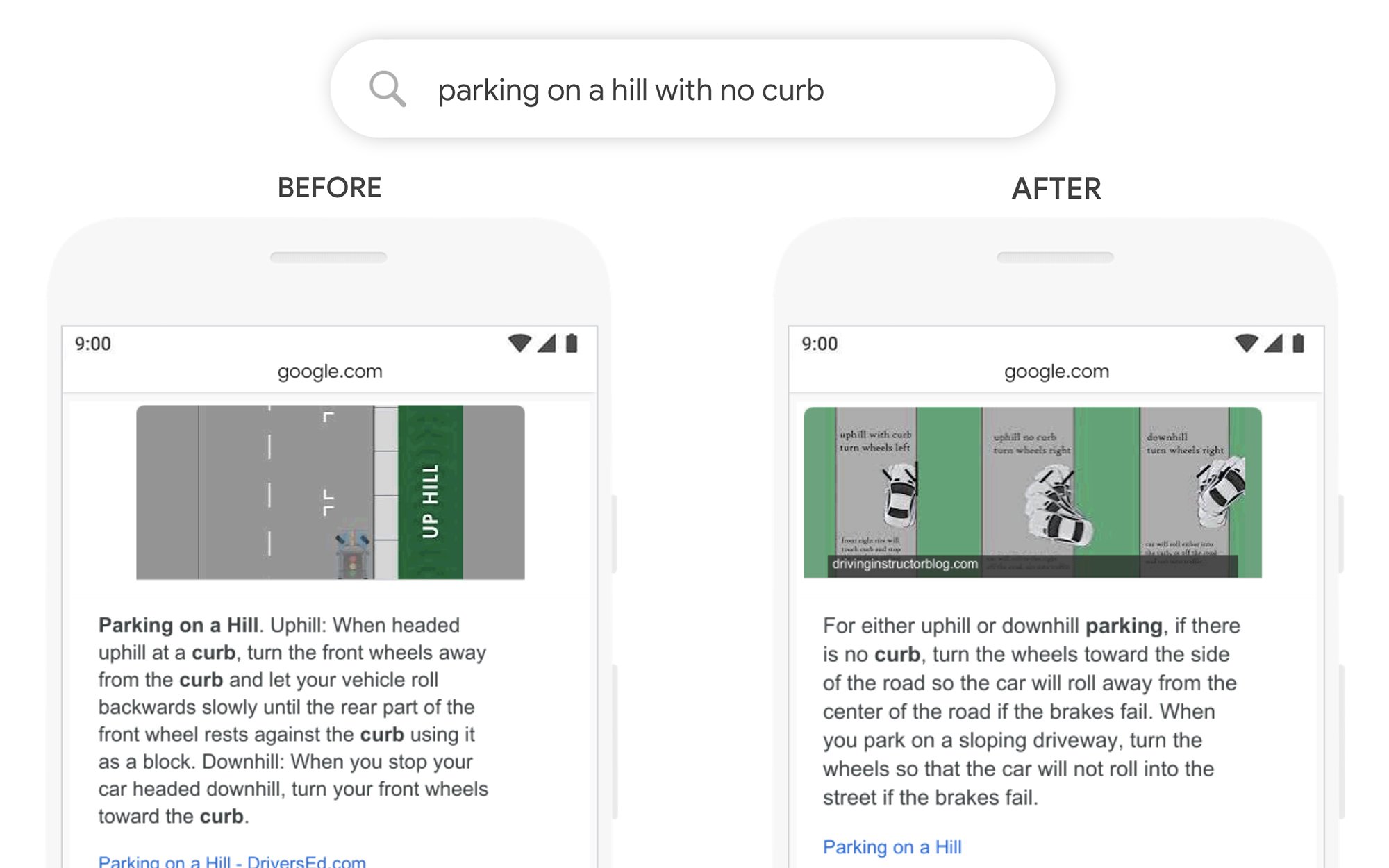

Exemplo 2: “Estacionar em uma colina sem meio-fio”

Neste exemplo do blogpost do Google, que trata da avaliação dos resultados da pesquisa para escolher o Featured Snippet mais relevante, o foco costumava ser colocado muito fortemente na palavra “curb”, ignorando a importância da palavra “não”. Isso significava que um snippet em destaque foi exibido de pouca utilidade, pois na verdade respondia à pergunta oposta àquela feita pelo pesquisador.

O que os SEOs e webmasters podem fazer?

Não há uma resposta simples sobre como reagir ao BERT. Não há táticas fáceis que você possa usar para melhorar a classificação do seu site de repente ou para recuperar perdas. Em vez disso, é importante ter em mente que você precisa escrever seu conteúdo e construir seus sites não apenas para algoritmos, mas para pessoas: para seus usuários e clientes em potencial que visitarão e interagirão com seu site.