Регулирование и соблюдение требований в области искусственного интеллекта в ЕС: определение правовой среды для разработки программного обеспечения

Опубликовано: 2024-02-12Искусственный интеллект (ИИ) быстро меняет способ функционирования нашего мира, оказывая значительное влияние на различные отрасли. Эта технология уже продемонстрировала свои возможности во всех отраслях: от персонализированного медицинского обслуживания до оптимизации логистики и цепочек поставок.

На европейских рынках потенциал ИИ особенно многообещающий, поскольку страны и предприятия быстро осваивают разработку программного обеспечения на базе ИИ для стимулирования инноваций, роста и общественного благосостояния.

Однако, наряду с волнением, существуют и важные проблемы, которые необходимо решить. Обеспокоенность по поводу предвзятости алгоритмов, их прозрачности и потенциального увольнения подняла множество этических и социальных вопросов, которые требуют тщательного рассмотрения. Крайне важно найти баланс между использованием его потенциала и снижением рисков для эффективного управления ландшафтом ИИ.

Примечательно, что Европейский Союз недавно внес изменения в Закон об ИИ, подчеркнув важность регулирования ЕС в области ИИ. Для компаний, желающих выйти на рынок разработки программного обеспечения в Европе, понимание и соблюдение этих правил больше не является необязательным, а является неотъемлемой частью бизнеса.

Этот блог поможет вам понять все, что связано с пересечением искусственного интеллекта и разработки программного обеспечения, освещая развивающуюся ситуацию в сфере регулирования ИИ в ЕС. В дополнение к этому мы также углубимся в важность соблюдения государственных нормативных стандартов в области ИИ.

Итак, без лишних слов, перейдем к важным деталям.

Значение регулирования ИИ в ЕС

Европейский Союз (ЕС) занимает активную позицию в вопросах регулирования и соблюдения требований в мире, где доминирует программное обеспечение на основе искусственного интеллекта. Признавая потенциальные преимущества и риски этой мощной технологии, ЕС стремится создать надежную основу, подкрепленную этическими практиками, прозрачностью и ответственным внедрением. Понимание важности соответствия ИИ при разработке программного обеспечения имеет решающее значение по нескольким причинам:

Укрепление доверия

Соблюдение требований ИИ в ЕС направлено на укрепление доверия между пользователями, предприятиями и заинтересованными сторонами путем обеспечения этической разработки и использования систем ИИ. Это доверие необходимо для широкого внедрения и дальнейшего развития решений искусственного интеллекта.

Снижение этических рисков

Потенциал предвзятости, дискриминации и других этических проблем растет по мере того, как ИИ все больше интегрируется в повседневную жизнь. Нормативы ЕС направлены на смягчение этих рисков и обеспечение справедливого и ответственного использования систем искусственного интеллекта.

Соблюдение требований и устойчивое развитие

ЕС стремится создать устойчивую и ответственную экосистему искусственного интеллекта, устанавливая четкие требования к соблюдению. Это помогает предприятиям управлять рисками, укреплять кибербезопасность и повышать прозрачность. В конечном итоге понимание важности соблюдения требований ИИ помогает предприятиям решать юридические вопросы и способствует ответственной разработке и внедрению ИИ.

Соблюдение требований ИИ в ЕС — это не только юридическое обязательство для бизнеса, но и стратегическая инвестиция в долгосрочный успех ИИ и его положительное влияние на общество. Соблюдая правила ЕС в области искусственного интеллекта, предприятия могут внести свой вклад в построение будущего, в котором их решения на базе искусственного интеллекта приносят пользу всем с этической и устойчивой точки зрения.

Чтобы убедиться, что система ИИ соответствует правилам, она должна пройти оценку соответствия. После его прохождения он регистрируется в базе данных ЕС и получает маркировку CE (европейское соответствие), подтверждающую его соответствие стандартам, прежде чем он будет допущен на рынок. Если в системе происходят большие изменения, такие как обучение на новых данных или добавление/удаление функций, она должна пройти новую оценку, чтобы убедиться, что она по-прежнему соответствует правилам, прежде чем ее можно будет снова сертифицировать и вернуть в базу данных.

Регламент ЕС в области искусственного интеллекта: изучение нормативно-правовой базы для разработки программного обеспечения на основе искусственного интеллекта

Европейский Союз принял несколько ключевых правил, которые существенно влияют на сферу искусственного интеллекта. Регулирование ИИ в разработке программного обеспечения призвано обеспечить этическую разработку ИИ, способную защитить конфиденциальность людей и снизить потенциальные риски. Давайте рассмотрим некоторые ключевые требования ЕС в области разработки ИИ.

1. Общий регламент защиты данных (GDPR)

Общий регламент по защите данных (GDPR) является решающим фактором в формировании ландшафта искусственного интеллекта в Европейском Союзе. Он фокусируется на защите персональных данных и применяет строгие меры для обеспечения прозрачности и подотчетности в приложениях искусственного интеллекта.

В дополнение к этому, GDPR также устраняет алгоритмическую предвзятость, подчеркивая важность справедливых и беспристрастных систем искусственного интеллекта. Постановление требует использования оценок воздействия на защиту данных (DPIA) для проектов ИИ, которые оценивают потенциальные риски и последствия для конфиденциальности. Эта всеобъемлющая нормативно-правовая база призвана создать прочную основу для этического и ответственного развития ИИ в ЕС.

2. Закон об искусственном интеллекте

Закон об искусственном интеллекте представляет собой всеобъемлющую структуру, регулирующую системы искусственного интеллекта высокого риска. В нем излагаются требования к прозрачности, объяснимости и человеческому надзору. Эта нормативная структура направлена на содействие ответственной и объяснимой разработке и внедрению ИИ.

Компании, разрабатывающие программное обеспечение на основе искусственного интеллекта, должны соблюдать требования ИИ при разработке программного обеспечения и его последствиях, включая сроки соответствия и практические соображения. Устанавливая критерии прозрачности и надзора, Закон обеспечивает баланс между содействием инновациям и защитой основных прав. Это открывает путь к этической практике искусственного интеллекта в Европейском Союзе.

3. Директива об ответственности за качество продукции

Директива об ответственности за качество продукции — это всеобъемлющая структура, в которой приоритетом отдается безопасность продуктов искусственного интеллекта и благополучие конечных пользователей. Он возлагает на разработчиков ответственность за управление потенциальными рисками, связанными с продуктами искусственного интеллекта, подчеркивая необходимость активного подхода к безопасности продуктов.

Директива призывает разработчиков, связанных с разработкой продуктов, изучать стратегии управления рисками для повышения общих стандартов безопасности продуктов искусственного интеллекта. Придерживаясь этих мер, разработчики могут внести свой вклад в создание безопасной и надежной среды искусственного интеллекта в Европейском Союзе.

Всесторонне понимая регулирование ИИ в ЕС, предприятия могут ориентироваться в меняющейся сфере разработки ИИ, обеспечивая соблюдение требований, этические нормы и ответственное внедрение технологий ИИ.

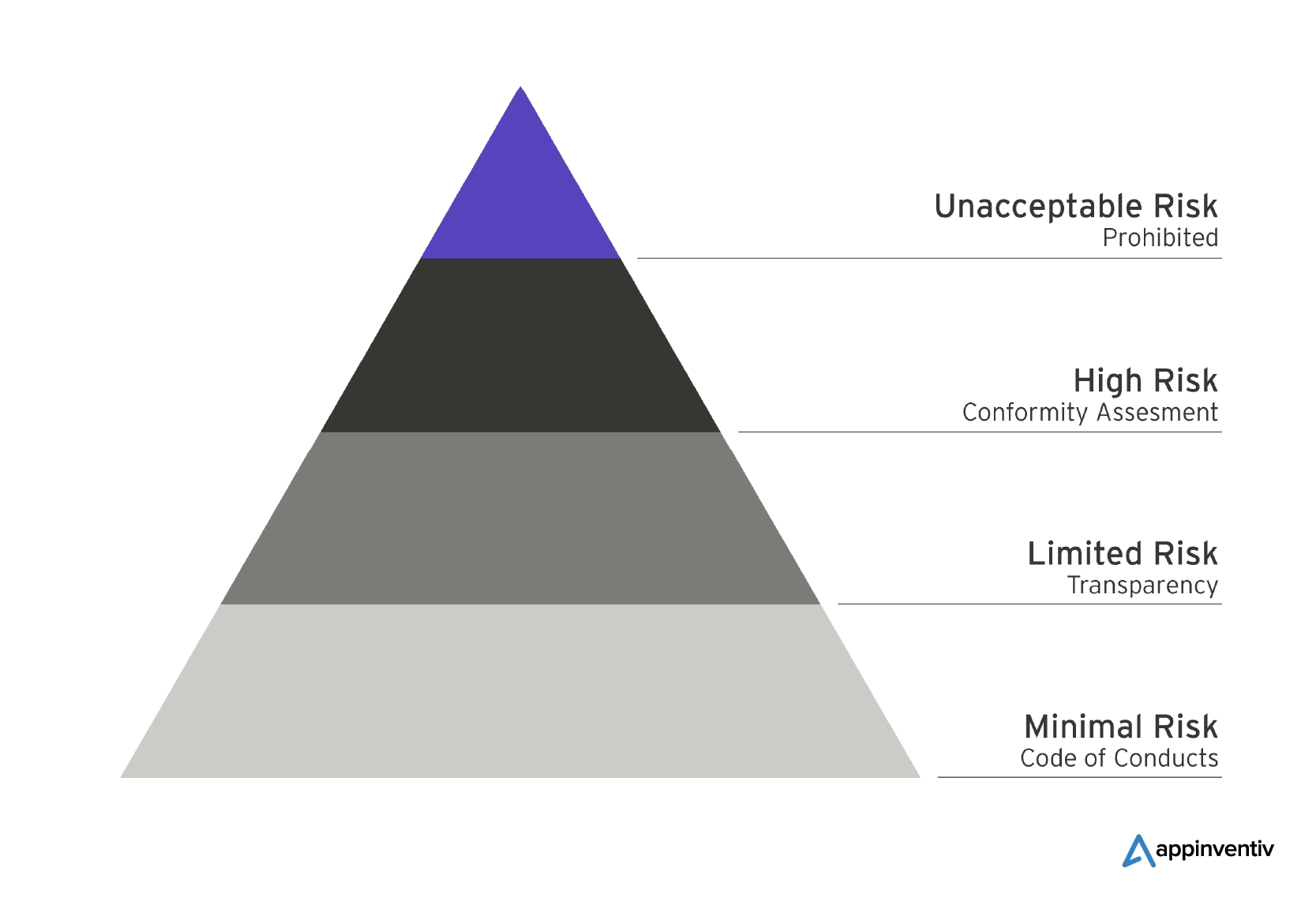

Навигация по спектру рисков: понимание категорий рисков в новом Законе ЕС об искусственном интеллекте

По мнению Европейского парламента, основной целью является обеспечение безопасности, прозрачности, отслеживаемости, недискриминации и экологической устойчивости систем искусственного интеллекта, используемых в ЕС. Таким образом, они установили дифференцированные правила, основанные на уровне риска, связанного с системами ИИ. Давайте подробно рассмотрим несколько категорий ниже:

Неприемлемый риск: запрет угрожающих систем искусственного интеллекта

Системы искусственного интеллекта, попадающие в категорию неприемлемого риска, считаются прямой угрозой для отдельных лиц и будут строго запрещены в соответствии с новым Законом ЕС об искусственном интеллекте. Например, когнитивно-поведенческие манипуляции, социальный рейтинг и биометрическая идентификация — вот некоторые примеры деятельности, подпадающей под эту запрещенную категорию. Некоторые исключения могут быть разрешены для конкретных приложений правоохранительных органов, к которым будут применяться строгие условия, особенно в случае систем биометрической идентификации в реальном времени.

Высокий риск: обеспечение безопасности и основных прав

Категория высокого риска, указанная в Законе ЕС об искусственном интеллекте, служит защитной мерой, обеспечивающей безопасность и сохранение основных прав при использовании искусственного интеллекта. В эту категорию входят системы искусственного интеллекта, которые потенциально могут негативно повлиять на безопасность или основные права.

Для большей ясности категория высокого риска разделена на две подкатегории. В первой подкатегории основное внимание уделяется системам искусственного интеллекта, интегрированным в продукты, регулируемые законодательством ЕС о безопасности продукции, которое включает широкий спектр секторов, таких как игрушки, авиация и медицинское оборудование. Вторая подкатегория фокусируется на системах искусственного интеллекта, работающих в конкретных критических областях, требующих обязательной регистрации в базе данных ЕС.

Ограниченный риск: минимальная прозрачность для информированных решений пользователей

Системы искусственного интеллекта, отнесенные к категории ограниченного риска, должны соответствовать минимальным требованиям прозрачности, которые позволяют пользователям принимать обоснованные решения. В соответствии с ограниченными ограничениями риска пользователь должен быть уведомлен при взаимодействии с приложениями искусственного интеллекта, например, теми, которые генерируют или манипулируют изображением, аудио или видеоконтентом, например дипфейками. Стандарты прозрачности для ИИ с ограниченным риском направлены на достижение баланса между осведомленностью пользователей и беспрепятственным использованием приложений ИИ.

Общее назначение и генеративный искусственный интеллект: обеспечение прозрачности

Закон ЕС об искусственном интеллекте устанавливает четкие руководящие принципы для моделей искусственного интеллекта общего назначения и генеративных моделей, чтобы обеспечить прозрачность их работы. Сюда входят такие инструменты, как ChatGPT, которые обязаны раскрывать информацию о том, что их контент создан искусственным интеллектом, предотвращать создание незаконного контента и публиковать сводки данных, защищенных авторским правом, используемых для обучения.

Кроме того, высокоэффективные модели искусственного интеллекта общего назначения, такие как продвинутые модели, такие как GPT-4, должны пройти всестороннюю оценку. В случае серьезных инцидентов эти модели обязаны сообщать о таких происшествиях в Европейскую комиссию.

Разработка программного обеспечения, совместимого с искусственным интеллектом: ключевые соображения для бизнеса

Согласно выводам обзора MIT, Закон ЕС об искусственном интеллекте представляет собой инновационный законодательный акт, призванный смягчить любой потенциальный вред, который может возникнуть в результате использования искусственного интеллекта в зонах повышенного риска, тем самым защищая фундаментальные права людей. В частности, такие сектора, как здравоохранение, образование, пограничный контроль и государственные услуги, были определены в качестве приоритетных областей для защиты. Более того, закон прямо запрещает использование приложений искусственного интеллекта, которые представляют «неприемлемый риск».

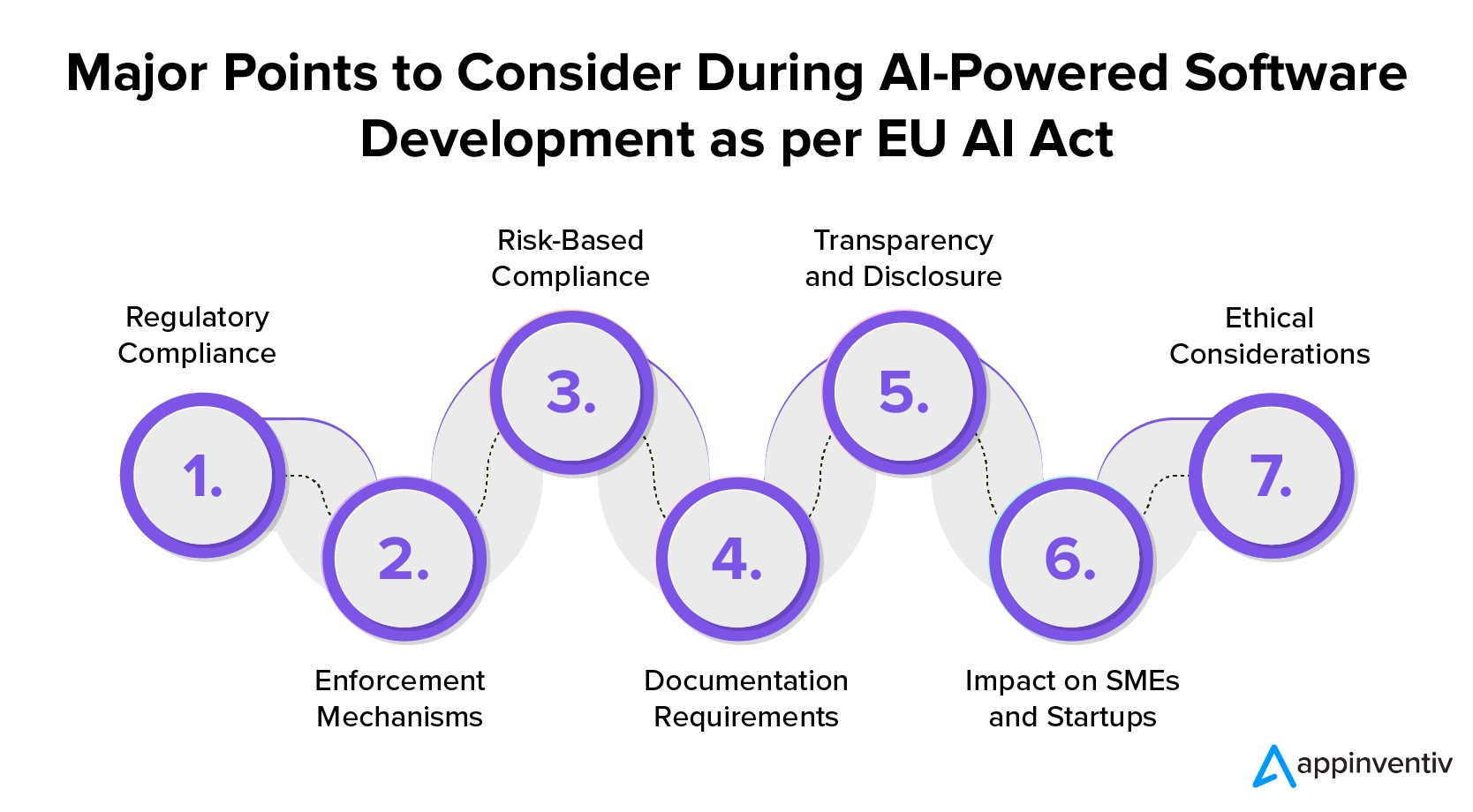

Объявленный в декабре 2023 года Закон ЕС об искусственном интеллекте является важным шагом на пути регулирования искусственного интеллекта в Европейском Союзе. Компании, желающие понять регулирование ИИ в разработке программного обеспечения, должны осознать его последствия и подготовиться к соблюдению требований. Вот ключевые моменты, которые следует учитывать компаниям, желающим инвестировать в услуги по разработке программного обеспечения, совместимого с искусственным интеллектом:

1. Соблюдение нормативных требований

Закон ЕС об искусственном интеллекте требует строгого соблюдения требований со стороны разработчиков программного обеспечения для искусственного интеллекта, устанавливая точные правила как для поставщиков, так и для пользователей. Чтобы обеспечить соблюдение этих правил, компании, стремящиеся инвестировать в разработку программного обеспечения на базе ИИ, должны строго соблюдать стандарты прозрачности и отчетности при выводе систем ИИ на рынок ЕС.

2. Механизмы обеспечения соблюдения

Закон включает в себя сильный механизм правоприменения и строгую структуру штрафов. Несоблюдение требований, особенно в случае серьезных нарушений AI, может привести к штрафам в размере до 7% мирового годового оборота. Это подчеркивает важность этической разработки ИИ и ответственного внедрения.

3. Соответствие требованиям, основанным на рисках

Когда компании решают использовать разработку программного обеспечения на основе искусственного интеллекта, они должны проводить оценку рисков. Это помогает классифицировать системы ИИ на основе потенциальных рисков, которые они могут представлять для безопасности человека и основных прав.

Системы искусственного интеллекта будут отнесены к категориям «неприемлемый», «высокий», «ограниченный» или «минимальный риск» с более строгими требованиями для групп повышенного риска.

Чтобы обеспечить соответствие ИИ в ЕС, предприятия должны классифицировать свои обязанности по соблюдению требований в соответствии с уровнем связанного с этим риска. Такой подход позволяет реализовать соответствующие меры для разных типов систем ИИ. Предприятия должны участвовать в этом процессе, чтобы снизить потенциальные риски и обеспечить ответственное использование ИИ.

4. Требования к документации

Компании, разрабатывающие программное обеспечение на основе искусственного интеллекта, обязаны поддерживать актуальность технической документации и записей для своих систем. Эта документация жизненно важна для обеспечения общей прозрачности и демонстрации соблюдения нормативных стандартов.

5. Прозрачность и раскрытие информации

Разработчики программного обеспечения, нанятые предприятиями, должны соблюдать различные обязательства по прозрачности в зависимости от уровня риска системы искусственного интеллекта. Для систем искусственного интеллекта высокого риска необходима регистрация в базе данных ЕС. Кроме того, предприятия должны информировать пользователей и получать их согласие на использование конкретных приложений ИИ, таких как распознавание эмоций или биометрическая категоризация.

6. Влияние на МСП и стартапы

Для поддержки малого бизнеса Закон ЕС об искусственном интеллекте ограничивает штрафы для малых и средних предприятий (МСП) и стартапов. Это отражает разнообразный характер бизнеса в сфере ИИ и способствует соблюдению правил.

7. Этические соображения

В этой системе особое внимание уделяется этическим соображениям, требующим от предприятий балансировать между использованием потенциала ИИ и снижением его рисков. Закон ЕС об искусственном интеллекте направлен на наказание за несоблюдение требований и поощрение соблюдения высоких стандартов безопасности.

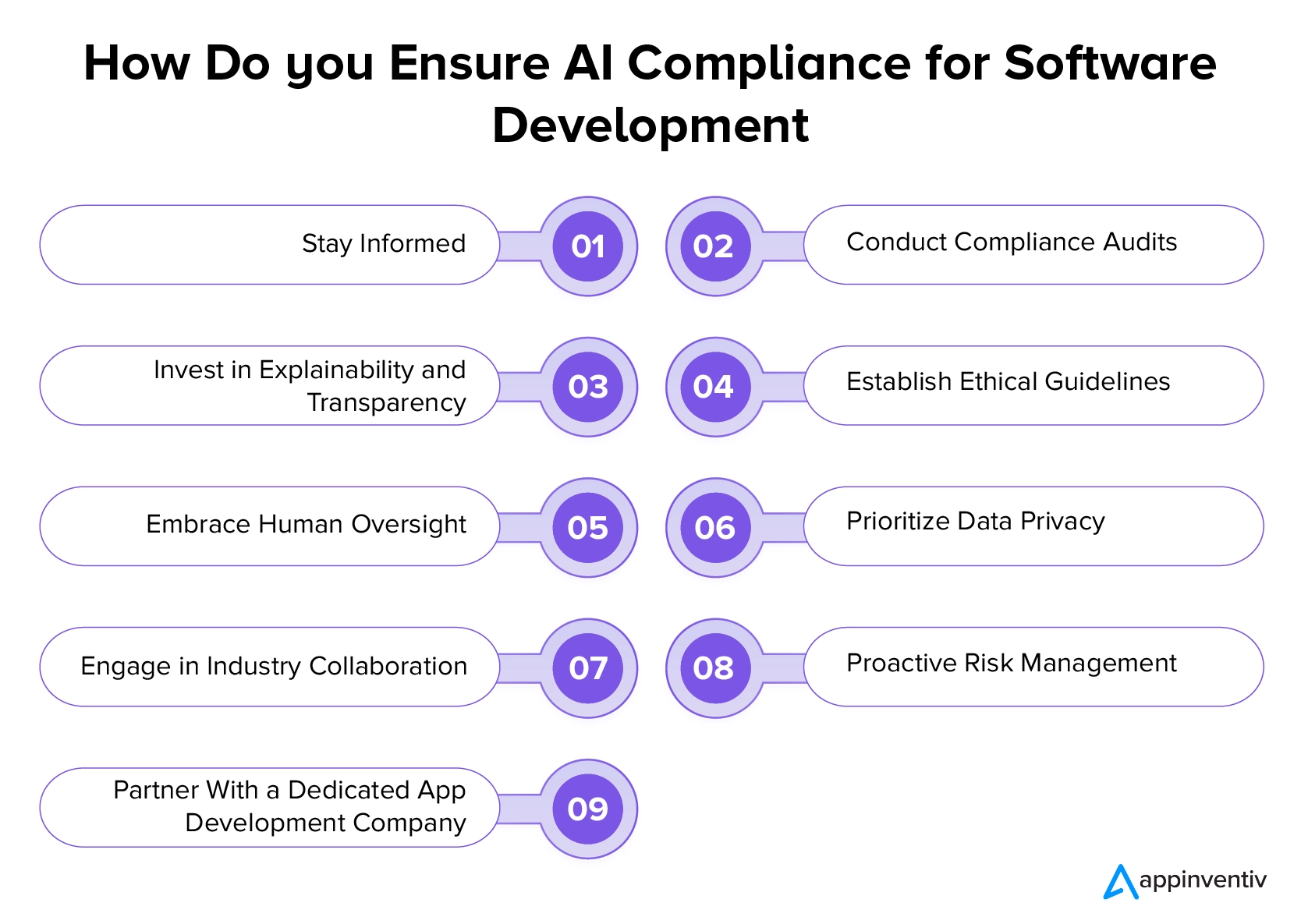

Как добиться успеха в эпоху регулирования искусственного интеллекта в ЕС: лучшие практики обеспечения соответствия

Закон ЕС об искусственном интеллекте и другие нормативные акты существенно меняют ландшафт развития ИИ, отдавая приоритет этике, прозрачности и благополучию пользователей. Хотя перспектива адаптации к этим изменениям может вызвать некоторые проблемы при разработке ИИ, компании могут ориентироваться в этой новой сфере, следуя передовым практикам, упомянутым ниже, и сотрудничая с профессиональной фирмой по разработке программного обеспечения.

В курсе

Предприятия должны быть в курсе последних изменений в правилах ИИ, включая поправки и обновления. Крайне важно регулярно следить за регулирующими органами, официальными публикациями и обновлениями отрасли, чтобы быть в курсе любых изменений, которые могут повлиять на инициативы в области ИИ. Оставаясь в курсе требований регулирования ИИ в сфере разработки программного обеспечения, компании могут активно адаптировать свои стратегии и обеспечить соблюдение развивающихся правил.

Проведение аудита соответствия

Предприятия должны регулярно проводить аудит своих систем и процессов искусственного интеллекта, чтобы обеспечить соблюдение существующих правил. Важно оценить прозрачность, справедливость и подотчетность алгоритмов ИИ. Это включает в себя выявление и устранение любых потенциальных предубеждений или рисков, связанных с вашими приложениями ИИ. Проводя такие проверки, предприятия могут смягчить любые потенциальные юридические или этические проблемы, которые могут возникнуть.

Читайте также: Предотвращение коллапса модели ИИ: устранение неотъемлемого риска синтетических наборов данных

Инвестируйте в понятность и прозрачность

Предприятиям рекомендуется уделять приоритетное внимание прозрачности и объяснимости в своих системах искусственного интеллекта. Им следует внедрять решения, которые обеспечивают четкое представление о том, как их алгоритмы ИИ принимают решения. Это соответствует нормативным требованиям и способствует доверию между пользователями и заинтересованными сторонами.

Установите этические принципы

Предприятия должны уделять приоритетное внимание разработке и внедрению четких этических принципов для своих проектов в области искусственного интеллекта. Эти руководящие принципы должны конкретно учитывать важные этические соображения, такие как справедливость, конфиденциальность и более широкое влияние ИИ на общество. Надежные этические стандарты обеспечивают ответственную разработку ИИ, вызывают доверие среди пользователей и заинтересованных сторон и соответствуют нормативным требованиям.

Примите человеческий надзор

Компании должны подчеркивать важность человеческого контроля за процессами ИИ, особенно в приложениях с высоким уровнем риска. Интеграция человеческого контроля и принятия решений имеет важное значение для повышения подотчетности и снижения потенциальных рисков, связанных с полностью автоматизированными системами искусственного интеллекта.

Уделяйте приоритетное внимание конфиденциальности данных

Предприятия должны придерживаться надежных методов обеспечения конфиденциальности данных, которые соответствуют таким правилам, как GDPR. При разработке программного обеспечения на базе искусственного интеллекта они должны обязательно внедрить безопасные протоколы обработки, хранения и обработки данных, чтобы защитить права на конфиденциальность лиц, чьи данные используются системами искусственного интеллекта. Такая приверженность конфиденциальности данных обеспечивает соблюдение требований законодательства и укрепляет доверие пользователей.

Участвуйте в отраслевом сотрудничестве

Компании, которые хотят инвестировать в услуги по разработке программного обеспечения, совместимого с ИИ, должны активно участвовать в отраслевом сотрудничестве, форумах и дискуссиях, посвященных регулированию ИИ. Взаимодействуя с коллегами и отраслевыми экспертами, они могут получить ценную информацию и внести свой вклад в разработку лучших практик развития.

Проактивное управление рисками

Предприятиям следует внедрять стратегии упреждающего управления рисками для выявления и смягчения потенциальных рисков, связанных с приложениями ИИ. Регулярно проводите тщательную оценку рисков и разрабатывайте планы решения непредвиденных проблем.

Партнер со специализированной компанией по разработке программного обеспечения

Одна из наиболее важных вещей, которые предприятия могут сделать для процветания в соответствии с новым регулированием и соблюдением требований ЕС в области ИИ, — это партнерство с фирмой, которая предлагает профессиональные услуги по разработке ИИ. Обращение за советом к преданным своему делу профессионалам гарантирует, что их инициативы в области искусственного интеллекта будут соответствовать законодательству.

Профессиональные компании, которые хорошо разбираются в руководящих принципах ЕС по разработке ИИ, могут предоставить конкретные советы, адаптированные к их бизнесу, помогая им ориентироваться в сложной нормативной среде и снижать связанные с ней юридические риски.

Как Appinventiv может стать вашим идеальным партнером в реализации нового закона ЕС об искусственном интеллекте для рационализации развития?

Мы надеемся, что наш блог помог вам разобраться в тонкостях регулирования ИИ в ЕС. Наша команда опытных разработчиков ИИ обладает богатым опытом, обеспечивая создание передовых решений ИИ, соответствующих новейшим нормативным стандартам. Мы стремимся оставаться на переднем крае технологий, гарантируя, что ваши приложения не только инновационные, но и полностью соответствуют Закону ЕС об искусственном интеллекте.

Как специализированная компания по разработке приложений искусственного интеллекта, мы хорошо разбираемся в требованиях, руководящих принципах прозрачности и сроках соответствия, указанных в нормативной базе. Это позволяет нам вести ваши проекты искусственного интеллекта в соответствии со строгими стандартами ЕС.

Свяжитесь с нашими экспертами, чтобы начать путь разработки искусственного интеллекта, который органично объединяет инновации и соответствие требованиям.

Часто задаваемые вопросы

Вопрос. Как GDPR влияет на разработку и использование ИИ в ЕС?

О. Общий регламент по защите данных (GDPR) существенно влияет на разработку и использование ИИ в ЕС. В нем особое внимание уделяется защите личных данных, обеспечению прозрачности и повышению подотчетности в приложениях искусственного интеллекта. Чтобы решить проблемы, связанные с алгоритмической предвзятостью, соответствие GDPR требует внедрения оценки воздействия на защиту данных (DPIA) для проектов ИИ.

Вопрос. Существуют ли в ЕС отраслевые правила ИИ, например, в здравоохранении или финансах?

A. Регламент ЕС по искусственному интеллекту служит комплексной основой для регулирования систем искусственного интеллекта высокого риска. Однако в отдельных секторах могут действовать дополнительные правила, адаптированные к их уникальным задачам и требованиям. Например, в отрасли здравоохранения могут действовать дополнительные правила, обеспечивающие этичное и ответственное использование ИИ в медицинских целях. Аналогичным образом, финансовый сектор может иметь конкретные рекомендации по применению ИИ в финансовых услугах. Предприятия должны знать как общие правила в области искусственного интеллекта, такие как Закон ЕС об искусственном интеллекте, так и любые отраслевые правила, применимые к их сфере деятельности.

Вопрос. Какие соображения следует учитывать генеральным директорам и техническим директорам при разработке продуктов искусственного интеллекта в соответствии с правилами ЕС?

О. Чтобы соответствовать правилам ЕС в отношении искусственного интеллекта, генеральные директора и технические директора должны в первую очередь уделять первоочередное внимание информированию о последнем законе. Крайне важно обеспечить соответствие руководящим принципам прозрачности и срокам их соблюдения. В дополнение к этому, этические принципы, прозрачность, человеческий надзор, практика конфиденциальности данных, управление рисками, юридические консультации и активное участие в отраслевом сотрудничестве — все это важные элементы для разработки стратегий искусственного интеллекта, соответствующих нормативным требованиям и этическим стандартам ЕС.