Regulación y cumplimiento de la IA en la UE: trazado del panorama legal para el desarrollo de software

Publicado: 2024-02-12La inteligencia artificial (IA) está cambiando rápidamente la forma en que opera nuestro mundo, dejando un impacto significativo en varios sectores. Desde ofrecer atención médica personalizada hasta optimizar la logística y las cadenas de suministro, la tecnología ya ha demostrado sus capacidades en todas las industrias.

Al llegar a los mercados europeos, el potencial de la IA es particularmente prometedor, ya que los países y las empresas están adoptando rápidamente el desarrollo de software impulsado por la IA para impulsar la innovación, el crecimiento y el bienestar social.

Sin embargo, junto con el entusiasmo, existen importantes desafíos que abordar. Las preocupaciones sobre los sesgos de los algoritmos, su transparencia y el posible desplazamiento laboral han planteado múltiples cuestiones éticas y sociales que requieren una cuidadosa consideración. Es fundamental equilibrar el aprovechamiento de su potencial y la mitigación de sus riesgos para navegar eficazmente en el panorama de la IA.

En particular, la Unión Europea ha modificado recientemente la Ley de IA, enfatizando la importancia de la regulación de la IA de la UE. Para las empresas que buscan sumergirse en el mercado de desarrollo de software en Europa, comprender y cumplir estas regulaciones ya no es una opción, sino una parte esencial del negocio.

Este blog le ayudará a comprender todo lo relacionado con la intersección de la inteligencia artificial y el desarrollo de software, destacando el panorama cambiante de la regulación de la IA en la UE. Además de esto, también profundizaremos en la importancia de cumplir con los estándares regulatorios gubernamentales de IA.

Entonces, sin más preámbulos, pasemos a los detalles cruciales.

Importancia de la regulación de la IA en la UE

La Unión Europea (UE) está adoptando una postura proactiva en materia de regulación y cumplimiento en un mundo dominado por software impulsado por inteligencia artificial. Al reconocer los posibles beneficios y riesgos de esta potente tecnología, la UE pretende establecer un marco sólido respaldado por prácticas éticas, transparencia y un despliegue responsable. Comprender la importancia del cumplimiento de la IA en el desarrollo de software es crucial por varias razones:

Formando confianza

El cumplimiento de la IA en la UE tiene como objetivo generar confianza entre los usuarios, las empresas y las partes interesadas garantizando que los sistemas de IA se desarrollen y utilicen de forma ética. Esta confianza es esencial para la adopción generalizada y el desarrollo continuo de soluciones de IA.

Mitigar los riesgos éticos

El potencial de prejuicios, discriminación y otras preocupaciones éticas crece a medida que la IA se integra cada vez más en la vida diaria. Las regulaciones de la UE guían para mitigar estos riesgos y garantizar que los sistemas de IA se utilicen de manera justa y responsable.

Cumplimiento y sostenibilidad

La UE tiene como objetivo crear un ecosistema de IA sostenible y responsable mediante el establecimiento de requisitos de cumplimiento claros. Esto ayuda a las empresas a gestionar riesgos, fortalecer la ciberseguridad y fomentar la transparencia. En última instancia, comprender la importancia del cumplimiento de la IA ayuda a las empresas a gestionar los problemas legales y promueve el desarrollo y la implementación responsable de la IA.

El cumplimiento de la IA en la UE no es sólo una obligación legal para las empresas, sino también una inversión estratégica para el éxito a largo plazo y el impacto positivo de la IA en la sociedad. Al adherirse a la regulación de la IA en la UE, las empresas pueden contribuir a construir un futuro en el que sus soluciones impulsadas por la IA beneficien a todos de forma ética y sostenible.

Para asegurarse de que un sistema de IA siga las reglas, debe someterse a una evaluación de conformidad. Una vez aprobado, se registra en la base de datos de la UE y recibe una marca CE (Conformidad Europea) para demostrar que cumple con los estándares antes de ser permitido en el mercado. Si hay grandes cambios en el sistema, como entrenarlo con nuevos datos o agregar o eliminar funciones, debe pasar por una nueva evaluación para asegurarse de que aún sigue las reglas antes de poder certificarlo nuevamente y volver a colocarlo en la base de datos.

El Reglamento de IA de la UE: Navegando por el panorama regulatorio para el desarrollo de software impulsado por IA

La Unión Europea ha implementado varias regulaciones clave que impactan significativamente el campo de la inteligencia artificial. La regulación de la IA en el desarrollo de software está diseñada para garantizar un desarrollo ético de la IA que sea capaz de proteger la privacidad de las personas y mitigar los riesgos potenciales. Examinemos algunos cumplimientos clave de la UE para el desarrollo de la IA.

1. Reglamento General de Protección de Datos (RGPD)

El Reglamento General de Protección de Datos (GDPR) es un factor crucial a la hora de dar forma al panorama de la inteligencia artificial en la Unión Europea. Se centra en la protección de datos personales y aplica medidas estrictas para garantizar la transparencia y la responsabilidad en las aplicaciones de IA.

Además de esto, el RGPD también aborda el sesgo algorítmico, enfatizando la importancia de sistemas de IA justos e imparciales. El reglamento requiere el uso de Evaluaciones de Impacto de la Protección de Datos (DPIA) para proyectos de IA, que evalúan los riesgos potenciales y las implicaciones para la privacidad. Este marco regulatorio integral tiene como objetivo establecer una base sólida para el desarrollo ético y responsable de la IA dentro de la UE.

2. Ley de Inteligencia Artificial

La Ley de Inteligencia Artificial es un marco integral que rige los sistemas de IA de alto riesgo. Describe los requisitos de transparencia, explicabilidad y supervisión humana. Esta estructura regulatoria tiene como objetivo promover el desarrollo y la implementación de IA responsable y explicable.

Las empresas que desarrollan software impulsado por IA deben cumplir con el cumplimiento de la IA en el desarrollo de software y sus implicaciones, incluidos los plazos de cumplimiento y las consideraciones prácticas. Al establecer criterios de transparencia y supervisión, la Ley logra un equilibrio entre el fomento de la innovación y la protección de los derechos fundamentales. Allana el camino para prácticas éticas de IA en la Unión Europea.

3. Directiva sobre responsabilidad del producto

La Directiva sobre responsabilidad de productos es un marco integral que prioriza la seguridad de los productos de IA y el bienestar de los usuarios finales. Asigna a los desarrolladores la responsabilidad de gestionar los riesgos potenciales asociados con los productos de IA, enfatizando la necesidad de un enfoque proactivo para la seguridad de los productos.

La directiva alienta a los desarrolladores asociados con el desarrollo de productos a explorar estrategias de gestión de riesgos para mejorar los estándares generales de seguridad de los productos de IA. Al adherirse a estas medidas, los desarrolladores pueden contribuir a la creación de un panorama de IA seguro y fiable dentro de la Unión Europea.

Al comprender de manera integral la regulación de la IA en la UE, las empresas pueden navegar por el panorama cambiante del desarrollo de la IA, garantizando el cumplimiento, las prácticas éticas y el despliegue responsable de las tecnologías de IA.

Navegando por el espectro de riesgos: comprensión de las categorías de riesgos en la nueva ley de IA de la UE

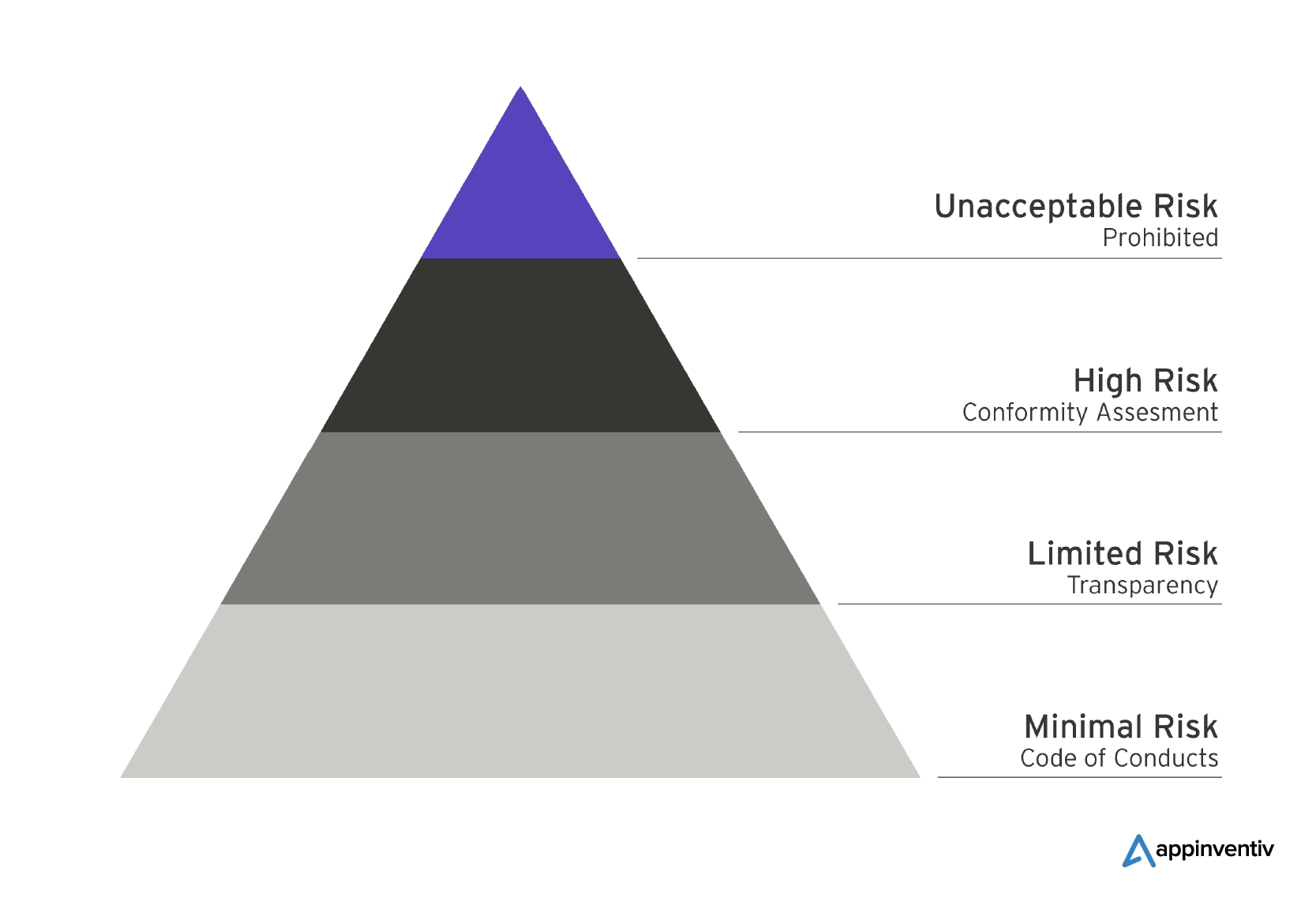

Según el Parlamento Europeo, el objetivo principal es garantizar la seguridad, la transparencia, la trazabilidad, la no discriminación y la sostenibilidad ambiental de los sistemas de IA utilizados en la UE. Así, han establecido reglas diferenciadas en función del nivel de riesgo asociado a los sistemas de IA. Veamos las múltiples categorías en detalle a continuación:

Riesgo inaceptable: prohibir los sistemas de inteligencia artificial amenazantes

Los sistemas de IA que entran en la categoría de riesgo inaceptable se consideran amenazas directas a las personas y se enfrentarán a una prohibición total según la nueva Ley de IA de la UE. Por ejemplo, la manipulación cognitivo-conductual, la puntuación social y la identificación biométrica son algunos de los ejemplos de actividades que entran en esta categoría prohibida. Es posible que se permitan algunas excepciones para aplicaciones específicas de aplicación de la ley, que estarán sujetas a condiciones estrictas, particularmente en el caso de sistemas de identificación biométrica en tiempo real.

Alto Riesgo: Salvaguardar la Seguridad y los Derechos Fundamentales

La categoría de alto riesgo descrita en la Ley de IA de la UE sirve como medida de protección para garantizar la seguridad y la preservación de los derechos fundamentales al implementar inteligencia artificial. Esta categoría abarca los sistemas de IA que poseen el potencial de impactar negativamente la seguridad o los derechos fundamentales.

Para mayor claridad, la categoría de alto riesgo se divide en dos subcategorías. La primera subcategoría se centra en los sistemas de IA integrados en productos regidos por la legislación de seguridad de productos de la UE, que incluye una amplia gama de sectores como juguetes, aviación y dispositivos médicos. La segunda subcategoría se centra en los sistemas de IA que operan en áreas críticas específicas, lo que requiere un registro obligatorio en una base de datos de la UE.

Riesgo limitado: transparencia mínima para decisiones de usuario informadas

Los sistemas de IA clasificados como de riesgo limitado deben cumplir con requisitos mínimos de transparencia que permitan a los usuarios tomar decisiones informadas. Según las restricciones de riesgo limitado, se debe notificar al usuario cuando interactúa con aplicaciones de inteligencia artificial, como aquellas que generan o manipulan contenido de imagen, audio o video, como los deepfakes. Los estándares de transparencia para la IA de riesgo limitado se centran en lograr un equilibrio entre la conciencia del usuario y el uso fluido de las aplicaciones de IA.

Propósito general e IA generativa: garantizar la transparencia

La Ley de IA de la UE establece directrices claras para los modelos de IA generativos y de propósito general para garantizar la transparencia en sus operaciones. Esto incluye herramientas como ChatGPT, que deben revelar que su contenido es generado por IA, evitar la generación de contenido ilegal y publicar resúmenes de los datos protegidos por derechos de autor utilizados para la capacitación.

Además, los modelos de IA de propósito general de alto impacto, como los modelos avanzados como GPT-4, deben someterse a evaluaciones exhaustivas. En caso de incidentes graves, estos modelos están obligados a informar de ello a la Comisión Europea.

Desarrollo de software compatible con IA: consideraciones clave para las empresas

Según las conclusiones de la revisión del MIT, la Ley de IA de la UE es una legislación innovadora diseñada para mitigar cualquier daño potencial que pueda surgir del uso de la IA en áreas de alto riesgo, salvaguardando así los derechos fundamentales de las personas. Específicamente, sectores como la salud, la educación, la vigilancia fronteriza y los servicios públicos han sido identificados como áreas prioritarias de protección. Además, la ley prohíbe explícitamente el uso de aplicaciones de inteligencia artificial que representen un "riesgo inaceptable".

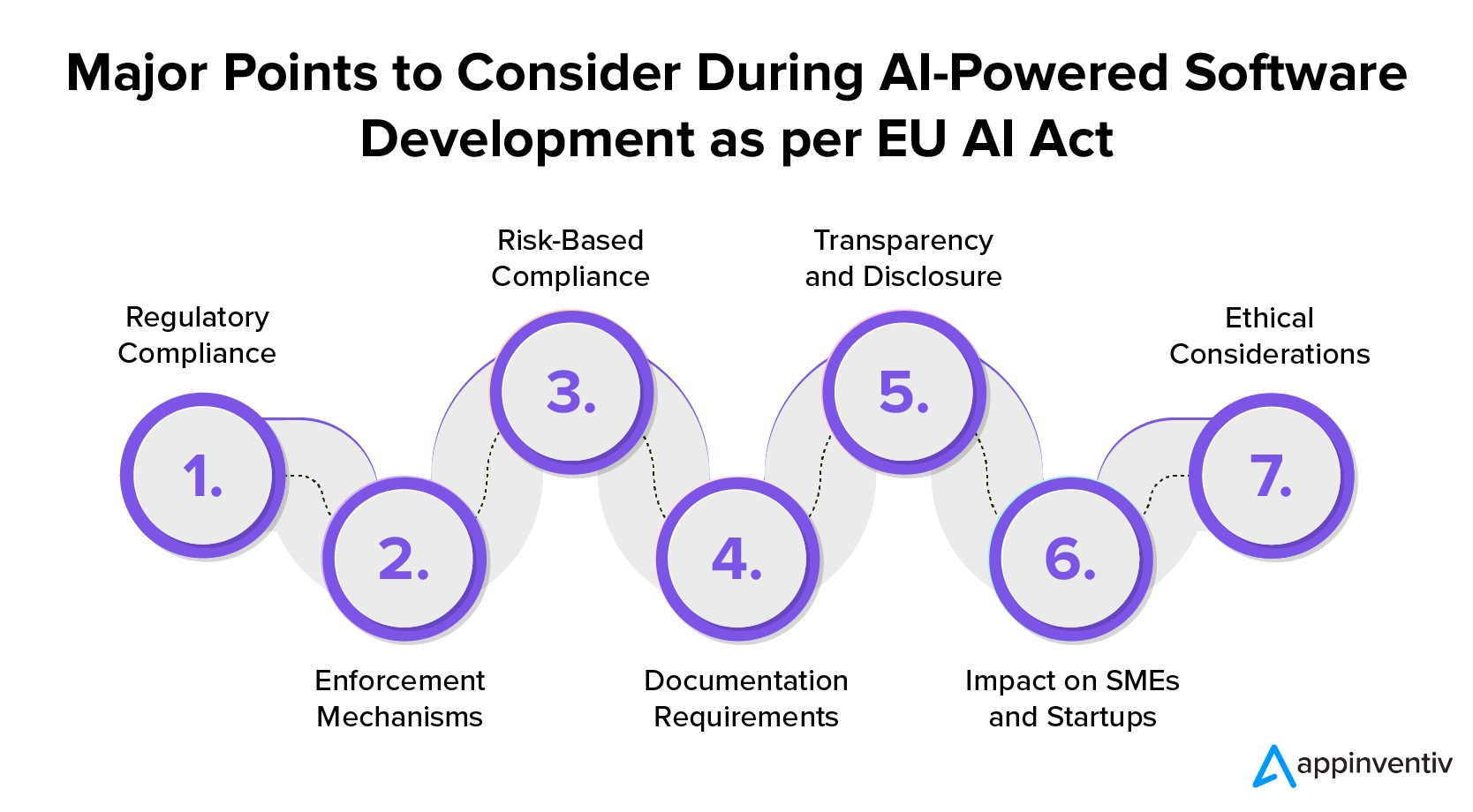

Anunciada en diciembre de 2023, la Ley de IA de la UE es un paso crucial hacia la regulación de la inteligencia artificial en la Unión Europea. Las empresas que quieran comprender la regulación de la IA en el desarrollo de software deben comprender sus implicaciones y prepararse para el cumplimiento. Estos son los puntos clave que deben considerar las empresas que deseen invertir en servicios de desarrollo de software compatibles con IA:

1. Cumplimiento normativo

La Ley de IA de la UE exige un cumplimiento estricto por parte de los desarrolladores de software de IA, estableciendo regulaciones precisas tanto para los proveedores como para los usuarios. Para garantizar el cumplimiento de estas regulaciones, las empresas que deseen invertir en el desarrollo de software basado en IA deben cumplir estrictamente con los estándares de transparencia y presentación de informes al introducir sistemas de IA en el mercado de la UE.

2. Mecanismos de aplicación

La Ley incluye un fuerte mecanismo de aplicación y una estricta estructura de multas. El incumplimiento, especialmente en casos de violaciones graves de la IA, puede dar lugar a multas de hasta el 7% de la facturación anual mundial. Esto destaca la importancia del desarrollo ético de la IA y su implementación responsable.

3. Cumplimiento basado en riesgos

Cuando las empresas optan por utilizar el desarrollo de software impulsado por IA, deben realizar evaluaciones de riesgos. Estos ayudan a clasificar los sistemas de IA en función de los riesgos potenciales que pueden representar para la seguridad humana y los derechos fundamentales.

Los sistemas de IA se clasificarán en categorías de “inaceptable”, “alto”, “limitado” o “riesgo mínimo” con requisitos más estrictos para los grupos de mayor riesgo.

Para garantizar el cumplimiento de la IA en la UE, las empresas deben clasificar sus obligaciones de cumplimiento según el nivel de riesgo involucrado. Este enfoque permite la implementación de medidas apropiadas para diferentes tipos de sistemas de IA. Las empresas deben participar en este proceso para mitigar los riesgos potenciales y garantizar el uso responsable de la IA.

4. Requisitos de documentación

Las empresas que desarrollan software basado en IA deben mantener documentación y registros técnicos actualizados para sus sistemas. Esta documentación es vital para la transparencia general y para demostrar el cumplimiento de los estándares regulatorios.

5. Transparencia y Divulgación

Los desarrolladores de software contratados por las empresas deben cumplir con distintas obligaciones de transparencia según el nivel de riesgo del sistema de inteligencia artificial. Para los sistemas de IA de alto riesgo, se requiere el registro en la base de datos de la UE. Además, las empresas deben informar a los usuarios y obtener su consentimiento para aplicaciones específicas de IA, como el reconocimiento de emociones o la categorización biométrica.

6. Impacto en las pymes y las startups

Para apoyar a las empresas más pequeñas, la Ley de IA de la UE limita las multas para las pequeñas y medianas empresas (PYME) y las nuevas empresas. Esto refleja la naturaleza variada de los negocios de IA y promueve el cumplimiento de las regulaciones.

7. Consideraciones éticas

El marco enfatiza consideraciones éticas, lo que requiere que las empresas equilibren el aprovechamiento del potencial de la IA y la mitigación de sus riesgos. La Ley de IA de la UE tiene como objetivo penalizar el incumplimiento y fomentar el cumplimiento de altos estándares de seguridad.

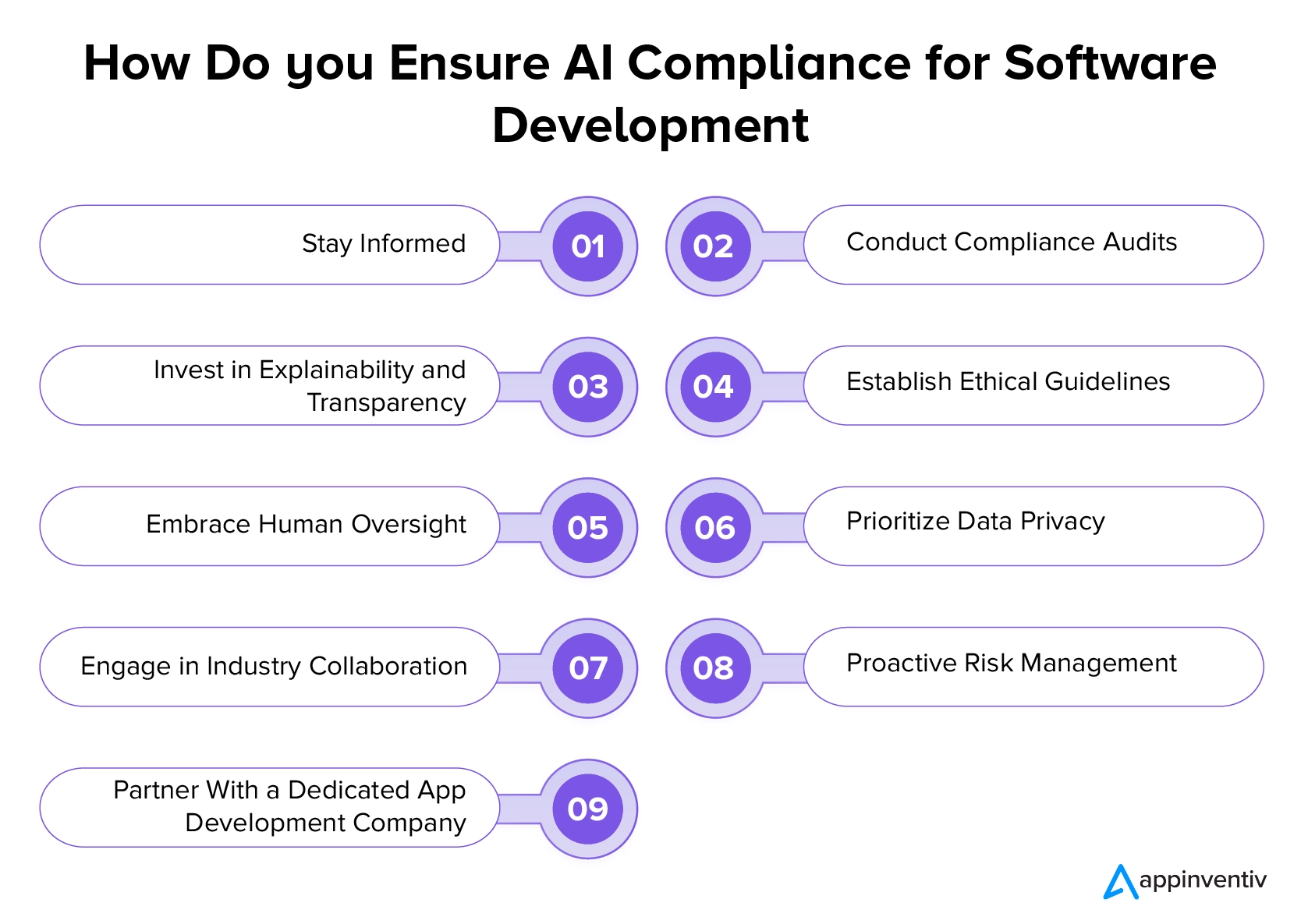

Cómo prosperar en la era de la regulación de la IA de la UE: mejores prácticas para garantizar el cumplimiento

La Ley de Inteligencia Artificial de la UE y otras regulaciones cambian significativamente el panorama del desarrollo de la IA, priorizando la ética, la transparencia y el bienestar de los usuarios. Si bien la perspectiva de adaptarse a estos cambios puede causar algunos desafíos en el desarrollo de la IA, las empresas pueden navegar por este nuevo terreno siguiendo las mejores prácticas que se mencionan a continuación y colaborando con una empresa de desarrollo de software profesional.

Mantente informado

Las empresas deben mantenerse informadas sobre los últimos avances en las regulaciones de IA, incluidas modificaciones y actualizaciones. Es fundamental monitorear periódicamente a las autoridades reguladoras, las publicaciones oficiales y las actualizaciones de la industria para garantizar el conocimiento de cualquier cambio que pueda afectar las iniciativas de IA. Al mantenerse actualizadas con la regulación de la IA en el desarrollo de software, las empresas pueden adaptar sus estrategias de manera proactiva y garantizar el cumplimiento de las regulaciones en evolución.

Realizar auditorías de cumplimiento

Las empresas deben realizar auditorías periódicas de sus sistemas y procesos de inteligencia artificial para garantizar el cumplimiento de las regulaciones existentes. Es importante evaluar la transparencia, la equidad y la responsabilidad de los algoritmos de IA. Esto incluye identificar y abordar cualquier posible sesgo o riesgo asociado con sus aplicaciones de IA. Al realizar estas auditorías, las empresas pueden mitigar cualquier posible problema legal o ético que pueda surgir.

Lea también: Prevención del colapso del modelo de IA: abordar el riesgo inherente de los conjuntos de datos sintéticos

Invierta en explicabilidad y transparencia

Se recomienda a las empresas que prioricen la transparencia y la explicabilidad en sus sistemas de IA. Deben implementar soluciones que permitan una comunicación clara de cómo sus algoritmos de IA toman decisiones. Esto se alinea con los requisitos regulatorios y fomenta la confianza entre los usuarios y las partes interesadas.

Establecer pautas éticas

Las empresas deben priorizar el desarrollo e implementación de directrices éticas claras para sus proyectos de IA. Estas directrices deben abordar específicamente consideraciones éticas críticas, como la equidad, la privacidad y el impacto social más amplio de la IA. Los sólidos estándares éticos garantizan el desarrollo responsable de la IA, infunden confianza entre los usuarios y las partes interesadas y se alinean con los requisitos reglamentarios.

Adopte la supervisión humana

Las empresas deberían enfatizar la importancia de la supervisión humana en los procesos de IA, particularmente en aplicaciones de alto riesgo. Integrar la revisión humana y la toma de decisiones es esencial para mejorar la rendición de cuentas y mitigar los riesgos potenciales vinculados a los sistemas de IA totalmente automatizados.

Priorizar la privacidad de los datos

Las empresas deben cumplir con prácticas sólidas de privacidad de datos que se alineen con regulaciones como GDPR. Al diseñar software impulsado por IA, deben asegurarse de implementar protocolos seguros de manejo, almacenamiento y procesamiento de datos para salvaguardar los derechos de privacidad de las personas cuyos datos son utilizados por los sistemas de IA. Este compromiso con la privacidad de los datos garantiza el cumplimiento de los requisitos legales y genera confianza con los usuarios.

Participar en la colaboración de la industria

Las empresas que deseen invertir en servicios de desarrollo de software compatibles con la IA deben participar activamente en colaboraciones, foros y debates de la industria centrados en la regulación de la IA. Al interactuar con pares y expertos de la industria, pueden obtener conocimientos valiosos y contribuir al desarrollo de mejores prácticas de desarrollo.

Gestión proactiva de riesgos

Las empresas deben implementar estrategias proactivas de gestión de riesgos para identificar y mitigar los riesgos potenciales asociados con las aplicaciones de IA. Realice periódicamente evaluaciones exhaustivas de riesgos y desarrolle planes para abordar desafíos imprevistos.

Asóciese con una empresa de desarrollo de software dedicada

Una de las cosas más importantes que pueden hacer las empresas para prosperar según la nueva regulación y el cumplimiento de la IA en la UE es asociarse con una empresa que ofrezca servicios profesionales de desarrollo de IA. Buscar orientación de profesionales dedicados garantiza que sus iniciativas de IA se alineen con el panorama legal.

Las empresas profesionales que conocen bien las directrices de la UE para el desarrollo de la IA pueden proporcionar asesoramiento específico adaptado a su negocio, ayudándoles a navegar por el complejo entorno regulatorio y mitigar los riesgos legales asociados con él.

¿Cómo puede Appinventiv ser su socio ideal en la gestión de la nueva Ley de IA de la UE para un desarrollo racionalizado?

Esperamos que nuestro blog le haya ayudado a comprender las complejidades relacionadas con la regulación de la IA en la UE. Nuestro equipo de desarrolladores experimentados de IA aporta una gran experiencia, lo que garantiza la creación de soluciones de IA de vanguardia que se alinean con los últimos estándares regulatorios. Estamos comprometidos a permanecer a la vanguardia de la tecnología, garantizando que sus aplicaciones no solo sean innovadoras sino que también cumplan plenamente con la Ley de IA de la UE.

Como empresa dedicada al desarrollo de aplicaciones de IA, conocemos bien los requisitos, las pautas de transparencia y los plazos de cumplimiento especificados en el marco regulatorio. Esto nos permite guiar sus proyectos de IA según los estrictos estándares de la UE.

Póngase en contacto con nuestros expertos para embarcarse en un viaje de desarrollo de IA que integre perfectamente la innovación y el cumplimiento.

Preguntas frecuentes

P. ¿Cómo afecta el RGPD al desarrollo y uso de la IA en la UE?

R. El Reglamento General de Protección de Datos (GDPR) afecta sustancialmente el desarrollo y el uso de la IA en la UE. Hace especial hincapié en salvaguardar los datos personales, garantizar la transparencia y promover la responsabilidad en las aplicaciones de IA. Para abordar las preocupaciones sobre el sesgo algorítmico, el cumplimiento del RGPD exige la implementación de Evaluaciones de Impacto de la Protección de Datos (DPIA) para proyectos de IA.

P. ¿Existen regulaciones de IA específicas para sectores en la UE, como la atención sanitaria o las finanzas?

R. El reglamento de IA de la UE sirve como un marco integral para regular los sistemas de IA de alto riesgo. Sin embargo, sectores específicos pueden tener regulaciones adicionales adaptadas a sus desafíos y requisitos únicos. Por ejemplo, la industria de la salud puede tener regulaciones adicionales para garantizar el uso ético y responsable de la IA en aplicaciones médicas. De manera similar, el sector financiero puede tener directrices específicas para las aplicaciones de IA en los servicios financieros. Las empresas deben conocer tanto las regulaciones generales de IA, como la Ley de IA de la UE, como cualquier regulación específica del sector que se aplique a su dominio.

P. ¿Qué consideraciones deberían tener en cuenta los directores ejecutivos y directores de tecnología al desarrollar productos de IA de conformidad con las regulaciones de la UE?

R. Para cumplir con las regulaciones de la UE sobre IA, los CEO y CTO deben priorizar primero mantenerse informados sobre la última ley. Es fundamental garantizar la alineación con las directrices de transparencia y los plazos de cumplimiento. Además de esto, las directrices éticas, la transparencia, la supervisión humana, las prácticas de privacidad de datos, la gestión de riesgos, la consulta legal y la participación activa en colaboraciones de la industria son elementos esenciales para desarrollar estrategias de IA que cumplan con los requisitos reglamentarios y los estándares éticos en la UE.