EU における AI 規制とコンプライアンス: ソフトウェア開発の法的状況の図表化

公開: 2024-02-12人工知能 (AI) は世界の運営方法を急速に変え、さまざまな分野に大きな影響を与えています。 パーソナライズされたヘルスケアの提供から物流やサプライチェーンの最適化まで、このテクノロジーはすでにあらゆる業界でその能力を実証しています。

欧州市場では、各国や企業がイノベーション、成長、社会福祉を促進するために AI を活用したソフトウェア開発を急速に受け入れており、AI の可能性は特に有望です。

ただし、興奮と同時に、対処すべき重要な課題もあります。 アルゴリズムの偏り、その透明性、潜在的な職の喪失に関する懸念により、慎重な検討が必要な複数の倫理的および社会的問題が生じています。 AI 環境を効果的にナビゲートするには、その可能性の活用とリスクの軽減のバランスをとることが重要です。

特に、欧州連合は最近 AI 法を改正し、EU AI 規制の重要性を強調しました。 ヨーロッパのソフトウェア開発市場への参入を検討している企業にとって、これらの規制を理解し、遵守することはもはやオプションではなく、ビジネスの不可欠な部分です。

このブログは、EU における AI 規制の進化する状況に焦点を当て、人工知能とソフトウェア開発の交差点に関連するすべてを理解するのに役立ちます。 これに加えて、政府の AI 規制基準を遵守することの重要性についても掘り下げていきます。

それでは、早速、重要な詳細に移りましょう。

EUにおけるAI規制の意義

欧州連合 (EU) は、AI を活用したソフトウェアが支配する世界において、規制とコンプライアンスに関して積極的な姿勢を取っています。 EU は、強力なテクノロジーの潜在的な利点とリスクを認識し、倫理慣行、透明性、責任ある展開に裏付けられた強固な枠組みを確立することを目指しています。 ソフトウェア開発における AI コンプライアンスの重要性を理解することは、次のような理由から非常に重要です。

建物の信頼

EU における AI コンプライアンスの目的は、AI システムが倫理的に開発および使用されることを保証することで、ユーザー、企業、利害関係者の間で信頼を築くことです。 この信頼は、AI ソリューションの広範な導入と継続的な開発にとって不可欠です。

倫理的リスクの軽減

AI が日常生活にますます統合されるにつれて、偏見、差別、その他の倫理的懸念が生じる可能性が高まります。 EU の規制は、これらのリスクを軽減し、AI システムが公正かつ責任を持って使用されることを保証するためのガイドです。

コンプライアンスと持続可能性

EU は、明確なコンプライアンス要件を確立することで、持続可能で責任ある AI エコシステムを構築することを目指しています。 これは、企業がリスクを管理し、サイバーセキュリティを強化し、透明性を促進するのに役立ちます。 最終的に、AI コンプライアンスの重要性を理解することは、企業が法的問題を管理し、AI の責任ある開発と展開を促進するのに役立ちます。

EU における AI コンプライアンスは、企業の法的義務であるだけでなく、AI の長期的な成功と社会へのプラスの影響への戦略的投資でもあります。 EU の AI 規制を遵守することで、企業は AI を活用したソリューションがすべての人に倫理的かつ持続的に利益をもたらす未来の構築に貢献できます。

AI システムがルールに従っていることを確認するには、適合性評価を受ける必要があります。 合格すると、EU データベースに登録され、市場での販売が許可される前に規格を満たしていることを示す CE (欧州適合性) マークが付与されます。 新しいデータでのトレーニングや機能の追加/削除など、システムに大きな変更があった場合は、再度認定されてデータベースに戻す前に、システムがルールに従っていることを確認するために新しい評価を受ける必要があります。

EU AI 規制: AI を活用したソフトウェア開発の規制状況をナビゲートする

欧州連合は、人工知能の分野に大きな影響を与えるいくつかの重要な規制を導入しました。 ソフトウェア開発における AI 規制は、個人のプライバシーを保護し、潜在的なリスクを軽減できる倫理的な AI 開発を保証するように設計されています。 AI 開発に関する主要な EU コンプライアンスをいくつか見てみましょう。

1. 一般データ保護規則 (GDPR)

一般データ保護規則 (GDPR) は、欧州連合における人工知能の状況を形成する上で重要な要素です。 個人データの保護に重点を置き、AI アプリケーションの透明性と説明責任を確保するための厳格な措置を実施しています。

これに加えて、GDPR はアルゴリズムのバイアスにも対処し、公平で偏りのない AI システムの重要性を強調しています。 この規制により、AI プロジェクトには潜在的なリスクとプライバシーへの影響を評価するデータ保護影響評価 (DPIA) の使用が義務付けられています。 この包括的な規制の枠組みは、EU 内で倫理的かつ責任ある AI 開発のための強力な基盤を確立することを目的としています。

2. 人工知能法

人工知能法は、高リスクの AI システムを管理する包括的な枠組みです。 透明性、説明可能性、人間による監視の要件を概説しています。 この規制構造は、責任があり説明可能な AI の開発と展開を促進することを目的としています。

AI を活用したソフトウェアを開発する企業は、ソフトウェア開発における AI コンプライアンスと、コンプライアンスのタイムラインや実際的な考慮事項を含むその影響を遵守する必要があります。 この法律は、透明性と監視の基準を確立することにより、イノベーションの促進と基本的権利の保護とのバランスをとります。 これにより、欧州連合における倫理的な AI 実践への道が開かれます。

3. 製造物責任指令

製造物責任指令は、AI 製品の安全性とエンドユーザーの幸福を優先する包括的な枠組みです。 これは、AI 製品に関連する潜在的なリスクを管理する責任を開発者に割り当て、製品の安全性に対する積極的なアプローチの必要性を強調しています。

この指令は、製品開発に関わる開発者に対し、AI 製品の全体的な安全基準を強化するためのリスク管理戦略を検討することを奨励しています。 これらの措置を遵守することで、開発者は欧州連合内での安全で信頼性の高い AI 環境の構築に貢献できます。

EU における AI 規制を包括的に理解することで、企業は AI 開発の進化する状況に対処し、コンプライアンス、倫理慣行、および AI テクノロジーの責任ある導入を確保できます。

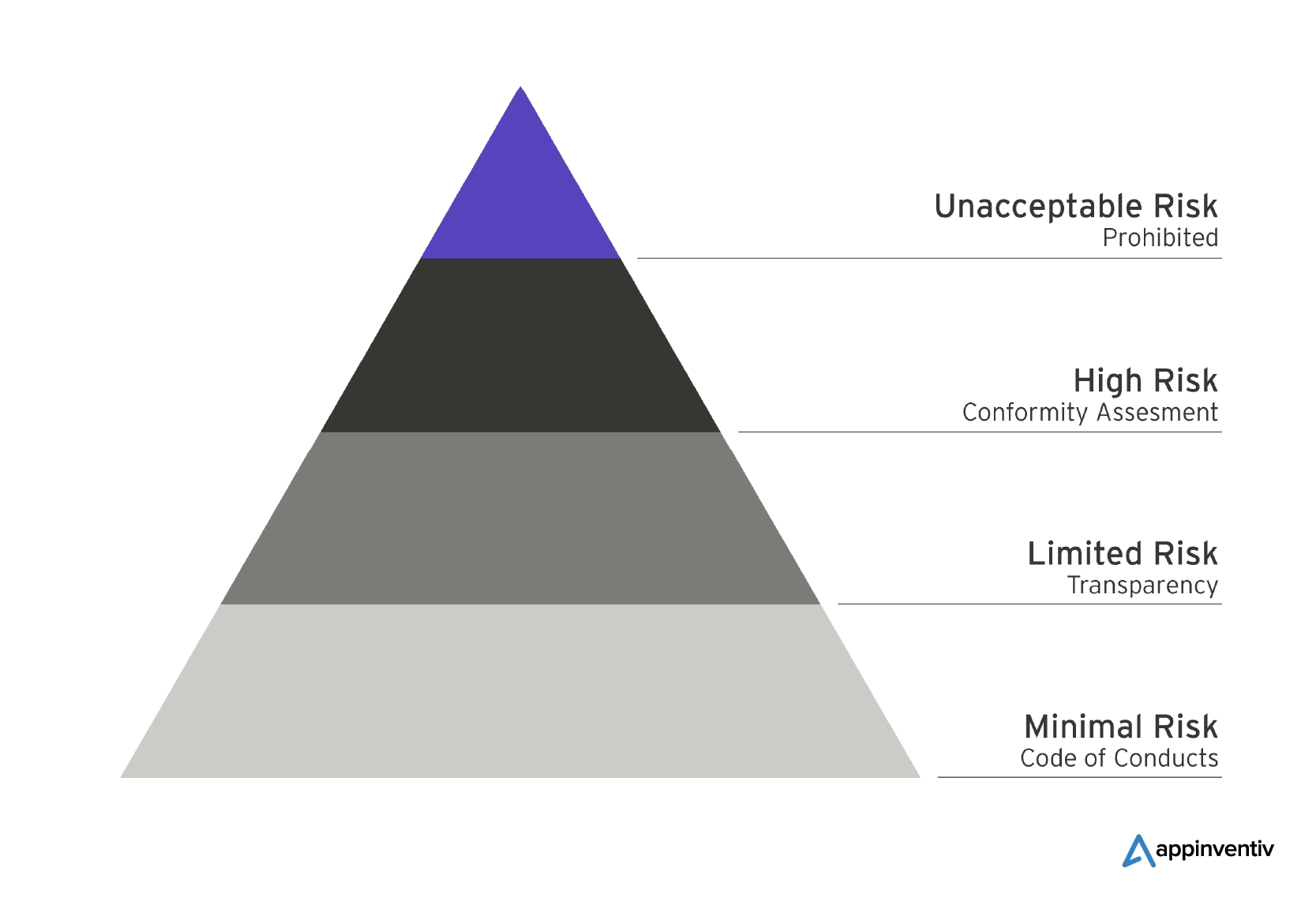

リスクの範囲をナビゲートする: 新しい EU AI 法におけるリスクのカテゴリーを理解する

欧州議会によると、主な目的は、EU 内で使用されている AI システムの安全性、透明性、トレーサビリティ、無差別、環境の持続可能性を確保することです。 したがって、AI システムに関連するリスクのレベルに基づいて差別化されたルールを確立しました。 以下で複数のカテゴリを詳しく見てみましょう。

容認できないリスク: 脅威となる AI システムの禁止

容認できないリスクのカテゴリーに分類される AI システムは、個人に対する直接的な脅威とみなされ、新しい EU AI 法に従って完全に禁止されることになります。 たとえば、認知行動操作、社会的スコアリング、生体認証などは、この禁止されたカテゴリに分類される活動の例です。 一部の例外は、特にリアルタイムの生体認証識別システムの場合、厳しい条件が適用される特定の法執行アプリケーションに対して許可される場合があります。

高リスク: 安全と基本的権利の保護

EU AI 法で概説されている高リスクのカテゴリーは、人工知能を導入する際の安全性と基本的権利の保護を確保するための保護措置として機能します。 このカテゴリには、安全性や基本的権利に悪影響を与える可能性のある AI システムが含まれます。

さらに明確にするために、高リスクのカテゴリは 2 つのサブカテゴリに分割されています。 最初のサブカテゴリは、玩具、航空、医療機器などの幅広い分野を含む、EU 製品安全法によって管理される製品に統合される AI システムに焦点を当てています。 2 番目のサブカテゴリは、特定の重要な領域で動作する AI システムに焦点を当てており、EU データベースへの登録が必須となります。

限定的なリスク: 情報に基づいたユーザーの意思決定に対する最小限の透明性

限定的リスクとして分類された AI システムは、ユーザーが情報に基づいた意思決定を行えるようにするための最小限の透明性要件に準拠する必要があります。 限られたリスク制約に従って、ディープフェイクなどの画像、音声、またはビデオ コンテンツを生成または操作する AI アプリケーションを操作するときは、ユーザーに通知する必要があります。 リスクが限定された AI の透明性基準は、ユーザーの認識と AI アプリケーションのシームレスな使用の間のバランスを取ることに重点を置いています。

汎用 AI と生成 AI: 透明性の確保

EU AI 法は、運用の透明性を確保するために、汎用 AI モデルと生成 AI モデルに関する明確なガイドラインを確立しています。 これには、コンテンツが AI によって生成されたものであることを開示すること、違法なコンテンツの生成を防止すること、トレーニングに使用される著作権で保護されたデータの概要を公開することが求められる ChatGPT などのツールが含まれます。

さらに、GPT-4 のような高度なモデルなど、影響力の高い汎用 AI モデルは、総合的な評価を受ける必要があります。 重大な事故が発生した場合、これらのモデルはそのような出来事を欧州委員会に報告する義務があります。

AI 準拠のソフトウェア開発 – ビジネスにおける重要な考慮事項

MIT のレビューからの洞察によると、EU AI 法は、リスクの高い分野で AI を使用することで生じる可能性のある潜在的な危害を軽減し、それによって個人の基本的権利を保護することを目的とした革新的な法律です。 具体的には、医療、教育、国境監視、公共サービスなどの部門が保護の優先分野として特定されています。 さらに、同法は「容認できないリスク」をもたらす AI アプリケーションの使用を明確に禁止しています。

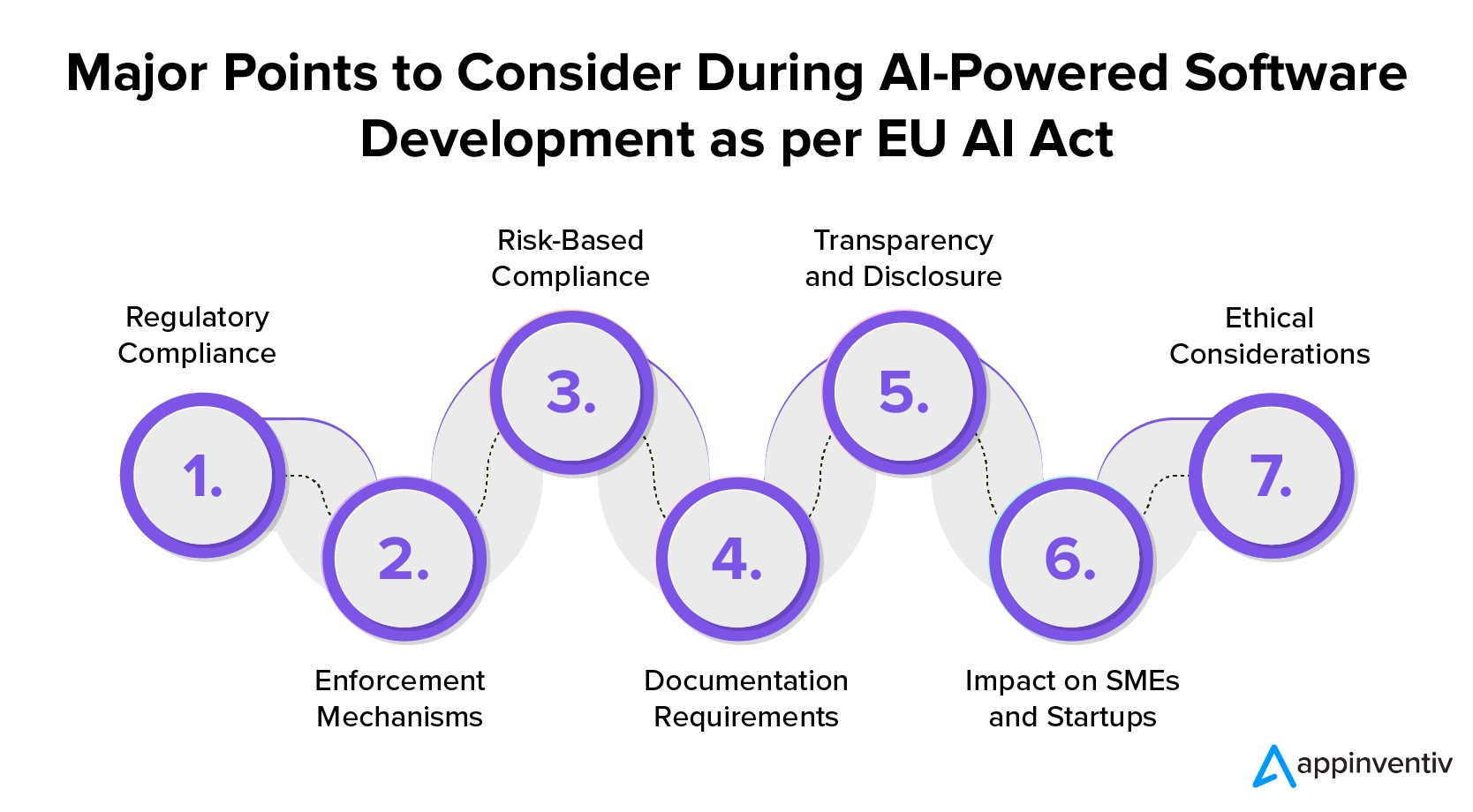

2023 年 12 月に発表された EU AI 法は、欧州連合における人工知能の規制に向けた重要な一歩です。 ソフトウェア開発における AI 規制を理解しようとしている企業は、その影響を理解し、コンプライアンスに備える必要があります。 AI 準拠のソフトウェア開発サービスへの投資を検討している企業が考慮すべき重要なポイントは次のとおりです。

1. 規制の遵守

EU AI 法は、プロバイダーとユーザーの両方に対して正確な規制を定め、AI ソフトウェア開発者に厳格な遵守を義務付けています。 これらの規制を確実に遵守するために、AI を活用したソフトウェア開発への投資を目指す企業は、AI システムを EU 市場に導入する際に透明性と報告基準を厳格に遵守する必要があります。

2. 執行メカニズム

この法律には、強力な執行メカニズムと厳格な罰金体系が含まれています。 コンプライアンス違反、特に重大な AI 違反の場合、世界の年間売上高の最大 7% の罰金が科される可能性があります。 これは、倫理的な AI 開発と責任ある導入の重要性を強調しています。

3. リスクベースのコンプライアンス

企業が AI を活用したソフトウェア開発を利用することを選択した場合、リスク評価を実施する必要があります。 これらは、人間の安全と基本的権利にもたらす可能性のある潜在的なリスクに基づいて AI システムを分類するのに役立ちます。

AI システムは、「許容できない」、「高」、「限定的」、または「最小リスク」のカテゴリに分類され、高リスクのグループにはより厳しい要件が設けられます。

EU における AI コンプライアンスを確保するには、企業は関連するリスクのレベルに応じてコンプライアンス義務を分類する必要があります。 このアプローチにより、さまざまなタイプの AI システムに適切な対策を実装することができます。 企業は、潜在的なリスクを軽減し、AI の責任ある使用を保証するために、このプロセスに取り組む必要があります。

4. 必要書類

AI ベースのソフトウェアを開発する企業は、システムに関する最新の技術文書と記録を維持する必要があります。 この文書は、全体的な透明性を確保し、規制基準への遵守を実証するために不可欠です。

5. 透明性と開示

企業に雇用されたソフトウェア開発者は、AI システムのリスク レベルに応じてさまざまな透明性義務に従う必要があります。 高リスク AI システムの場合は、EU データベースへの登録が必要です。 さらに、企業は感情認識や生体認証分類などの特定の AI アプリケーションについてユーザーに通知し、同意を得る必要があります。

6. 中小企業やスタートアップ企業への影響

中小企業を支援するために、EU AI 法は中小企業 (SME) と新興企業に対する罰金を制限しています。 これは AI ビジネスの多様な性質を反映しており、規制の遵守を促進します。

7. 倫理的配慮

このフレームワークは倫理的配慮を重視しており、企業はAIの可能性の活用とリスクの軽減のバランスをとることが求められている。 EU AI 法は、違反を罰し、高い安全基準の順守を奨励することを目的としています。

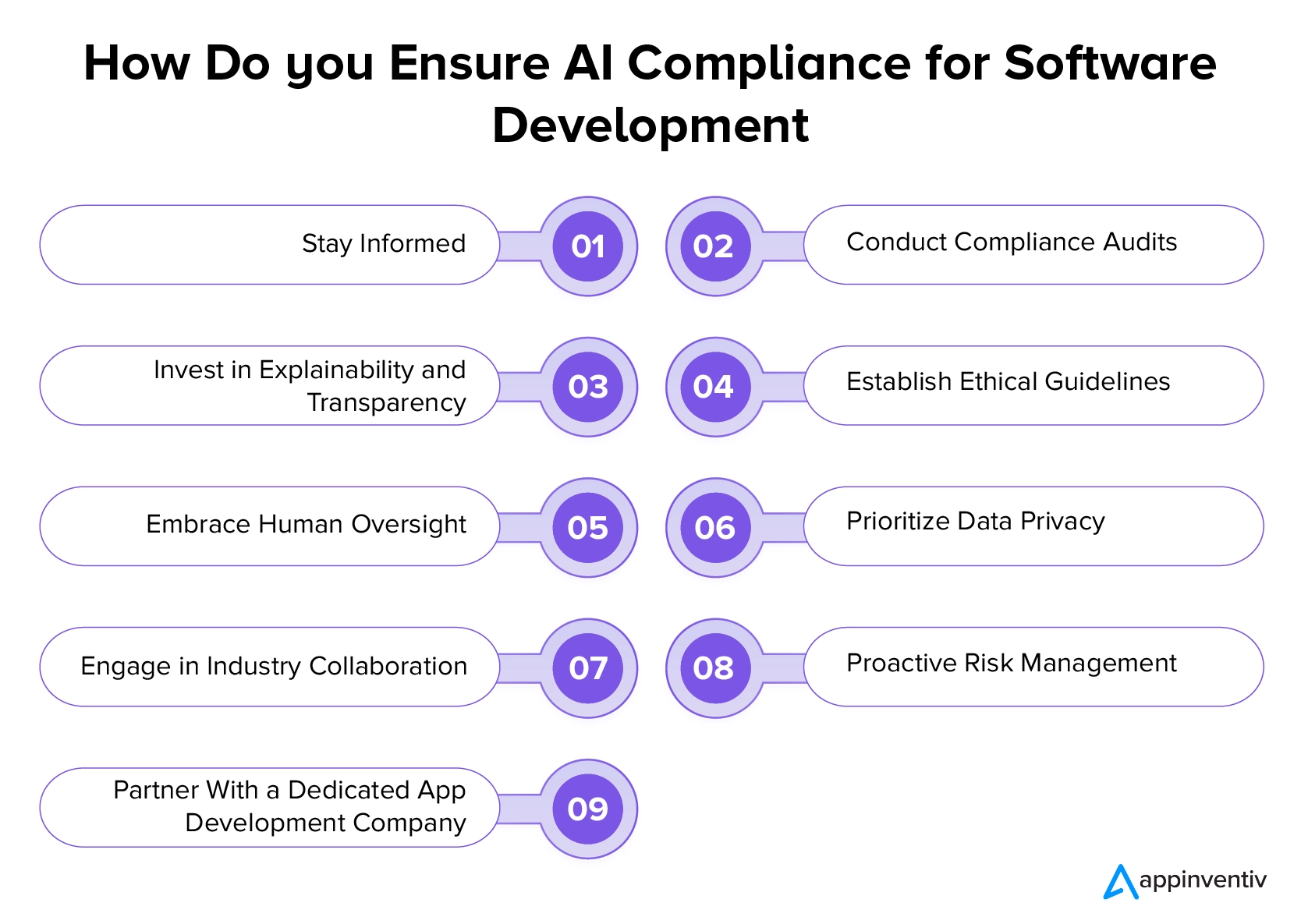

EU AI 規制時代で成功する方法: コンプライアンスを確保するためのベスト プラクティス

EU 人工知能法およびその他の規制は、倫理、透明性、ユーザーの幸福を優先する AI 開発の状況を大きく変えています。 これらの変化に適応するために AI 開発にいくつかの課題が生じる可能性がありますが、企業は以下に説明するベスト プラクティスに従い、専門のソフトウェア開発会社と協力することで、この新たな領域を乗り越えることができます。

最新情報を入手

企業は、修正や更新を含む AI 規制の最新の動向について常に情報を入手する必要があります。 規制当局、公式出版物、業界の最新情報を定期的に監視して、AI への取り組みに影響を与える可能性のある変更を確実に認識することが重要です。 ソフトウェア開発における AI 規制を常に最新の状態に保つことで、企業は戦略を積極的に適応させ、進化する規制へのコンプライアンスを確保できます。

コンプライアンス監査の実施

企業は、既存の規制を確実に遵守するために、AI システムとプロセスの監査を定期的に実施する必要があります。 AI アルゴリズムの透明性、公平性、説明責任を評価することが重要です。 これには、AI アプリケーションに関連する潜在的なバイアスやリスクを特定して対処することが含まれます。 これらの監査を実施することで、企業は発生する可能性のある法的または倫理的問題を軽減できます。

こちらもお読みください: AI モデルの崩壊を防ぐ: 合成データセットの固有のリスクに対処する

説明可能性と透明性への投資

企業は、AI システムの透明性と説明可能性を優先することをお勧めします。 AI アルゴリズムがどのように意思決定を行うかを明確に伝達できるソリューションを実装する必要があります。 これは規制要件に適合し、ユーザーと関係者間の信頼を促進します。

倫理ガイドラインの確立

企業は、AI プロジェクトのための明確な倫理ガイドラインの開発と実装を優先する必要があります。 これらのガイドラインは、公平性、プライバシー、AI の広範な社会的影響などの重要な倫理的考慮事項に特に対処する必要があります。 堅牢な倫理基準により、責任ある AI 開発が保証され、ユーザーと関係者の間に信頼が植え付けられ、規制要件との整合が図られます。

人間の監視を受け入れる

企業は、AI プロセス、特にリスクの高いアプリケーションにおける人間による監視の重要性を強調する必要があります。 人間によるレビューと意思決定を統合することは、説明責任を強化し、完全に自動化された AI システムに関連する潜在的なリスクを軽減するために不可欠です。

データプライバシーを優先する

企業は、GDPR などの規制に準拠した堅牢なデータ プライバシー慣行を遵守する必要があります。 AI を活用したソフトウェアを設計する場合、AI システムによってデータが利用される個人のプライバシー権を保護するために、安全なデータ処理、保存、および処理プロトコルを必ず実装する必要があります。 データプライバシーに対するこの取り組みにより、法的要件の遵守が保証され、ユーザーとの信頼が構築されます。

業界連携への取り組み

AI 準拠のソフトウェア開発サービスへの投資を希望する企業は、AI 規制に焦点を当てた業界のコラボレーション、フォーラム、ディスカッションに積極的に参加する必要があります。 同業他社や業界の専門家と連携することで、貴重な洞察を得て、ベストな開発手法の開発に貢献できます。

プロアクティブなリスク管理

企業は、AI アプリケーションに関連する潜在的なリスクを特定し、軽減するために、プロアクティブなリスク管理戦略を導入する必要があります。 徹底的なリスク評価を定期的に実施し、予期せぬ課題に対処する計画を策定します。

専門のソフトウェア開発会社と提携する

EU の新しい AI 規制とコンプライアンスに従って成長するために企業ができる最も重要なことの 1 つは、専門的な AI 開発サービスを提供する企業と提携することです。 専任の専門家の指導を求めることで、AI への取り組みが法的状況に確実に適合するようになります。

AI 開発に関する EU ガイドラインに精通した専門企業は、自社のビジネスに合わせた具体的なアドバイスを提供し、複雑な規制環境に対処し、それに関連する法的リスクを軽減するのに役立ちます。

Appinventiv は、開発を効率化するための新しい EU AI 法を推進する上で、どのように理想的なパートナーとなれるでしょうか?

私たちのブログが EU における AI 規制に関連する複雑さを理解していただければ幸いです。 当社の経験豊富な AI 開発者チームは豊富な専門知識を持ち込んで、最新の規制基準に準拠した最先端の AI ソリューションの作成を保証します。 当社はテクノロジーの最前線に留まり、お客様のアプリケーションが革新的であるだけでなく、EU AI 法に完全に準拠していることを保証することに尽力しています。

AI アプリ開発専門会社として、当社は規制の枠組みで指定された要件、透明性ガイドライン、コンプライアンスのスケジュールに精通しています。 これにより、厳しい EU 基準に従って AI プロジェクトを指導できるようになります。

当社の専門家に連絡して、イノベーションとコンプライアンスをシームレスに統合する AI 開発の旅に乗り出しましょう。

よくある質問

Q. GDPR は EU における AI の開発と利用にどのような影響を与えますか?

A.一般データ保護規則 (GDPR) は、EU における AI の開発と使用に大きな影響を与えます。 個人データの保護、透明性の確保、AI アプリケーションにおける説明責任の促進を強く強調しています。 アルゴリズムのバイアスに関する懸念に対処するために、GDPR 準拠では AI プロジェクトに対するデータ保護影響評価 (DPIA) の実装が義務付けられています。

Q. EU には医療や金融などの分野固有の AI 規制はありますか?

A. EU AI 規制は、高リスク AI システムを規制するための包括的な枠組みとして機能します。 ただし、特定のセクターには、その固有の課題や要件に合わせた追加の規制がある場合があります。 たとえば、医療業界では、医療アプリケーションにおける AI の倫理的かつ責任ある使用を保証するために追加の規制が設けられる場合があります。 同様に、金融分野でも、金融サービスにおける AI アプリケーションに関する特定のガイドラインが存在する可能性があります。 企業は、EU AI 法などの一般的な AI 規制と、自社のドメインに適用されるセクター固有の規制の両方を認識しておく必要があります。

Q. EU の規制に準拠して AI 製品を開発する際、CEO と CTO はどのような点を考慮する必要がありますか?

A. AI に関する EU の規制に準拠するには、CEO と CTO はまず最新の法律に関する情報を常に入手することを優先する必要があります。 透明性ガイドラインとコンプライアンスのスケジュールを確実に整合させることが重要です。 これに加えて、倫理ガイドライン、透明性、人的監視、データプライバシー慣行、リスク管理、法的相談、業界連携への積極的な参加はすべて、EU の規制要件と倫理基準を満たす AI 戦略を開発するために不可欠な要素です。