Normativa e conformità sull'intelligenza artificiale nell'UE: tracciare il panorama giuridico per lo sviluppo di software

Pubblicato: 2024-02-12L’intelligenza artificiale (AI) sta rapidamente cambiando il modo in cui opera il nostro mondo, lasciando un impatto significativo su vari settori. Dall’offerta di assistenza sanitaria personalizzata all’ottimizzazione della logistica e delle catene di approvvigionamento, la tecnologia ha già messo in mostra le sue capacità in tutti i settori.

Venendo ai mercati europei, il potenziale dell’intelligenza artificiale è particolarmente promettente, poiché i paesi e le imprese stanno rapidamente abbracciando lo sviluppo di software basato sull’intelligenza artificiale per promuovere l’innovazione, la crescita e il benessere sociale.

Tuttavia, oltre all’entusiasmo, ci sono sfide importanti da affrontare. Le preoccupazioni riguardanti i pregiudizi degli algoritmi, la loro trasparenza e il potenziale spostamento di posti di lavoro hanno sollevato molteplici questioni etiche e sociali che richiedono un’attenta considerazione. È fondamentale trovare un equilibrio tra lo sfruttamento del suo potenziale e la mitigazione dei suoi rischi per navigare in modo efficace nel panorama dell’intelligenza artificiale.

In particolare, l’Unione Europea ha recentemente modificato la legge sull’intelligenza artificiale, sottolineando l’importanza della regolamentazione dell’UE sull’intelligenza artificiale. Per le aziende che desiderano entrare nel mercato dello sviluppo software in Europa, comprendere e rispettare queste normative non è più facoltativo ma una parte essenziale del business.

Questo blog ti aiuterà a comprendere tutto ciò che riguarda l'intersezione tra intelligenza artificiale e sviluppo di software, evidenziando il panorama in evoluzione della regolamentazione dell'IA nell'UE. Oltre a ciò, approfondiremo anche l’importanza di aderire agli standard normativi governativi sull’IA.

Quindi, senza ulteriori indugi, passiamo ai dettagli cruciali.

Importanza della regolamentazione sull’IA nell’UE

L’Unione Europea (UE) sta assumendo una posizione proattiva in materia di regolamentazione e conformità in un mondo dominato da software basato sull’intelligenza artificiale. Riconoscendo i potenziali benefici e rischi di questa potente tecnologia, l'UE mira a creare un quadro solido sostenuto da pratiche etiche, trasparenza e implementazione responsabile. Comprendere l’importanza della conformità dell’IA nello sviluppo del software è fondamentale per diversi motivi:

Costruire la fiducia

La conformità dell’IA nell’UE mira a creare fiducia tra utenti, imprese e parti interessate garantendo che i sistemi di intelligenza artificiale siano sviluppati e utilizzati in modo etico. Questa fiducia è essenziale per l’adozione diffusa e il continuo sviluppo delle soluzioni IA.

Mitigare i rischi etici

Il potenziale di pregiudizi, discriminazioni e altre preoccupazioni etiche cresce man mano che l’intelligenza artificiale diventa sempre più integrata nella vita quotidiana. Le normative dell’UE guidano per mitigare questi rischi e garantire che i sistemi di intelligenza artificiale siano utilizzati in modo equo e responsabile.

Conformità e sostenibilità

L’UE mira a creare un ecosistema di IA sostenibile e responsabile stabilendo chiari requisiti di conformità. Ciò aiuta le aziende a gestire i rischi, rafforzare la sicurezza informatica e promuovere la trasparenza. In definitiva, comprendere l’importanza della conformità dell’IA aiuta le aziende a gestire le questioni legali e promuove lo sviluppo e l’implementazione responsabili dell’IA.

La conformità all’IA nell’UE non è solo un obbligo giuridico per le imprese, ma anche un investimento strategico nel successo a lungo termine dell’IA e nell’impatto positivo sulla società. Aderendo alla normativa sull’intelligenza artificiale nell’UE, le aziende possono contribuire a costruire un futuro in cui le loro soluzioni basate sull’intelligenza artificiale avvantaggiano tutti in modo etico e sostenibile.

Per garantire che un sistema di IA rispetti le regole, deve essere sottoposto a una valutazione di conformità. Una volta superato, viene registrato nel database dell'UE e riceve un marchio CE (conformità europea) per dimostrare che soddisfa gli standard prima di essere autorizzato sul mercato. Se vengono apportate grandi modifiche al sistema, come l'addestramento su nuovi dati o l'aggiunta/rimozione di funzionalità, deve essere sottoposto a una nuova valutazione per assicurarsi che rispetti ancora le regole prima di poter essere nuovamente certificato e reinserito nel database.

Il regolamento UE sull'intelligenza artificiale: orientarsi nel panorama normativo per lo sviluppo di software basato sull'intelligenza artificiale

L’Unione Europea ha implementato diverse normative chiave che hanno un impatto significativo sul campo dell’intelligenza artificiale. La regolamentazione dell’IA nello sviluppo del software è progettata per garantire uno sviluppo etico dell’IA in grado di proteggere la privacy delle persone e mitigare i potenziali rischi. Esaminiamo alcune principali conformità dell'UE per lo sviluppo dell'IA.

1. Regolamento generale sulla protezione dei dati (GDPR)

Il Regolamento generale sulla protezione dei dati (GDPR) è un fattore cruciale nel plasmare il panorama dell’intelligenza artificiale nell’Unione europea. Si concentra sulla protezione dei dati personali e applica misure rigorose per garantire trasparenza e responsabilità nelle applicazioni di intelligenza artificiale.

Oltre a ciò, il GDPR affronta anche i pregiudizi algoritmici, sottolineando l’importanza di sistemi di intelligenza artificiale equi e imparziali. Il regolamento richiede l’uso di valutazioni d’impatto sulla protezione dei dati (DPIA) per i progetti di intelligenza artificiale, che valutano i potenziali rischi e le implicazioni sulla privacy. Questo quadro normativo completo mira a stabilire una solida base per lo sviluppo etico e responsabile dell’IA all’interno dell’UE.

2. Legge sull'intelligenza artificiale

L’Artificial Intelligence Act è un quadro completo che regola i sistemi di intelligenza artificiale ad alto rischio. Delinea i requisiti di trasparenza, spiegabilità e supervisione umana. Questa struttura normativa mira a promuovere lo sviluppo e la diffusione responsabili e spiegabili dell’IA.

Le aziende che sviluppano software basato sull’intelligenza artificiale devono aderire alla conformità dell’intelligenza artificiale nello sviluppo del software e alle sue implicazioni, comprese le tempistiche di conformità e le considerazioni pratiche. Stabilendo criteri di trasparenza e controllo, la legge trova un equilibrio tra la promozione dell’innovazione e la protezione dei diritti fondamentali. Apre la strada a pratiche etiche di intelligenza artificiale nell’Unione europea.

3. Direttiva sulla responsabilità del prodotto

La Direttiva sulla responsabilità per danno da prodotti difettosi è un quadro completo che dà priorità alla sicurezza dei prodotti di intelligenza artificiale e al benessere degli utenti finali. Assegna agli sviluppatori la responsabilità di gestire i potenziali rischi associati ai prodotti IA, sottolineando la necessità di un approccio proattivo alla sicurezza dei prodotti.

La direttiva incoraggia gli sviluppatori associati allo sviluppo del prodotto a esplorare strategie di gestione del rischio per migliorare gli standard di sicurezza generali dei prodotti di intelligenza artificiale. Aderendo a queste misure, gli sviluppatori possono contribuire alla creazione di un panorama di IA sicuro e affidabile all’interno dell’Unione Europea.

Comprendendo in modo completo la regolamentazione dell’IA nell’UE, le aziende possono navigare nel panorama in evoluzione dello sviluppo dell’IA, garantendo conformità, pratiche etiche e l’implementazione responsabile delle tecnologie di intelligenza artificiale.

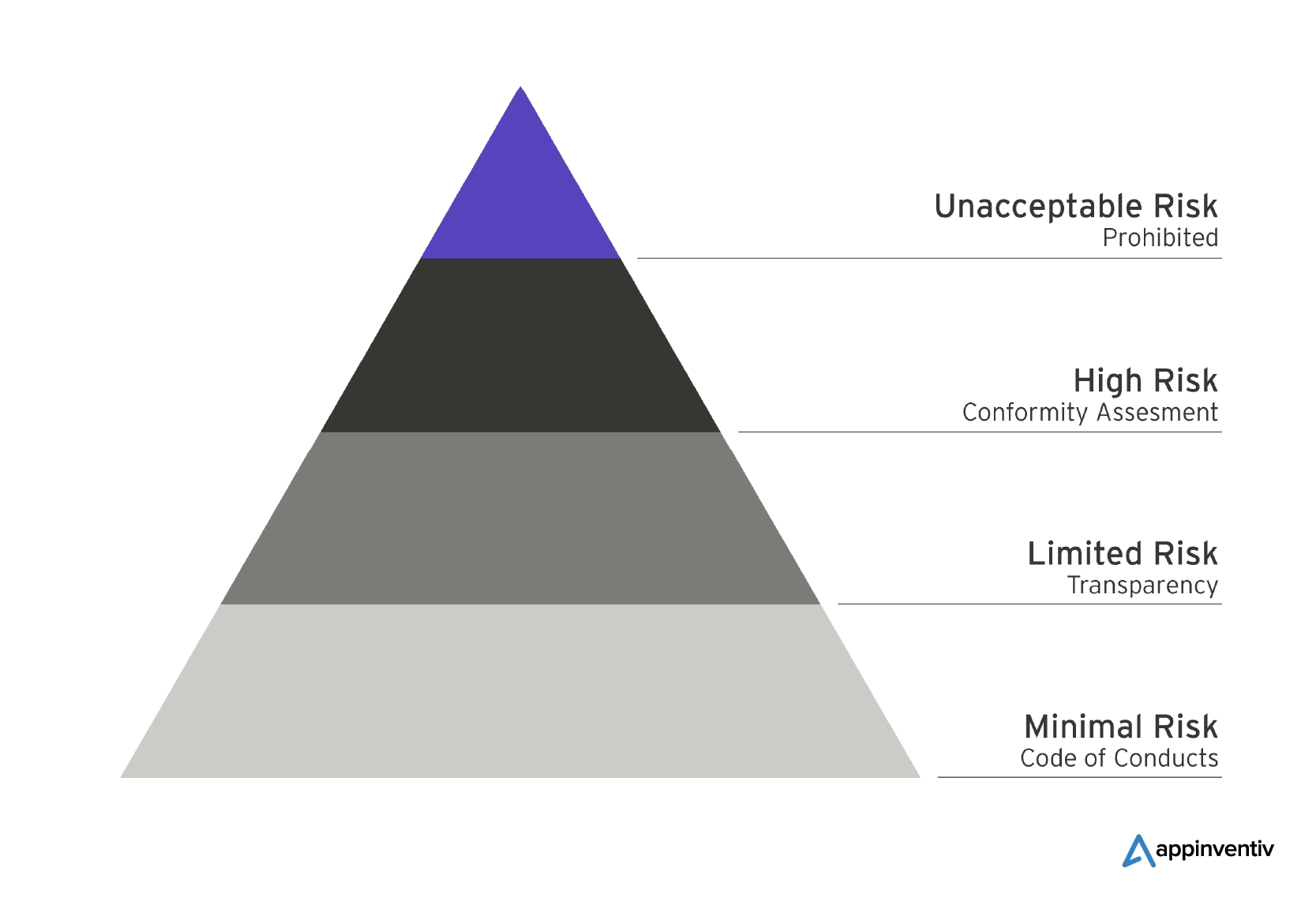

Orientarsi nello spettro dei rischi: comprendere le categorie di rischi nella nuova legge UE sull’intelligenza artificiale

Secondo il Parlamento Europeo, l’obiettivo primario è garantire la sicurezza, la trasparenza, la tracciabilità, la non discriminazione e la sostenibilità ambientale dei sistemi di IA in uso all’interno dell’UE. Pertanto, hanno stabilito regole differenziate in base al livello di rischio associato ai sistemi di intelligenza artificiale. Diamo un'occhiata alle molteplici categorie in dettaglio di seguito:

Rischio inaccettabile: vietare i sistemi di intelligenza artificiale minacciosi

I sistemi di IA che rientrano nella categoria di rischio inaccettabile sono considerati minacce dirette per gli individui e dovranno affrontare un divieto assoluto secondo la nuova legge UE sull’IA. Ad esempio, la manipolazione cognitivo comportamentale, il punteggio sociale e l’identificazione biometrica sono alcuni esempi di attività che rientrano in questa categoria proibita. Potrebbero essere consentite alcune eccezioni per specifiche applicazioni delle forze dell'ordine, che saranno soggette a condizioni rigorose, in particolare nel caso dei sistemi di identificazione biometrica in tempo reale.

Rischio elevato: salvaguardare la sicurezza e i diritti fondamentali

La categoria ad alto rischio delineata nella legge dell’UE sull’intelligenza artificiale funge da misura di protezione per garantire la sicurezza e la tutela dei diritti fondamentali durante l’impiego dell’intelligenza artificiale. Questa categoria comprende i sistemi di intelligenza artificiale che hanno il potenziale di avere un impatto negativo sulla sicurezza o sui diritti fondamentali.

Per maggiore chiarezza, la categoria ad alto rischio è divisa in due sottocategorie. La prima sottocategoria si concentra sui sistemi di intelligenza artificiale integrati nei prodotti disciplinati dalla legislazione dell’UE sulla sicurezza dei prodotti, che comprende un’ampia gamma di settori come giocattoli, aviazione e dispositivi medici. La seconda sottocategoria si concentra sui sistemi di IA che operano in aree critiche specifiche, che richiedono la registrazione obbligatoria in un database dell’UE.

Rischio limitato: trasparenza minima per le decisioni informate degli utenti

I sistemi di intelligenza artificiale classificati come a rischio limitato sono tenuti a rispettare requisiti minimi di trasparenza che consentano agli utenti di prendere decisioni informate. Secondo i vincoli di rischio limitato, l’utente dovrebbe essere avvisato quando interagisce con applicazioni AI, come quelle che generano o manipolano contenuti di immagini, audio o video, come i deepfake. Gli standard di trasparenza per l’IA a rischio limitato si concentrano sulla ricerca di un equilibrio tra la consapevolezza dell’utente e l’uso senza interruzioni delle applicazioni IA.

Scopo generale e intelligenza artificiale generativa: garantire la trasparenza

La legge dell’UE sull’IA stabilisce linee guida chiare per i modelli di IA generici e generativi per garantire la trasparenza delle loro operazioni. Ciò include strumenti come ChatGPT, che sono tenuti a rivelare che il loro contenuto è generato dall’intelligenza artificiale, a prevenire la generazione di contenuti illegali e a pubblicare riepiloghi dei dati protetti da copyright utilizzati per la formazione.

Inoltre, i modelli di intelligenza artificiale generica ad alto impatto, come i modelli avanzati come GPT-4, devono essere sottoposti a valutazioni approfondite. In caso di incidenti gravi, questi modelli sono obbligati a segnalare tali eventi alla Commissione Europea.

Sviluppo di software compatibile con l'intelligenza artificiale: considerazioni chiave per le aziende

Secondo gli approfondimenti della revisione del MIT, l’EU AI Act è un atto legislativo innovativo progettato per mitigare qualsiasi potenziale danno che potrebbe derivare dall’uso dell’IA in aree ad alto rischio, salvaguardando così i diritti fondamentali degli individui. Nello specifico, settori come la sanità, l’istruzione, la sorveglianza delle frontiere e i servizi pubblici sono stati identificati come aree prioritarie da proteggere. Inoltre, la legge vieta esplicitamente l’uso di applicazioni di intelligenza artificiale che rappresentano un “rischio inaccettabile”.

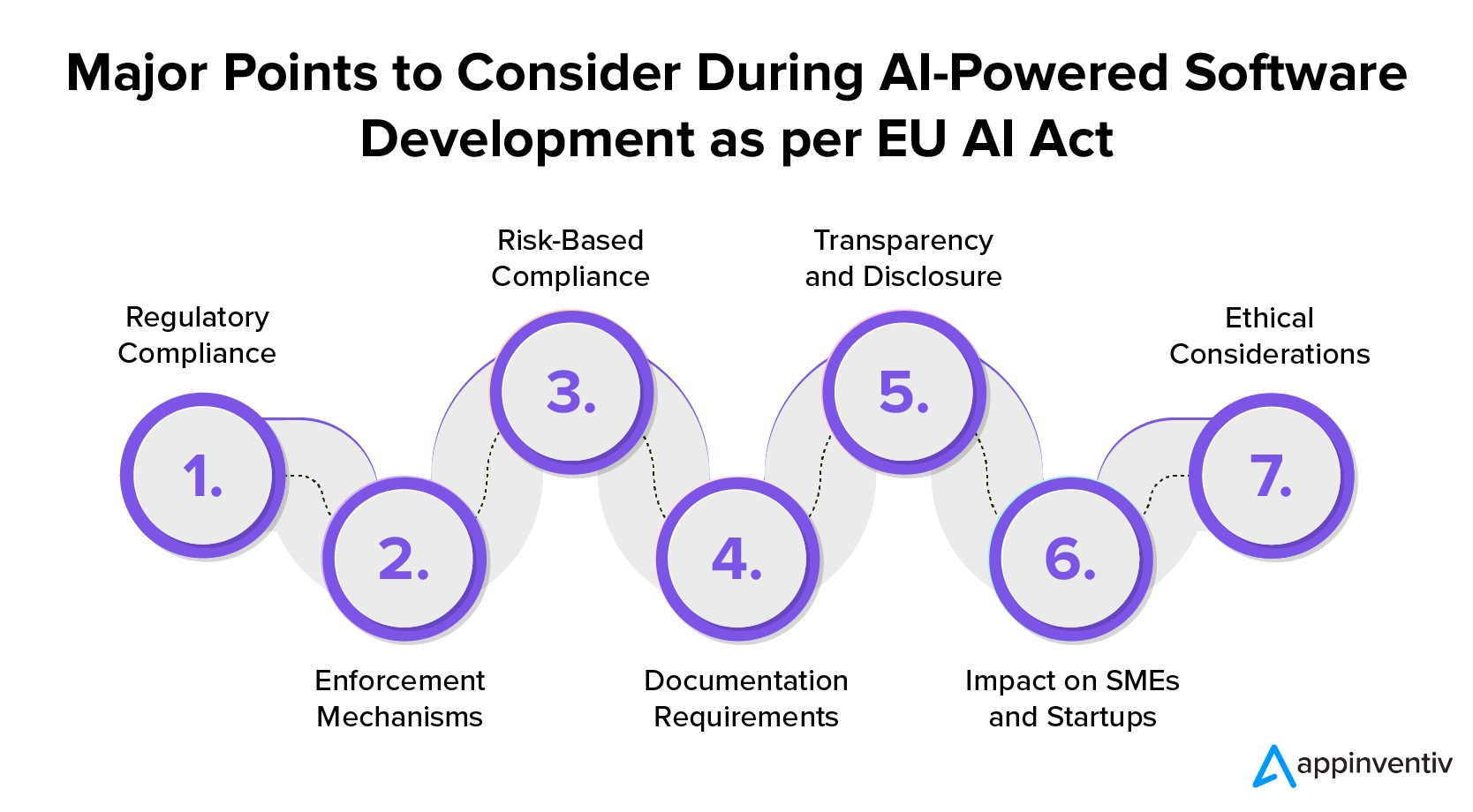

Annunciato nel dicembre 2023, l’EU AI Act rappresenta un passo cruciale verso la regolamentazione dell’intelligenza artificiale nell’Unione Europea. Le aziende che desiderano comprendere la regolamentazione dell’intelligenza artificiale nello sviluppo del software devono coglierne le implicazioni e prepararsi alla conformità. Ecco i punti chiave che le aziende che desiderano investire in servizi di sviluppo software conformi all’intelligenza artificiale dovrebbero considerare:

1. Conformità normativa

L’EU AI Act richiede una rigorosa conformità da parte degli sviluppatori di software AI, stabilendo norme precise sia per i fornitori che per gli utenti. Per garantire il rispetto di queste normative, le aziende che cercano di investire nello sviluppo di software basato sull’intelligenza artificiale devono attenersi rigorosamente agli standard di trasparenza e rendicontazione quando introducono sistemi di intelligenza artificiale nel mercato dell’UE.

2. Meccanismi di applicazione

La legge prevede un forte meccanismo di applicazione e una rigorosa struttura delle sanzioni. La non conformità, in particolare nei casi di gravi violazioni dell’IA, può portare a sanzioni fino al 7% del fatturato annuo globale. Ciò evidenzia l’importanza dello sviluppo etico dell’IA e dell’implementazione responsabile.

3. Conformità basata sul rischio

Quando le aziende scelgono di utilizzare lo sviluppo di software basato sull’intelligenza artificiale, devono condurre valutazioni del rischio. Questi aiutano a classificare i sistemi di IA in base ai potenziali rischi che possono comportare per la sicurezza umana e i diritti fondamentali.

I sistemi di intelligenza artificiale saranno classificati nelle categorie “inaccettabile”, “alto”, “limitato” o “rischio minimo” con requisiti più severi per i gruppi a rischio più elevato.

Per garantire la conformità all’IA nell’UE, le aziende devono classificare i propri obblighi di conformità in base al livello di rischio coinvolto. Questo approccio consente l’attuazione di misure adeguate per diversi tipi di sistemi di IA. Le imprese devono impegnarsi in questo processo per mitigare i rischi potenziali e garantire un uso responsabile dell’intelligenza artificiale.

4. Requisiti di documentazione

Le aziende che sviluppano software basato sull’intelligenza artificiale sono tenute a mantenere la documentazione tecnica e i registri aggiornati per i loro sistemi. Questa documentazione è vitale per la trasparenza generale e per dimostrare l'aderenza agli standard normativi.

5. Trasparenza e divulgazione

Gli sviluppatori di software assunti dalle imprese devono rispettare obblighi di trasparenza diversi a seconda del livello di rischio del sistema di intelligenza artificiale. Per i sistemi di IA ad alto rischio è richiesta la registrazione nella banca dati dell’UE. Inoltre, le aziende devono informare gli utenti e ottenere il loro consenso per specifiche applicazioni di intelligenza artificiale, come il riconoscimento delle emozioni o la categorizzazione biometrica.

6. Impatto su PMI e Startup

Per sostenere le imprese più piccole, la legge UE sull’intelligenza artificiale limita le sanzioni per le piccole e medie imprese (PMI) e le startup. Ciò riflette la natura variegata delle attività di intelligenza artificiale e promuove il rispetto delle normative.

7. Considerazioni etiche

Il quadro enfatizza le considerazioni etiche, richiedendo alle aziende di trovare un equilibrio tra lo sfruttamento del potenziale dell’intelligenza artificiale e la mitigazione dei suoi rischi. L’UE AI Act mira a penalizzare la non conformità e incoraggiare il rispetto di elevati standard di sicurezza.

Come prosperare nell’era della regolamentazione dell’IA dell’UE: migliori pratiche per garantire la conformità

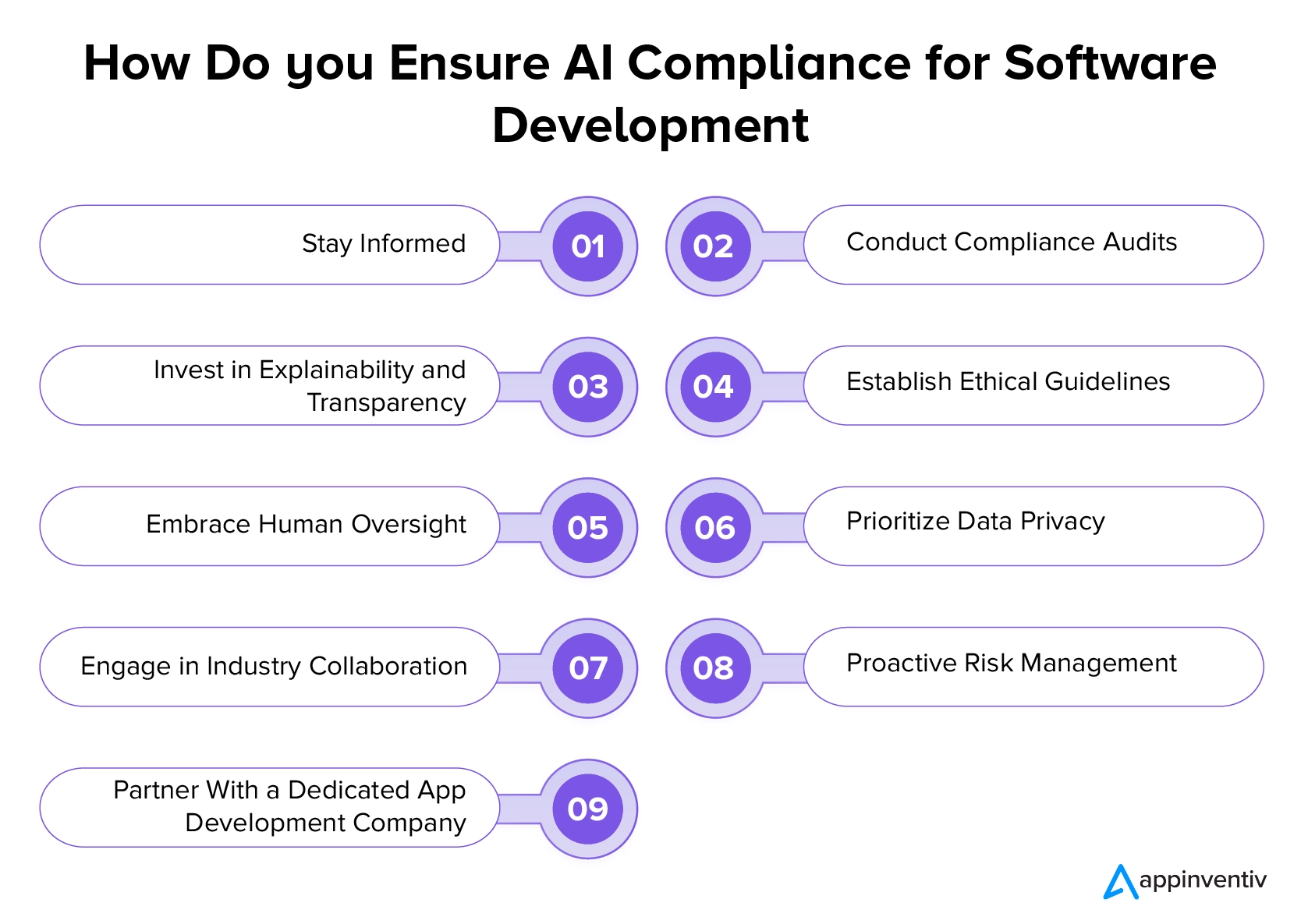

La legge europea sull’intelligenza artificiale e altre normative modificano in modo significativo il panorama dello sviluppo dell’intelligenza artificiale, dando priorità all’etica, alla trasparenza e al benessere degli utenti. Sebbene la prospettiva di adattarsi a questi cambiamenti possa causare alcune sfide nello sviluppo dell’intelligenza artificiale, le aziende possono esplorare questo nuovo terreno seguendo le migliori pratiche menzionate di seguito e collaborando con un’azienda di sviluppo software professionale.

Rimani informato

Le aziende devono rimanere informate sugli ultimi sviluppi delle normative sull’intelligenza artificiale, inclusi emendamenti e aggiornamenti. È fondamentale monitorare regolarmente le autorità di regolamentazione, le pubblicazioni ufficiali e gli aggiornamenti del settore per garantire la consapevolezza di eventuali cambiamenti che potrebbero avere un impatto sulle iniziative di intelligenza artificiale. Rimanendo aggiornati con la normativa sull’intelligenza artificiale nello sviluppo di software, le aziende possono adattare in modo proattivo le proprie strategie e garantire la conformità alle normative in evoluzione.

Condurre controlli di conformità

Le aziende devono condurre regolarmente audit dei propri sistemi e processi di intelligenza artificiale per garantire la conformità alle normative esistenti. È importante valutare la trasparenza, l’equità e la responsabilità degli algoritmi di intelligenza artificiale. Ciò include l'identificazione e la risoluzione di eventuali pregiudizi o rischi associati alle applicazioni IA. Conducendo questi controlli, le aziende possono mitigare eventuali problemi legali o etici che potrebbero sorgere.

Leggi anche: Prevenire il collasso del modello di intelligenza artificiale: affrontare il rischio intrinseco dei set di dati sintetici

Investire in spiegabilità e trasparenza

Si consiglia alle aziende di dare priorità alla trasparenza e alla spiegabilità dei propri sistemi di intelligenza artificiale. Dovrebbero implementare soluzioni che consentano una comunicazione chiara su come i loro algoritmi di intelligenza artificiale prendono decisioni. Ciò è in linea con i requisiti normativi e promuove la fiducia tra gli utenti e le parti interessate.

Stabilire linee guida etiche

Le aziende devono dare priorità allo sviluppo e all’implementazione di linee guida etiche chiare per i loro progetti di intelligenza artificiale. Queste linee guida dovrebbero affrontare in modo specifico considerazioni etiche critiche, come l’equità, la privacy e l’impatto sociale più ampio dell’intelligenza artificiale. Robusti standard etici garantiscono uno sviluppo responsabile dell’IA, infondono fiducia tra gli utenti e le parti interessate e si allineano ai requisiti normativi.

Abbraccia la supervisione umana

Le aziende dovrebbero sottolineare l’importanza della supervisione umana nei processi di intelligenza artificiale, in particolare nelle applicazioni ad alto rischio. L’integrazione della revisione umana e del processo decisionale è essenziale per rafforzare la responsabilità e mitigare i potenziali rischi legati ai sistemi di IA completamente automatizzati.

Dare priorità alla privacy dei dati

Le aziende devono aderire a solide pratiche sulla privacy dei dati in linea con normative come il GDPR. Quando progettano software basato sull’intelligenza artificiale, devono assicurarsi di implementare protocolli sicuri di gestione, archiviazione ed elaborazione dei dati per salvaguardare i diritti alla privacy delle persone i cui dati vengono utilizzati dai sistemi di intelligenza artificiale. Questo impegno per la privacy dei dati garantisce la conformità ai requisiti legali e crea fiducia negli utenti.

Impegnarsi nella collaborazione industriale

Le aziende che desiderano investire in servizi di sviluppo software conformi all’intelligenza artificiale dovrebbero partecipare attivamente a collaborazioni, forum e discussioni di settore incentrati sulla regolamentazione dell’intelligenza artificiale. Interagendo con colleghi ed esperti del settore, possono acquisire preziose informazioni e contribuire allo sviluppo delle migliori pratiche di sviluppo.

Gestione proattiva del rischio

Le aziende dovrebbero implementare strategie proattive di gestione del rischio per identificare e mitigare i potenziali rischi associati alle applicazioni di intelligenza artificiale. Condurre regolarmente valutazioni approfondite dei rischi e sviluppare piani per affrontare sfide impreviste.

Collaborare con una società di sviluppo software dedicata

Una delle cose più importanti che le aziende possono fare per prosperare secondo la nuova regolamentazione e conformità sull’IA nell’UE è collaborare con un’azienda che offra servizi professionali di sviluppo dell’IA. La ricerca della guida di professionisti dedicati garantisce che le loro iniziative di intelligenza artificiale siano in linea con il panorama legale.

Le aziende professionali che conoscono bene le linee guida dell’UE per lo sviluppo dell’IA possono fornire consulenza specifica su misura per la loro attività, aiutandole a destreggiarsi nel complesso contesto normativo e a mitigare i rischi legali ad esso associati.

In che modo Appinventiv può essere il tuo partner ideale nell'affrontare la nuova legge UE sull'intelligenza artificiale per uno sviluppo semplificato?

Ci auguriamo che il nostro blog ti abbia fatto comprendere le complessità legate alla regolamentazione dell'IA nell'UE. Il nostro team di sviluppatori IA esperti mette a disposizione una vasta gamma di competenze, garantendo la creazione di soluzioni IA all'avanguardia in linea con i più recenti standard normativi. Ci impegniamo a rimanere all'avanguardia nella tecnologia, garantendo che le tue applicazioni non siano solo innovative ma anche pienamente conformi alla legge UE sull'intelligenza artificiale.

In qualità di società dedicata allo sviluppo di app IA, conosciamo bene i requisiti, le linee guida sulla trasparenza e le tempistiche di conformità specificate nel quadro normativo. Questo ci consente di guidare i tuoi progetti di intelligenza artificiale secondo i rigorosi standard dell’UE.

Mettiti in contatto con i nostri esperti per intraprendere un viaggio di sviluppo dell'intelligenza artificiale che integra perfettamente innovazione e conformità.

Domande frequenti

D. In che modo il GDPR influisce sullo sviluppo e sull'utilizzo dell'IA nell'UE?

R. Il Regolamento generale sulla protezione dei dati (GDPR) ha un impatto sostanziale sullo sviluppo e sull’utilizzo dell’IA nell’UE. Sottolinea fortemente la salvaguardia dei dati personali, la garanzia della trasparenza e la promozione della responsabilità nelle applicazioni di intelligenza artificiale. Per affrontare le preoccupazioni relative ai bias algoritmici, la conformità al GDPR impone l’implementazione di valutazioni di impatto sulla protezione dei dati (DPIA) per i progetti di intelligenza artificiale.

D. Nell’UE esistono normative sull’IA specifiche per settore, ad esempio nel settore sanitario o finanziario?

R. Il regolamento UE sull’IA costituisce un quadro completo per la regolamentazione dei sistemi di IA ad alto rischio. Tuttavia, settori specifici possono avere normative aggiuntive adattate alle loro sfide ed esigenze specifiche. Ad esempio, il settore sanitario potrebbe avere normative aggiuntive per garantire l’uso etico e responsabile dell’IA nelle applicazioni mediche. Allo stesso modo, il settore finanziario potrebbe avere linee guida specifiche per le applicazioni dell’IA nei servizi finanziari. Le aziende devono essere a conoscenza sia delle normative generali sull’IA, come la legge UE sull’AI, sia di eventuali normative specifiche del settore che si applicano al loro settore.

D. Quali considerazioni dovrebbero tenere in considerazione CEO e CTO quando sviluppano prodotti di intelligenza artificiale in conformità con le normative UE?

R. Per conformarsi alle normative UE sull’intelligenza artificiale, i CEO e i CTO devono innanzitutto dare la priorità all’informazione sull’ultima legge. È fondamentale garantire l’allineamento con le linee guida sulla trasparenza e le tempistiche di conformità. Oltre a ciò, le linee guida etiche, la trasparenza, il controllo umano, le pratiche sulla privacy dei dati, la gestione del rischio, la consulenza legale e la partecipazione attiva alle collaborazioni di settore sono tutti elementi essenziali per lo sviluppo di strategie di intelligenza artificiale che soddisfino i requisiti normativi e gli standard etici nell’UE.