Apa Itu Pipa Data?

Diterbitkan: 2019-08-15Apa itu Pipa Data?

Pipeline data berfungsi sebagai mesin pemrosesan yang mengirimkan data Anda melalui aplikasi transformatif, filter, dan API secara instan.

Anda dapat membayangkan jalur pipa data seperti rute transportasi umum. Anda menentukan di mana data Anda melompat di bus dan ketika meninggalkan bus.

Pipeline data menyerap kombinasi sumber data, menerapkan logika transformasi (seringkali dibagi menjadi beberapa tahapan berurutan) dan mengirimkan data ke tujuan pemuatan, seperti gudang data misalnya.

Dengan munculnya pemasaran digital dan kemajuan teknologi yang berkelanjutan di sektor TI – jalur pipa data telah menjadi penyelamat untuk pengumpulan , konversi , migrasi , dan visualisasi data yang kompleks.

Menurut Adobe, hanya 35% pemasar yang berpikir bahwa saluran pipa mereka efisien. Di sini, di Improvado, kami mulai mengubahnya.

Improvado adalah solusi saluran data #1 untuk pemasar. Alat ETL yang digunakan untuk mengekstrak, mengubah, dan memuat data dari lebih dari 150 platform pemasaran yang berbeda ke tujuan akhir apa pun, seperti alat BI atau gudang data. Pelajari lebih lanjut di sini.

Sifat perampingan dan terkonsentrasi dari pipa data memungkinkan skema yang fleksibel dari sumber statis dan real-time. Pada akhirnya, fleksibilitas ini terkait kembali dengan kapasitas jalur pipa data untuk membagi data menjadi bagian-bagian kecil.

Hubungan rentang data dan dampaknya menjadi lebih penting bagi bisnis di seluruh dunia. Secara bersamaan, pemahaman tentang ikatan yang saling berhubungan ini membantu ilmuwan data memilah latensi, kemacetan, sumber tak dikenal, dan masalah duplikasi.

Itu benar; pipa data sekarang melengkapi jaringan sistem. Semakin lengkap saluran data, semakin baik penerapan sistem jaringan untuk menggabungkan layanan cloud dan aplikasi hybrid untuk bekerja.

Bangkitnya Pipa Data

Selain itu, jalur pipa data telah membuka pintu baru untuk mengintegrasikan banyak alat dan menyerap banyak sekali file XML dan CSV yang besar. Pemrosesan data secara real-time, bagaimanapun, mungkin merupakan titik kritis untuk jalur pipa data.

Titik kritis itu memfasilitasi kebutuhan jam untuk memindahkan potongan besar data dari satu tempat ke tempat lain tanpa mengubah format. Akibatnya, bisnis telah menemukan kebebasan baru untuk mengubah , menggeser , menyegmentasikan , memamerkan , atau mentransfer data dalam waktu singkat.

Selama bertahun-tahun, objektivitas cara bisnis beroperasi telah berubah secara signifikan. Fokusnya tidak lagi terpaku pada perolehan margin keuntungan, tetapi bagaimana para ilmuwan data dapat menghadirkan solusi yang layak yang terhubung dengan orang-orang. Selain itu, yang lebih penting, perubahan tersebut harus transformatif , dapat dilacak , dan dapat disesuaikan untuk mengubah dinamika masa depan. Yang mengatakan, pipa data telah datang jauh dari menggunakan file datar, database, dan danau data untuk mengelola layanan pada platform tanpa server.

Infrastruktur Pipa Data

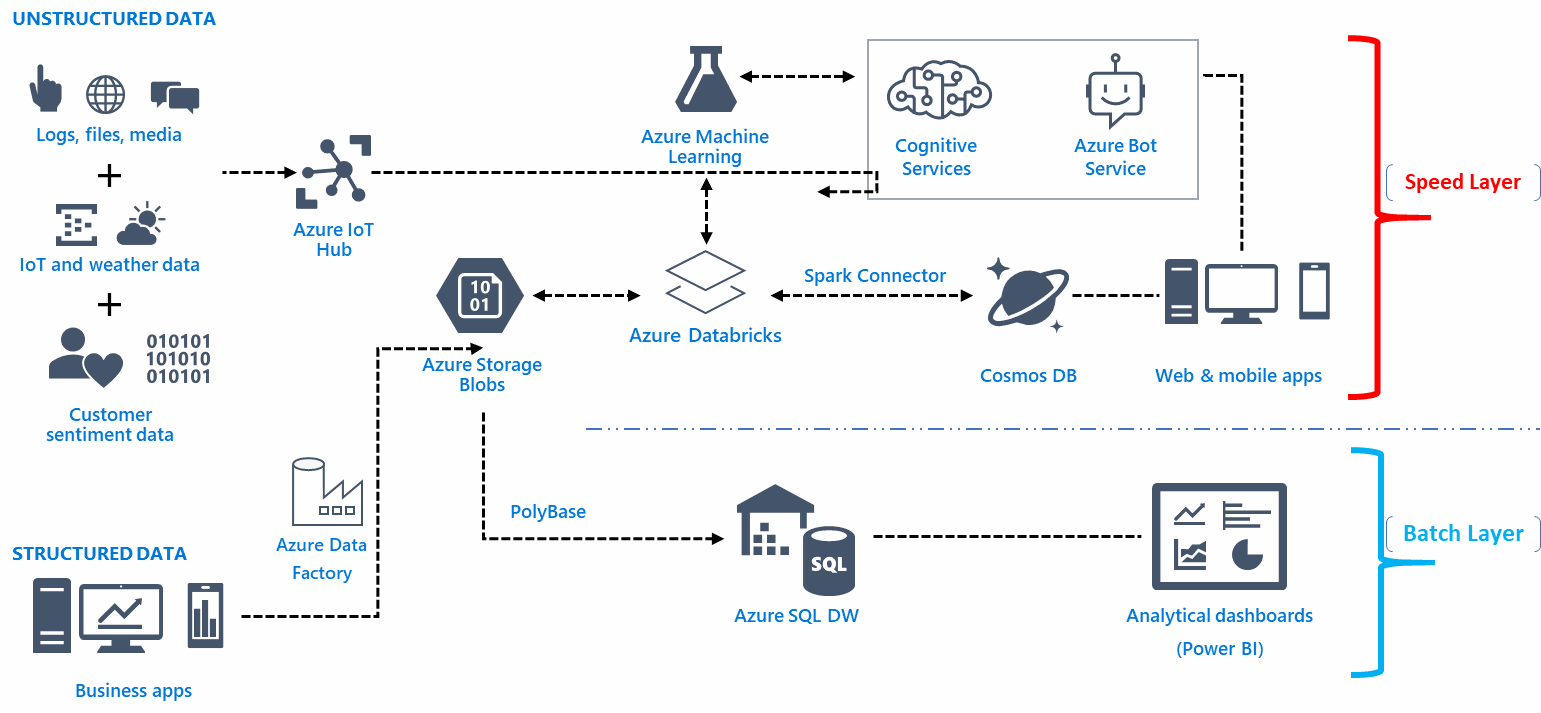

Infrastruktur arsitektur pipa data bergantung pada fondasi untuk menangkap, mengatur, merutekan, atau merutekan ulang data untuk mendapatkan informasi yang mendalam. Inilah masalahnya, umumnya ada cukup banyak titik masuk yang tidak relevan untuk data mentah. Selain itu, di sinilah infrastruktur pipa menggabungkan, menyesuaikan, mengotomatisasi, memvisualisasikan, mengubah, dan memindahkan data dari berbagai sumber daya untuk mencapai tujuan yang ditetapkan.

Selain itu, infrastruktur arsitektur saluran data melengkapi fungsionalitas berdasarkan analitik dan kecerdasan bisnis yang tepat. Fungsionalitas data berarti mendapatkan wawasan berharga tentang perilaku pelanggan, proses robot, proses otomatisasi, dan pola pengalaman pelanggan, serta pola perjalanan pengguna. Anda belajar tentang tren dan informasi real-time melalui intelijen bisnis dan analitik melalui sejumlah besar data.

Memilih Tim Rekayasa Data yang Tepat

Akan lebih bijaksana untuk membentuk tim rekayasa data besar yang selalu sibuk dengan detail aplikasi. Pekerjakan insinyur data yang harus dapat memperoleh data struktural dan menyelesaikan untuk memecahkan masalah, memahami tabel yang kompleks, dan mengimplementasikan data fungsional secara tepat waktu.

Fungsionalitas Pipa Data

Fungsionalitas pipa data berfungsi untuk mengumpulkan informasi, tetapi secara teknis, metode untuk menyimpan, mengakses, dan menyebarkan data dapat bervariasi tergantung pada konfigurasi.

Meminimalkan pergerakan data, misalnya, dimungkinkan melalui lapisan abstrak untuk membubarkan data tanpa secara manual memindahkan setiap informasi di UI. Anda dapat membuat lapisan abstrak untuk beberapa sistem file dengan bantuan Alluxio antara mekanisme penyimpanan dan vendor yang dipilih seperti AWS.

Fungsionalitas pipa data tidak harus bergantung pada belas kasihan sistem database vendor. Selain itu, apa gunanya menciptakan infrastruktur bebas kesalahan dan berlapis tanpa fleksibilitas? Dengan mengingat hal itu, saluran data Anda harus dapat mengumpulkan informasi lengkap di perangkat penyimpanan seperti AWS untuk melindungi masa depan sistem data.

Fungsi pipa data harus memenuhi analitik bisnis alih-alih membangun jaringan sepenuhnya berdasarkan pilihan estetika. Fungsi infrastruktur streaming, misalnya, cukup sulit untuk dikelola dan umumnya membutuhkan pengalaman profesional dan bisnis yang kuat untuk mengelola tugas-tugas rekayasa yang kompleks.

Anda dapat menggunakan layanan kontainer utama, seperti Dockers, untuk membuat pipa data. Anda dapat mengubah respons fungsional keamanan, memeriksa potensi skalabilitas, dan meningkatkan kode perangkat lunak dengan bantuan container. Kesalahan umum yang biasanya dilakukan orang selama pembuatan respons fungsional adalah melakukan dan mendistribusikan operasi secara tidak merata. Triknya adalah menghindari penggunaan file transformasi utama dalam SQL dan mengadaptasi metode CTAS untuk mengatur beberapa parameter dan operasi file.

Meskipun database seperti Snowflake dan Presto memberi Anda akses SQL bawaan, sebagian besar data pasti mengurangi waktu UI. Oleh karena itu, terapkan algoritme yang berfokus pada kecepatan yang menghasilkan kesalahan keluaran kecil.

Alat Untuk Membangun Pipa Data

Sistem file kolom dari saluran data Anda harus dapat menyimpan dan mengompresi data akumulatif akhir. Mesin data meningkatkan penggunaan sistem file tersebut di UI. Juga, untuk mendapatkan visualisasi yang menarik – gunakan iPython atau Jupyter sebagai notebook. Anda bahkan dapat membuat template notebook berbasis parameter tertentu untuk mendapatkan fungsi bawaan untuk mengaudit data, menyorot grafik, memfokuskan plot yang relevan, atau meninjau data secara bersamaan.

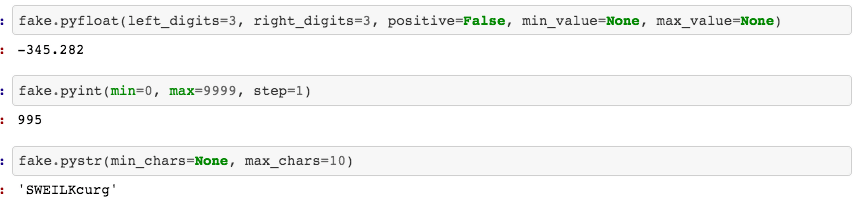

Anda dapat mentransfer subset data khusus ini ke lokasi yang jauh dengan bantuan alat seperti Google Cloud Platform (GCP), Python , atau Kafka . Anda tidak perlu membuat versi akhir kode pada langkah pertama – mulai dengan fitur pustaka Faker di Python untuk menulis dan menguji kode di jalur data.

Apa Perbedaan Antara Pipa Data Dan ETL?

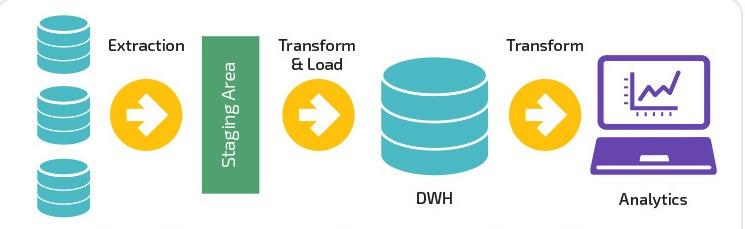

ETL adalah akronim umum yang digunakan untuk Extract , Transform , dan Load. Perbedaan utama dari ETL adalah bahwa ia berfokus sepenuhnya pada satu sistem untuk mengekstrak, mengubah, dan memuat data ke gudang data tertentu. Atau, ETL hanyalah salah satu komponen yang termasuk dalam pipa data.

Pipa ETL memindahkan data dalam batch ke sistem tertentu dengan interval yang diatur. Relatif, pipa data memiliki penerapan yang lebih luas untuk mengubah dan memproses data melalui streaming atau real-time.

Pipeline data tidak harus memuat data ke gudang data tetapi dapat memilih untuk memuat ke target selektif seperti bucket S3 (Simple Storage Service) Amazon atau bahkan menghubungkannya ke sistem yang sama sekali berbeda.

Solusi Pipa Data yang Tersedia

Sifat dan respons fungsional pipa data akan berbeda dari alat cloud untuk memigrasikan data untuk langsung menggunakannya untuk solusi waktu nyata.

- Berbasis awan

Rasio biaya-manfaat menggunakan alat berbasis cloud untuk menggabungkan data cukup tinggi. Bisnis telah belajar untuk memelihara infrastruktur terkini dengan penggunaan sarana dan sumber daya yang minimal. Namun, proses untuk memilih vendor untuk mengelola saluran data adalah masalah lain sepenuhnya.

- Sumber Terbuka

Istilah ini memiliki konotasi yang kuat bagi para ilmuwan data yang menginginkan saluran pipa data transparan yang tidak menipu penggunaan data atas nama pelanggan. Alat Open Source ideal untuk pemilik usaha kecil yang menginginkan biaya lebih rendah dan ketergantungan yang berlebihan pada vendor. Namun, kegunaan alat tersebut membutuhkan keahlian dan pemahaman fungsional untuk menyesuaikan dan memodifikasi pengalaman pengguna.

- Pemrosesan Waktu Nyata

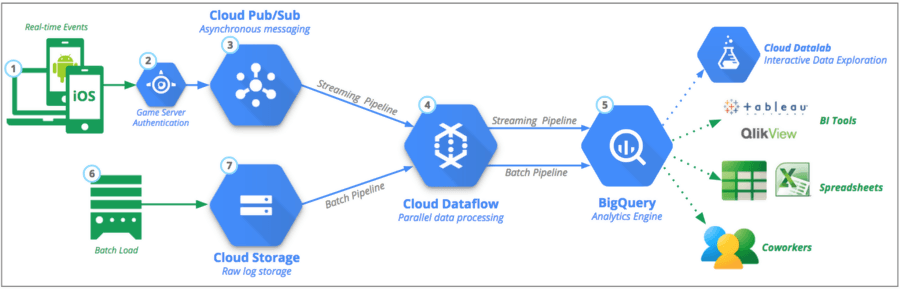

Implementasi pemrosesan waktu nyata bermanfaat bagi bisnis yang ingin memproses data dari sumber streaming yang diatur. Selain itu, pasar keuangan dan perangkat seluler kompatibel untuk memiliki pemrosesan waktu nyata. Yang mengatakan, pemrosesan waktu nyata membutuhkan interaksi manusia yang minimal, opsi penskalaan otomatis, dan kemungkinan partisi.

- Penggunaan Batch

Pemrosesan batch memungkinkan bisnis untuk dengan mudah mengangkut sejumlah besar data pada interval tanpa harus memerlukan visibilitas waktu nyata. Proses ini memudahkan analis yang menggabungkan banyak data pemasaran untuk membentuk hasil atau pola yang menentukan.

Proses Otomatis

Yah, itu menghilangkan kebutuhan untuk mengulang untuk mendefinisikan , mengekstrak , memuat , dan mengubah data. Ingat, hanya pada awal program Anda harus memasukkan pekerjaan manual dan sistem akan mengotomatiskannya untuk seluruh proses. Namun, proses otomatisasi membutuhkan penerjemah yang dapat menyelaraskan dan menyesuaikan kebutuhan bisnis.

Selain itu, faktor reproduktifitas membuatnya nyaman bagi pengguna untuk mengakses data dengan keamanan yang masuk akal. Namun, Anda perlu memahami bahwa seluruh proses rentan terhadap debugging. Ini pasti mengarah pada perubahan analisis dan penggabungan data .

Penyelesaian proyek bernilai tinggi sepenuhnya bergantung pada tingkat keahlian, dan pelatihan ilmuwan data yang disewa. Namun, untuk beberapa bisnis, penambahan perangkat keras dan orang mungkin bukan pilihan yang layak. Meskipun demikian, demi pemeliharaan dan peningkatan saluran data – Anda pada akhirnya perlu menggunakan layanan tim profesional.

- Integrasi Kontemporer

Opsi infrastruktur dan fungsional tidak terbatas dalam hal membangun saluran data, selaras dan terintegrasi dengan Google AdWords, Analytics, Iklan Facebook, LinkedIn, dan integrasi YouTube. Ini berarti Anda dapat mengakses UI Anda untuk mengembangkan saluran data tanpa harus bergantung pada kode.

Sumber

Pemasaran digital mungkin telah merevolusi dalam beberapa tahun terakhir, tetapi begitu juga peran ilmuwan data, yang kini memungkinkan untuk menggabungkan sebagian besar kumpulan data Anda dari data AdWords dan Streaming konten ke platform cloud yang dipilih dalam hitungan menit .

Anda dapat menyerap dan memproses kumpulan data untuk mengatur analitik real-time di seluruh dunia, dan mempersonalisasi aliran di berbagai proyek juga. Demikian pula, Anda dapat menautkan ulang operasi data dan memeriksa penagihan per detik. Namun, ia juga menawarkan lingkungan stasiun alur kerja yang mulus di cloud lokal dan publik. Pada akhirnya, ini membuat eksplorasi visual, konektivitas ke IoT , dan pembersihan data terstruktur menjadi lebih mudah.

Kesesuaian & Skalabilitas Pipa Data

Skalabilitas saluran data harus mampu mencetak miliaran poin data dan skala produk yang jauh lebih banyak. Selain itu, triknya adalah menyimpan data pada sistem dengan cara yang memudahkan ketersediaan kueri.

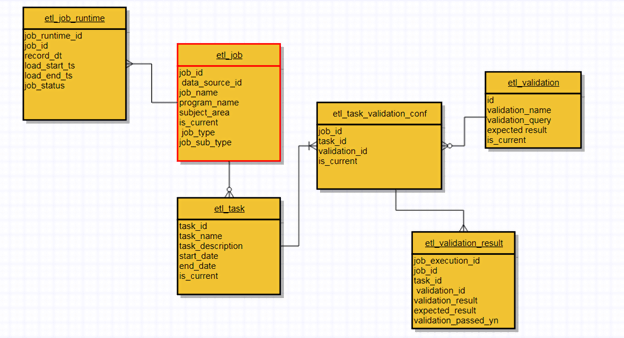

Terlebih lagi, adalah bahwa saluran data yang dirancang dengan baik berfokus pada opsi kesesuaian dan skalabilitas secara bersamaan. Semakin tinggi rasio skalabilitas, semakin kompatibel. Demikian pula, gunakan tayangan ulang sebagai teknik kontingensi yang efektif untuk kemungkinan penyajian kembali data. Anda dapat memeriksa pos pemeriksaan mengubah kode sumber untuk melanjutkan proses. Ini secara praktis memungkinkan Anda untuk melalui saluran ETL yang menggunakan meta-data untuk setiap titik masuk untuk memeriksa status, data yang dikumpulkan, dan transformasi keseluruhan.

Desain klaster dari pipeline data harus diskalakan pada setiap beban alih-alih mekanisme tetap 24/7. AWS EMR (Elastic MapReduce), misalnya, adalah contoh sempurna penskalaan otomatis di mana kluster menerima pemicu untuk melewati urutan ETL tertentu dan membuangnya setelah selesai. Penting untuk dicatat bahwa Anda selalu dapat menaikkan atau menurunkan skala tergantung pada sifat data.

Selain itu, antarmuka pengguna (UI) Anda harus cukup jelas untuk memantau tayangan ulang data lengkap dan status batch. Selain itu, Anda dapat menempatkan kueri (UI) di atas model data primer untuk menganalisis dan meninjau kondisi saluran data. Apache Airflow, misalnya, adalah opsi yang layak untuk memantau status, tetapi ini mencakup penggunaan dev-op dan penulisan kode. Selain itu, di sinilah penggunaan metadata arsitektur menjadi penting untuk memantau, memeriksa validasi, dan mengatasi masalah data produktivitas yang rumit.

Bagaimana Pipa Data Dapat Mempengaruhi Pengambilan Keputusan

Saat ini, para pembuat keputusan berhak bergantung pada budaya berorientasi data. Selain itu, kombinasi beberapa data analitik ke dalam dasbor yang disederhanakan tentu saja merupakan salah satu alasan utama keberhasilannya.

Data terstruktur terbatas membantu pemilik bisnis dan pengusaha untuk membuat keputusan yang optimal berdasarkan bukti yang dikumpulkan. Namun, pola ini berlaku untuk manajer yang biasa membuat keputusan berdasarkan desain pemodelan sederhana dan data statistik deskriptif.

Sumber

Penggunaan dan diversifikasi metrik untuk bisnis yang berbeda juga bergantung pada komunikasi antara karyawan dan manajer. Aturan yang sama berlaku ketika menyangkut kemampuan karyawan dan manajer untuk membuang duplikasi dan penyimpanan untuk tujuan yang benar.

Meskipun faktanya tetap ada – penilaian risiko dan pengambilan keputusan yang berani selalu menjadi kebutuhan saat ini untuk bersaing di pasar. Selain itu, kebebasan untuk mengakses sejumlah besar data dan visualisasi tetap menjadi bagian dari solusi.

Konon, budaya data-centric yang melibatkan angka statistik, rata-rata, jalur distribusi, dan median ini mungkin sulit dipahami oleh sejumlah orang. Dan itulah alasan file dump tidak membebani individu yang ingin membuat keputusan cepat dan kuat berdasarkan data analitik yang tersedia.

Ketika budaya data yang berkembang tampaknya berkembang – pengambilan keputusan yang kalkulatif menjadi lebih bergantung pada kepercayaan yang dituangkan dalam pengumpulan data.

Pipeline Data dan Peran Estetika Visual

Terlepas dari proses fungsional, saluran pipa harus membentuk analisis visual terbaik yang dapat dilihat oleh pikiran manusia melalui paralelisasi, tampilan, dan perancangan yang akurat. Visualisasi berlapis melengkapi sebagai tujuan akhir dari keseluruhan proses. Dan itu tidak hanya menguntungkan pengguna, tetapi juga pemasar.

Aturan yang sama berlaku untuk vitalitas komunikasi. Apa gunanya membuat jaringan saraf yang rumit dan menyoroti model yang sedang tren jika tidak dapat memunculkan pola nada dasar dan pengenalan nilai di antara orang-orang?

Tentu, bisnis dapat menjalankan metrik langsung atau menggunakan model analitik tingkat lanjut; selama orang-orang dapat menavigasi dan memahami antarmuka untuk analisis menyeluruh. Demikian pula, kesenjangan antara setiap pipa kode harus sempit sehingga pengguna dapat membuat modifikasi tertentu sesuai kebutuhan mereka sendiri.

Anda mungkin ingin memperhatikan bahwa tidak ada gaya estetika visual yang pasti. Itu perlu mengalami perubahan, revisi, penemuan kembali, dan menghubungkan ke tren baru yang menawan. Korelasi ini hampir dapat diraba oleh pembuat kode yang memahami bagaimana pemantauan dapat membuat semua perbedaan.

Manfaat Pipa Data

- Sederhana dan Efektif

Meskipun jalur pipa data mungkin memiliki infrastruktur yang kompleks dan proses yang berfungsi, penggunaan dan navigasinya cukup mudah. Demikian pula, proses pembelajaran membangun saluran data dapat dicapai melalui praktik umum (JVM) bahasa Java Virtual Machine untuk membaca dan menulis file.

Tujuan yang mendasari pola dekorator , di sisi lain, adalah untuk mengubah operasi yang disederhanakan menjadi operasi yang kuat. Pemrogram menghargai lebih dari siapa pun kemudahan akses dalam hal pemipaan data.

- Kompatibilitas dengan Aplikasi

Sifat tertanam dari pipa data membuatnya lebih mudah digunakan untuk pelanggan dan ahli strategi pemasaran digital. Kompatibilitasnya yang pas mencegah kebutuhan untuk menginstal, memiliki file konfigurasi, atau mengandalkan server. Anda dapat memiliki akses data lengkap hanya dengan menyematkan pipa data ukuran kecil ke dalam aplikasi.

- Fleksibilitas Metadata

Pemisahan bidang kustom dan catatan adalah salah satu ciri efisien dari pipa data. Metadata memungkinkan Anda melacak sumber data, pembuat , tag , instruksi , perubahan baru , dan opsi visibilitas .

- Komponen bawaan

Meskipun opsi yang dapat disesuaikan dapat diakses oleh Anda, pipeline data memiliki komponen bawaan yang memungkinkan Anda memasukkan atau mengeluarkan data dari pipeline. Setelah aktivasi internal, Anda dapat mulai bekerja dengan data melalui operator streaming.

Sumber

- Segmentasi Data Real-Time Cepat

Baik data Anda disimpan dalam bentuk file excel, di platform media sosial online, atau di basis data jarak jauh – saluran data dapat memecah data menjadi potongan-potongan kecil yang pada dasarnya merupakan bagian dari alur kerja streaming yang lebih besar.

Dan fungsi waktu nyata tidak memerlukan waktu yang lama untuk memproses data Anda. Akibatnya, ini menyisakan ruang gerak bagi Anda untuk memproses dan menyimpulkan data yang ada dengan lebih mudah.

- Pemrosesan dalam memori

Dengan tersedianya jalur pipa data, Anda tidak perlu menyimpan atau menyimpan perubahan baru pada data dalam file, disk, atau database acak. Pipeline menggunakan fungsi dalam memori yang membuat aksesibilitas data lebih cepat daripada menyimpannya dalam disk.

Era Data Besar

Penggunaan istilah ' big data' sering disalahgunakan. Ini lebih merupakan istilah yang lebih luas yang berkaitan dengan apa yang telah terjadi dalam beberapa tahun terakhir di dunia analitis. Tetapi tujuan dari alat integrasi data besar sebagian besar adalah untuk mengumpulkan acara dan banyak sumber untuk membuat dasbor yang komprehensif. Sekarang, ingat, Anda dapat merakit, menggandakan, membersihkan, mengubah, dan membuat ulang data yang tersedia untuk memiliki fungsionalitas navigasi yang lancar dengan alat perangkat lunak analisis data ini.

Sumber

Selain itu, sebagian besar alat yang tersedia dapat berkomunikasi dengan file besar, database, banyak perangkat seluler, IoT, layanan streaming, dan API. Selanjutnya, proses komunikasi ini membuat catatan di penyimpanan cloud atau perangkat lunak lokal. Alat SaaS ETL seperti analisis bajak salju , data jahitan , atau lima tran, misalnya , hadir dengan driver dan plug-in tambahan untuk membuat integrasi semulus mungkin.

Yang mengatakan, pengambil keputusan telah menyadari bahwa alat ini hanyalah sarana untuk mencapai tujuan. Mereka melayani tujuan mengambil dan menyimpan data tidak terstruktur. Bisnis, di sisi lain, sudah mulai memahami bahwa jalur pipa data mungkin telah membuka pintu baru untuk mengumpulkan data analitik, tetapi tanggung jawab untuk membuat keputusan logis masih ada pada mereka.

Pikiran Akhir

Keunggulan teknologi data pipeline akan terus meningkat untuk mengakomodasi segmen data yang lebih besar dengan kemampuan transformasional. Konon, tren futuristik dari jalur pipa data hampir sama vitalnya dengan satu dekade lalu. Proses baru untuk saluran data yang dipantau dengan baik selalu ada di depan mata. Dan kebutuhan untuk mencapai desain yang sempurna, kepatuhan, efisiensi kinerja, skalabilitas yang lebih tinggi, dan desain yang menarik tentu saja sedang menuju peningkatan.

Improvado adalah solusi saluran data #1 untuk pemasar. Alat ETL yang digunakan untuk mengekstrak, mengubah, dan memuat data dari lebih dari 150 platform pemasaran yang berbeda ke tujuan akhir apa pun, seperti alat BI atau gudang data. Pelajari lebih lanjut di sini.

Rekomendasi kami:

Lihat Alat & Perangkat Lunak Analisis Pemasaran Terbaik untuk tahun 2022

14 Alat ETL Terbaik Untuk Bisnis Perusahaan untuk Dicoba pada tahun 2021

Cara Merampingkan Data dari Snowflake ke Tableau [Dua Cara Mudah]