Webスクレイピング - データサイエンスの不可欠な部分

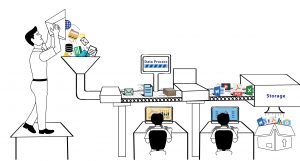

公開: 2020-02-21Web スクレイピングはデータ サイエンスの不可欠な部分となり、それ自体がエコシステムであり、この用語はしばしば機械学習、人工知能などの代わりとして使用されるようになりました。 データ サイエンス エコシステムは、ライフサイクル全体を構成する 5 つの異なる段階で構成されています。 各ステップは、そのステップを完了するために使用される複数のオプションで構成されています-

ウェブスクレイピング方法:

データ収集

- Web スクレイピングなどのプロセスを使用したデータ抽出。

- 手動データ入力。

- データ取得 - データセットの購入による。

- IoT デバイスからの信号のキャプチャ。

情報処理

- データマイニング。

- 生データの分類またはクラスタリング。

- データのクリーニングと正規化。

- データモデリング。

メンテナンス

- データ ウェアハウジングとデータ レイク。

- データを管理および保存し、最大限の可用性を提供するためのインフラストラクチャを構築します。

調査結果の伝達

- グラフを使用した調査結果の視覚化。

- 調査結果をテキスト レポートに要約します。

- ビジネス インテリジェンスと意思決定。

分析

- 探索的および確認的分析。

- 予測分析。

- 回帰。

- テキストマイニング。

- 感情と質的分析。

上記のリストからわかるように、データ サイエンスの分野では、アルゴリズムを実行したいデータを持つデータ キャプチャがなければ何も起こりません。 この最初のステップは非常に重要であり、主要なビルディング ブロックです。 毎日テラバイト単位の使用可能なデータを生成するシステムを持っていない限り、おそらくここでの選択肢は、Web からデータをクロールしてデータベースに保存し、その上でアルゴリズムを実行して予測エンジンを構築することです。

データ サイエンティストが Web スクレイピングに使用できるツールは何ですか?

あなたがデータ サイエンティストで、コードを記述してインターネットからデータをクロールする必要がある場合は、 Pythonを使用してコードを記述することができます。 学習曲線が簡単になるだけでなく、コードを介して自動化された方法で Web サイトとやり取りすることもできます。 コードを使用すると、Web ブラウザーを使用するときと同じように、Web サイトが要求を受け取るような方法で Web サイトと対話できます。 スクレイピング要件を自動化したり、タイムリーなスクリプトを実行したり、(Twitter などのソーシャル メディア Web サイトからの) データの安定したフィードを維持したりして、データ サイエンス プロジェクト用のデータセットを構築することもできます。 プロジェクトのデータをスクレイピングするときに人々が直面するさまざまな課題に取り組むのに役立つ Python で利用可能なライブラリの一部を次に示します。

リクエスト

コードを使用して Web からデータをクロールする場合、最初の目的は、コードを使用して Web サイトにアクセスすることです。 そこでリクエストライブラリの出番です。これは、Web ページや API を簡単に呼び出すことができるため、Python コミュニティの間で人気があります。 これにより、多くのボイラープレート コードが抽象化され、組み込みの URLLib ライブラリを使用する場合よりも HTTP 要求が単純になります。 ブラウザ スタイルの SSL 検証、ヘッドレス リクエスト、コンテンツの自動デコード、プロキシ サポートなど、いくつかの機能が含まれています。

美しいスープ

Web からスクレイピングした Web ページを作成したら、HTML ページのタグと属性からデータを抽出する必要があります。 このためには、すべてのデータに簡単にアクセスできるように、HTML コンテンツを解析する必要があります。 BeautifulSoupを使用すると、ナビゲート、検索、および変更が簡単になる方法で、HTML および XML ドキュメントを簡単に解析できます。 ドキュメントをツリーのように扱い、ツリーのデータ構造をナビゲートするのと同じ方法でナビゲートできます。

メカニカルスープ

より複雑な Web サイトと対話する場合。 多くの Web ページをクロールするのに役立つ拡張機能が必要になる場合があります。 Mechanical Soupは、Cookie の保存と送信の自動化に役立ち、リダイレクトを許可し、リンクをたどり、フォームを送信することもできます。

スクレイピー

最も強力な Python ベースの Web スクレイピング ライブラリの 1 つであるScrapyは、オープンソースの共同フレームワークを提供します。 これは、データ マイニング操作、自動化されたスパイダー、Web の定期的なクロールを設定するために使用される高レベルのスクレイピング ライブラリです。 Scrapy はスパイダーと呼ばれるものを使用します。 これらは、Web ページから情報を抽出するために使用されるユーザー定義のクラスです。

セレン

通常、 SeleniumはWeb ページとその機能のテストに使用されますが、スクリーンショットを使用した Web からのデータのスクレイピング、クリックの自動化、公開されたデータのスクレイピングなどの自動手動タスクにも使用できます。

Web スクレイピング vs 他のデータ ソース:

現在利用可能なデータ ソースは複数ありますが、Web スクレイピングは、企業がデータを調達する (最終的に処理され、使用可能な情報に変換される) 最も一般的なプロセスの 1 つとして浮上しています。 この背後にある最大の理由の 1 つは、データ サイエンス プロジェクトに取り組んでいるとき、未使用の新しいデータを使用して、これまでに得られたことのない論文を作成したり、結果を予測したりすることを好むからです。 データは新しいオイルですが、時間の経過とともにデータの価値は低下します。 このように、Web 上のデータは毎秒更新されるため、Web スクレイピングは天の恵みです。 新しいデータに置き換えられない限り有効です。 たとえば、Web サイトのアイテムの価格はおそらく 1000 ドルです。

レポートを探して、ソースから価格表を取得できます。 価格表が 1000 ドルのマークであなたに届く頃には、アイテムの価格は 900 ドルに下がっている可能性があります。 したがって、手元にある価格に基づくあなたの決定は間違っていることが判明するでしょう. 代わりに、アイテムの価格を今クロールすると、その時点での価格が表示されます。 次に、定期的な頻度でスクレイパーを実行し続けて、10 秒ごとに価格の変化をキャプチャできます。 したがって、決定を下すためにデータを手元に置くと、更新されたデータと履歴データの両方が得られ、結果を改善できます。 Webスクレイピングが提供するのは、終わりのないデータの安定したストリームです。 これが、マーケティング マネージャーによるものであろうと研究科学者によるものであろうと、データ サイエンスの主な理由です。

データ サイエンスでスクレイピングされたデータを使用する際の課題:

Web スクレイピングで取得するデータは膨大で定期的です。 重要な事実は、Web から抽出されたデータには、通常、大量の汚れた構造化されていないデータが含まれているということです。 また、重複や検証されていないデータ ポイントの存在も見られます。 データ ソースを正しく取得することは重要であるため、データは常に検証済みの既知の Web サイトからクロールする必要があります。 同時に、データを確認するために多くのデータ ソースが使用されました。 データをクリーンアップし、重複がないことを確認するには、インテリジェントなコーディングを使用して取り組みます。 しかし、非構造化データを構造化データに変換することは、依然として最も困難な Web スクレイピングの問題の 1 つであり、解決策はケースごとに異なります。

もう 1 つの大きな問題は、セキュリティ、合法性、およびプライバシーから生じます。 データのプライバシーを規定し、データへのアクセス制限を強化する国がますます増えているため、ログイン ページからのみアクセスできる Web サイトがますます増えています。 データをクロールしない限り、同様のペナルティが発生する可能性があります。 それはあなたの IP がブロックされることから始まり、あなたに対する訴訟に発展する可能性があります。

結論:

すべての機会には課題が伴います。 挑戦が大きければ大きいほど、報酬は高くなります。 したがって、Web スクレイピングをビジネス ワークフローに統合する必要があり、データ サイエンス プロジェクトではそのデータから有用な情報を生成する必要があります。 しかし、あなたの会社やスタートアップのウェブサイトからデータをスクレイピングするサポートが必要な場合は、 PromptCloudのチームが完全に管理された DaaS ソリューションを提供します。ここでは、要件を教えていただければ、スクレイピング エンジンをセットアップします。