Пасхальные яйца Robots.txt — сделайте инструкции для роботов интересными для людей!

Опубликовано: 2021-10-28Пасхальные яйца обычно ассоциируются с предметами, которые вы находите во время охоты, потратив время на их поиски в неизвестных местах, без четких указаний, где искать. Поскольку поиск требует некоторого времени и усилий, найти их в конечном итоге полезно.

Все это также верно для пасхальных яиц, найденных в технических продуктах.

Сегодня я хочу посмотреть на пасхалки в файлах robots.txt. Я объясню концепцию пасхальных яиц и файлов robots.txt и почему разработчики могут включать в них пасхальные яйца.

Я также отправился на собственную охоту за пасхальными яйцами, чтобы определить, сколько форм могут принимать пасхальные яйца в файлах robots.txt. Как оказалось - много!

Читайте дальше и обязательно дочитайте эту статью до конца — у меня будет для вас задание!

Что такое пасхалки в технологиях?

Под пасхалками в технике понимаются недокументированные фичи или программные части, которые не нужны для работы продукта. Эти функции не раскрываются открыто и не передаются пользователям, которым нужно искать их без особых указаний.

Пасхальные яйца обычно можно найти в видеоиграх, программах, приложениях, программном обеспечении и частях веб-сайтов.

Они бывают разных форм, например:

- чит-коды в игре, открывающие дополнительные функции или уровни,

- культурные ссылки, появляющиеся на скрытых страницах или других веб-документах,

- игры или приложения, расположенные в программном обеспечении, созданном для других целей, например, для написания и редактирования текстовых документов,

- сообщения, оставленные разработчиками, например те, в которых упоминаются создатели продукта.

Список можно продолжать, и нет никаких ограничений на то, какими могут быть пасхальные яйца.

Но это еще не все.

Для меня пасхалки — это человеческое прикосновение к машинной среде, для которой характерна богатая логика и конкретные правила.

Пасхальные яйца выходят за рамки этих строгих правил. Это способ для создателей добавить уникальный элемент с человеческим лицом в свой технологический продукт. Включение пасхальных яиц делает весь опыт использования данного технологического продукта более увлекательным и может быть удовольствием для несгибаемых поклонников, в зависимости от продукта.

Перейдем к пасхалкам, которые можно найти в файлах robots.txt сайтов.

Пасхальные яйца и файлы robots.txt

Найти пасхалки в файлах robots.txt проще, чем во многих других случаях — вам нужно просто получить доступ к файлу robots.txt сайта.

В файлах robots.txt есть множество примеров пасхальных яиц. Эти файлы предназначены для чтения и отслеживания роботами; следовательно, пасхальные яйца должны быть добавлены таким образом, чтобы это было понятно только людям.

Давайте проясним, что такое файлы robots.txt и не повлияет ли добавление пасхальных яиц на чтение файла роботами.

Что такое файлы robots.txt?

Файл robots.txt находится в корне вашего домена и содержит набор директив для сканеров поисковых систем, сообщающих им, как сканировать страницы на веб-сайте.

Каждая директива блокирует или разрешает доступ определенному сканеру к пути к файлу на сайте. Если в robots.txt не указано иное, роботы могут сканировать все файлы на веб-сайте.

Директивы в файле robots.txt позволяют максимально увеличить краулинговый бюджет, чтобы робот Googlebot не тратил его на нерелевантные страницы вашего сайта.

Может ли добавление пасхальных яиц повредить файл robots.txt?

Файлы robots.txt имеют определенный формат, о котором вы можете узнать подробнее в рекомендациях Google по добавлению правил robots.txt .

Поисковые системы игнорируют любые символы или команды, которые появляются в файле robots.txt после хэштега, поэтому включение пасхальных яиц, которым предшествует хэштег, не повлияет на то, как роботы понимают эти файлы.

Пасхальные яйца также, как правило, размещаются в документах или местах, к которым пользователи не могут легко получить доступ, и это верно в отношении файлов robots.txt. Как правило, на них нет ссылок с других страниц, и пользователи не могут перейти к ним, просто нажав кнопку на веб-сайте.

Зачем добавлять пасхалку в файл robots.txt?

Поскольку вы можете добавлять текст в файлы robots.txt, которые могут быть прочитаны только людьми, почему бы не использовать эту возможность для создания эксклюзивного контента в дополнение к вашим маркетинговым усилиям?

Вы можете добавлять пасхалки в файл robots.txt по многим причинам, помимо развлечения пользователей.

Например, содержимое файла robots.txt также может:

- Повысьте узнаваемость вашего бренда

- Продемонстрируйте бренд вашего работодателя

Этого можно достичь несколькими способами. Ты сможешь:

- Внедрите собственный брендинг, например, добавьте свой логотип или слоган.

- Обратитесь к услугам или продуктам, которые вы предлагаете, или к вашей компании как к рабочей среде.

- Поощряйте посетителей откликаться на ваши предложения о работе — таким образом вы ориентируетесь только на выбранную группу людей, которые посещают ваш файл robots.txt. Вы можете сделать это специально, чтобы пригласить гиков присоединиться к вашей команде разработчиков или SEO!

- Создавайте актуальный и оригинальный контент. Он может тематически соответствовать назначению файла robots.txt, например, обращаться к роботам, включать юмористические ссылки на них, поисковые системы или другие темы, такие как поп-культура. Включение подобного беззаботного контента может сделать ваш бренд более доступным и ориентированным на пользователя.

Выберите подход, который покажет ваш бренд в лучшем свете и станет уникальным активом в отношении того, как пользователи воспринимают ваш бренд.

Примеры пасхалок в robots.txt

Давайте посмотрим на примеры пасхальных яиц в файлах robots.txt и посмотрим, какие типы сообщений мы можем в них найти.

Killer-robots.txt от Google

Файл killer-robots.txt от Google был памятным пасхальным яйцом, созданным к 20-летию директивы robots.txt, доступной для веб-мастеров. С тех пор он был удален, но остается одним из самых известных примеров пасхальных яиц в файлах robots.txt.

Вот текст, который Google включил:

Агент пользователя: T-1000

Агент пользователя: T-800

Запретить: /+LarryPage

Запретить: /+СергейБрин

Т-800 — это Терминатор, которого Арнольд Шварценеггер изобразил в знаменитом фильме. Т-1000 — робот-убийца из фильма « Терминатор 2 » . Директивы, включенные в этот файл, не позволяют Т-800 и Т-1000 убить основателей Google Ларри Пейджа и Сергея Брина.

Найк

Nike включает свой брендинг в файл robots.txt, добавляя юмористический слоган своего бренда. Он сочетается со ссылкой на поисковые системы:

Nike развивает эти особенности бренда еще больше, добавляя свой логотип:

Облачная вспышка

Cloudflare лично обращается к роботам. Это начинается так:

И заканчивается тем, что робот отвечает на запрос и соглашается ему следовать:

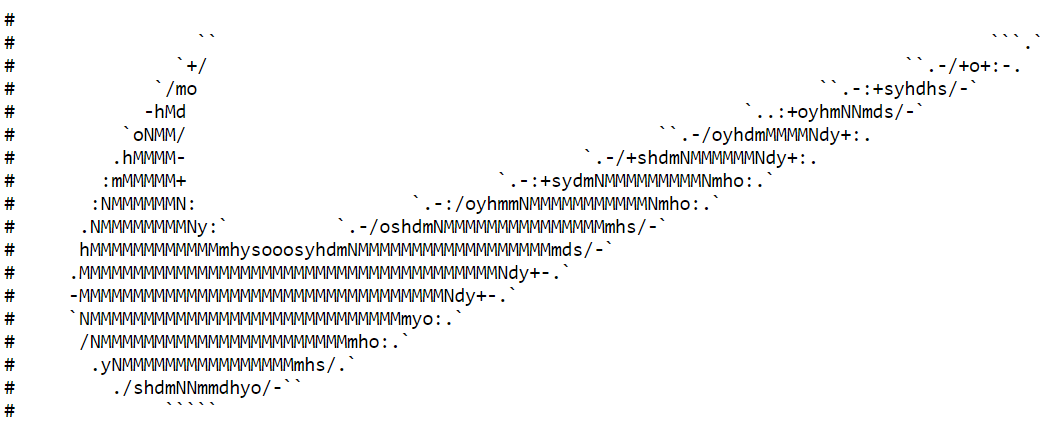

YouTube

Youtube ссылается на роботов и обращается к антиутопическому будущему, в котором они доминируют:

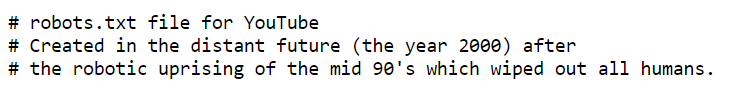

Стеклянная дверь

Glassdoor — это веб-сайт, который позволяет сотрудникам просматривать компании, просматривать предлагаемые ими зарплаты, искать работу на платформе и многое другое. Их файл robots.txt соответствует теме работы . Директивы в файле поощряют SEO-специалистов, которые отваживаются заглянуть в свой файл robots.txt, подать заявку на одну из своих вакансий:

Этси

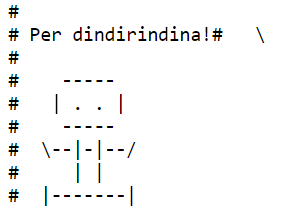

Сообщение Etsy кажется итальянским «ради всего святого!» и включает в себя простое изображение в форме… робота, конечно:

Визг

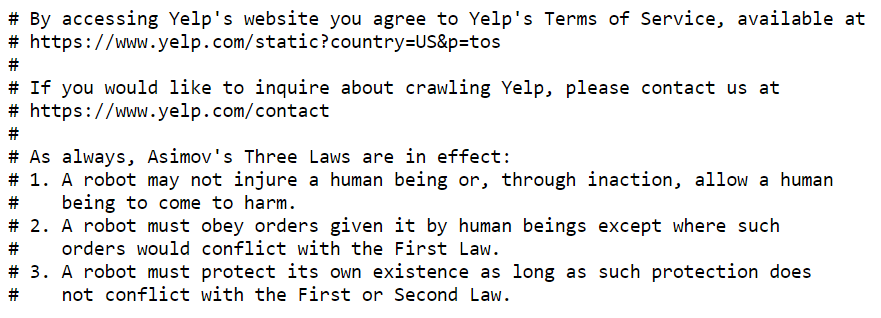

Yelp цитирует известного писателя-фантаста Айзека Азимова и его «Три закона робототехники» . Азимов представил эти законы в рассказе 1942 года, а затем использовал их в качестве основы для своих романов.

Законы — это этическая система для людей и роботов, и файл robots.txt можно рассматривать именно как способ взаимодействия людей и роботов и получения взаимной выгоды:

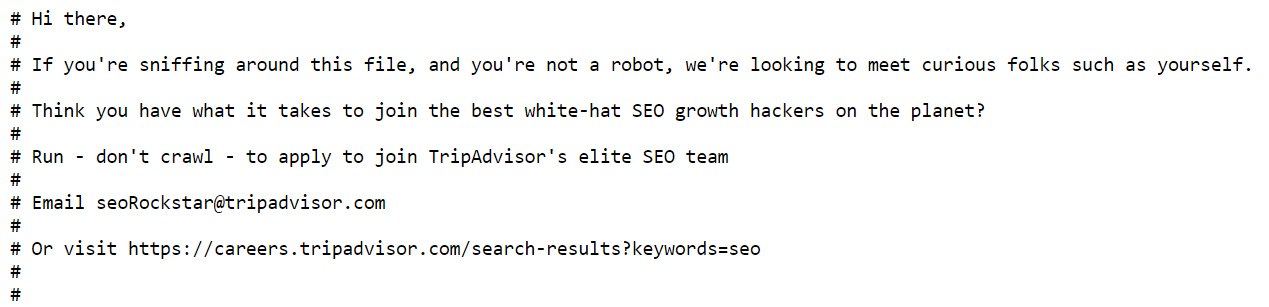

Tripadvisor

Как и Glassdoor, Tripadvisor ценит любопытство людей и просит охотников за пасхальными яйцами подать заявку и стать членами их команды SEO:

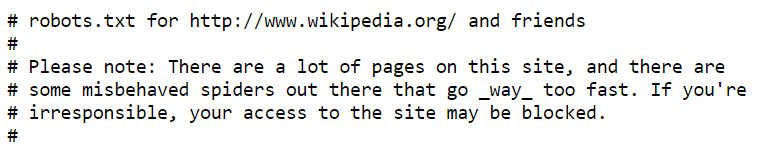

Википедия

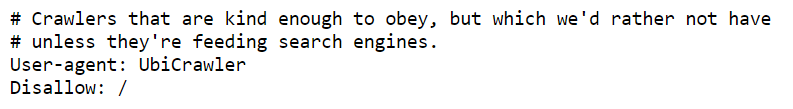

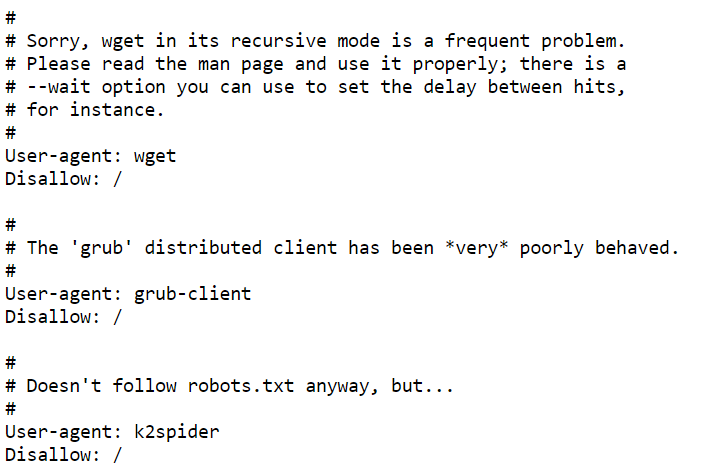

Файл robots.txt Википедии содержит несколько сообщений — вот лишь некоторые из них:

Эти директивы комментируют поведение роботов — поскольку их могут читать только люди, это способ пошутить над роботами. Он показывает забавную, беззаботную сторону Википедии, которая контрастирует с тем, что мы от нее ожидаем — серьезными, проверенными фактами статьями.

Мерриам Вебстер

Merriam Webster напоминает всем, у кого есть доступ к файлу, «внимательно редактировать»:

Это двойное напоминание о том, что любые директивы, включенные в файлы robots.txt, должны быть тщательно спланированы и помещены в файл — ведь ошибки могут помешать роботам правильно сканировать сайт.

Кричащая лягушка

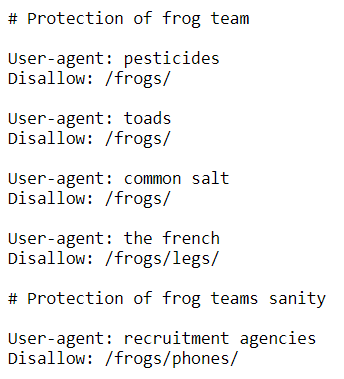

Screaming Frog включала юмористические директивы, касающиеся названия компании:

Но это нечто большее, чем просто забавная отсылка. Включение этих директив помогает повысить узнаваемость бренда. Упоминание «защиты команды лягушек» можно рассматривать как пример брендинга работодателя.

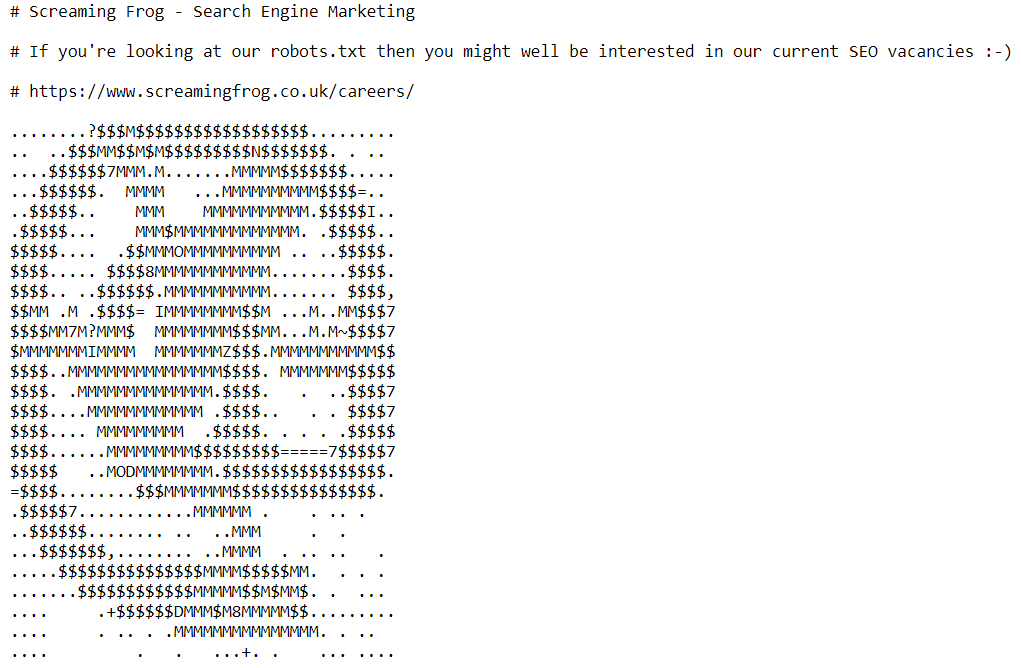

Далее в файле robots.txt находим приглашение присоединиться к SEO-команде компании:

Земля поисковой системы

Search Engine Land обращается к людям, которые могут прочитать следующее сообщение — потому что роботы не могут — признавая, что могут быть не роботы, которые посещают их файл robots.txt. Также есть отсылка к Battlestar Galactica:

Люди.txt

Интернет должен быть о людях, а не только о роботах.

Если есть файл robots.txt для роботов, то он должен быть и для людей.

Это идея, стоящая за файлом human.txt , который был создан в качестве контринициативы файлам robots.txt. Как мы читаем на его официальном сайте:

«Это инициатива для знакомства с людьми, стоящими за веб-сайтом. Это файл TXT, который содержит информацию о разных людях, которые внесли свой вклад в создание веб-сайта».

Файл .txt не мешает коду, и это простой способ доказать авторство сайта.

Вот текст, который содержит файл Google human.txt :

«Google создан большой командой инженеров, дизайнеров, исследователей, роботов и других специалистов на разных площадках по всему миру. Он постоянно обновляется и использует больше инструментов и технологий, чем мы можем себе представить. Если вы хотите нам помочь, посетите сайт careers.google.com».

Другие веб-сайты тоже используют его и часто становятся более креативными — взгляните на файлы Humans.txt Netflix и Medium .

Следующие шаги

Теперь, когда вы увидели примеры пасхальных яиц, найденных в файлах robots.txt, чувствуете ли вы вдохновение оставить пасхалки для своих пользователей?

Мы сделали!