Uova di Pasqua Robots.txt: rendi le tue direttive sui robot divertenti per gli umani!

Pubblicato: 2021-10-28Le uova di Pasqua sono generalmente associate agli oggetti che trovi durante una caccia, dopo aver trascorso del tempo a cercarli in luoghi sconosciuti, senza una chiara guida su dove cercare. Poiché la ricerca richiede tempo e fatica, è gratificante trovarli alla fine.

Tutto questo vale anche per le uova di Pasqua che si trovano nei prodotti tecnologici.

Oggi voglio guardare le uova di Pasqua nei file robots.txt. Spiegherò il concetto di uova di Pasqua e file robots.txt e perché gli sviluppatori possono includere le uova di Pasqua in essi.

Sono anche andato a caccia di uova di Pasqua per determinare quante forme possono assumere le uova di Pasqua nei file robots.txt. A quanto pare - molti!

Continua a leggere e assicurati di arrivare alla fine di questo articolo: avrò un compito per te!

Cosa sono le uova di Pasqua nella tecnologia?

Le uova di Pasqua in tecnologia sono intese come funzionalità non documentate o pezzi di software che non sono necessari per il funzionamento del prodotto. Queste funzionalità non vengono rivelate o condivise apertamente con gli utenti che devono cercarle senza molta guida.

Le uova di Pasqua si trovano comunemente in videogiochi, programmi, app, software e parti di siti Web.

Sono disponibili in molte forme, come ad esempio:

- codici cheat in un gioco che scoprono funzionalità o livelli aggiuntivi,

- riferimenti culturali che appaiono su pagine nascoste o altri documenti web,

- giochi o app che si trovano in software realizzati per altri scopi, ad esempio, scrivere e modificare documenti di testo,

- messaggi lasciati dagli sviluppatori, ad esempio, quelli che danno credito ai creatori del prodotto.

L'elenco potrebbe continuare e non ci sono limiti a ciò che possono essere gli easter egg.

Ma c'è di più.

Per me le uova di Pasqua sono un tocco umano in un ambiente macchina caratterizzato da logiche abbondanti e regole concrete.

Le uova di Pasqua infrangono queste rigide regole. Sono un modo per i creatori di aggiungere un elemento unico con un volto umano al loro prodotto tecnologico. L'inclusione delle uova di Pasqua rende l'intera esperienza di utilizzo di un determinato prodotto tecnologico più divertente e potrebbe essere un piacere per i fan sfegatati, a seconda del prodotto.

Passiamo agli easter egg che possiamo trovare nei file robots.txt dei siti.

Uova di Pasqua e file robots.txt

Trovare le uova di Pasqua nei file robots.txt è meno complicato che in molti altri casi: devi semplicemente accedere al robots.txt di un sito.

Ci sono numerosi esempi di uova di Pasqua nei file robots.txt. Questi file sono pensati per essere letti e seguiti dai robot; quindi le uova di Pasqua dovrebbero essere aggiunte in un modo comprensibile solo per gli esseri umani.

Chiariamo cosa sono i file robots.txt e se l'aggiunta di easter egg non influirà sul modo in cui i robot leggono il file.

Cosa sono i file robots.txt?

Un file robots.txt risiede nella radice del tuo dominio e contiene una serie di direttive per i crawler dei motori di ricerca, che indicano loro come eseguire la scansione delle pagine di un sito web.

Ogni direttiva blocca o consente l'accesso per un crawler specifico a un percorso di file in un sito. Salvo diversamente specificato in robots.txt, i robot possono eseguire la scansione di tutti i file su un sito web.

Le direttive in un file robots.txt sono un modo per massimizzare il tuo budget di scansione, quindi Googlebot non lo spreca su pagine irrilevanti del tuo sito.

L'aggiunta di uova di Pasqua può danneggiare il tuo file robots.txt?

I file Robots.txt seguono un formato specifico di cui puoi leggere di più nelle linee guida di Google sull'aggiunta di regole robots.txt .

I motori di ricerca ignorano tutti i simboli o i comandi che appaiono nel file robots.txt dopo un hashtag, quindi l'inclusione di easter egg preceduti da un hashtag non influirà sul modo in cui i robot interpretano questi file.

Le uova di Pasqua tendono anche a essere collocate in documenti o posizioni a cui gli utenti non possono accedere facilmente, e questo è vero per i file robots.txt. In genere non sono collegati ad altre pagine e gli utenti non possono accedervi semplicemente facendo clic su un pulsante su un sito web.

Perché dovresti aggiungere un easter egg al tuo file robots.txt?

Dal momento che puoi aggiungere testo ai file robots.txt che possono essere letti solo dagli esseri umani, perché non sfruttare questa opportunità per creare contenuti esclusivi per integrare le tue attività di marketing?

Puoi aggiungere easter egg al tuo file robots.txt per molte ragioni oltre a fornire intrattenimento agli utenti.

Ad esempio, il contenuto del tuo robots.txt può anche:

- Aumenta la consapevolezza del tuo marchio

- Metti in mostra il tuo marchio del datore di lavoro

Questo può essere ottenuto in diversi modi. Puoi:

- Implementa il tuo marchio, ad esempio includi il tuo logo o slogan.

- Fare riferimento ai servizi o prodotti che offri o alla tua azienda come ambiente di lavoro.

- Incoraggia i visitatori a candidarsi alle tue offerte di lavoro: in questo modo, ti rivolgi solo a un gruppo selezionato di persone che visitano il tuo robots.txt. Puoi farlo soprattutto per invitare i fanatici a unirsi al tuo team di sviluppo o SEO!

- Crea contenuti pertinenti e originali. Può corrispondere tematicamente allo scopo del file robots.txt, ad esempio indirizzare i robot, includere riferimenti umoristici ad essi, motori di ricerca o altri argomenti, come la cultura pop. Includere contenuti spensierati come questo può far sembrare il tuo marchio più accessibile e orientato all'utente.

Scegli un approccio che mostri il tuo marchio nella luce migliore e rappresenti una risorsa unica per il modo in cui gli utenti percepiscono il tuo marchio.

Esempi di uova di Pasqua in robots.txt

Diamo un'occhiata agli esempi di easter egg nei file robots.txt e vediamo i vari tipi di messaggi che possiamo trovare in essi.

Killer-robots.txt di Google

Il file killer-robots.txt di Google era un easter egg memorabile creato per il 20° anniversario della messa a disposizione dei webmaster della direttiva robots.txt. Da allora è stato rimosso ma rimane uno degli esempi più famosi di uova di Pasqua nei file robots.txt.

Ecco il testo che Google ha incluso:

User-Agente: T-1000

User-Agente: T-800

Non consentire: /+LarryPage

Non consentire: /+SergeyBrin

T-800 è il Terminator interpretato da Arnold Schwarzenegger nel famoso film. T-1000 è il robot assassino del film Terminator 2 . Le direttive incluse in questo file impediscono al T-800 e al T-1000 di uccidere i fondatori di Google Larry Page e Sergey Brin.

Nike

Nike incorpora il loro marchio nel file robots.txt includendo una versione umoristica del suo slogan del marchio. È combinato con un riferimento ai motori di ricerca:

Nike porta ulteriormente queste caratteristiche del marchio incorporando il loro logo:

Cloudflare

Cloudflare si rivolge ai robot personalmente. Inizia così:

E termina con il robot che risponde alla richiesta e accetta di seguirla:

Youtube

Youtube fa riferimento ai robot e si riferisce a un futuro distopico in cui sono dominanti:

Porta di vetro

Glassdoor è un sito Web che consente ai dipendenti di esaminare le aziende, visualizzare gli stipendi offerti, cercare lavoro sulla piattaforma e molto altro. Il loro file robots.txt segue il tema del lavoro . Le direttive nel file incoraggiano i fanatici della SEO che si avventurano nel loro file robots.txt a candidarsi per una delle loro posizioni:

Etsy

Il messaggio di Etsy sembra essere italiano per "per l'amor del cielo!" e include una semplice immagine a forma di... un robot, ovviamente:

Guaire

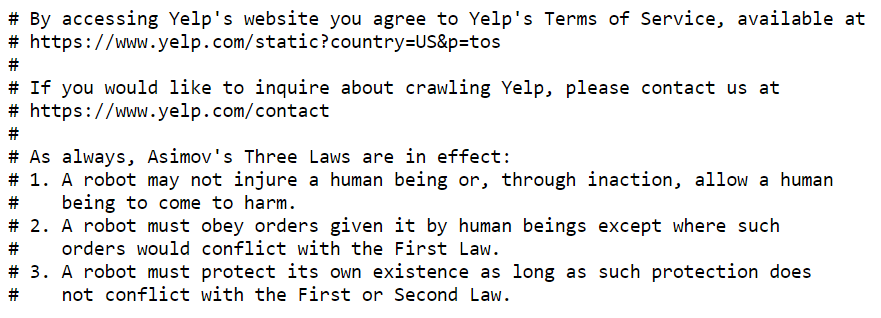

Yelp cita un famoso autore di fantascienza, Isaac Asimov, e le sue tre leggi della robotica . Asimov ha introdotto queste leggi in un racconto del 1942 e in seguito le ha utilizzate come base per i suoi romanzi.

Le leggi sono un sistema etico per esseri umani e robot, e un file robots.txt potrebbe essere visto esattamente come questo: un modo in cui esseri umani e robot possono interagire e trarre vantaggio reciproco da:

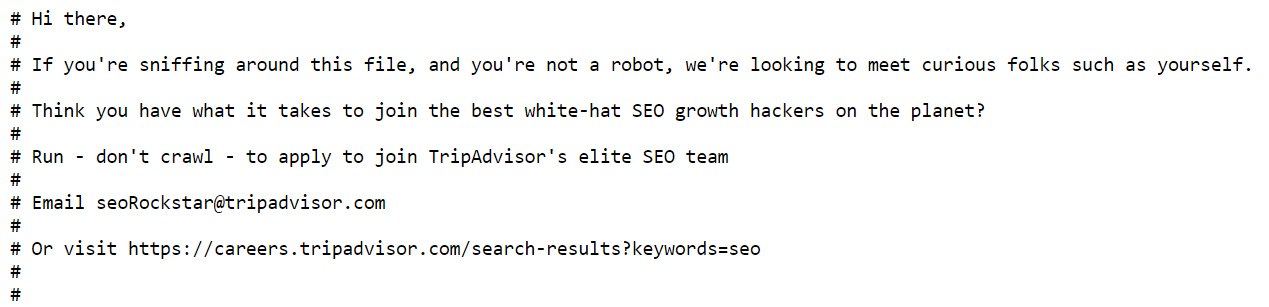

TripAdvisor

Analogamente a Glassdoor, Tripadvisor apprezza la curiosità delle persone e chiede ai cacciatori di uova di Pasqua di candidarsi e diventare membri del loro team SEO:

Wikipedia

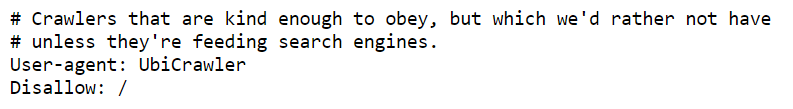

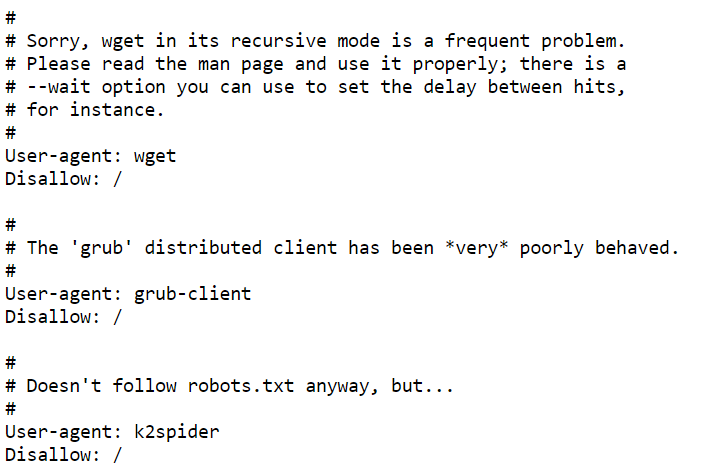

Il file robots.txt di Wikipedia contiene diversi messaggi, eccone solo alcuni:

Queste direttive commentano il comportamento dei robot: poiché solo gli esseri umani possono leggerle, è un modo per scherzare sui robot. Mostra il lato divertente e spensierato di Wikipedia, che è in contrasto con ciò che ci aspettiamo da essa: articoli seri e verificati.

Merriam Webster

Merriam Webster ricorda a chiunque abbia accesso al file di "modificare con cura":

Questo è un doppio promemoria sul fatto che qualsiasi direttiva inclusa nei file robots.txt deve essere pianificata con cura e inserita nel file: dopotutto, gli errori possono impedire ai robot di eseguire correttamente la scansione del sito.

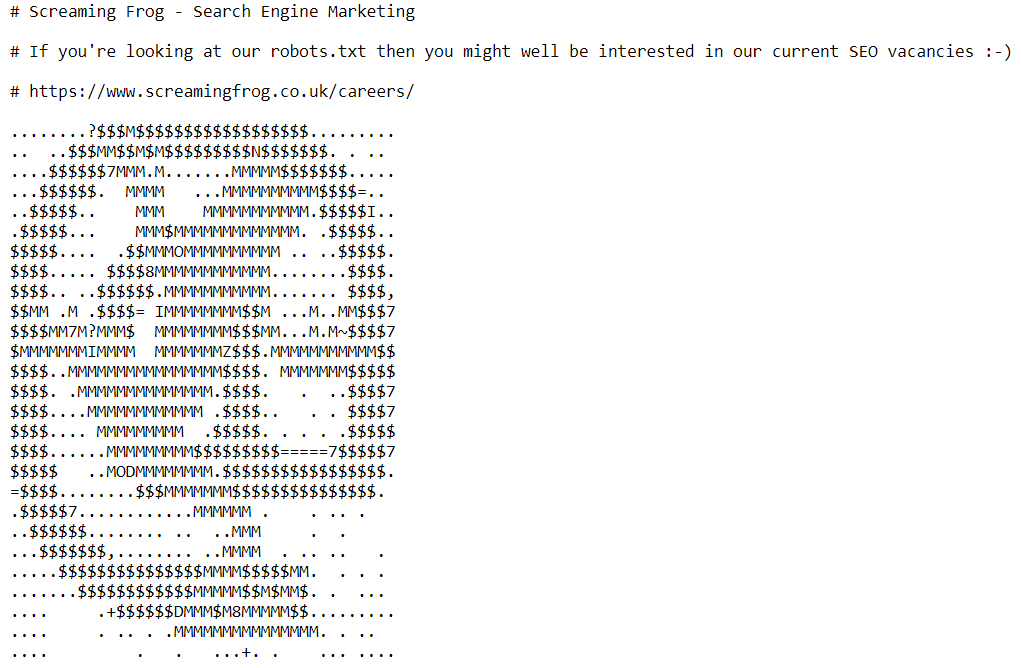

Rana urlante

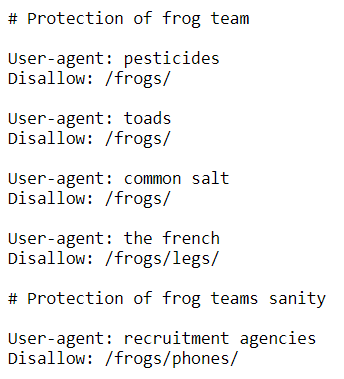

Screaming Frog includeva direttive umoristiche relative al nome dell'azienda:

Ma c'è di più che essere solo un riferimento divertente. L'inclusione di queste direttive aiuta a creare consapevolezza del marchio. Menzionare la "protezione del team di rana" potrebbe essere visto come un esempio di employer branding.

Più avanti nel file robots.txt, possiamo trovare un invito a entrare a far parte del team SEO dell'azienda:

Motore di ricerca Terra

Search Engine Land si rivolge alle persone che possono leggere il seguente messaggio, perché i robot non possono, riconoscendo che possono esserci non robot che visitano il loro file robots.txt. C'è anche un riferimento a Battlestar Galactica:

Umani.txt

Internet dovrebbe riguardare gli esseri umani, non solo i robot.

Se esiste un file robots.txt per i robot, dovrebbe essercene uno anche per gli esseri umani.

Questo è il pensiero alla base di human.txt , che è stato creato come controiniziativa ai file robots.txt. Come leggiamo sul suo sito ufficiale:

“È un'iniziativa per conoscere le persone dietro un sito web. È un file TXT che contiene informazioni sulle diverse persone che hanno contribuito alla costruzione del sito web”.

Un file .txt non è invadente con il codice ed è un modo semplice per dimostrare la paternità di un sito.

Ecco il testo che contiene il file human.txt di Google:

"Google è creato da un ampio team di ingegneri, designer, ricercatori, robot e altri in molti siti diversi in tutto il mondo. Viene aggiornato continuamente e costruito con più strumenti e tecnologie di cui possiamo scuotere un bastone. Se vuoi aiutarci, visita careers.google.com."

Anche altri siti Web lo usano e spesso diventano più creativi: guarda i file human.txt di Netflix e Medium .

Prossimi passi

Ora che hai visto esempi di easter egg trovati nei file robots.txt, ti senti ispirato a lasciare un easter egg per i tuoi utenti?

Noi facemmo!