Robots.txt Easter Eggs – spraw, aby dyrektywy dotyczące robotów były zabawą dla ludzi!

Opublikowany: 2021-10-28Pisanki zazwyczaj kojarzą się z przedmiotami znalezionymi podczas polowania, po spędzeniu czasu na ich poszukiwaniu w nieznanych miejscach, bez jasnych wskazówek, gdzie szukać. Ponieważ wyszukiwanie wymaga trochę czasu i wysiłku, znalezienie ich w końcu jest satysfakcjonujące.

Wszystko to dotyczy również jajek wielkanocnych znajdujących się w produktach technologicznych.

Dzisiaj chcę przyjrzeć się easter eggom w plikach robots.txt. Wyjaśnię pojęcie easter eggów i plików robots.txt oraz dlaczego programiści mogą w nich umieszczać easter eggi.

Poszedłem również na własne polowanie na jajka wielkanocne, aby określić, ile form mogą przybierać jajka wielkanocne w plikach robots.txt. Jak się okazuje – wielu!

Czytaj dalej i koniecznie dojdź do końca tego artykułu – mam dla Ciebie zadanie!

Czym są pisanki w technologii?

Pisanki w technologii rozumiane są jako nieudokumentowane funkcje lub elementy oprogramowania, które nie są niezbędne do działania produktu. Te funkcje nie są otwarcie ujawniane ani udostępniane użytkownikom, którzy muszą je wyszukiwać bez większych wskazówek.

Pisanki są często spotykane w grach wideo, programach, aplikacjach, oprogramowaniu i częściach stron internetowych.

Występują w wielu formach, takich jak:

- kody w grze, które odkrywają dodatkowe funkcje lub poziomy,

- nawiązania kulturowe pojawiające się na ukrytych stronach lub innych dokumentach internetowych,

- gry lub aplikacje znajdujące się w oprogramowaniu stworzonym do innych celów, np. pisania i edytowania dokumentów tekstowych,

- wiadomości pozostawione przez programistów, np. takie, które przypisują twórcom produktu.

Lista jest długa i nie ma ograniczeń co do tego, czym mogą być pisanki.

Ale jest w tym coś więcej.

Dla mnie pisanki to ludzki dotyk w środowisku maszynowym, charakteryzującym się bogatą logiką i konkretnymi zasadami.

Pisanki wyłamują się z tych surowych zasad. Są dla twórców sposobem na dodanie unikalnego elementu z ludzką twarzą do ich technologicznego produktu. Włączenie jajek wielkanocnych sprawia, że całe doświadczenie korzystania z danego produktu technologicznego jest przyjemniejsze i może być gratką dla zagorzałych fanów, w zależności od produktu.

Przejdźmy do easter eggów, które możemy znaleźć w plikach robots.txt witryn.

Pisanki i pliki robots.txt

Znalezienie easter eggów w plikach robots.txt jest mniej skomplikowane niż w wielu innych przypadkach — wystarczy uzyskać dostęp do pliku robots.txt witryny.

Istnieje wiele przykładów easter eggów w plikach robots.txt. Te pliki mają być odczytywane i śledzone przez roboty; dlatego jajka wielkanocne powinny być dodawane w sposób zrozumiały tylko dla ludzi.

Wyjaśnijmy, czym są pliki robots.txt i czy dodanie pisanek nie wpłynie na sposób, w jaki roboty odczytają plik.

Co to są pliki robots.txt?

Plik robots.txt znajduje się w katalogu głównym Twojej domeny i zawiera zestaw dyrektyw dla robotów wyszukiwarek, mówiących im, jak indeksować strony w witrynie.

Każda dyrektywa blokuje określonemu robotowi indeksującemu lub umożliwia dostęp do ścieżki pliku w witrynie. O ile nie określono inaczej w pliku robots.txt, roboty mogą indeksować wszystkie pliki w witrynie.

Dyrektywy w pliku robots.txt pozwalają zmaksymalizować budżet indeksowania, więc Googlebot nie marnuje go na nieistotne strony w Twojej witrynie.

Czy dodanie pisanek może zaszkodzić plikowi robots.txt?

Pliki robots.txt mają określony format, o którym możesz przeczytać więcej we wskazówkach Google dotyczących dodawania reguł robots.txt .

Wyszukiwarki ignorują wszelkie symbole i polecenia pojawiające się w pliku robots.txt po hashtagu, więc dodanie easter eggów poprzedzonych hashtagiem nie wpłynie na to, jak roboty rozumieją te pliki.

Pisanki są również umieszczane w dokumentach lub miejscach, do których użytkownicy nie mają łatwego dostępu, i dotyczy to plików robots.txt. Zasadniczo nie są one połączone z innymi stronami, a użytkownicy nie mogą nawigować do nich, po prostu klikając przycisk w witrynie.

Dlaczego warto dodać jajko wielkanocne do pliku robots.txt?

Ponieważ możesz dodać tekst do plików robots.txt, który będzie czytelny tylko dla ludzi, dlaczego nie wykorzystać tej okazji do stworzenia ekskluzywnych treści, które uzupełnią Twoje działania marketingowe?

Możesz dodać pisanki do pliku robots.txt z wielu powodów, poza zapewnieniem rozrywki użytkownikom.

Na przykład zawartość pliku robots.txt może również:

- Zwiększ świadomość marki

- Zaprezentuj swoją markę pracodawcy

Można to osiągnąć na kilka sposobów. Możesz:

- Zaimplementuj własny branding, np. dołącz swoje logo lub hasło.

- Odwołaj się do oferowanych usług lub produktów lub do swojej firmy jako środowiska pracy.

- Zachęcaj odwiedzających do aplikowania na Twoje oferty pracy – w ten sposób kierujesz reklamy tylko do wybranej grupy osób, które odwiedzają Twój robots.txt. Możesz to zrobić zwłaszcza po to, by zaprosić geeków do zespołu deweloperskiego lub SEO!

- Twórz trafne i oryginalne treści. Może tematycznie odpowiadać celowi pliku robots.txt, np. adresować roboty, zawierać humorystyczne odniesienia do nich, wyszukiwarek lub innych tematów, takich jak popkultura. Włączenie takich niefrasobliwych treści może sprawić, że Twoja marka będzie wyglądać na bardziej przystępną i zorientowaną na użytkownika.

Wybierz podejście, które pokaże Twoją markę w najlepszym świetle i będzie wyjątkowym atutem tego, jak użytkownicy postrzegają Twoją markę.

Przykłady pisanek w robots.txt

Przyjrzyjmy się przykładom easter eggów w plikach robots.txt i zobaczmy, jakie rodzaje wiadomości możemy w nich znaleźć.

Killer-robots.txt Google

Plik killer-robots.txt firmy Google był niezapomnianym jajkiem wielkanocnym stworzonym z okazji 20. rocznicy udostępnienia webmasterom dyrektywy robots.txt. Od tego czasu został usunięty, ale pozostaje jednym z najbardziej znanych przykładów easter eggów w plikach robots.txt.

Oto tekst zawarty przez Google:

Użytkownik-Agent: T-1000

Użytkownik-Agent: T-800

Odrzuć: /+LarryPage

Disallow: /+SergeyBrin

T-800 to Terminator grany przez Arnolda Schwarzeneggera w słynnym filmie. T-1000 to robot-zabójca z filmu Terminator 2 . Dyrektywy zawarte w tym pliku uniemożliwiają T-800 i T-1000 zabicie założycieli Google Larry'ego Page'a i Sergeya Brina.

Nike

Nike włącza ich branding do pliku robots.txt, dodając humorystyczne podejście do hasła swojej marki. Jest połączony z odniesieniem do wyszukiwarek:

Nike rozwija te cechy marki jeszcze bardziej, umieszczając ich logo:

Cloudflare

Cloudflare zwraca się do robotów osobiście. Zaczyna się tak:

A kończy się odpowiedzią robota na żądanie i wyrażeniem zgody na jego wykonanie:

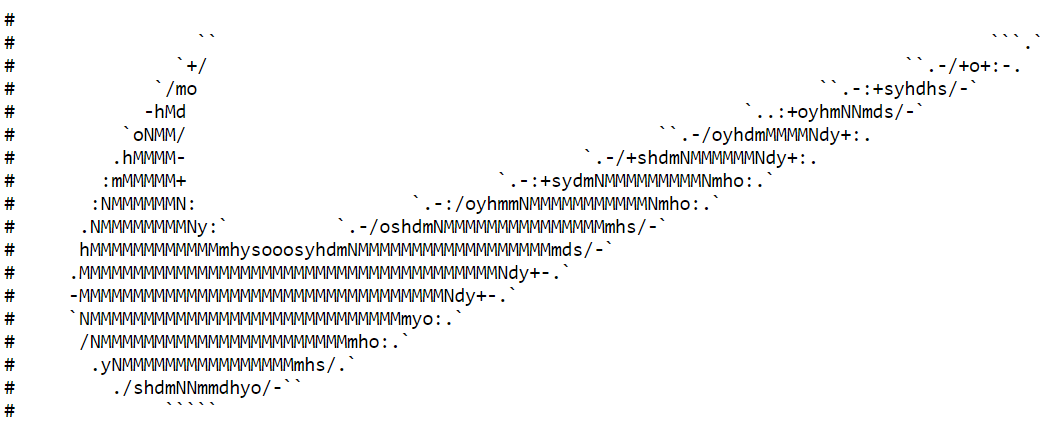

youtube

Youtube odwołuje się do robotów i odnosi się do dystopijnej przyszłości, w której dominują:

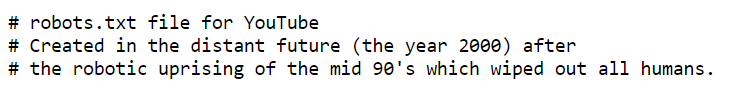

Szklane drzwi

Glassdoor to strona internetowa, która umożliwia pracownikom przeglądanie firm, przeglądanie oferowanych przez nie wynagrodzeń, wyszukiwanie ofert pracy na platformie i wiele więcej. Ich plik robots.txt jest zgodny z motywem zadania . Zawarte w pliku dyrektywy zachęcają maniaków SEO, którzy zapuszczają się w swój plik robots.txt, do aplikowania na jedno ze swoich stanowisk:

Etsy

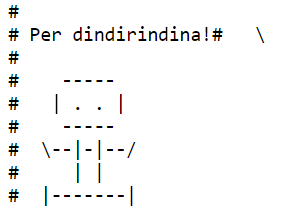

Wiadomość Etsy wydaje się być po włosku „na miłość boską!” i zawiera prosty obrazek w kształcie… robota, oczywiście:

Skowyt

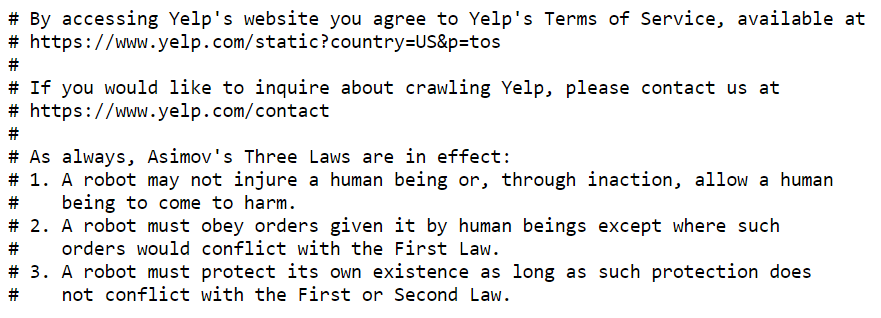

Yelp cytuje słynnego autora science fiction, Isaaca Asimova, i jego Trzy prawa robotyki . Asimov wprowadził te prawa w opowiadaniu z 1942 r., a później wykorzystał je jako podstawę swoich powieści.

Prawa są systemem etycznym dla ludzi i robotów, a plik robots.txt może być dokładnie tak postrzegany – sposób, w jaki ludzie i roboty mogą wchodzić w interakcje i czerpać obopólne korzyści z:

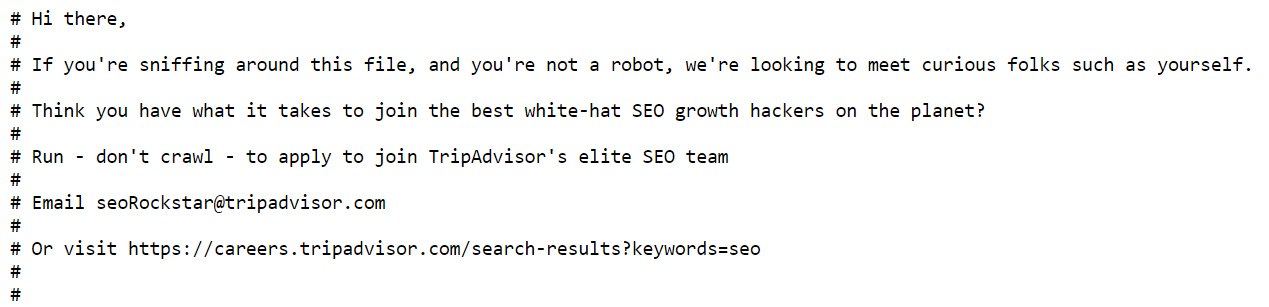

Tripadvisor

Podobnie jak Glassdoor, strona Tripadvisor ceni ciekawość ludzi i prosi poszukiwaczy jajek wielkanocnych o zgłoszenie się i zostanie członkami ich zespołu SEO:

Wikipedia

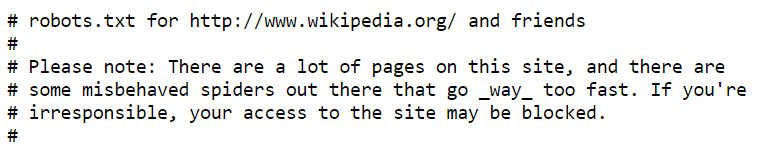

Plik robots.txt Wikipedii zawiera kilka wiadomości – oto tylko niektóre z nich:

Dyrektywy te komentują zachowanie robotów – ponieważ tylko ludzie mogą je czytać, jest to sposób na żartowanie z robotów. Pokazuje zabawną, beztroską stronę Wikipedii, która kontrastuje z tym, czego od niej oczekujemy – poważnymi, sprawdzonymi artykułami.

Merriam Webster

Merriam Webster przypomina każdemu, kto ma dostęp do pliku, aby „edytował z ostrożnością”:

To podwójne przypomnienie, że wszelkie dyrektywy zawarte w plikach robots.txt powinny być starannie zaplanowane i umieszczone w pliku – w końcu błędy mogą uniemożliwić robotom prawidłowe indeksowanie witryny.

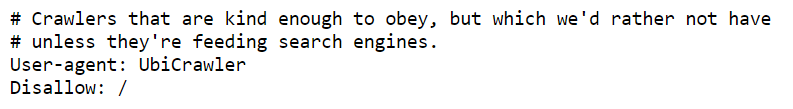

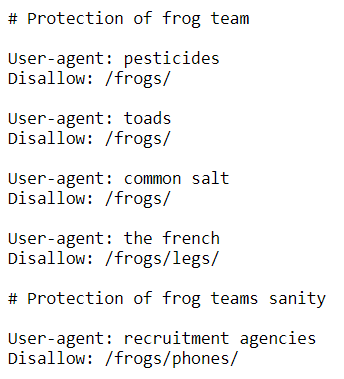

krzycząca żaba

Screaming Frog zawierało humorystyczne dyrektywy odnoszące się do nazwy firmy:

Ale jest w tym coś więcej niż tylko zabawne odniesienie. Uwzględnienie tych dyrektyw pomaga budować świadomość marki. Wzmianka o „ochronie zespołu żab” może być traktowana jako przykład brandingu pracodawcy.

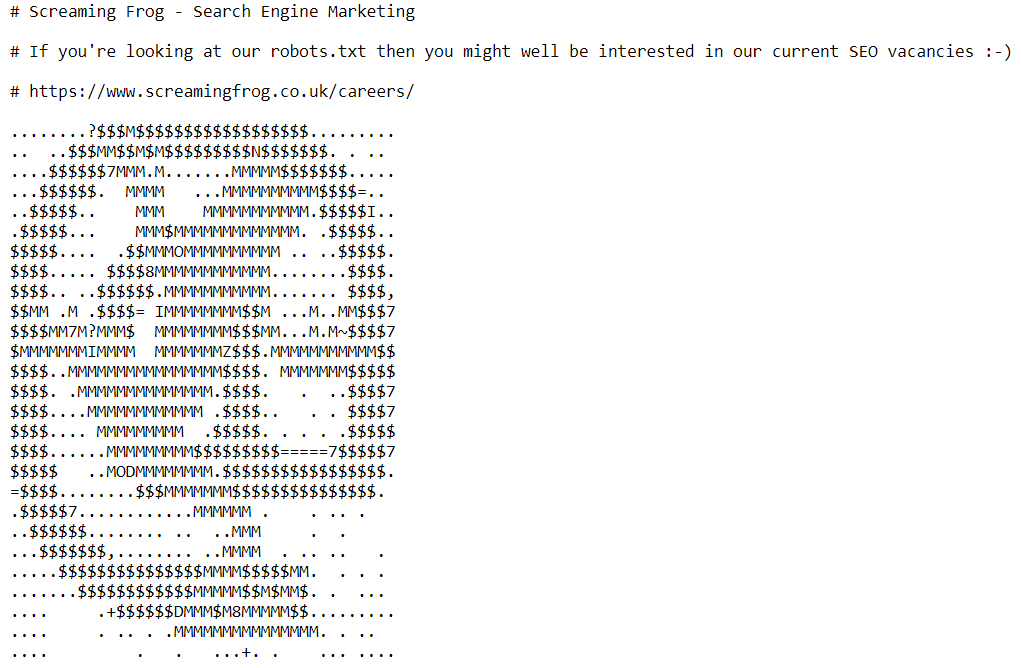

W dalszej części pliku robots.txt znajdziemy zaproszenie do zespołu SEO firmy:

Wyszukiwarka Land

Search Engine Land zwraca się do osób, które potrafią przeczytać następującą wiadomość – ponieważ roboty nie potrafią – rozpoznając, że mogą istnieć nieroboty, które odwiedzają ich plik robots.txt. Jest też odniesienie do Battlestar Galactica:

Humans.txt

Internet powinien dotyczyć ludzi, a nie tylko robotów.

Jeśli istnieje plik robots.txt dla robotów, powinien również istnieć plik dla ludzi.

To jest myśl stojąca za humans.txt , który został stworzony jako kontr-inicjatywa dla plików robots.txt. Jak czytamy na jego oficjalnej stronie internetowej:

„To inicjatywa mająca na celu poznanie ludzi stojących za stroną internetową. Jest to plik TXT, który zawiera informacje o różnych osobach, które przyczyniły się do powstania witryny”.

Plik .txt nie ingeruje w kod i jest łatwym sposobem udowodnienia autorstwa witryny.

Oto tekst, który zawiera plik humans.txt Google:

„Google jest tworzony przez duży zespół inżynierów, projektantów, badaczy, roboty i inne osoby w wielu różnych miejscach na całym świecie. Jest stale aktualizowana i budowana przy użyciu większej liczby narzędzi i technologii, niż jesteśmy w stanie potrząsnąć kijem. Jeśli chcesz nam pomóc, wejdź na careers.google.com”.

Inne witryny również z niego korzystają i często stają się bardziej kreatywne — spójrz na pliki humans.txt Netflixa i Medium .

Następne kroki

Teraz, gdy widziałeś już przykłady easter eggów znalezionych w plikach robots.txt, czy czujesz się natchniony, by zostawić je swoim użytkownikom?

Zrobiliśmy!