Les forums sont-ils morts pour le SEO en 2022 ?

Publié: 2022-07-12Au tout début d'Internet, les forums communautaires étaient extrêmement populaires. Ils servaient de lieu pratique où les gens pouvaient poser des questions, partager des connaissances ou faire des affaires. Et pour certains, c'était juste un excellent moyen de tuer le temps.

Il semble qu'au cours des deux dernières années, les forums traditionnels aient été largement remplacés par des outils spécialisés de création de communautés, comme Discord et Slack, ou par des groupes de médias sociaux, comme ceux de Facebook.

Mais cela signifie-t-il que les forums traditionnels sont morts ?

Analyser le trafic vers les sites de forums populaires

Contrairement au contenu des plates-formes de forum traditionnelles, les publications des forums Discord ou des groupes privés sur Facebook sont impossibles à trouver sur Google.

Mais malgré le fait que les plates-formes traditionnelles devraient être facilement accessibles via la recherche Google, la question demeure : combien de personnes visitent encore les forums Internet ?

Pour savoir si les forums conventionnels sont en train de disparaître, j'ai vérifié certaines statistiques dans SimilarWeb pour voir le trafic qu'ils reçoivent de Google. Voici les résultats d'avril 2022 :

| Forum | Trafic total | Part de trafic organique |

| reddit.com | 1,6 milliard | 46% |

| quora.com | 500 millions | 70% |

| stackoverflow.com | 274,4 millions | 88% |

| forum.xda-developers.com | 14,7 millions | 30% |

| ubuntuforums.org | 800 mille | 80% |

| digitalpoint.com | 186 mille | 46% |

Il est clair que les forums sont toujours visités par un grand nombre d'utilisateurs et peuvent générer un trafic massif de Google. Par exemple, StackOverflow reçoit environ 275 millions de trafic mensuel, dont 88 % proviennent de Google. Incroyable!

Indexation des forums populaires

En utilisant ZipTie.dev, j'ai remarqué que Google n'indexait que 35% des pages testées sur l'un des forums populaires, Digital Point. C'est un résultat relativement faible par rapport à d'autres sites Web comme Quora ou UbuntuForums, qui ont plus de 90 % de leurs pages indexées sur Google.

Une faible couverture d'indice signifie généralement deux choses :

- Le site Web contient du contenu de mauvaise qualité.

- Le site Web a de sérieux problèmes techniques de référencement.

Dans le cas de Digital Point, ces deux problèmes se sont produits et, de plus, il s'est avéré qu'ils étaient liés l'un à l'autre.

Au cours d'une analyse plus approfondie, j'ai découvert que DigitalPoint permet à certains contenus de mauvaise qualité d'être explorés et indexés par Google. Cet oubli amène Google à percevoir l'ensemble du site Web comme du spam et inutile du point de vue de l'utilisateur.

Voyons à quel point cela peut être dangereux avec quelques autres exemples.

Contenu de mauvaise qualité et visibilité de recherche

Inonder l'index de Google avec des tonnes de contenu de mauvaise qualité n'est pas une bonne stratégie. Comme je l'ai expliqué dans l'un de mes articles précédents, c'est la raison pour laquelle des sites Web comme Giphy et Pinterest ont autrefois perdu plus de 50 % de leur visibilité sur Google.

Un contenu indexable de faible qualité peut avoir une influence négative sur la visibilité de votre recherche à trois niveaux :

- Page de destination.

- Rubrique (répertoire).

- L'ensemble du site.

Mais qu'est-ce que nous ne voudrions pas exactement voir dans l'index Google ? Regardons quelques exemples de Digital Point :

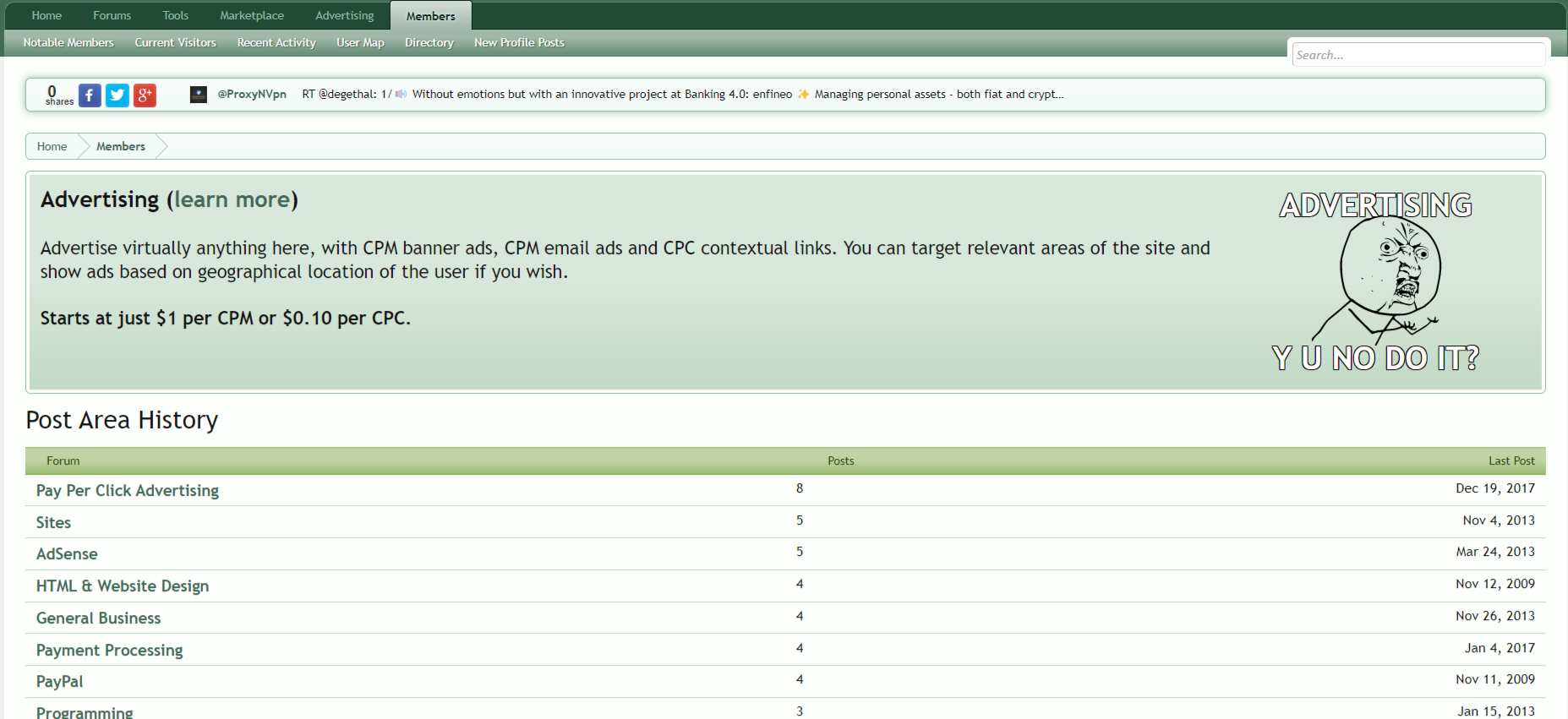

Exemple de page : liste des catégories de sujets recommandées par un auteur donné.

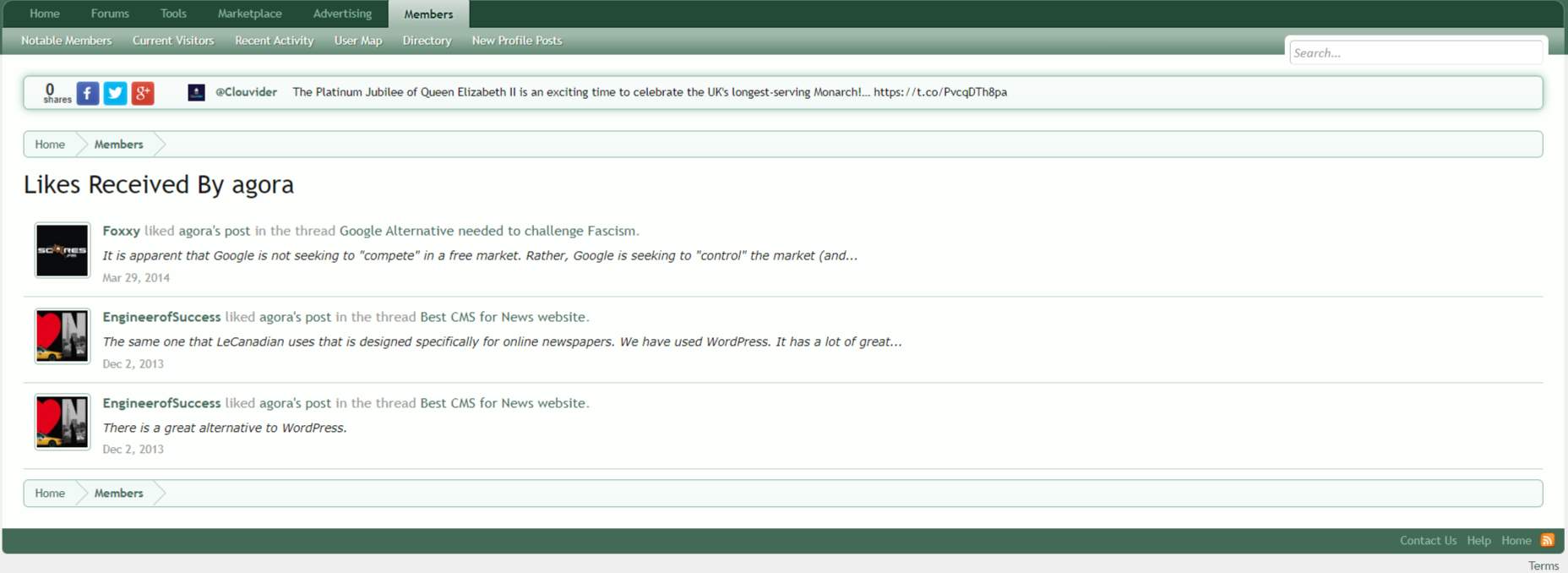

Exemple de page : Liste des likes reçus par un auteur donné.

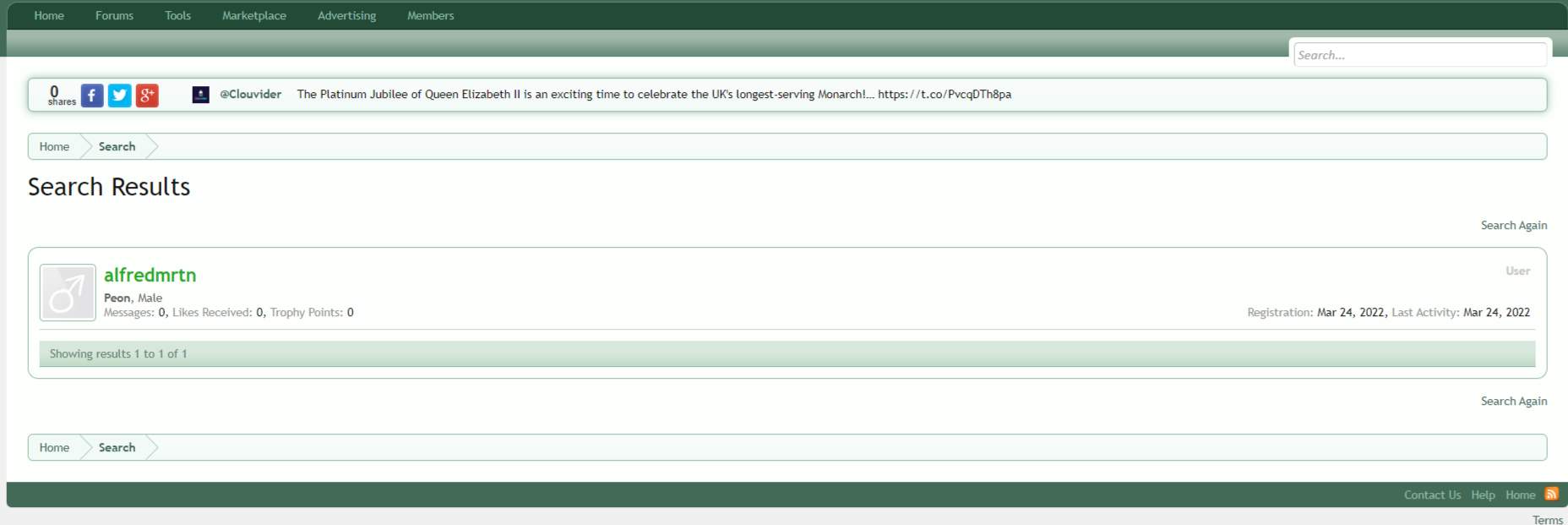

Exemple de page : liste de tous les messages d'un auteur donné - dans ce cas, la liste est vide.

Les pages présentées ci-dessus sont totalement impraticables pour Google. Personne ne les cherchera jamais et ils ne fourniront à personne des informations utiles. Ces auteurs ne sont pas réputés pour leurs connaissances dans un domaine donné, et les likes individuels ne nous fourniront aucune information sur la qualité de leurs publications. Pour ces raisons, ces pages ne doivent pas être indexables.

Si vous ne mettez pas en œuvre une stratégie d'indexation solide sur votre site Web, Google peut considérer que toutes ses sections sont de mauvaise qualité et supposer qu'elles ne devraient pas être bien classées dans les résultats de recherche.

Faire face à un contenu de mauvaise qualité

Avoir une stratégie d'indexation pour votre site Web est une étape nécessaire pour réussir dans la recherche. Et l'un des aspects clés par lequel vous devriez commencer est de contrôler votre contenu de mauvaise qualité.

Quora

Quora est un brillant exemple de la façon de gérer le contenu de mauvaise qualité généré par les utilisateurs. Ils ont mis en place une procédure simple mais efficace pour lutter contre le ballonnement de l'index.

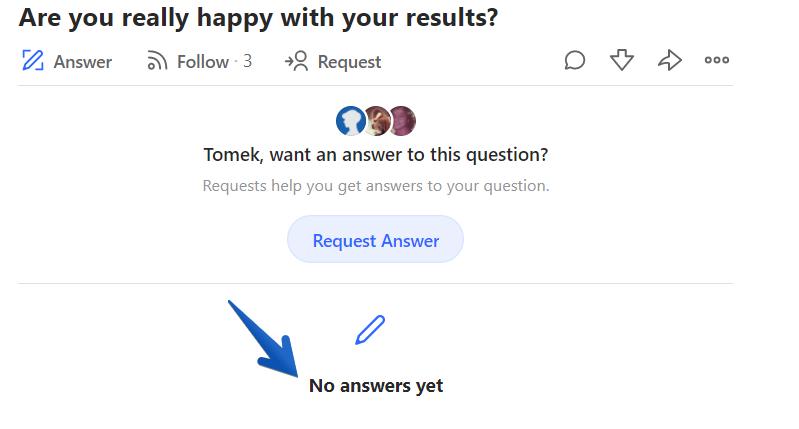

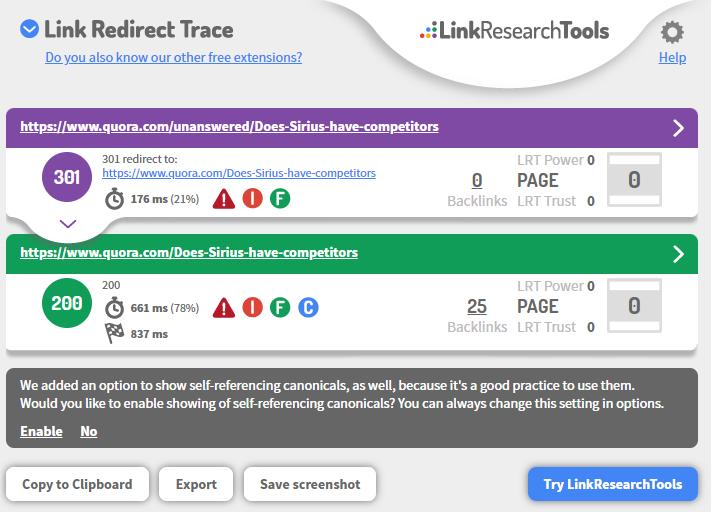

Chaque question sans réponse posée sur Quora a le préfixe "/sans réponse/" dans l'URL.

Voici un exemple de Quora marquant les questions sans réponse :

Dans le cas de Quora.com, les URL avec ce préfixe ne sont pas autorisées dans robots.txt, ce qui signifie que Googlebot ne gaspillera pas son budget d'exploration sur du contenu de mauvaise qualité.

Une fois qu'une page obtient des réponses utiles, son URL change automatiquement afin que Google puisse la visiter et l'indexer.

Pourquoi est-ce que je considère que c'est une bonne stratégie ?

Parce que Google n'est pas inondé de contenu de mauvaise qualité et ne gaspille pas son budget de crawl pour le traiter. Bon travail, Quora !

StackOverflow

Une autre façon de contrôler le contenu de mauvaise qualité consiste à empêcher sa création. Un forum de programmation bien connu StackOverflow utilise cette solution.

Chaque fois qu'un utilisateur souhaite poser une question, le portail vérifie automatiquement si les membres du forum ont déjà discuté du problème soulevé. S'il existe un fil de discussion sur ce sujet, l'utilisateur est dirigé vers celui-ci et donc découragé de poster une question redondante et de créer une URL inutile.

De plus, le site Web permet à ses utilisateurs de trier les réponses en fonction du nombre de votes positifs et s'assure que les fils de discussion sont faciles à distinguer et à suivre.

Pourquoi les forums traditionnels doivent-ils changer ?

Internet évolue, les attentes des utilisateurs aussi. Pour rester pertinents, les sites de forum doivent non seulement résoudre leurs dilemmes d'indexation, mais aussi s'adapter aux tendances modernes.

Les forums traditionnels auraient pu être formidables il y a vingt ans. Mais de nos jours, il existe de meilleurs outils pour les communautés en ligne. Des applications comme Slack ou Discord offrent des fonctionnalités étendues tout en conservant la plupart de ce qu'offre un tableau d'affichage typique. C'est là que semble se situer l'avenir des communautés en ligne.

Dans le même temps, la nécessité pour les gens de rechercher des informations sur des sujets spécifiques liés à la communauté n'a pas disparu. Mais leur capacité d'attention diminue et leur comportement de navigation est différent. Ils veulent que les réponses à leurs questions soient à la fois exhaustives et rapides.

Des sites Web comme Quora ou StackOverflow prospèrent car, au mieux, ils offrent des réponses simples et faciles à trouver à des questions spécifiques. Google aime ça.

De plus, les internautes modernes ne font plus confiance aux réponses non vérifiées des comptes anonymes. Ils attendent du professionnalisme et de la responsabilité.

Et la confiance devient la monnaie avec laquelle ils paient pour obtenir des conseils utiles.

Cette politique s'applique principalement aux sites de la catégorie Your Money Your Life (sujets pouvant avoir un impact négatif sur le bonheur, la santé, la sécurité ou la stabilité financière d'une personne).

À mon avis, un forum moderne devrait s'en tenir aux règles suivantes :

- Assurez-vous d'être en mesure de valider rapidement les auteurs pour voir s'ils sont des experts dans leur domaine.

- Recommandez aux gens d'utiliser leur nom et prénom, ou au moins de les mettre dans leur bios. Grâce à cela, vous pouvez décider si vous faites confiance à leur opinion.

De plus, si quelqu'un utilise son nom pour un compte de forum, il devra se rappeler que les employeurs ou sous-traitants potentiels peuvent accéder à ses messages et commentaires. Avec leur réputation en jeu, ils éviteront de publier des déclarations de mauvaise qualité sur le Web. - Permettez aux utilisateurs d'exprimer leurs opinions sur le contenu afin que les réponses de haute qualité soient visibles en haut et soient facilement disponibles pour les utilisateurs pressés.

Meilleures pratiques de référencement pour les sites Web de forum

Les résultats de mon analyse d'indexation montrent clairement que les forums peuvent recevoir une grande quantité de trafic de Google. Pour en tirer parti, vous devez apprendre à optimiser la recherche organique.

Voici quelques bonnes pratiques lors de la création et de la gestion de sites Web de forum :

- Empêchez Google d'indexer du contenu de mauvaise qualité. Le gonflement de l'index peut affecter négativement votre visibilité dans les résultats de recherche.

- Permettez aux utilisateurs et aux moteurs de recherche de naviguer rapidement vers les discussions les plus commentées sur des sujets similaires.

Des liens internes cohérents offrent non seulement une excellente expérience utilisateur aux utilisateurs, mais sont également essentiels pour que Google découvre vos pages et comprenne leur structure et leur contexte. - Rendez votre forum précieux pour les utilisateurs. Le classement dans les résultats de recherche n'est que la première étape. Si les gens visitent votre forum et rebondissent, cela peut indiquer que votre contenu ne sert pas bien l'intention de l'utilisateur.

- Méfiez-vous des spams et du contenu NSFW, car les utilisateurs dont le filtre SafeSearch est activé ne verront pas les pages considérées comme réservées aux adultes.

- Enfin, appliquez les principes du référencement traditionnel comme base du processus d'optimisation.