Indexación SEO 101: Cómo crear una estrategia de indexación para su sitio web

Publicado: 2021-12-14Los motores de búsqueda no deberían indexar todas las páginas de su sitio web.

Incluso si piensa que todo en su sitio es simplemente fantástico, la mayoría de los sitios web tienen toneladas de páginas que simplemente no pertenecen a los resultados de búsqueda. Y si permite que los motores de búsqueda indexen esas páginas, puede enfrentar consecuencias negativas.

Es por eso que necesita una estrategia de indexación para su sitio. Sus elementos clave son:

- Decidir qué páginas quiere que indexen los motores de búsqueda y usar los métodos apropiados para maximizar sus posibilidades de ser indexados.

- Decidir qué páginas no deben indexarse y cómo excluirlas de la búsqueda sin limitar su visibilidad potencial de búsqueda.

Decidir qué páginas deben o no indexarse es difícil. Es posible que encuentre algunas pautas y sugerencias para páginas específicas, pero a menudo estará solo.

Y elegir los métodos apropiados para excluir esas páginas de los resultados de búsqueda requiere aún más consideración. ¿Debería usar la etiqueta noindex o la etiqueta canónica, bloquear la página en robots.txt o usar una redirección permanente?

Este artículo describirá el proceso de toma de decisiones que le permitirá crear una estrategia de indexación personalizada para su sitio web.

Si bien puede encontrarse con casos extremos que no se adhieren a la lógica que propongo, el proceso subrayado a continuación le brindará excelentes resultados en la gran mayoría de los casos.

Por qué algunas páginas no deben indexarse

Hay dos razones principales por las que no debería querer que los motores de búsqueda indexen todas sus páginas:

- Ayuda a optimizar el presupuesto de rastreo,

- Una gran cantidad de contenido de baja calidad que es indexable podría dañar la forma en que los motores de búsqueda ven su sitio web.

Optimice su presupuesto de rastreo

Los bots de los motores de búsqueda pueden rastrear un número limitado de páginas en un sitio web determinado. Internet es infinitamente grande, y rastrear todo excedería los recursos que tienen los motores de búsqueda.

La cantidad de tiempo y recursos que los robots de los motores de búsqueda dedican a rastrear su sitio web se denomina presupuesto de rastreo. Si desperdicia el presupuesto de rastreo en páginas de baja calidad, es posible que no haya suficiente para las más valiosas que realmente deberían indexarse.

Al tomarse el tiempo para decidir qué páginas desea indexar, puede optimizar su presupuesto de rastreo y asegurarse de que los bots de los motores de búsqueda no desperdicien sus recursos en páginas menos importantes.

Si desea obtener más información sobre cómo optimizar su presupuesto de rastreo, consulte nuestra Guía definitiva para la optimización del presupuesto de rastreo.

No permita que el contenido de baja calidad dañe su sitio web

Si los motores de búsqueda se dan cuenta de que tiene mucho contenido de baja calidad, podrían decidir dejar de rastrear su sitio web con tanta frecuencia.

Tomek Rudzki, en su Ultimate Guide to Indexing SEO, llamó a esto “ responsabilidad colectiva ”.

Es un círculo vicioso:

- Google rastrea páginas de baja calidad.

- Google deja de visitar el sitio web con tanta frecuencia.

- Muchas páginas nunca son rastreadas por Google, incluso si son páginas de alta calidad.

- Hay páginas valiosas que no están indexadas.

Esto muestra cómo se interconectan la clasificación, el rastreo y la indexación.

fuente: Tomasz Rudzki

Métodos para controlar la indexación

Hay varios métodos que puede usar para controlar la indexación de sus páginas, que incluyen:

- Metaetiqueta de robots Noindex,

- Disallow directiva en robots.txt,

- etiqueta canónica,

- redirección permanente,

- Mapa del sitio XML.

Cada uno de los métodos anteriores tiene su propio uso y función.

Metaetiqueta de robots Noindex

<meta name="robots" content="noindex">Si agrega la directiva anterior a la sección HTML <head> de su página, los robots de los motores de búsqueda comprenderán que no deben indexarla. Evitará que la página aparezca en la página de resultados de los motores de búsqueda.

Debe utilizar esta etiqueta si no desea que la página se indexe, pero desea que los robots de los motores de búsqueda rastreen su página y, por ejemplo, sigan los enlaces de esa página.

Disallow directiva en robots.txt

Agente de usuario: * No permitir: /ejemplo/pagina.html

La directiva disallow en el archivo robots.txt le permite bloquear el acceso de los motores de búsqueda a la página. Si un robot de motor de búsqueda respeta la directiva, no rastreará las páginas no permitidas y, en consecuencia, no se indexarán.

Dado que la directiva disallow restringe el rastreo, este método puede ayudarlo a ahorrar su presupuesto de rastreo.

Nota: la directiva disallow no es una forma adecuada de bloquear el acceso a sus páginas confidenciales. Los bots maliciosos ignoran el archivo robots.txt y aún pueden acceder al contenido. Si desea asegurarse de que algunas páginas no sean accesibles para todos los bots, es mejor bloquearlas con una contraseña.

etiqueta canónica

<enlace rel="canonical" href="https://www.example.com/page.html">Una etiqueta canónica es un elemento HTML que le dice a los motores de búsqueda qué URL duplicadas son las originales.

Con la etiqueta canónica, especifica exactamente qué versión de una página desea que se indexe y aparezca en los resultados de búsqueda. Sin la etiqueta canónica, no tienes control sobre qué versión de tu página se indexa.

Los bots de los motores de búsqueda aún necesitan rastrear la página para descubrir la etiqueta canónica, por lo que usarla no lo ayudará a ahorrar su presupuesto de rastreo.

Redirección permanente

La redirección 301 es un código de respuesta HTTP que indica una redirección permanente. Especifica que la página solicitada tiene una nueva ubicación y que la página anterior se eliminó del servidor.

Cuando utiliza una redirección 301, los usuarios y los robots de los motores de búsqueda no accederán a la URL anterior. En su lugar, las señales de tráfico y clasificación se redirigirán a la nueva página.

Usar la redirección 301 es un buen método para ahorrar el presupuesto de rastreo. Está disminuyendo la cantidad de páginas disponibles en su sitio web, por lo que los robots de los motores de búsqueda tienen menos contenido para rastrear.

Recuerda que debes redirigir solo a una página relacionada. Redirigir a una página no relacionada puede confundir a los usuarios. Además, es posible que los robots de los motores de búsqueda no sigan la redirección y traten la página como un 404 suave.

Mapas de sitio XML

Un mapa del sitio XML es un archivo de texto que enumera las URL que desea que indexen los motores de búsqueda. Su propósito es ayudar a los robots de los motores de búsqueda a encontrar fácilmente las páginas que le interesan.

Un mapa del sitio bien optimizado no solo dirige los motores de búsqueda a sus páginas valiosas, sino que también lo ayuda a ahorrar su presupuesto de rastreo. Sin él, los bots necesitan rastrear todo el sitio para descubrir su valioso contenido.

Es por eso que los sitemaps deben enumerar solo las URL indexables en su sitio web. Esto significa que las páginas que coloque en el mapa del sitio deben ser:

- Canónico,

- No bloqueado por la metaetiqueta de robots noindex, y

- No bloqueado por la directiva disallow en robots.txt,

- Respondiendo con código de estado 200.

Puede obtener más información sobre cómo optimizar los mapas de sitio en nuestra Guía definitiva de mapas de sitio XML.

Cómo decidir qué páginas deben o no indexarse

Para ayudarlo a decidir qué páginas deben indexarse o no, creé un árbol de decisiones con todas las preguntas esenciales que debe responder.

Ver la imagen en tamaño completo.

Como puede ver arriba, la pregunta fundamental es: ¿esta página es valiosa para alguien?

Hay tres posibles respuestas a esa pregunta:

- La página es valiosa para los usuarios de motores de búsqueda (y los motores de búsqueda),

- La página es valiosa para los motores de búsqueda,

- La página no es valiosa para nadie.

La conclusión es que solo se deben indexar las páginas valiosas para los usuarios. Sin embargo, incluso en esa categoría, hay tipos de páginas que no deberían indexarse.

Vamos a desglosarlo.

Páginas valiosas para los usuarios

Una página es valiosa para los usuarios de motores de búsqueda si proporciona una respuesta a su búsqueda o les permite navegar hasta la respuesta.

En la mayoría de los casos, si una página es valiosa para los usuarios, debe indexarse. Sin embargo, aún puede haber una situación en la que una página sea valiosa para los usuarios pero no deba indexarse.

Páginas valiosas para los usuarios que deben indexarse

Una página debe ser indexada si:

- Proporciona contenido único y de alta calidad que atrae tráfico,

- Es una versión en idioma alternativo de una página diferente de alta calidad (si corresponde).

Contenido único y de alta calidad

Las páginas únicas y de alta calidad que atraen tráfico a su sitio definitivamente deberían llegar a su mapa del sitio. Asegúrese de no bloquearlos en robots.txt y que no tengan la etiqueta de metarobots noindex.

Preste especial atención a las páginas más valiosas para su negocio . Son las que más conversión suelen traer. Paginas como:

- página de inicio,

- Sobre nosotros y páginas de contacto,

- Páginas con información sobre el servicio que prestas,

- Artículos de blog que muestran su experiencia,

- Páginas con elementos específicos (como productos de comercio electrónico),

siempre debe ser indexable, y debe monitorear regularmente su indexación.

Versión en idioma alternativo

Los motores de búsqueda no tratan el contenido traducido como duplicado. De hecho, los motores de búsqueda quieren saber si tiene versiones en varios idiomas disponibles para presentar la versión más adecuada a los usuarios en diferentes países.

Si tiene una versión de idioma alternativo de una página, debe especificarla con una etiqueta hreflang y colocar la página en su mapa del sitio.

Puede especificar las etiquetas hreflang en su mapa del sitio, HTML o ambos. Las etiquetas Hreflang utilizadas en los mapas del sitio están perfectamente bien desde la perspectiva del motor de búsqueda. Sin embargo, pueden ser difíciles de verificar con herramientas de SEO o complementos de navegador. Por esa razón, la forma recomendada de agregar la etiqueta es en código HTML y el mapa del sitio, o solo en el código HTML.

Recuerde que cada página debe especificar todas las versiones de idioma, incluido su propio idioma.

Páginas valiosas para los usuarios que no deberían indexarse

En algunas situaciones, las páginas pueden ser valiosas para los usuarios, pero aun así no deben indexarse. Las situaciones incluyen:

- Contenido duplicado o casi duplicado,

- Páginas sin demanda de búsqueda.

Duplicado o casi duplicado de una página diferente

Los bots de los motores de búsqueda podrían considerar una página duplicada o casi duplicada si:

- Dos o más URL diferentes conducen a la misma página,

- Dos páginas diferentes tienen un contenido muy similar.

Uno de los ejemplos más comunes de contenido duplicado son las páginas de categorías filtradas en los sitios de comercio electrónico. Los usuarios pueden aplicar filtros para restringir los productos y encontrar lo que buscan más rápido. Desafortunadamente, cada filtro aplicado puede guardar los parámetros en la URL, creando múltiples URL que conducen a la misma página.

Por ejemplo, store.com/dresses/item y store.com/dresses/item?color=yellow pueden apuntar al mismo contenido.

Otras razones para el contenido duplicado o casi duplicado incluyen:

- Tener diferentes URL para las versiones móvil y de escritorio,

- Tener una versión impresa de su sitio web, o

- Crear contenido duplicado por error.

Los riesgos de tener contenido duplicado indexable incluyen:

- No tener control sobre qué versión puede aparecer en los resultados de búsqueda. Por ejemplo, si tiene versiones impresas y regulares disponibles, los motores de búsqueda pueden mostrar la versión impresa en la búsqueda.

- Dividir las señales de clasificación entre varias URL.

- Aumentar drásticamente la cantidad de URL que los motores de búsqueda necesitan rastrear.

- Bajar su posición en los SERP si los motores de búsqueda deciden que desea manipular el ranking (una consecuencia rara).

Para evitar las consecuencias negativas de tener contenido duplicado, debes intentar consolidarlo . Las principales formas de hacerlo incluyen etiquetas canónicas y redireccionamientos 301.

Las etiquetas canónicas son la mejor opción si necesita que todas las páginas estén disponibles para los usuarios.

Un ejemplo de contenido duplicado que debería permanecer disponible en su sitio es uno que mejora la experiencia del usuario. Por ejemplo, cuando los usuarios filtran los productos en un sitio de comercio electrónico, redirigirlos puede resultar confuso por varios motivos, como un cambio repentino de migas de pan.

Además, puede ser necesario tener contenido duplicado en su sitio cuando tiene diferentes versiones para diferentes dispositivos.

Con una redirección 301 , solo una de las páginas permanece disponible en su sitio. El resto será redirigido automáticamente.

Una redirección 301 puede ser útil cuando, por ejemplo, tiene dos publicaciones de blog muy similares y decide que solo una debe permanecer en su sitio. El código de estado 301 redirigirá el tráfico y las señales de clasificación al artículo elegido. Es un método excelente para optimizar su presupuesto de rastreo, pero solo puede usarlo cuando desee eliminar la página duplicada.

Recuerde realizar cambios en su mapa del sitio cada vez que utilice redireccionamientos permanentes. Solo debe colocar páginas que respondan con 200 códigos de estado en su mapa del sitio. Por lo tanto, si está utilizando la redirección 301 para consolidar el contenido, solo la versión que permanece en su sitio web debe permanecer en el mapa del sitio.

Páginas sin demanda de búsqueda

Es posible que tenga un buen contenido en su sitio que no tenga ninguna demanda de búsqueda. En otras palabras, nadie lo está buscando. Esto puede suceder cuando escribe sobre un pasatiempo de nicho o tiene páginas con, por ejemplo, una nota de "gracias" para sus usuarios.

Es posible que estas páginas no generen tráfico ni conversiones. Tal vez quiera dejarlos porque complementan los viajes de los usuarios, pero no quiere que sean lo primero que vean los usuarios en el resultado de la búsqueda.

Si no cree que los usuarios deban ver una página específica en los resultados de búsqueda, o si la página no genera tráfico, no es necesario que la mantenga indexada. De esta forma, los robots de los motores de búsqueda pueden centrarse en las páginas que realmente generan tráfico.

Para bloquear la indexación de una página sin demanda de búsqueda, use la etiqueta de meta robots noindex. Los bots no lo indexarán, pero aún así lo rastrearán y seguirán los enlaces en esa página, dándoles más contexto sobre su sitio web.

Páginas valiosas solo para los motores de búsqueda

No todas las páginas están destinadas a ayudar a los usuarios. Algunos de ellos ayudan a los motores de búsqueda a conocer su sitio web y descubrir enlaces.

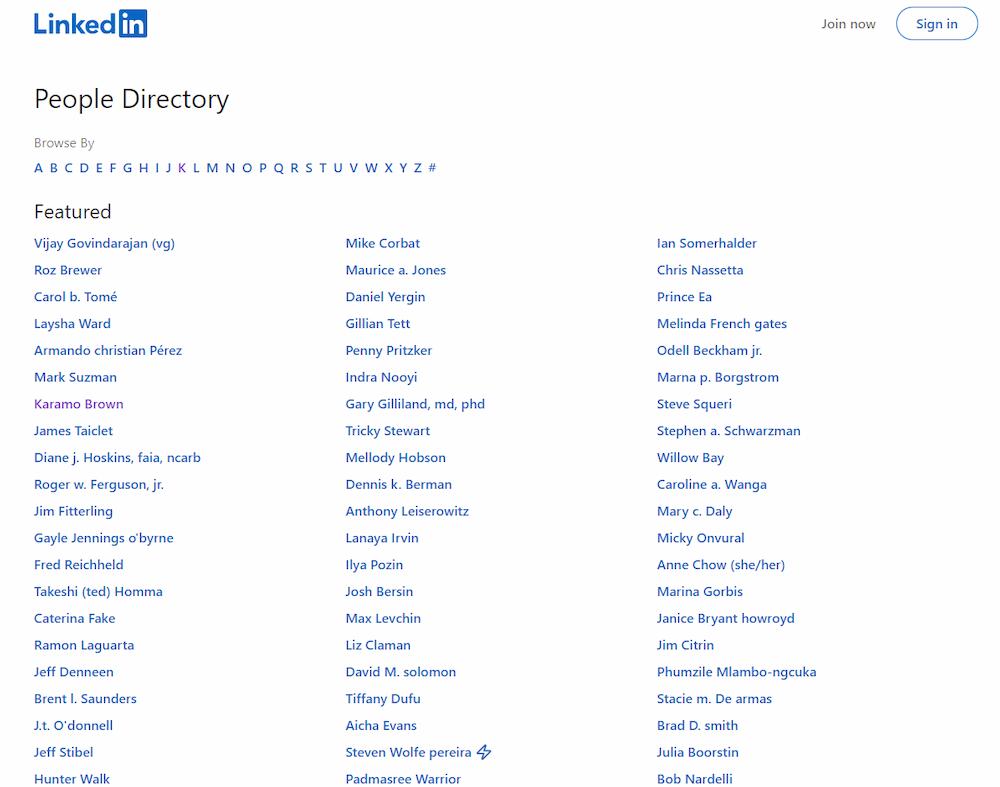

Echa un vistazo a esta página de LinkedIn:

Enumera todos los perfiles de los usuarios, lo que facilita que los motores de búsqueda encuentren todos los enlaces.

Por un lado, páginas como estas pueden confundir a los usuarios y disuadirlos de permanecer en el sitio. No son valiosos para ellos, por lo que no deberían aparecer en los resultados de búsqueda y no deberían indexarse.

Por otro lado, son útiles para los motores de búsqueda: potencian los enlaces internos.

Es por eso que la mejor solución es implementar etiquetas meta robots sin índice, dejar estas páginas fuera de su mapa del sitio y permitir su rastreo en robots.txt. No se indexarán, pero los bots los rastrearán.

Páginas que no son valiosas para nadie

Algunas páginas no son valiosas para los usuarios ni para los motores de búsqueda.

Algunos de ellos están obligados a existir en su sitio por ley, por ejemplo, la política de privacidad, pero, seamos honestos, nadie está buscando este tipo de contenido. Por supuesto, no puede eliminarlos, pero no es necesario indexarlos porque nadie quiere encontrarlos. En algunos casos, pueden superar contenido más valioso y "robar" tráfico.

Las páginas sin valor también incluyen contenido delgado y de baja calidad. Debe prestarles especial atención, ya que pueden dañar la forma en que los usuarios y los motores de búsqueda perciben la calidad general de su sitio. Consulte el capítulo El contenido de baja calidad puede dañar su sitio web para obtener más información.

Lo más importante es que debe asegurarse de que las páginas sin valor tengan la etiqueta meta robots noindex. Si no bloquea su indexación, podrían dañar su clasificación y desalentar a los usuarios de visitar su sitio web.

Además, si desea optimizar su presupuesto de rastreo, bloquee estas páginas en el archivo robots.txt y elimine los enlaces internos que apuntan a ellas. Esto lo ayudará a ahorrar el presupuesto de rastreo para páginas más valiosas.

Terminando

Saber cuáles de sus páginas deben y no deben indexarse y comunicarlo a los robots de los motores de búsqueda es crucial para crear una estrategia de indexación sólida.

Maximizará las posibilidades de que su sitio web sea rastreado e indexado correctamente y garantizará que sus usuarios puedan encontrar todo su contenido valioso en los resultados de búsqueda.

Estos son los puntos clave que debe tener en cuenta al crear su estrategia de indexación:

- Al decidir si una página debe indexarse, pregúntese si tiene contenido único con valor para los usuarios. Las páginas únicas y valiosas no deben ser bloqueadas para que no sean indexadas por las etiquetas de meta robots noindex o bloqueadas para que no sean rastreadas usando las directivas de rechazo de robots.txt.

- Si su contenido de baja calidad es indexable, puede afectar negativamente su clasificación y poner sus páginas valiosas en riesgo de no ser indexadas.

- Si tiene contenido duplicado o casi duplicado en su sitio, debe consolidarlo con una etiqueta canónica o una redirección 301.

- Si una página no tiene demanda de búsqueda, no tiene que estar indexada; use el noindex en la etiqueta meta robots.

- Las páginas que contienen contenido o enlaces valiosos solo para los motores de búsqueda deben bloquearse para que no se indexen con la etiqueta meta robots noindex, pero no las bloquee para que no se rastreen en robots.txt.

- Si ni los usuarios ni los motores de búsqueda se benefician de visitar una página determinada, debe establecerse en noindex en la etiqueta meta robots.

- Si tiene varias versiones en idiomas alternativos de la misma página, manténgalas indexables. Use la etiqueta hreflang para ayudar a los motores de búsqueda a comprender cómo se relacionan estas páginas.