Индексация SEO 101: как создать стратегию индексации для вашего сайта

Опубликовано: 2021-12-14Поисковые системы не должны индексировать все страницы вашего сайта.

Даже если вы думаете, что все на вашем сайте просто фантастика, на большинстве веб-сайтов есть множество страниц, которым просто не место в результатах поиска. И если вы позволите поисковым системам индексировать эти страницы, вы можете столкнуться с негативными последствиями.

Вот почему вам нужна стратегия индексации вашего сайта. Его ключевыми элементами являются:

- Решите, какие страницы вы хотите, чтобы поисковые системы индексировали, и используйте соответствующие методы, чтобы максимизировать их шансы на индексацию,

- Решите, какие страницы не должны быть проиндексированы и как исключить их из поиска, не ограничивая вашу потенциальную видимость в поиске.

Трудно решить, какие страницы следует или не следует индексировать. Вы можете найти некоторые рекомендации и советы для конкретных страниц, но часто вы будете предоставлены сами себе.

И выбор подходящих методов для исключения этих страниц из результатов поиска требует еще большего внимания. Следует ли использовать тег noindex или тег canonical, заблокировать страницу в robots.txt или использовать постоянную переадресацию?

В этой статье будет описан процесс принятия решений , который позволит вам создать собственную стратегию индексации для вашего веб-сайта.

Хотя вы можете столкнуться с крайними случаями, которые не соответствуют логике, которую я предлагаю, описанный ниже процесс даст вам отличные результаты в подавляющем большинстве случаев.

Почему некоторые страницы не должны быть проиндексированы

Есть две основные причины, по которым вы не должны хотеть, чтобы поисковые системы индексировали все ваши страницы:

- Это помогает оптимизировать краулинговый бюджет,

- Большое количество некачественного контента, который можно индексировать, может повредить тому, как поисковые системы видят ваш сайт.

Оптимизируйте краулинговый бюджет

Боты поисковых систем могут сканировать ограниченное количество страниц на данном веб-сайте. Интернет бесконечно велик, и сканирование всего превысит ресурсы поисковых систем.

Количество времени и ресурсов, которое роботы поисковых систем тратят на сканирование вашего сайта, называется краулинговым бюджетом. Если вы тратите краулинговый бюджет на низкокачественные страницы, его может не хватить на наиболее ценные, которые действительно должны быть проиндексированы.

Потратив время на то, чтобы решить, какие страницы вы хотите проиндексировать, вы сможете оптимизировать свой краулинговый бюджет и убедиться, что роботы поисковых систем не тратят свои ресурсы на менее важные страницы.

Если вы хотите узнать больше об оптимизации краулингового бюджета, ознакомьтесь с нашим Полным руководством по оптимизации краулингового бюджета.

Не позволяйте низкокачественному контенту навредить вашему сайту

Если поисковые системы поймут, что у вас много некачественного контента, они могут решить прекратить сканировать ваш сайт так часто.

Томек Рудзки в своем Ultimate Guide to Indexing SEO назвал это « коллективной ответственностью ».

Это порочный круг:

- Google сканирует некачественные страницы.

- Google перестает посещать сайт так часто.

- Многие страницы никогда не сканируются Google, даже если это высококачественные страницы.

- Есть ценные страницы, которые не проиндексированы.

Это показывает, как взаимосвязаны ранжирование, сканирование и индексирование.

источник: Томаш Рудзки

Методы управления индексацией

Существуют различные методы, которые вы можете использовать для управления индексацией своих страниц, в том числе:

- метатег Noindex для роботов,

- Директива Disallow в robots.txt,

- Канонический тег,

- Постоянная переадресация,

- XML-карта сайта.

Каждый из вышеперечисленных методов имеет свое применение и функцию.

Метатег Noindex для роботов

<meta name="роботы" content="noindex">Если вы добавите указанную выше директиву в раздел HTML <head> своей страницы, роботы поисковых систем поймут, что они не должны его индексировать. Это предотвратит появление страницы на странице результатов поисковых систем.

Вам следует использовать этот тег, если вы не хотите, чтобы страница индексировалась, но все же хотите, чтобы роботы поисковых систем сканировали вашу страницу и, например, переходили по ссылкам на этой странице.

Директива Disallow в robots.txt

Пользовательский агент: * Запретить: /example/page.html

Директива disallow в файле robots.txt позволяет заблокировать доступ поисковых систем к странице. Если бот поисковой системы соблюдает директиву, он не будет сканировать запрещенные страницы и, следовательно, они не будут проиндексированы.

Поскольку директива disallow ограничивает сканирование, этот метод может помочь вам сэкономить бюджет сканирования.

Примечание. Директива disallow не является надлежащим способом блокировки доступа к вашим конфиденциальным страницам. Вредоносные боты игнорируют файл robots.txt и по-прежнему могут получить доступ к содержимому. Если вы хотите, чтобы некоторые страницы были недоступны для всех ботов, лучше заблокируйте их паролем.

Канонический тег

<link rel="canonical" href="https://www.example.com/page.html">Канонический тег — это элемент HTML, который сообщает поисковым системам, какие повторяющиеся URL-адреса являются оригинальными.

Используя тег canonical, вы точно указываете, какую версию страницы вы хотите проиндексировать и отобразить в результатах поиска. Без канонического тега вы не можете контролировать, какая версия вашей страницы будет проиндексирована.

Ротам поисковых систем по-прежнему необходимо сканировать страницу, чтобы обнаружить канонический тег, поэтому его использование не поможет вам сэкономить бюджет сканирования.

Постоянная переадресация

Перенаправление 301 — это код ответа HTTP, указывающий на постоянное перенаправление. Он указывает, что запрошенная страница находится в новом местоположении, а старая страница была удалена с сервера.

Когда вы используете переадресацию 301, пользователи и боты поисковых систем не будут получать доступ к старому URL-адресу. Вместо этого сигналы трафика и ранжирования будут перенаправлены на новую страницу.

Использование редиректа 301 — хороший способ сэкономить краулинговый бюджет. Вы уменьшаете количество страниц, доступных на вашем веб-сайте, поэтому у роботов поисковых систем остается меньше контента для сканирования.

Помните, что вы должны перенаправлять только на связанную страницу. Перенаправление на несвязанную страницу может запутать пользователей. Кроме того, боты поисковых систем могут не следовать перенаправлению и рассматривать страницу как программную ошибку 404.

XML-карты сайта

XML-карта сайта — это текстовый файл, в котором перечислены URL-адреса, которые должны быть проиндексированы поисковыми системами. Его цель — помочь ботам поисковых систем легко найти интересующие вас страницы.

Хорошо оптимизированная карта сайта не только направляет поисковые системы на ваши ценные страницы , но и помогает вам сэкономить краулинговый бюджет. Без него ботам необходимо просканировать весь сайт, чтобы найти ценный контент.

Вот почему в картах сайта должны быть перечислены только индексируемые URL-адреса вашего веб-сайта. Это означает, что страницы, которые вы добавляете в карту сайта, должны быть:

- Канонический,

- Не блокируется метатегом noindex robots и

- Не блокируется директивой disallow в robots.txt,

- Отвечает с кодом состояния 200.

Вы можете узнать больше об оптимизации файлов Sitemap в нашем Ultimate Guide to XML Sitemaps.

Как решить, какие страницы должны или не должны быть проиндексированы

Чтобы помочь вам решить, какие страницы следует или не следует индексировать, я создал дерево решений со всеми основными вопросами, на которые вам нужно ответить.

Просмотрите изображение в полном размере.

Как вы можете видеть выше, фундаментальный вопрос: ценна ли эта страница для кого-либо?

На этот вопрос есть три возможных ответа:

- Страница представляет ценность для пользователей поисковых систем (и поисковых систем),

- Страница ценна для поисковых систем,

- Страница никому не нужна.

Суть в том, что индексироваться должны только страницы, ценные для пользователей. Однако даже в этой категории есть типы страниц, которые не следует индексировать.

Давайте сломаем это.

Страницы, ценные для пользователей

Страница ценна для пользователей поисковых систем, если она дает ответ на их поиск или позволяет им перейти к ответу.

В большинстве случаев, если страница представляет ценность для пользователей, ее следует проиндексировать. Однако все же может возникнуть ситуация, когда страница представляет ценность для пользователей, но ее не следует индексировать.

Страницы, ценные для пользователей, которые должны быть проиндексированы

Страница должна быть проиндексирована, если:

- Предоставляет качественный, уникальный контент, который приносит трафик,

- Это альтернативная языковая версия другой высококачественной страницы (если применимо).

Качественный, уникальный контент

Качественные, уникальные страницы, которые приносят трафик на ваш сайт, обязательно должны попасть в вашу карту сайта. Убедитесь, что вы не блокируете их в файле robots.txt, и у них нет мета-тега robots noindex.

Обратите особое внимание на самые ценные страницы для вашего бизнеса . Именно они обычно приносят наибольшую конверсию. Страницы типа:

- Домашняя страница,

- О нас и контактных страницах,

- Страницы с информацией о предоставляемой вами услуге,

- Статьи в блогах, демонстрирующие ваш опыт,

- Страницы с определенными товарами (например, продуктами электронной коммерции),

всегда должны быть индексируемыми, и вы должны регулярно следить за их индексацией.

Альтернативная языковая версия

Переведенный контент не рассматривается поисковыми системами как дубликат. На самом деле поисковые системы хотят знать, есть ли у вас несколько языковых версий, чтобы предоставить наиболее подходящую версию пользователям в разных странах.

Если у вас есть альтернативная языковая версия страницы, вы должны указать ее с помощью тега hreflang и поместить страницу в свою карту сайта.

Вы можете указать теги hreflang в карте сайта, HTML или в том и другом. Теги hreflang, используемые в картах сайта, прекрасно подходят для поисковых систем. Однако их может быть сложно проверить с помощью инструментов SEO или плагинов для браузера. По этой причине рекомендуемый способ добавления тега — в HTML-код и карту сайта или только в HTML-код.

Помните, что на каждой странице должны быть указаны все языковые версии, включая собственный язык.

Страницы, ценные для пользователей, которые не должны быть проиндексированы

В некоторых ситуациях страницы могут быть полезны пользователям, но их все равно не следует индексировать. К ситуациям относятся:

- Дублированный или почти дублированный контент,

- Страницы без поискового запроса.

Дубликат или почти дубликат другой страницы

Боты поисковых систем могут считать страницу дубликатом или почти дубликатом, если:

- Два или более разных URL ведут на одну и ту же страницу,

- Две разные страницы имеют очень похожий контент.

Одним из наиболее распространенных примеров дублированного контента являются отфильтрованные страницы категорий на сайтах электронной коммерции. Пользователи могут применять фильтры, чтобы сузить список продуктов и быстрее найти то, что они ищут. К сожалению, каждый примененный фильтр может сохранять параметры в URL-адресе, создавая несколько URL-адресов, ведущих на одну и ту же страницу.

Например, store.com/dresses/item и store.com/dresses/item?color=yellow могут указывать на один и тот же контент.

Другие причины дублирования или почти дублирования контента включают:

- Имея разные URL-адреса для мобильных и настольных версий,

- Наличие печатной версии вашего сайта или

- Создание дублированного контента по ошибке.

Риски наличия индексируемого дублированного контента включают в себя:

- Нет контроля над тем, какая версия может отображаться в результатах поиска. Например, если у вас есть печатная и обычная версии, поисковые системы могут отображать печатную версию в поиске.

- Разделение сигналов ранжирования между несколькими URL-адресами.

- Резкое увеличение количества URL-адресов, которые поисковые системы должны сканировать.

- Снижение вашей позиции в поисковой выдаче, если поисковые системы решат, что вы хотите манипулировать рейтингом (редкое последствие).

Чтобы избежать негативных последствий наличия дублированного контента, вы должны стремиться к его консолидации . Основные способы сделать это включают канонические теги и 301 редиректы.

Канонические теги — лучший вариант, если вам нужно, чтобы все страницы были доступны для пользователей.

Примером дублированного контента, который должен оставаться доступным на вашем сайте, является контент, улучшающий взаимодействие с пользователем. Например, когда пользователи фильтруют продукты на сайте электронной коммерции, их перенаправление может сбивать с толку по разным причинам, например из-за внезапного изменения хлебных крошек.

Кроме того, может потребоваться дублирование контента на вашем сайте, если у вас разные версии для разных устройств.

При переадресации 301 на вашем сайте остается доступной только одна из страниц. Остальные будут автоматически перенаправлены.

Перенаправление 301 может быть полезно, когда, например, у вас есть два очень похожих поста в блоге, и вы решили, что на вашем сайте должен остаться только один. Код состояния 301 перенаправит трафик и сигналы ранжирования на выбранную вами статью. Это отличный метод оптимизации краулингового бюджета, но вы можете использовать его только тогда, когда хотите удалить повторяющуюся страницу.

Не забывайте вносить изменения в карту сайта всякий раз, когда используете постоянные перенаправления. Вы должны помещать в свою карту сайта только те страницы, которые отвечают кодами состояния 200. Поэтому, если вы используете перенаправление 301 для консолидации контента, в карте сайта должна оставаться только та версия, которая остается на вашем веб-сайте.

Страницы без поискового запроса

На вашем сайте может быть хороший контент, который не пользуется спросом в поиске. Другими словами, его никто не ищет. Это может произойти, когда вы пишете о нишевом хобби или имеете страницы, например, с примечанием «спасибо» для ваших пользователей.

Эти страницы могут не приносить трафика или конверсий. Возможно, вы хотите оставить их, потому что они дополняют пути пользователей, но вы не хотите, чтобы они были первым, что пользователи увидят в результатах поиска.

Если вы считаете, что пользователи не должны видеть определенную страницу в результатах поиска или страница не приносит никакого трафика, нет необходимости ее индексировать. Таким образом, поисковые роботы могут сосредоточиться на страницах, которые действительно приносят вам трафик.

Чтобы заблокировать индексацию страницы без поискового запроса, используйте метатег robots noindex. Боты не будут его индексировать, но они все равно будут сканировать его и переходить по ссылкам на этой странице, предоставляя им больше информации о вашем веб-сайте.

Страницы, ценные только для поисковых систем

Не все страницы предназначены для помощи пользователям. Некоторые из них помогают поисковым системам узнать о вашем сайте и найти ссылки.

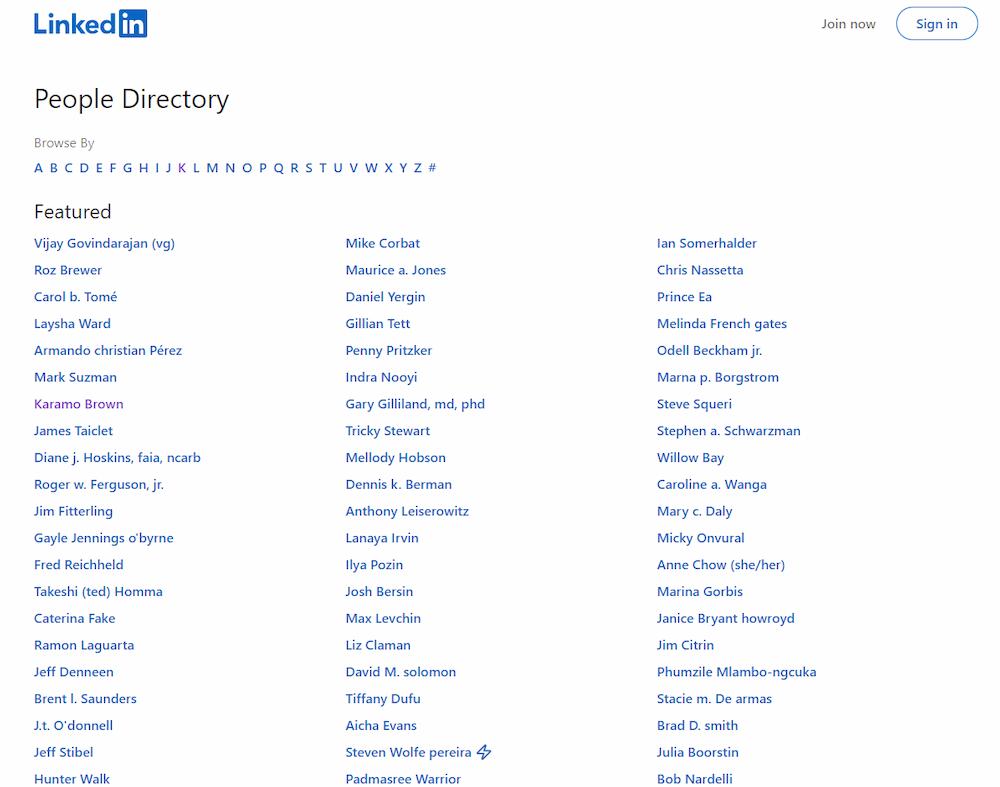

Взгляните на эту страницу LinkedIn:

В нем перечислены все профили пользователей, что облегчает поисковым системам поиск всех ссылок.

С одной стороны, подобные страницы могут запутать пользователей и отбить у них желание оставаться на сайте. Они не представляют для них ценности, поэтому не должны отображаться в результатах поиска и не должны индексироваться.

С другой стороны, они полезны для поисковых систем — они повышают вашу внутреннюю перелинковку.

Вот почему лучшим решением является внедрение мета-тегов noindex для роботов, исключение этих страниц из вашей карты сайта и разрешение их сканирования в файле robots.txt. Они не будут проиндексированы, но их будут сканировать боты.

Страницы, которые никому не нужны

Некоторые страницы не представляют ценности для пользователей или поисковых систем.

Некоторые из них должны присутствовать на вашем сайте по закону, например, политика конфиденциальности, но, будем честными – никто не ищет этот тип контента. Удалить их, конечно, нельзя, но и индексировать их не нужно, потому что никто не хочет их находить. В некоторых случаях они могут опережать более ценный контент и «воровать» трафик.

Страницы, не имеющие ценности, также содержат низкокачественный контент. Вам следует обратить на них особое внимание, так как они могут отрицательно сказаться на том, как пользователи и поисковые системы воспринимают общее качество вашего сайта. Дополнительную информацию см . в главе « Низкокачественный контент может повредить ваш веб-сайт» .

Самое главное, вам нужно убедиться, что страницы без значения имеют метатег robots noindex. Если вы не заблокируете их индексацию, они могут повредить вашему рейтингу и отпугнуть пользователей от посещения вашего веб-сайта.

Кроме того, если вы хотите оптимизировать краулинговый бюджет, заблокируйте эти страницы в файле robots.txt и удалите внутренние ссылки, указывающие на них. Это поможет вам сэкономить краулинговый бюджет для более ценных страниц.

Подведение итогов

Знание того, какие из ваших страниц должны и не должны быть проиндексированы, и сообщение об этом роботам поисковых систем имеет решающее значение для создания надежной стратегии индексации.

Это максимизирует шансы на правильное сканирование и индексацию вашего веб-сайта и гарантирует, что ваши пользователи смогут найти весь ваш ценный контент в результатах поиска.

Вот основные выводы, которые необходимо учитывать при создании стратегии индексации:

- Принимая решение о том, следует ли индексировать страницу, спросите себя, есть ли на ней уникальный контент, представляющий ценность для пользователей. Уникальные, ценные страницы не должны быть заблокированы от индексации с помощью мета-тегов noindex для роботов или заблокированы от сканирования с помощью директив disallow в файле robots.txt.

- Если ваш некачественный контент индексируется, это может негативно повлиять на ваш рейтинг и поставить ваши ценные страницы под угрозу индексации.

- Если на вашем сайте есть дублированный или почти дублированный контент, вы должны объединить его с помощью канонического тега или перенаправления 301.

- Если страница не имеет поискового спроса, ее не нужно индексировать — используйте noindex в метатеге robots.

- Страницы, которые содержат контент или ссылки, ценные только для поисковых систем, должны быть заблокированы от индексации с помощью мета-тега robots noindex, но не блокируйте их от сканирования в файле robots.txt.

- Если ни пользователи, ни поисковые системы не получают выгоды от посещения данной страницы, для нее следует установить значение noindex в метатеге robots.

- Если у вас есть несколько версий одной и той же страницы на разных языках, оставьте их индексируемыми. Используйте тег hreflang, чтобы помочь поисковым системам понять, как связаны эти страницы.