SEO 101のインデックス作成:Webサイトのインデックス作成戦略を作成する方法

公開: 2021-12-14検索エンジンはあなたのウェブサイト上のすべてのページを索引付けするべきではありません。

あなたのサイトのすべてが素晴らしいと思っていても、ほとんどのWebサイトには、検索結果に含まれないページがたくさんあります。 そして、検索エンジンにそれらのページのインデックスを作成させると、悪影響に直面する可能性があります。

そのため、サイトのインデックス作成戦略が必要です。 その重要な要素は次のとおりです。

- 検索エンジンにインデックスを付けるページを決定し、適切な方法を使用してインデックスを作成する可能性を最大化します。

- インデックスに登録するべきではないページと、潜在的な検索の可視性を制限せずにそれらを検索から除外する方法を決定します。

どのページをインデックスに登録するか、しないかを決定するのは困難です。 特定のページに関するガイドラインやヒントが見つかるかもしれませんが、多くの場合、自分で作成します。

また、これらのページを検索結果から除外するための適切な方法を選択するには、さらに検討が必要です。 noindexタグまたはcanonicalタグを使用するか、robots.txtでページをブロックするか、永続的なリダイレクトを使用する必要がありますか?

この記事では、Webサイトのカスタムインデックス作成戦略を作成できるようにする意思決定プロセスの概要を説明します。

私が提案するロジックに準拠していないエッジケースに遭遇する可能性がありますが、以下に下線が引かれているプロセスは、圧倒的多数のケースで素晴らしい結果をもたらします。

一部のページをインデックスに登録しない理由

検索エンジンにすべてのページのインデックスを作成させたくない主な理由は2つあります。

- クロール予算を最適化するのに役立ちます。

- インデックスに登録できる低品質のコンテンツがたくさんあると、検索エンジンがWebサイトを見る方法が損なわれる可能性があります。

クロール予算を最適化する

検索エンジンボットは、特定のWebサイトの限られた数のページをクロールできます。 インターネットは無限に大きく、すべてをクロールすると、検索エンジンが持つリソースを超えてしまいます。

検索エンジンボットがWebサイトのクロールに費やす時間とリソースは、クロールバジェットと呼ばれます。 低品質のページでクロール予算を浪費すると、実際にインデックスを作成する必要がある最も価値のあるページには十分ではない可能性があります。

時間をかけてインデックスを作成するページを決定することで、クロール予算を最適化し、検索エンジンボットが重要度の低いページでリソースを浪費しないようにすることができます。

クロール予算の最適化について詳しく知りたい場合は、クロール予算の最適化に関する究極のガイドをご覧ください。

低品質のコンテンツがあなたのウェブサイトに損害を与えないようにしてください

検索エンジンは、低品質のコンテンツがたくさんあることに気付いた場合、ウェブサイトのクロールを頻繁に停止することを決定する可能性があります。

Tomek Rudzkiは、 SEOのインデックス作成に関する究極のガイドで、これを「共同責任」と呼んでいます。

それは悪循環です:

- Googleは低品質のページをクロールします。

- Googleは頻繁にウェブサイトにアクセスするのをやめます。

- 高品質のページであっても、多くのページがGoogleによってクロールされることはありません。

- インデックスに登録されていない貴重なページがあります。

これは、ランキング、クロール、およびインデックス作成がどのように相互接続されているかを示しています。

出典: Tomasz Rudzki

インデックス作成を制御する方法

ページのインデックス作成を制御するために使用できるさまざまな方法があります。

- Noindexロボットのメタタグ、

- robots.txtでディレクティブを禁止します。

- カノニカルタグ、

- 永続的なリダイレクト、

- XMLサイトマップ。

上記の各メソッドには、独自の用途と機能があります。

Noindexロボットのメタタグ

<meta name = "robots" content = "noindex">上記のディレクティブをページのHTML<head>セクションに追加すると、検索エンジンボットはインデックスを作成すべきではないことを理解します。 これにより、ページが検索エンジンの結果ページに表示されなくなります。

ページのインデックスを作成したくないが、検索エンジンボットがページをクロールし、たとえばそのページのリンクをたどる場合は、このタグを使用する必要があります。

robots.txtでディレクティブを禁止する

ユーザーエージェント: * 禁止:/example/page.html

robots.txtファイルのdisallowディレクティブを使用すると、検索エンジンによるページへのアクセスをブロックできます。 検索エンジンボットがディレクティブを尊重する場合、許可されていないページをクロールしないため、インデックスに登録されません。

disallowディレクティブはクロールを制限するため、この方法はクロールの予算を節約するのに役立ちます。

注:disallowディレクティブは、機密ページへのアクセスをブロックする適切な方法ではありません。 悪意のあるボットはrobots.txtファイルを無視し、コンテンツにアクセスできます。 一部のページにすべてのボットがアクセスできないようにする場合は、パスワードでブロックすることをお勧めします。

カノニカルタグ

<link rel = "canonical" href = "https://www.example.com/page.html">正規タグは、どの重複URLが元のURLであるかを検索エンジンに通知するHTML要素です。

正規タグを使用して、インデックスを作成して検索結果に表示するページのバージョンを正確に指定します。 正規タグがないと、ページのどのバージョンがインデックスに登録されるかを制御できません。

検索エンジンボットは、正規タグを見つけるためにページをクロールする必要があるため、それを使用してもクロール予算を節約することはできません。

永続的なリダイレクト

301リダイレクトは、永続的なリダイレクトを示すHTTP応答コードです。 要求されたページに新しい場所があり、古いページがサーバーから削除されたことを指定します。

301リダイレクトを使用すると、ユーザーと検索エンジンボットは古いURLにアクセスしません。 代わりに、トラフィックとランキングのシグナルが新しいページにリダイレクトされます。

301リダイレクトを使用することは、クロールバジェットを節約するための優れた方法です。 Webサイトで利用できるページ数を減らしているため、検索エンジンボットはクロールするコンテンツが少なくなっています。

関連するページにのみリダイレクトする必要があることに注意してください。 無関係なページにリダイレクトすると、ユーザーが混乱する可能性があります。 さらに、検索エンジンのボットはリダイレクトに従わず、ページをソフト404として扱う可能性があります。

XMLサイトマップ

XMLサイトマップは、検索エンジンでインデックスを作成するURLを一覧表示するテキストファイルです。 その目的は、検索エンジンボットが気になるページを簡単に見つけられるようにすることです。

適切に最適化されたサイトマップは、検索エンジンを貴重なページに誘導するだけでなく、クロール予算を節約するのにも役立ちます。 これがないと、ボットはサイト全体をクロールして貴重なコンテンツを見つける必要があります。

そのため、サイトマップにはWebサイトのインデックス可能なURLのみをリストする必要があります。 これは、サイトマップに配置するページが次のようになることを意味します。

- カノニカル、

- noindex robotsメタタグによってブロックされていない、および

- robots.txtのdisallowディレクティブによってブロックされていません。

- 200ステータスコードで応答します。

サイトマップの最適化について詳しくは、XMLサイトマップの究極のガイドをご覧ください。

インデックスを作成するページとインデックスを作成しないページを決定する方法

どのページをインデックスに登録するかどうかを決定するのに役立つように、私はあなたが答える必要のあるすべての重要な質問を含む決定木を作成しました。

画像をフルサイズで表示します。

上記のように、基本的な質問は次のとおりです。このページは誰にとっても価値がありますか?

その質問に対する3つの可能な答えがあります:

- このページは、検索エンジンのユーザー(および検索エンジン)にとって価値があります。

- このページは検索エンジンにとって価値があり、

- このページは誰にとっても価値がありません。

肝心なのは、ユーザーにとって価値のあるページだけをインデックスに登録する必要があるということです。 ただし、そのカテゴリでも、インデックスに登録してはならない種類のページがあります。

分解してみましょう。

ユーザーにとって価値のあるページ

ページは、検索に対する回答を提供したり、回答に移動したりできる場合、検索エンジンユーザーにとって価値があります。

ほとんどの場合、ページがユーザーにとって価値がある場合は、インデックスを作成する必要があります。 ただし、ページがユーザーにとって価値があるが、インデックスを作成するべきではないという状況がまだ存在する可能性があります。

インデックスを作成する必要があるユーザーにとって価値のあるページ

次の場合、ページにインデックスを付ける必要があります。

- トラフィックをもたらす高品質でユニークなコンテンツを提供し、

- これは、別の高品質ページの代替言語バージョンです(該当する場合)。

高品質でユニークなコンテンツ

あなたのサイトにトラフィックをもたらす高品質でユニークなページは間違いなくあなたのサイトマップに到達するはずです。 robots.txtでブロックしないようにしてください。また、noindexメタロボットタグがありません。

あなたのビジネスにとって最も価値のあるページに特に注意を払ってください。 それらは通常最も多くのコンバージョンをもたらすものです。 次のようなページ:

- ホームページ、

- 私たちと連絡先ページについて、

- 提供するサービスに関する情報が記載されたページ、

- あなたの専門知識を示すブログ記事、

- 特定のアイテム(eコマース製品など)を含むページ、

常にインデックス付け可能である必要があり、定期的にインデックス作成を監視する必要があります。

代替言語バージョン

翻訳されたコンテンツは、検索エンジンによって重複として扱われません。 実際、検索エンジンは、さまざまな国のユーザーに最適なバージョンを提示するために利用できる複数の言語バージョンがあるかどうかを知りたいと考えています。

ページの代替言語バージョンがある場合は、 hreflangタグで指定し、ページをサイトマップに配置する必要があります。

サイトマップ、HTML、またはその両方でhreflangタグを指定できます。 サイトマップで使用されるHreflangタグは、検索エンジンの観点からは完全に問題ありません。 ただし、SEOツールやブラウザプラグインでは確認が難しい場合があります。 そのため、タグを追加するための推奨される方法は、HTMLコードとサイトマップ、またはHTMLコードのみです。

各ページでは、独自の言語を含むすべての言語バージョンを指定する必要があることに注意してください。

インデックスに登録すべきではないユーザーにとって価値のあるページ

状況によっては、ページはユーザーにとって価値がある場合がありますが、それでもインデックスを作成するべきではありません。 状況は次のとおりです。

- 重複またはほぼ重複するコンテンツ、

- 検索を必要としないページ。

別のページの重複またはほぼ重複

検索エンジンボットは、次の場合にページが重複またはほぼ重複していると見なす可能性があります。

- 2つ以上の異なるURLが同じページにつながります。

- 2つの異なるページの内容は非常に似ています。

重複コンテンツの最も一般的な例の1つは、eコマースサイトのフィルタリングされたカテゴリページです。 ユーザーはフィルターを適用して製品を絞り込み、探しているものをすばやく見つけることができます。 残念ながら、適用された各フィルターはパラメーターをURLに保存し、同じページにつながる複数のURLを作成する可能性があります。

たとえば、store.com / dresses/itemとstore.com/dresses/item?color=yellowは同じコンテンツを指している場合があります。

コンテンツが重複またはほぼ重複するその他の理由は次のとおりです。

- モバイルバージョンとデスクトップバージョンで異なるURLを使用し、

- あなたのウェブサイトの印刷版を持っている、または

- 誤って重複コンテンツを作成しています。

インデックス可能な重複コンテンツを持つリスクには、次のものがあります。

- 検索結果に表示される可能性のあるバージョンを制御することはできません。 たとえば、印刷版と通常版が利用できる場合、検索エンジンは検索で印刷版を表示することがあります。

- ランキング信号を複数のURLに分割します。

- 検索エンジンがクロールする必要のあるURLの数を大幅に増やします。

- 検索エンジンがランキングを操作したいと判断した場合、SERPでの位置を下げる(まれな結果)。

コンテンツが重複することによる悪影響を回避するには、コンテンツの統合を目指す必要があります。 これを行う主な方法には、正規タグと301リダイレクトが含まれます。

すべてのページをユーザーが利用できるようにする必要がある場合は、正規タグが最適なオプションです。

サイトで引き続き利用できるはずの重複コンテンツの例は、ユーザーエクスペリエンスを向上させるものです。 たとえば、ユーザーがeコマースサイトで商品をフィルタリングする場合、パンくずリストの突然の変更など、さまざまな理由で商品のリダイレクトが混乱する可能性があります。

さらに、デバイスごとにバージョンが異なる場合は、サイトに重複するコンテンツが必要になる場合があります。

301リダイレクトを使用すると、サイトで使用できるページは1つだけになります。 残りは自動的にリダイレクトされます。

たとえば、非常によく似たブログ投稿が2つあり、サイトに1つだけ残す必要があると判断した場合は、301リダイレクトが役立つことがあります。 301ステータスコードは、トラフィックとランキング信号を選択した記事にリダイレクトします。 これはクロール予算を最適化する優れた方法ですが、重複するページを削除する場合にのみ使用できます。

永続的なリダイレクトを使用する場合は常に、サイトマップに変更を加えることを忘れないでください。 サイトマップには、200のステータスコードで応答するページのみを配置する必要があります。 したがって、301リダイレクトを使用してコンテンツを統合している場合は、Webサイトに残っているバージョンのみをサイトマップに残す必要があります。

検索の需要がないページ

あなたは検索の需要がないあなたのサイトに良いコンテンツを持っているかもしれません。 言い換えれば、誰もそれを探していません。 これは、ニッチな趣味について書いている場合や、ユーザーへの「ありがとう」のメモなどのページがある場合に発生する可能性があります。

これらのページはトラフィックやコンバージョンをもたらさない可能性があります。 おそらく、ユーザーの旅を補完するためにそれらを残したいが、ユーザーが検索結果に最初に表示するものにしたくない場合があります。

ユーザーが検索結果に特定のページを表示する必要がないと思われる場合、またはページにトラフィックがない場合は、インデックスを作成しておく必要はありません。 このようにして、検索エンジンボットは実際にトラフィックを獲得しているページに集中できます。

検索要求のないページのインデックス作成をブロックするには、noindexmetarobotsタグを使用します。 ボットはインデックスを作成しませんが、それでもクロールしてそのページのリンクをたどり、Webサイトに関するより多くのコンテキストを提供します。

検索エンジンだけに価値のあるページ

すべてのページがユーザーを支援することを目的としているわけではありません。 それらのいくつかは、検索エンジンがあなたのウェブサイトについて学び、リンクを発見するのを助けます。

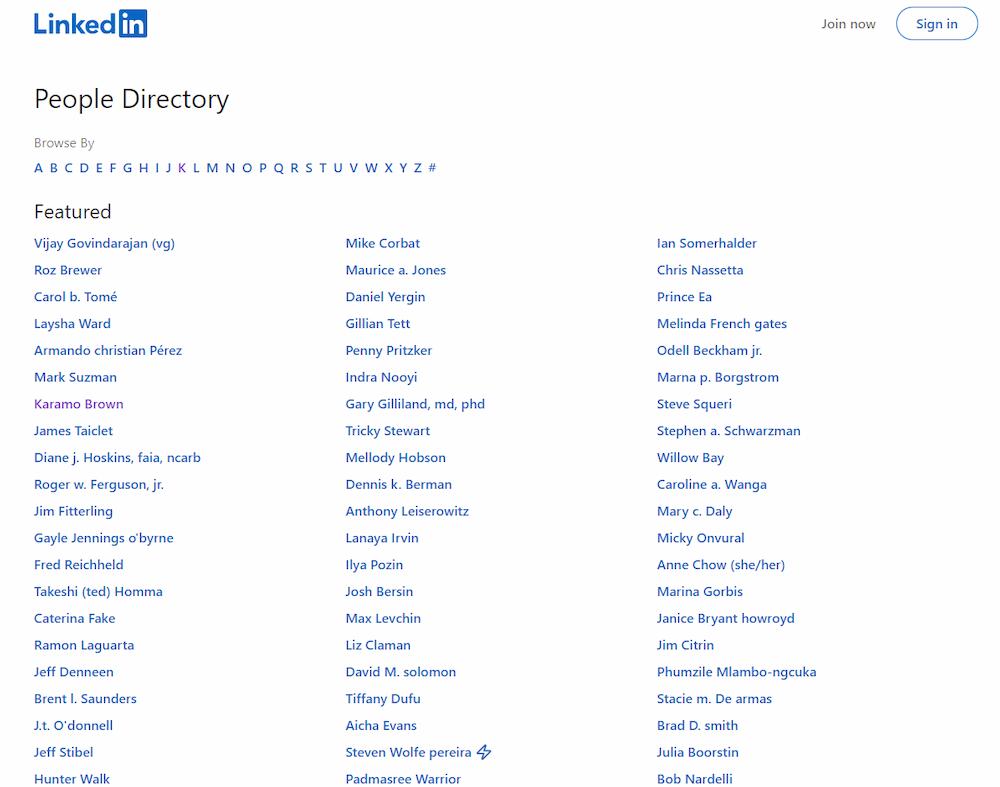

このLinkedInページを見てください:

すべてのユーザーのプロファイルが一覧表示されるため、検索エンジンはすべてのリンクを簡単に見つけることができます。

一方では、このようなページはユーザーを混乱させ、サイトにとどまることを思いとどまらせる可能性があります。 それらは彼らにとって価値がないので、検索結果に表示されたり、索引付けされたりするべきではありません。

一方、それらは検索エンジンに役立ちます–それらはあなたの内部リンクを後押しします。

そのため、最善の解決策は、noindexメタロボットタグを実装し、これらのページをサイトマップから除外し、robots.txtでクロールできるようにすることです。 それらはインデックスに登録されませんが、ボットはそれらをクロールします。

誰にとっても価値のないページ

一部のページは、ユーザーや検索エンジンにとって価値がありません。

それらのいくつかは、法律によってサイトに存在することが義務付けられています。たとえば、プライバシーポリシーですが、正直に言うと、このタイプのコンテンツを検索している人は誰もいません。 もちろん、それらを削除することはできませんが、誰もそれらを見つけたくないので、それらを索引付けする必要はありません。 場合によっては、より価値のあるコンテンツを上回り、トラフィックを「盗む」可能性があります。

価値のないページには、薄くて低品質のコンテンツも含まれます。 ユーザーや検索エンジンがサイトの全体的な品質を認識する方法を損なう可能性があるため、特に注意を払う必要があります。 詳細については、低品質のコンテンツがWebサイトの章に損傷を与える可能性があるを参照してください。

最も重要なことは、値のないページにnoindexmetarobotsタグが付いていることを確認する必要があります。 インデックス作成をブロックしないと、ランキングが低下し、ユーザーがWebサイトにアクセスできなくなる可能性があります。

さらに、クロールバジェットを最適化する場合は、robots.txtファイルでこれらのページをブロックし、それらを指す内部リンクを削除します。 これにより、より価値のあるページのクロール予算を節約できます。

まとめ

インデックスを作成する必要があるページとインデックスを作成しないページを把握し、それを検索エンジンボットに伝達することは、適切なインデックス作成戦略を作成する上で非常に重要です。

それはあなたのウェブサイトが適切にクロールされて索引付けされる可能性を最大にし、あなたのユーザーが検索結果であなたのすべての価値あるコンテンツを見つけることができることを確実にします。

インデックス作成戦略を作成する際に留意する必要のある重要なポイントは次のとおりです。

- ページにインデックスを付けるかどうかを決定するときは、ユーザーにとって価値のある独自のコンテンツがあるかどうかを自問してください。 ユニークで価値のあるページは、noindex meta robotsタグによるインデックス作成をブロックしたり、robots.txtdisallowディレクティブを使用したクロールをブロックしたりしないでください。

- 低品質のコンテンツがインデックスに登録可能である場合、ランキングに悪影響を及ぼし、貴重なページがインデックスに登録されないリスクにさらされる可能性があります。

- サイトに重複またはほぼ重複するコンテンツがある場合は、正規タグまたは301リダイレクトを使用してコンテンツを統合する必要があります。

- ページに検索要求がない場合は、インデックスを作成する必要はありません。メタロボットタグでnoindexを使用してください。

- 検索エンジンにのみ価値のあるコンテンツやリンクを含むページは、noindex meta robotsタグを使用してインデックスに登録されないようにブロックする必要がありますが、robots.txtでクロールされるのをブロックしないでください。

- ユーザーも検索エンジンも特定のページにアクセスするメリットがない場合は、メタロボットタグでnoindexに設定する必要があります。

- 同じページに複数の代替言語バージョンがある場合は、それらを索引付け可能にしてください。 hreflangタグを使用して、検索エンジンがこれらのページがどのように関連しているかを理解できるようにします。