2023 年網頁抓取技術 – 完整指南

已發表: 2023-07-06在廣闊的在線尋寶世界中,網絡抓取已成為提取有價值的信息寶石的終極工具。 無論您是孤獨的冒險家還是渴求數據的企業,網絡抓取都是您數字工具包中值得信賴的鎬。

然而,並非所有網絡抓取技術都是一樣的。 這就像為手頭的任務選擇完美的釣魚竿一樣。 畢竟,你不會用一個小魚鉤來捕捉像莫比迪克這樣的巨大生物,對吧? 在這篇博客中,我們將揭開手動、自動和高級網絡抓取技術背後的秘密。

想像一下組建一支超級英雄團隊,每個人都有自己的特殊能力和弱點。 同樣,每種抓取方法都有其優點和局限性。

但我們不要忘記在網絡抓取中負責任的行為的重要性。 正如騎士永遠不會違背誓言一樣,以道德方式進行抓取並尊重您想要抓取的網站的服務條款至關重要。

自動網頁抓取技術

自動網頁抓取是指使用軟件或工具自動從網站中提取數據的過程。 這種自動化方法消除了手動複製和粘貼數據的需要,從而可以從各種在線來源高效且大規模地收集數據。

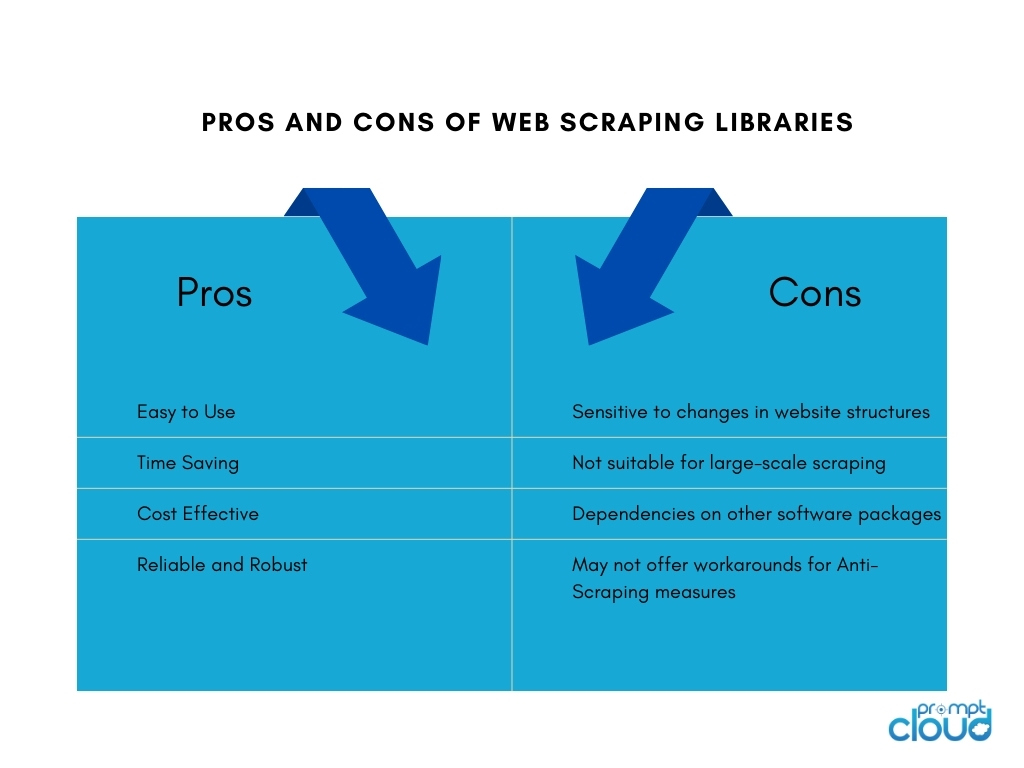

1. 網頁抓取庫

網頁抓取庫是提供預構建功能和實用程序以促進網頁抓取任務的軟件工具或框架。 它們提供了一種簡單而有效的方法來執行網頁抓取,而無需從頭開始編寫所有內容。 它們可以節省時間、提高生產力,並能夠更有效地從不同的在線來源收集數據。

一些流行的網絡抓取庫包括:

- BeautifulSoup:廣泛使用的用於網頁抓取的 Python 庫,提供直觀的 API 來解析 HTML 和 XML 文檔,允許用戶輕鬆導航和提取數據。

- Scrapy:一個強大的 Python 網絡抓取框架,提供了一套全面的工具來構建可擴展且高效的網絡爬蟲,具有自動請求限制、項目管道和處理分頁的內置支持等功能。

- Selenium:一個多功能庫,允許自動瀏覽器交互進行網頁抓取,在處理動態內容和 JavaScript 密集型網站時特別有用。

- Puppeteer:一個 Node.js 庫,提供高級 API 來控制無頭 Chrome 或 Chromium 瀏覽器,支持使用 JavaScript 進行網頁抓取和與網頁交互。

2. 網頁抓取工具和服務

網頁抓取工具

網頁抓取工具是專門為自動化和簡化網頁抓取過程而設計的軟件應用程序或平台。 這些工具通常提供用戶友好的界面,允許用戶指定他們想要從網站提取的數據,而無需廣泛的編程知識。

它們通常提供諸如點擊式選擇數據元素、調度和監控功能以及數據導出選項等功能。 網絡抓取工具對於需要數據提取而無需大量編碼或開發資源的個人或企業來說可能是有益的。

構建內部網絡抓取工具

為公司構建內部網絡抓取工具有其優點和缺點:

網頁抓取服務

網絡抓取服務提供商提供從網站提取數據的專業服務。 這些提供商通常擁有專門代表客戶處理網絡抓取任務的基礎設施、工具和專業知識。

以下是使用網絡抓取服務提供商的優點和缺點:

網頁抓取 API

Web 抓取 API 提供了一個編程接口,允許開發人員使用標準化方法從網站訪問和檢索數據。 與傳統的抓取技術相比,這些 API 提供了一種更加結構化和可控的網絡抓取方法。 開發人員可以向 API 發送請求,指定所需的數據,並以結構化格式(例如 JSON 或 XML)接收抓取的數據。

優點

Web 抓取 API 簡化了抓取過程,使開發人員能夠專注於集成 API 和處理數據。 由於提供商的維護,它們提供可靠性和性能,並且可能包括身份驗證和速率限制等功能。 API 還有助於遵守服務條款和法律要求。

缺點

使用網頁抓取 API 有局限性。 數據可用性和功能取決於 API 提供商,可能對支持的網站和抓取限制有限制。 外部 API 依賴引入了對提供商可用性和性能的依賴,從而影響數據檢索。 此外,可能存在與大批量或商業用途相關的成本。

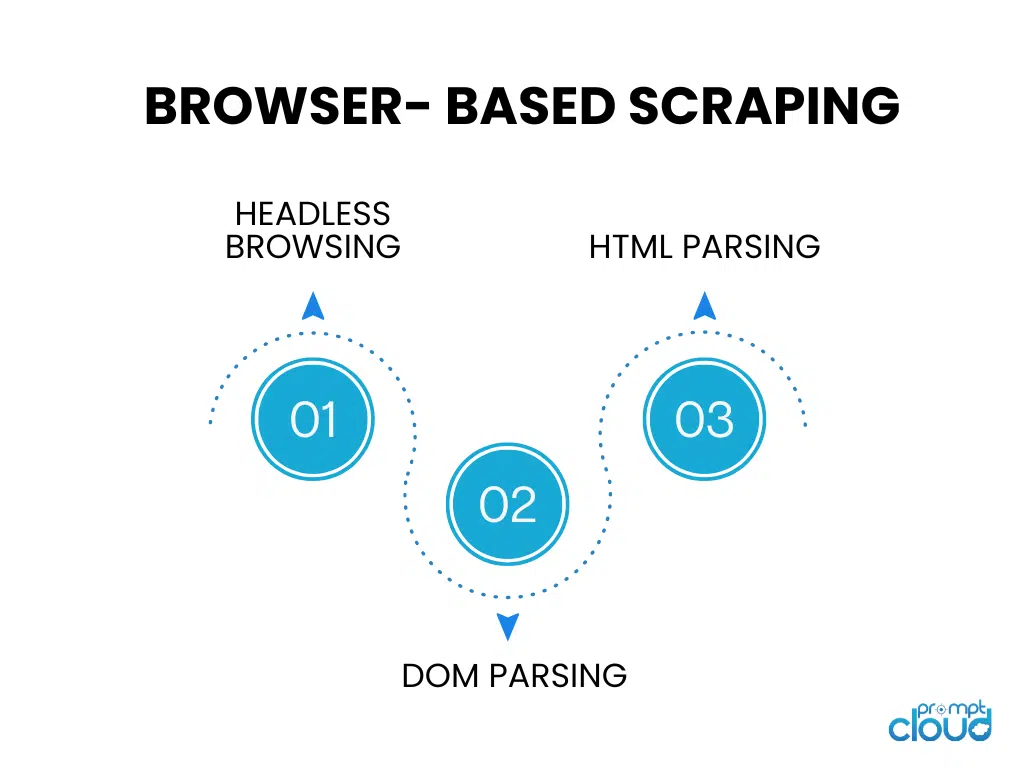

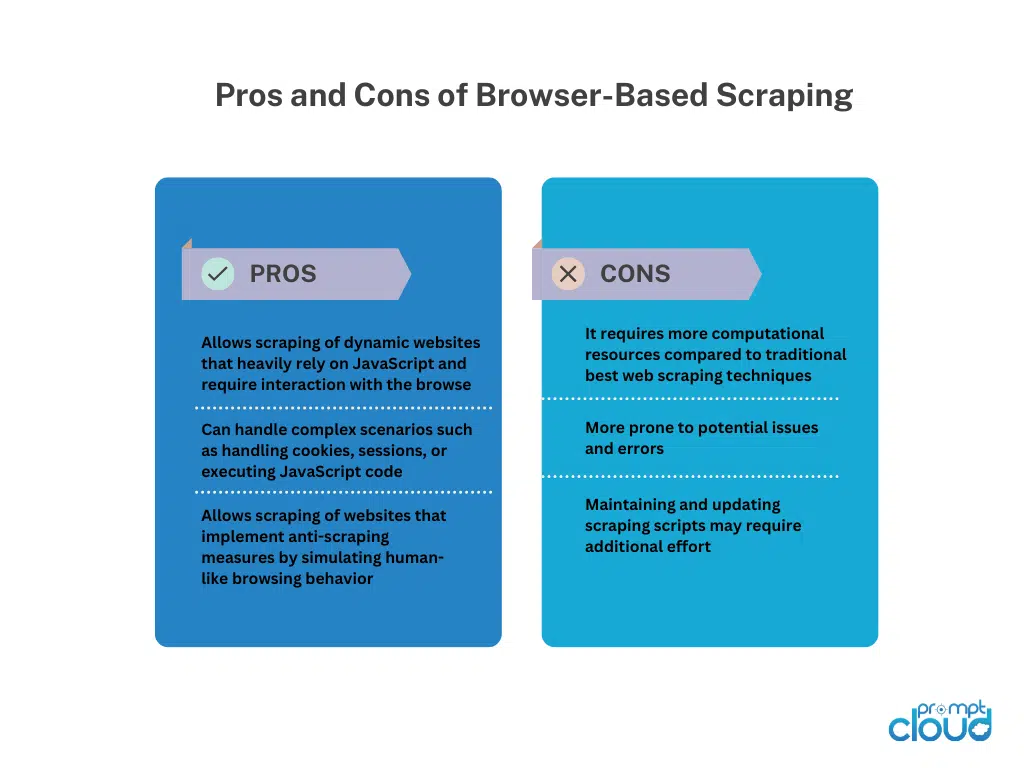

基於瀏覽器的抓取

無頭瀏覽

無頭瀏覽運行沒有圖形用戶界面的網絡瀏覽器,允許使用代碼自動瀏覽網站並與之交互。 它非常適合抓取嚴重依賴客戶端渲染的動態網站。

DOM解析

DOM 解析涉及通過訪問文檔對像模型來操作網頁的 HTML 結構。 這使得能夠以編程方式有針對性地提取元素、屬性或文本。

HTML解析

HTML解析分析網頁的HTML源代碼以提取所需的數據。 它使用庫或解析器來解釋 HTML 結構並識別特定的標籤、屬性或數據提取模式。 HTML 解析通常用於在不執行 JavaScript 的情況下抓取靜態網頁。

手動網頁抓取技術

手動網頁抓取技術

手動網絡抓取是指在不使用自動化工具或腳本的情況下手動從網站提取數據的過程。 它涉及人工干預來瀏覽網站、搜索相關信息以及使用各種技術提取數據。

手動網頁抓取技術:

屏幕捕獲:此技術涉及捕獲網頁的屏幕截圖或視頻,以提取難以以編程方式解析的視覺數據,例如圖像、圖表或表格。從捕獲的媒體中手動提取可以進行數據檢索。

數據輸入:在數據輸入中,需要從網頁手動複製所需信息,並將其輸入到所需的格式(例如電子表格或數據庫)中。它涉及瀏覽網頁、選擇數據並將其輸入目標目的地。 數據輸入適用於易於復制和粘貼的結構化數據。

手動網頁抓取在處理複雜網站、JavaScript 交互性或反抓取措施時提供了靈活性。 然而,它非常耗時,不太適合大規模任務,並且容易出現人為錯誤。 它需要人力、對細節的關注和仔細的執行。

混合網絡抓取技術

混合網絡抓取結合了自動化工具和手動干預,可以從網站中高效、準確地提取數據。 自動化工具處理重複性任務,例如導航和結構化數據提取,而手動技術(例如屏幕捕獲或數據輸入)則處理複雜的場景和視覺/非結構化數據。

混合網頁抓取提供了自動化的可擴展性和速度,以及人類判斷的靈活性。 它適合具有不同結構、動態內容或反抓取措施的網站。 選擇取決於網站的複雜性、數據類型和可用資源,為全面的數據提取提供平衡的方法。