Tecniche di web scraping 2023: una guida completa

Pubblicato: 2023-07-06Nel vasto mondo della caccia al tesoro online, il web scraping è diventato lo strumento definitivo per estrarre preziose gemme di informazioni. Che tu sia un avventuriero solitario o un'impresa affamata di dati, il web scraping è il fidato piccone nel tuo toolkit digitale.

Tuttavia, non tutte le tecniche di web scraping sono uguali. È come scegliere la canna da pesca perfetta per il compito da svolgere. Dopotutto, non porteresti un minuscolo amo per catturare una creatura colossale come Moby Dick, giusto? In questo blog, sveleremo i segreti dietro le tecniche manuali, automatizzate e avanzate di web scraping.

Immagina di assemblare una squadra di supereroi, ognuno con i propri poteri e punti deboli speciali. Allo stesso modo, ogni approccio di scraping ha i suoi punti di forza e i suoi limiti.

Ma non dimentichiamo l'importanza delle azioni responsabili nel web scraping. Proprio come un cavaliere non infrangerebbe mai il proprio giuramento, è fondamentale effettuare lo scraping in modo etico e rispettare i termini di servizio dei siti web che si desidera effettuare.

Tecniche automatizzate di web scraping

Il web scraping automatizzato si riferisce al processo di utilizzo di software o strumenti per estrarre automaticamente i dati dai siti web. Questo approccio automatizzato elimina la necessità di copiare e incollare manualmente i dati, consentendo una raccolta di dati efficiente e su larga scala da varie fonti online.

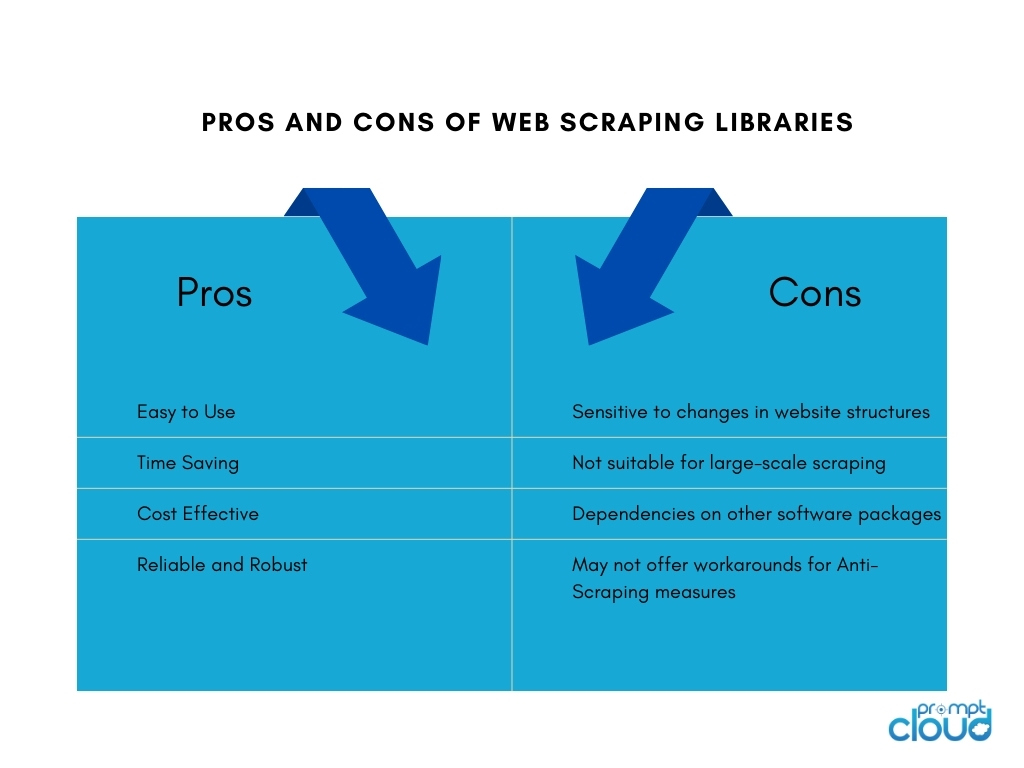

1. Librerie di web scraping

Le librerie di web scraping sono strumenti o framework software che forniscono funzioni e utilità predefinite per facilitare le attività di web scraping. Offrono un modo semplificato ed efficiente per eseguire il web scraping senza la necessità di scrivere tutto da zero. Risparmiano tempo, aumentano la produttività e consentono una raccolta di dati più efficiente da diverse fonti online.

Alcune delle popolari librerie di web scraping includono:

- BeautifulSoup: una libreria Python ampiamente utilizzata per il web scraping che fornisce un'API intuitiva per analizzare documenti HTML e XML, consentendo agli utenti di navigare ed estrarre i dati senza sforzo.

- Scrapy: un potente framework Python per il web scraping che fornisce un set completo di strumenti per la creazione di web crawler scalabili ed efficienti, con funzionalità come la limitazione automatica delle richieste, pipeline di elementi e supporto integrato per la gestione dell'impaginazione.

- Selenium: una libreria versatile che consente interazioni automatiche del browser per il web scraping, particolarmente utile quando si ha a che fare con contenuti dinamici e siti web con JavaScript pesante.

- Puppeteer: una libreria Node.js che fornisce un'API di alto livello per controllare un browser Chrome o Chromium headless, consentendo il web scraping e l'interazione con le pagine web tramite JavaScript.

2. Strumenti e servizi di web scraping

Strumenti di web scraping

Gli strumenti di web scraping sono applicazioni software o piattaforme progettate specificamente per automatizzare e semplificare il processo di web scraping. Questi strumenti spesso forniscono un'interfaccia intuitiva che consente agli utenti di specificare i dati che desiderano estrarre dai siti Web senza richiedere una conoscenza approfondita della programmazione.

In genere offrono funzionalità come la selezione point-and-click di elementi di dati, funzionalità di pianificazione e monitoraggio e opzioni di esportazione dei dati. Gli strumenti di web scraping possono essere utili per individui o aziende che richiedono l'estrazione dei dati senza la necessità di risorse di codifica o sviluppo estese.

Creazione di strumenti di web scraping interni

Costruire uno strumento di web scraping interno per un'azienda ha i suoi pro e contro:

Servizi di web scraping

I fornitori di servizi di web scraping offrono servizi specializzati per l'estrazione di dati dai siti web. Questi fornitori in genere dispongono di infrastrutture, strumenti e competenze dedicati alla gestione delle attività di web scraping per conto dei clienti.

Ecco i pro e i contro dell'utilizzo dei fornitori di servizi di web scraping:

API di web scraping

Le API di web scraping forniscono un'interfaccia programmatica che consente agli sviluppatori di accedere e recuperare i dati dai siti Web utilizzando metodi standardizzati. Queste API offrono un approccio più strutturato e controllato al web scraping rispetto alle tradizionali tecniche di scraping. Gli sviluppatori possono inviare richieste all'API, specificando i dati di cui hanno bisogno e ricevendo i dati raccolti in un formato strutturato, come JSON o XML.

Professionisti

Le API di web scraping semplificano il processo di scraping, consentendo agli sviluppatori di concentrarsi sull'integrazione dell'API e sulla gestione dei dati. Offrono affidabilità e prestazioni grazie alla manutenzione del provider e possono includere funzionalità come l'autenticazione e la limitazione della velocità. Le API aiutano anche a rispettare i termini di servizio e i requisiti legali.

Contro

L'utilizzo delle API di web scraping ha dei limiti. La disponibilità e le capacità dei dati dipendono dal provider API, con possibili restrizioni sui siti Web supportati e limiti di scraping. La dipendenza da API esterne introduce la dipendenza dalla disponibilità e dalle prestazioni del provider, con un impatto sul recupero dei dati. Inoltre, potrebbero esserci costi associati a volumi elevati o all'utilizzo commerciale.

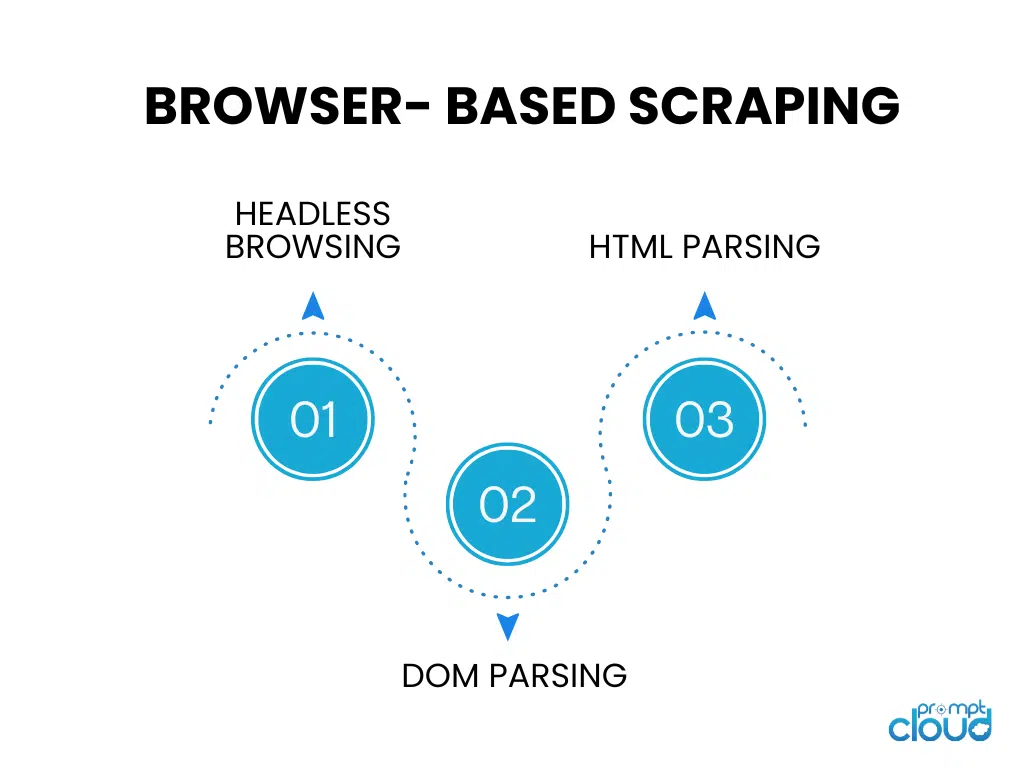

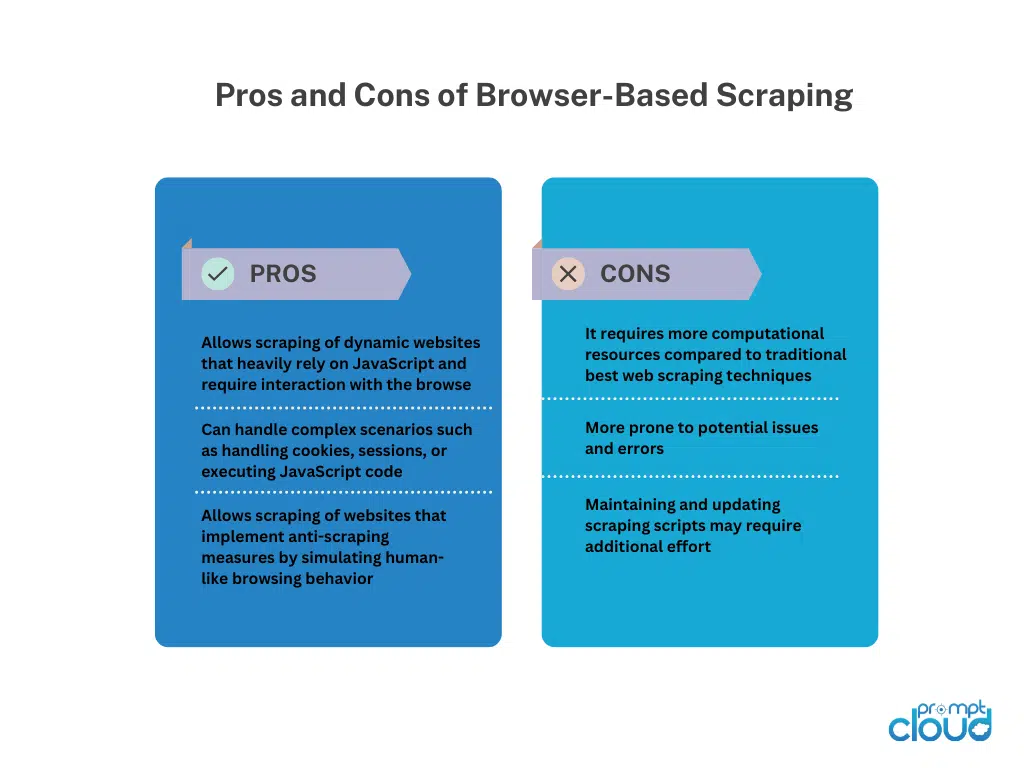

Scraping basato su browser

Navigazione senza testa

La navigazione senza testa esegue un browser Web senza un'interfaccia utente grafica, consentendo la navigazione automatizzata e l'interazione con i siti Web utilizzando il codice. È ideale per lo scraping di siti Web dinamici che si basano fortemente sul rendering lato client.

Analisi DOM

L'analisi del DOM comporta la manipolazione della struttura HTML di una pagina Web accedendo al suo Document Object Model. Ciò consente l'estrazione mirata di elementi, attributi o testo a livello di codice.

Analisi HTML

L'analisi HTML analizza il codice sorgente HTML di una pagina Web per estrarre i dati desiderati. Utilizza librerie o parser per interpretare la struttura HTML e identificare tag, attributi o modelli specifici per l'estrazione dei dati. L'analisi HTML viene comunemente utilizzata per eseguire lo scraping di pagine Web statiche senza l'esecuzione di JavaScript.

Tecniche manuali di web scraping

Tecniche manuali di web scraping

Il web scraping manuale si riferisce al processo di estrazione manuale dei dati dai siti Web, senza l'uso di strumenti o script automatizzati. Implica l'intervento umano per navigare nei siti Web, cercare informazioni pertinenti ed estrarre dati utilizzando varie tecniche.

Tecniche per il web scraping manuale:

Screen Capturing: questa tecnica prevede l'acquisizione di schermate o video di pagine Web per estrarre dati visivi come immagini, grafici o tabelle difficili da analizzare a livello di codice.L'estrazione manuale dal supporto acquisito consente il recupero dei dati.

Inserimento dati: nell'inserimento dati, le informazioni richieste vengono copiate manualmente dalle pagine Web e inserite in un formato desiderato come fogli di calcolo o database.Implica la navigazione di pagine Web, la selezione dei dati e l'inserimento nella destinazione di destinazione. L'inserimento dati è adatto per dati strutturati che possono essere facilmente copiati e incollati.

Il web scraping manuale offre flessibilità quando si ha a che fare con siti web complessi, interattività JavaScript o misure anti-scraping. Tuttavia, è dispendioso in termini di tempo, meno adatto per attività su larga scala e soggetto a errori umani. Richiede sforzo umano, attenzione ai dettagli e un'attenta esecuzione.

Tecniche di web scraping ibrido

Il web scraping ibrido combina strumenti automatizzati e intervento manuale per un'estrazione dei dati efficiente e accurata dai siti web. Gli strumenti automatizzati gestiscono attività ripetitive come la navigazione e l'estrazione di dati strutturati, mentre le tecniche manuali, come l'acquisizione di schermate o l'immissione di dati, affrontano scenari complessi e dati visivi/non strutturati.

Hybrid Web Scraping offre scalabilità e velocità di automazione, insieme alla flessibilità del giudizio umano. Si adatta a siti Web con strutture diverse, contenuti dinamici o misure anti-scraping. La scelta dipende dalla complessità del sito Web, dal tipo di dati e dalle risorse disponibili, fornendo un approccio equilibrato per l'estrazione completa dei dati.