Técnicas de raspagem da Web 2023 - um guia completo

Publicados: 2023-07-06No vasto mundo da caça ao tesouro online, o web scraping tornou-se a melhor ferramenta para extrair informações valiosas. Seja você um aventureiro solitário ou uma empresa sedenta por dados, a raspagem da web é a picareta confiável em seu kit de ferramentas digital.

No entanto, nem todas as técnicas de raspagem da web são criadas iguais. É como escolher a vara de pescar perfeita para a tarefa em questão. Afinal, você não traria um pequeno anzol para pegar uma criatura colossal como Moby Dick, certo? Neste blog, vamos desvendar os segredos por trás das técnicas manuais, automatizadas e avançadas de web scraping.

Imagine montar uma equipe de super-heróis, cada um com seus próprios poderes e fraquezas especiais. Da mesma forma, cada abordagem de raspagem tem seus pontos fortes e limitações.

Mas não vamos esquecer a importância de ações responsáveis no web scraping. Assim como um cavaleiro nunca quebraria seu juramento, é crucial raspar eticamente e respeitar os termos de serviço dos sites que você deseja raspar.

Técnicas de Web Scraping Automatizadas

A raspagem automatizada da web refere-se ao processo de uso de software ou ferramentas para extrair dados automaticamente de sites. Essa abordagem automatizada elimina a necessidade de copiar e colar manualmente os dados, permitindo uma coleta de dados eficiente e em larga escala de várias fontes online.

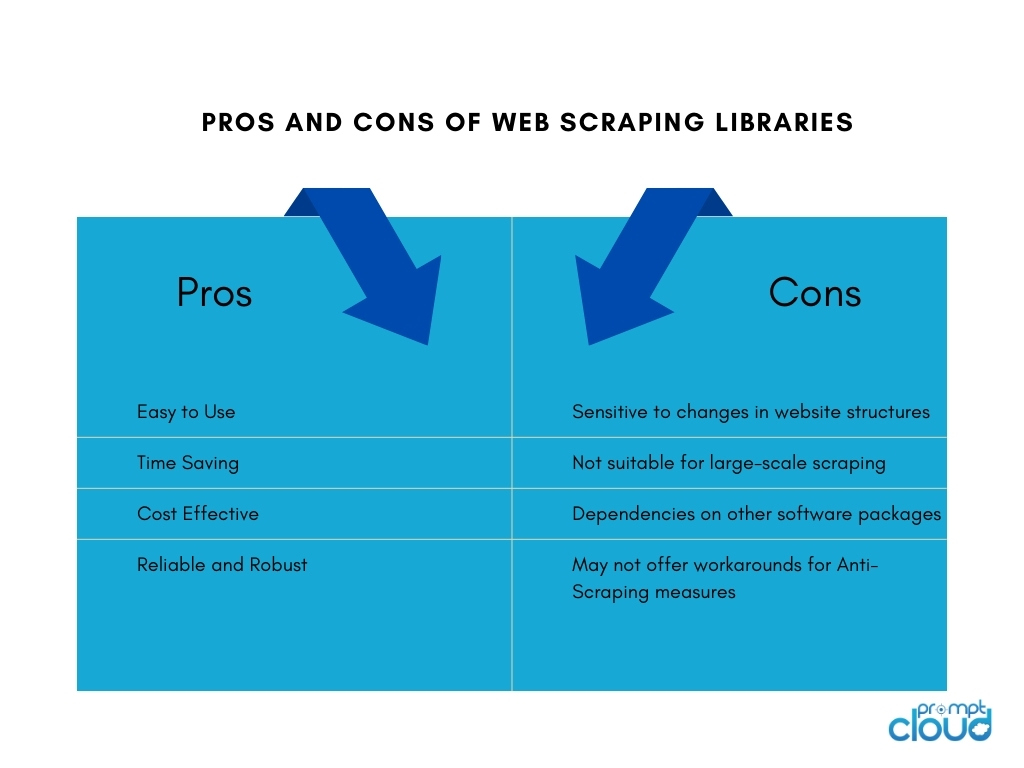

1. Bibliotecas de raspagem da Web

As bibliotecas de raspagem da Web são ferramentas de software ou estruturas que fornecem funções e utilitários pré-criados para facilitar as tarefas de raspagem da web. Eles oferecem uma maneira simplificada e eficiente de executar a raspagem da web sem a necessidade de escrever tudo do zero. Eles economizam tempo, aumentam a produtividade e permitem uma coleta de dados mais eficiente de diversas fontes online.

Algumas das bibliotecas populares de raspagem da web incluem:

- BeautifulSoup: uma biblioteca Python amplamente usada para web scraping que fornece uma API intuitiva para analisar documentos HTML e XML, permitindo que os usuários naveguem e extraiam dados sem esforço.

- Scrapy: Uma poderosa estrutura Python para web scraping que fornece um conjunto abrangente de ferramentas para criar rastreadores da Web escaláveis e eficientes, com recursos como limitação automática de solicitações, pipelines de itens e suporte integrado para manipulação de paginação.

- Selenium: Uma biblioteca versátil que permite interações automatizadas do navegador para web scraping, particularmente útil ao lidar com conteúdo dinâmico e sites pesados em JavaScript.

- Puppeteer: uma biblioteca Node.js que fornece uma API de alto nível para controlar um navegador sem cabeça Chrome ou Chromium, permitindo a extração da web e a interação com páginas da web usando JavaScript.

2. Ferramentas e serviços de raspagem da Web

Ferramentas de raspagem da Web

As ferramentas de raspagem da Web são aplicativos de software ou plataformas projetadas especificamente para automatizar e simplificar o processo de raspagem da web. Essas ferramentas geralmente fornecem uma interface amigável que permite aos usuários especificar os dados que desejam extrair de sites sem a necessidade de amplo conhecimento de programação.

Eles normalmente oferecem recursos como seleção de elementos de dados de apontar e clicar, recursos de agendamento e monitoramento e opções de exportação de dados. As ferramentas de raspagem da Web podem ser benéficas para indivíduos ou empresas que exigem extração de dados sem a necessidade de codificação extensiva ou recursos de desenvolvimento.

Construindo ferramentas internas de raspagem da Web

Construir uma ferramenta interna de web scraping para uma empresa tem seus prós e contras:

serviços de raspagem da web

Os provedores de serviços de raspagem da Web oferecem serviços especializados para extração de dados de sites. Esses provedores geralmente possuem infraestrutura, ferramentas e experiência dedicada a lidar com tarefas de raspagem da Web em nome dos clientes.

Aqui estão os prós e os contras do uso de provedores de serviços de web scraping:

APIs de raspagem da Web

As APIs de raspagem da Web fornecem uma interface programática que permite aos desenvolvedores acessar e recuperar dados de sites usando métodos padronizados. Essas APIs oferecem uma abordagem mais estruturada e controlada para web scraping em comparação com as técnicas tradicionais de scraping. Os desenvolvedores podem enviar solicitações para a API, especificando os dados de que precisam e recebendo os dados extraídos em um formato estruturado, como JSON ou XML.

Prós

As APIs de raspagem da Web simplificam o processo de raspagem, permitindo que os desenvolvedores se concentrem na integração da API e no manuseio dos dados. Eles oferecem confiabilidade e desempenho devido à manutenção do provedor e podem incluir recursos como autenticação e limitação de taxa. As APIs também auxiliam na conformidade com os termos de serviço e requisitos legais.

Contras

O uso de APIs de web scraping tem limitações. A disponibilidade e os recursos dos dados dependem do provedor de API, com possíveis restrições em sites com suporte e limites de extração. A dependência da API externa introduz dependência na disponibilidade e no desempenho do provedor, impactando a recuperação de dados. Além disso, pode haver custos associados ao uso comercial ou de alto volume.

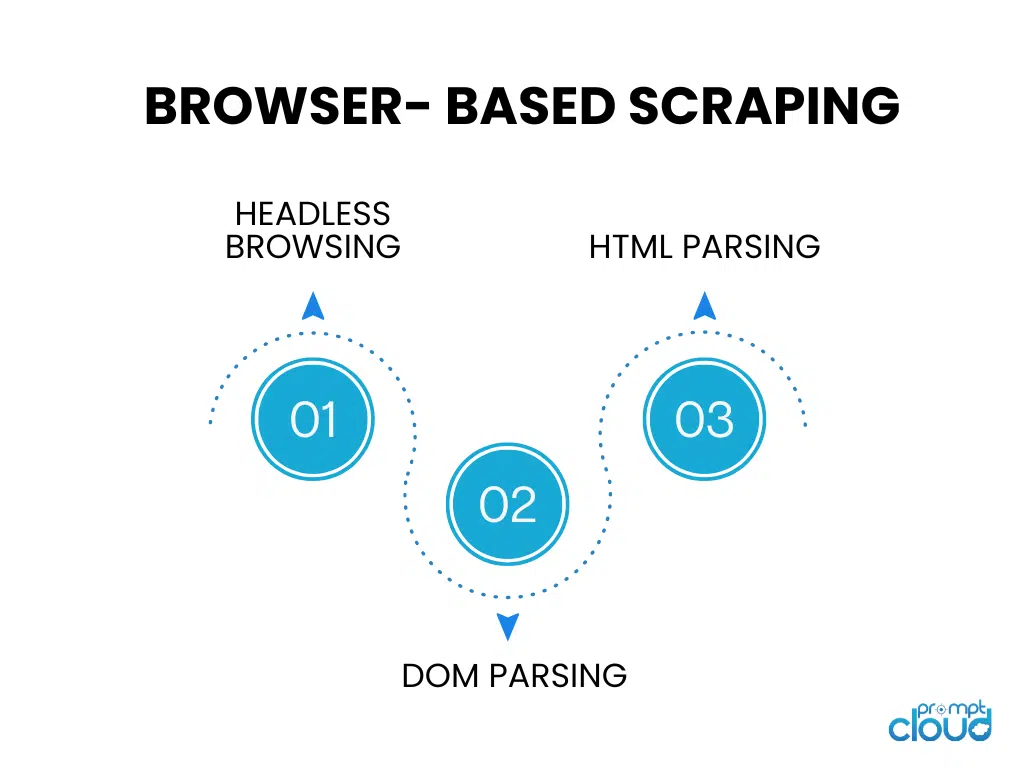

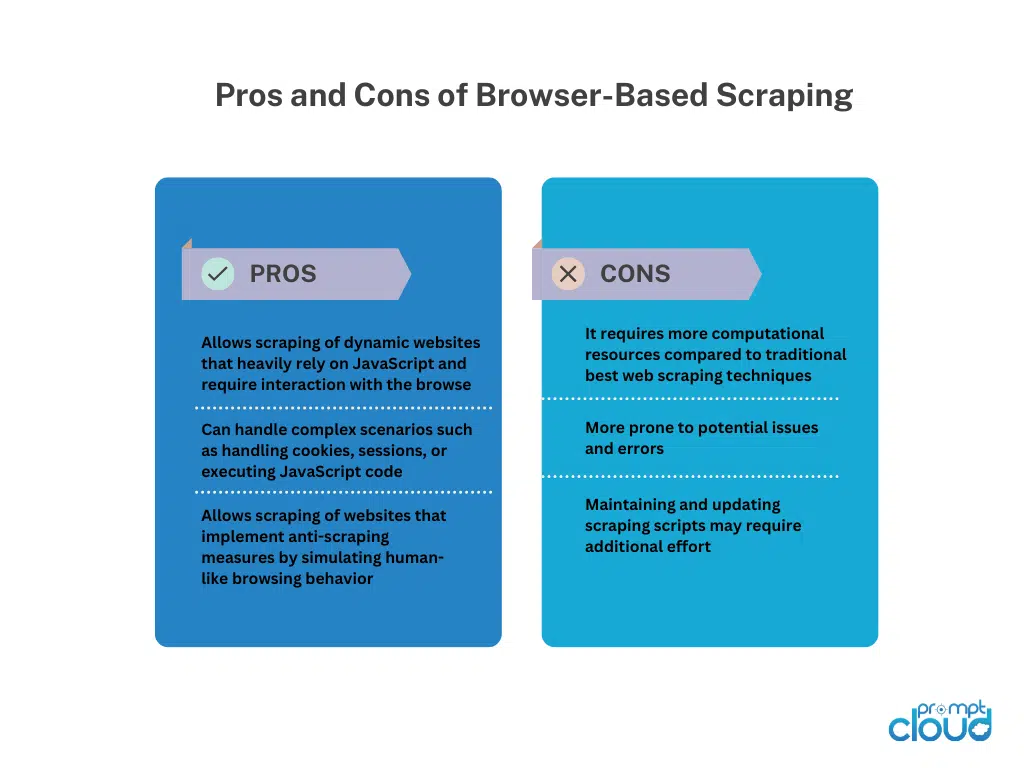

Raspagem baseada em navegador

Navegação sem cabeça

A navegação sem cabeça executa um navegador da Web sem uma interface gráfica do usuário, permitindo navegação automatizada e interação com sites usando código. É ideal para raspar sites dinâmicos que dependem muito da renderização do lado do cliente.

Análise de DOM

A análise DOM envolve a manipulação da estrutura HTML de uma página da Web acessando seu Document Object Model. Isso permite a extração direcionada de elementos, atributos ou texto programaticamente.

Análise de HTML

A análise de HTML analisa o código-fonte HTML de uma página da Web para extrair os dados desejados. Ele usa bibliotecas ou analisadores para interpretar a estrutura HTML e identificar tags, atributos ou padrões específicos para extração de dados. A análise de HTML é comumente usada para extrair páginas da Web estáticas sem execução de JavaScript.

Técnicas manuais de Web Scraping

Técnicas manuais de Web Scraping

A raspagem manual da web refere-se ao processo de extração manual de dados de sites, sem o uso de ferramentas ou scripts automatizados. Envolve intervenção humana para navegar em sites, pesquisar informações relevantes e extrair dados usando várias técnicas.

Técnicas para Web Scraping manual:

Captura de tela: essa técnica envolve a captura de capturas de tela ou vídeos de páginas da Web para extrair dados visuais como imagens, gráficos ou tabelas que são difíceis de analisar programaticamente.A extração manual da mídia capturada permite a recuperação de dados.

Entrada de dados: Na entrada de dados, as informações necessárias são copiadas manualmente de páginas da Web e inseridas em um formato desejado, como planilhas ou bancos de dados.Envolve navegar em páginas da web, selecionar dados e inseri-los no destino de destino. A entrada de dados é adequada para dados estruturados que podem ser facilmente copiados e colados.

A raspagem manual da web oferece flexibilidade ao lidar com sites complexos, interatividade de JavaScript ou medidas anti-raspagem. No entanto, é demorado, menos adequado para tarefas de grande escala e propenso a erros humanos. Requer esforço humano, atenção aos detalhes e execução cuidadosa.

Técnicas de Web Scraping Híbridas

A raspagem híbrida da web combina ferramentas automatizadas e intervenção manual para extração de dados eficiente e precisa de sites. Ferramentas automatizadas lidam com tarefas repetitivas, como navegação e extração de dados estruturados, enquanto técnicas manuais, como captura de tela ou entrada de dados, abordam cenários complexos e dados visuais/não estruturados.

O Hybrid Web Scraping oferece escalabilidade e velocidade de automação, juntamente com a flexibilidade do julgamento humano. Adequa-se a sites com diversas estruturas, conteúdo dinâmico ou medidas anti-raspagem. A escolha depende da complexidade do site, tipo de dados e recursos disponíveis, fornecendo uma abordagem equilibrada para extração de dados abrangente.