Técnicas de raspado web 2023: una guía completa

Publicado: 2023-07-06En el vasto mundo de la búsqueda de tesoros en línea, el web scraping se ha convertido en la herramienta definitiva para extraer valiosas gemas de información. Ya sea que sea un aventurero solitario o una empresa ávida de datos, el web scraping es el pico de confianza en su conjunto de herramientas digitales.

Sin embargo, no todas las técnicas de web scraping son iguales. Es como elegir la caña de pescar perfecta para la tarea en cuestión. Después de todo, no traerías un pequeño anzuelo para atrapar a una criatura colosal como Moby Dick, ¿verdad? En este blog, desvelaremos los secretos detrás de las técnicas de web scraping manuales, automatizadas y avanzadas.

Solo imagina reunir un equipo de superhéroes, cada uno con sus propios poderes y debilidades especiales. Asimismo, cada enfoque de scraping tiene sus puntos fuertes y sus limitaciones.

Pero no olvidemos la importancia de las acciones responsables en el web scraping. Así como un caballero nunca rompería su juramento, es crucial raspar éticamente y respetar los términos de servicio de los sitios web que desea raspar.

Técnicas automatizadas de web scraping

El raspado web automatizado se refiere al proceso de usar software o herramientas para extraer automáticamente datos de sitios web. Este enfoque automatizado elimina la necesidad de copiar y pegar manualmente los datos, lo que permite una recopilación de datos eficiente y a gran escala de varias fuentes en línea.

1. Bibliotecas web scraping

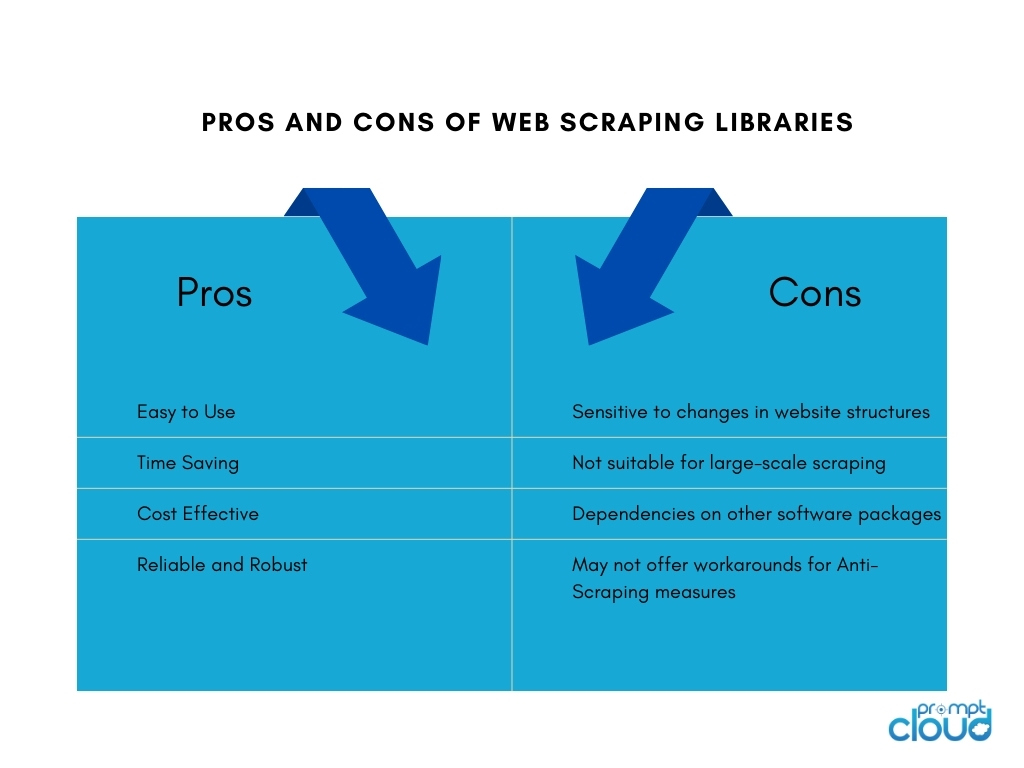

Las bibliotecas de web scraping son herramientas de software o marcos que proporcionan funciones y utilidades preconstruidas para facilitar las tareas de web scraping. Ofrecen una forma simplificada y eficiente de realizar web scraping sin necesidad de escribir todo desde cero. Ahorran tiempo, aumentan la productividad y permiten una recopilación de datos más eficiente de diversas fuentes en línea.

Algunas de las bibliotecas populares de web scraping incluyen:

- BeautifulSoup: una biblioteca de Python ampliamente utilizada para web scraping que proporciona una API intuitiva para analizar documentos HTML y XML, lo que permite a los usuarios navegar y extraer datos sin esfuerzo.

- Scrapy: un potente marco de trabajo de Python para el web scraping que proporciona un conjunto completo de herramientas para crear rastreadores web escalables y eficientes, con funciones como la limitación automática de solicitudes, canalizaciones de artículos y soporte integrado para gestionar la paginación.

- Selenium: una biblioteca versátil que permite interacciones automatizadas del navegador para el web scraping, particularmente útil cuando se trata de contenido dinámico y sitios web con mucho JavaScript.

- Puppeteer: una biblioteca de Node.js que proporciona una API de alto nivel para controlar un navegador Chrome o Chromium sin interfaz gráfica, lo que permite el web scraping y la interacción con páginas web mediante JavaScript.

2. Herramientas y servicios de web scraping

Herramientas de web scraping

Las herramientas de web scraping son aplicaciones o plataformas de software diseñadas específicamente para automatizar y simplificar el proceso de web scraping. Estas herramientas suelen proporcionar una interfaz fácil de usar que permite a los usuarios especificar los datos que desean extraer de los sitios web sin necesidad de tener amplios conocimientos de programación.

Por lo general, ofrecen funciones como la selección de elementos de datos con solo apuntar y hacer clic, capacidades de programación y monitoreo, y opciones de exportación de datos. Las herramientas de raspado web pueden ser beneficiosas para las personas o empresas que requieren la extracción de datos sin necesidad de recursos extensos de codificación o desarrollo.

Creación de herramientas internas de web scraping

Construir una herramienta interna de web scraping para una empresa tiene sus pros y sus contras:

Servicios de web scraping

Los proveedores de servicios de web scraping ofrecen servicios especializados para la extracción de datos de sitios web. Estos proveedores suelen tener infraestructura, herramientas y experiencia dedicadas a manejar tareas de web scraping en nombre de los clientes.

Estos son los pros y los contras de usar proveedores de servicios de web scraping:

API de web scraping

Las API de raspado web proporcionan una interfaz programática que permite a los desarrolladores acceder y recuperar datos de sitios web utilizando métodos estandarizados. Estas API ofrecen un enfoque más estructurado y controlado para el web scraping en comparación con las técnicas de scraping tradicionales. Los desarrolladores pueden enviar solicitudes a la API, especificar los datos que necesitan y recibir los datos extraídos en un formato estructurado, como JSON o XML.

ventajas

Las API de raspado web simplifican el proceso de raspado, lo que permite a los desarrolladores concentrarse en integrar la API y manejar los datos. Ofrecen confiabilidad y rendimiento debido al mantenimiento del proveedor y pueden incluir funciones como autenticación y limitación de velocidad. Las API también ayudan a cumplir con los términos de servicio y los requisitos legales.

Contras

El uso de API de web scraping tiene limitaciones. La disponibilidad y las capacidades de los datos dependen del proveedor de API, con posibles restricciones en los sitios web admitidos y límites de raspado. La dependencia de la API externa introduce la dependencia de la disponibilidad y el rendimiento del proveedor, lo que afecta la recuperación de datos. Además, puede haber costos asociados con el uso comercial o de gran volumen.

Scraping basado en navegador

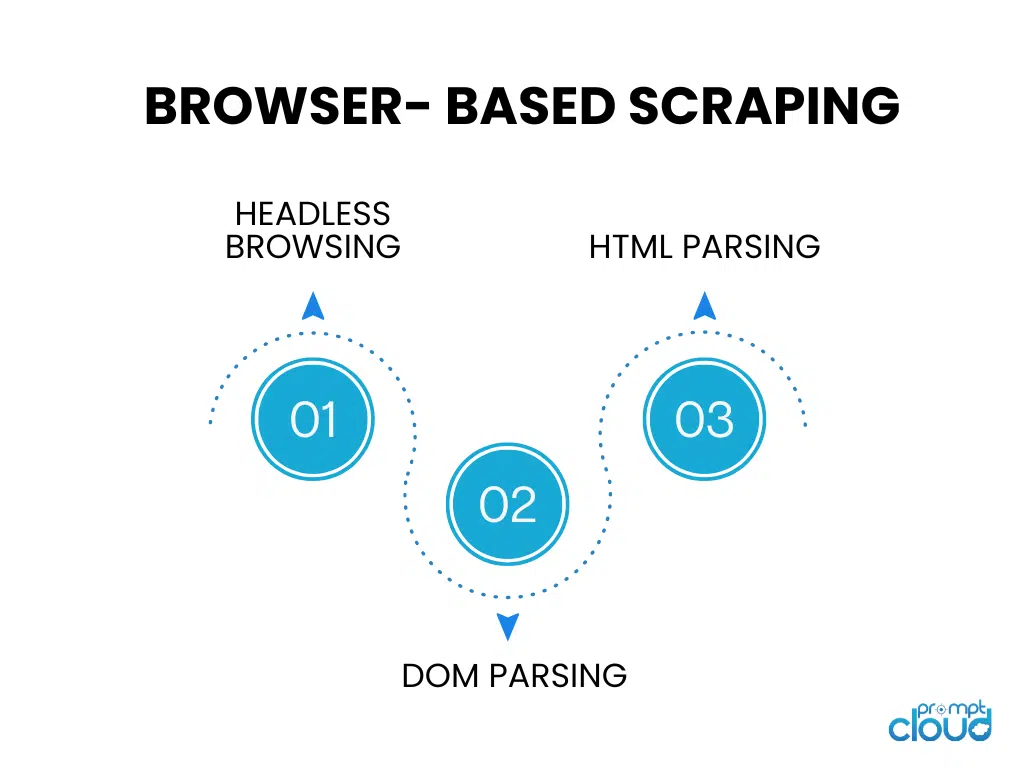

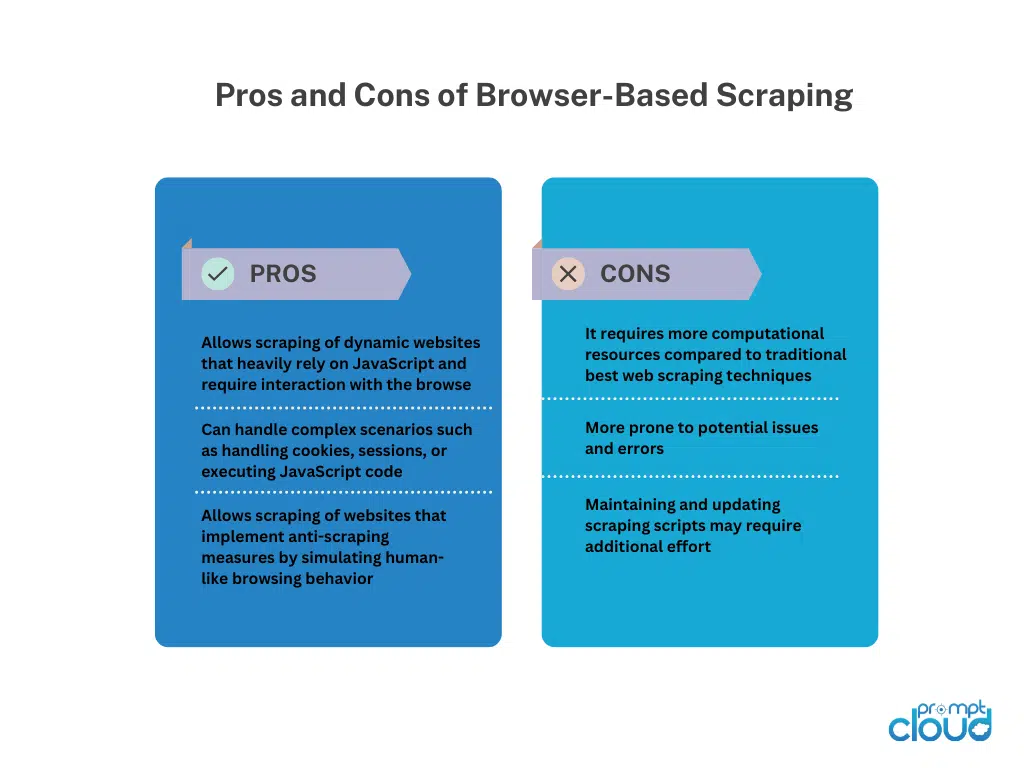

Navegación sin cabeza

La navegación sin cabeza ejecuta un navegador web sin una interfaz gráfica de usuario, lo que permite la navegación automatizada y la interacción con sitios web mediante código. Es ideal para raspar sitios web dinámicos que dependen en gran medida de la representación del lado del cliente.

Análisis de DOM

El análisis DOM implica manipular la estructura HTML de una página web accediendo a su modelo de objeto de documento. Esto permite la extracción dirigida de elementos, atributos o texto mediante programación.

Análisis de HTML

El análisis de HTML analiza el código fuente HTML de una página web para extraer los datos deseados. Utiliza bibliotecas o analizadores para interpretar la estructura HTML e identificar etiquetas, atributos o patrones específicos para la extracción de datos. El análisis de HTML se usa comúnmente para raspar páginas web estáticas sin la ejecución de JavaScript.

Técnicas manuales de web scraping

Técnicas manuales de web scraping

El web scraping manual se refiere al proceso de extracción manual de datos de sitios web, sin el uso de herramientas o scripts automatizados. Implica la intervención humana para navegar por sitios web, buscar información relevante y extraer datos utilizando diversas técnicas.

Técnicas para Web Scraping Manual:

Captura de pantalla: esta técnica consiste en capturar capturas de pantalla o videos de páginas web para extraer datos visuales como imágenes, gráficos o tablas que son difíciles de analizar mediante programación.La extracción manual de los medios capturados permite la recuperación de datos.

Entrada de datos: en la entrada de datos, la información requerida se copia manualmente de las páginas web y se ingresa en el formato deseado, como hojas de cálculo o bases de datos.Implica navegar por páginas web, seleccionar datos e ingresarlos en el destino de destino. La entrada de datos es adecuada para datos estructurados que se pueden copiar y pegar fácilmente.

El web scraping manual ofrece flexibilidad cuando se trata de sitios web complejos, interactividad de JavaScript o medidas anti-scraping. Sin embargo, requiere mucho tiempo, es menos adecuado para tareas a gran escala y es propenso a errores humanos. Requiere esfuerzo humano, atención a los detalles y una ejecución cuidadosa.

Técnicas híbridas de web scraping

El web scraping híbrido combina herramientas automatizadas e intervención manual para una extracción de datos eficiente y precisa de los sitios web. Las herramientas automatizadas manejan tareas repetitivas como la navegación y la extracción de datos estructurados, mientras que las técnicas manuales, como la captura de pantalla o el ingreso de datos, abordan escenarios complejos y datos visuales/no estructurados.

Hybrid Web Scraping ofrece escalabilidad y velocidad de automatización, junto con la flexibilidad del juicio humano. Se adapta a sitios web con diversas estructuras, contenido dinámico o medidas anti-raspado. La elección depende de la complejidad del sitio web, el tipo de datos y los recursos disponibles, lo que proporciona un enfoque equilibrado para la extracción completa de datos.