Przyszłość web scrapingu w ustrukturyzowanej sieci — PromptCloud

Opublikowany: 2019-03-14Techniki SEO ewoluowały z biegiem czasu, a linki zwrotne i metatagi nie są już jedynymi rzeczami, które pomagają firmom generować lepszy ruch organiczny. Choć wszyscy wiedzą, że Google rankinguje strony internetowe na podstawie wielu czynników, używając skomplikowanych algorytmów, nie są znane wszystkie parametry, które liczą się w rankingach SEO. Jednak potrzeba ustrukturyzowanych danych do celów SEO jest powszechnie akceptowana i można znaleźć w sieci wiele blogów na ten temat. Ta strona Google faktycznie wyjaśnia, w jaki sposób Google stara się lepiej zrozumieć Twoją stronę internetową, korzystając ze wszystkich uporządkowanych danych, które są dostępne do przeanalizowania. Posiadając uporządkowane dane w swojej witrynie, pozostawiasz Google więcej wskazówek, aby zrozumieć swoją witrynę i odpowiednio ją uszeregować. W rzeczywistości Google przedstawił również przykłady tego, jak dane Twojej witryny powinny wyglądać w backendzie. Ponieważ Google jest największą wyszukiwarką na świecie (z wyjątkiem Baidu w Chinach), można śmiało powiedzieć, że stosowanie tego formatu uporządkowanych danych byłoby korzystne dla wszystkich witryn w celu uzyskania lepszej widoczności. I właśnie dlatego strony internetowe szybko zmieniają formaty danych na swoich stronach, co przyniesie korzyści zarówno rankingom SEO, jak i web scraperom.

Uporządkowane dane są korzystne dla wszystkich. Nawet witryny, które chcą skalować w górę, skorzystałyby na ustrukturyzowanych danych, ponieważ miałyby już podstawowy układ danych do naśladowania, a operacje w ich zapleczu byłyby szybsze, co prowadziłoby do mniejszych opóźnień i lepszej obsługi klienta.

Różnica, jaką dają dane strukturalne

Tak więc do tej pory mówiłem o danych strukturalnych i o tym, jak praktyki SEO zmuszają strony internetowe, aby się do nich przestawiły. Ale jaka jest różnica między ustrukturyzowanymi i nieustrukturyzowanymi danymi i dlaczego łatwiej jest analizować ustrukturyzowane dane, czy to do rankingu SEO, czy do web scrapingu?

Wyjaśnijmy to na przykładzie. Załóżmy, że prowadzisz witrynę, na której ludzie publikują recenzje restauracji. Ludzie oceniają restauracje, a także publikują komentarze na temat jedzenia, które mieli w różnych restauracjach w Twojej witrynie. Powiedzmy, że masz restaurację pod nazwą „Restauracja z czerwoną cebulą”, a trzy osoby oceniły restaurację, a dwie opublikowały komentarze. Załóżmy, że przechowujesz te dane w formie ciągu-

“Restauracja z czerwoną cebulą | Średnia ocena- 3,5 gwiazdki| 3 | “Dobre jedzenie, zbyt zatłoczone” | “Kluski były świetne.”

Widzisz więc, że jest to pojedynczy ciąg lub jedno zdanie, które Google będzie analizować pod kątem SEO, lub może być skrobanie w celu wyodrębnienia danych. Możesz zrozumieć, że ten ciąg znaków może się różnić w zależności od dodatkowych szczegółów, takich jak lokalizacja i przedział cenowy niektórych restauracji. W takich sytuacjach wyodrębnianie oddzielnych elementów, takich jak średnia ocena i różne komentarze, może okazać się uciążliwe i wymagać dodatkowych obliczeń.

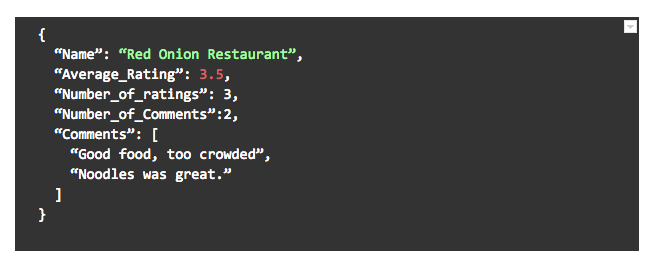

Teraz powiedzmy, że ta sama witryna faktycznie przechowywała te dane w obiekcie JSON w tym formacie-

Wyobraź sobie, jak łatwiej byłoby Google zrozumieć dane i uszeregować witrynę oraz jak proste byłoby dla Ciebie indeksowanie danych. Nawet jeśli istnieją dodatkowe pola dla niektórych restauracji (lub jeśli brakuje niektórych z tych pól), wystarczyłoby sprawdzić dostępne dane. W ten sposób ustrukturyzowane dane są znacznie łatwiejsze do przetworzenia, czy to dla ludzkiego oka, czy dla komputera.

Rozwój web scrapingu wspierany przez uporządkowane dane

Web scraping rozwija się w ogromnym tempie od czasu, gdy ludzie wycinali artykuły prasowe lub kopiowali wklejanie z internetowych blogów. W dzisiejszych czasach większość czynności związanych z web-scrapingiem jest wykonywana przez automatyczne lub półautomatyczne inteligentne boty, które zajmują się większością problemów. W przypadku napotkania problemu lub konieczności przeszkolenia w zakresie indeksowania nowej strony internetowej wymagana jest interwencja człowieka. Jeśli web scraper działa na stronach internetowych, które mają większość danych w ustrukturyzowanym formacie, szanse na błędy lub konieczność ręcznej interwencji są wysoce zminimalizowane, a prędkość, z jaką może działać skrobak, jest również szybsza.

Nic w witrynie nie może pomóc w zbieraniu informacji bardziej niż uporządkowane dane. Często obrazy i filmy są obecne na stronach internetowych, a nawet te mogą być umieszczane w losowych tagach. Zamiast tego posiadanie ich linków jako części danych JSON i przechowywanie ich w innym miejscu znacznie pomogłoby wyszukiwarkom internetowym w rozróżnianiu różnych form danych oraz przeszukiwaniu i przechowywaniu ich oddzielnie i odpowiednio.

Dane strukturalne mogą pozytywnie wpłynąć na skrobanie stron internetowych i odkrywanie informacji

Ważnym czynnikiem, o którym ludzie zapominają, mówiąc o danych, jest czystość danych. Czystość danych jest bardzo ważna, ponieważ brudne dane mogą zmniejszyć wartość samych danych, a nawet uczynić je bezużytecznymi. Dane nieustrukturyzowane mogą prowadzić do brudnych danych, gdy są zbierane, przetwarzane, a nawet przesyłane między witrynami lub stronami internetowymi. Dane strukturalne zmniejszają szanse na zabrudzenie lub zduplikowanie danych, ponieważ stosując jeden format dla każdego nowego wpisu danych, błędy i problemy są oznaczane w samym punkcie wejścia danych.

Web scraping odbywa się w bardzo podobny sposób do tego, jak wyszukiwarki analizują Twoje witryny w celu rankingu, więc nie jest niespodzianką, że interesy obu stron są ze sobą powiązane. Należy jednak zrozumieć podstawową logikę, dlaczego preferowane są dane strukturalne, bez względu na przypadek użycia. Zmiany kodu odbywają się regularnie, a zarówno obliczenia front-end, jak i back-end są podatne na regularne zmiany z powodu aktualizacji produktów, nowych funkcji itp., ale posiadanie standardowego formatu danych znacznie ułatwiłoby życie programistom. Gdy format wejściowy i wyjściowy interfejsu API pozostaje taki sam, bez względu na inne zmiany zachodzące na obu końcach, innym łatwiej jest z niego korzystać, ponieważ wiedzą, że nie będą miały miejsca zwykłe złamania kodu spowodowane zmianami formatu danych .

Web scraping, będący jednym z głównych beneficjentów danych strukturalnych, zapewni dalszy rozwój, ponieważ ten sam skrobak może działać w znacznie szybszym tempie i zapewniać lepsze wskaźniki dokładności, gdy analizuje tylko dane strukturalne w porównaniu z analizą zniekształconą dane.