مستقبل تجريف الويب في الويب المهيكل - PromptCloud

نشرت: 2019-03-14تطورت تقنيات تحسين محركات البحث بمرور الوقت ولم تعد الروابط الخلفية والعلامات الوصفية هي الأشياء الوحيدة التي تساعد الشركات على إنشاء حركة مرور عضوية أفضل. على الرغم من أن الجميع يعرف أن Google تصنف مواقع الويب بناءً على عدد من العوامل ، باستخدام خوارزميات معقدة ، فإن جميع المعلمات التي يتم احتسابها في تصنيفات تحسين محركات البحث غير معروفة. ومع ذلك ، فإن الحاجة إلى البيانات المنظمة لأغراض تحسين محركات البحث مقبولة عالميًا وستجد عددًا من المدونات على الويب حول هذا الموضوع. تشرح صفحة Google هذه في الواقع كيف تحاول Google فهم صفحة الويب الخاصة بك بشكل أفضل باستخدام جميع البيانات المنظمة المتوفرة لها لتحليلها. من خلال وجود بيانات منظمة على موقع الويب الخاص بك ، فإنك تترك لـ Google المزيد من الأدلة لفهم موقع الويب الخاص بك وترتيبه وفقًا لذلك. في الواقع ، قدمت Google أيضًا أمثلة على كيفية ظهور بيانات موقع الويب الخاص بك في الخلفية. نظرًا لكون Google أكبر محرك بحث في العالم (باستثناء Baidu في الصين) ، فمن الآمن القول أنه سيكون من المفيد لجميع مواقع الويب اتباع تنسيق البيانات المنظمة هذا للحصول على رؤية أفضل. وهذا هو السبب في أن مواقع الويب تغير تنسيقات البيانات بسرعة على صفحاتها ، وهذا سيفيد تصنيفات تحسين محركات البحث وكذلك أدوات كشط الويب.

البيانات المنظمة مفيدة للجميع. حتى مواقع الويب التي ترغب في توسيع نطاقها ستستفيد من وجود بيانات منظمة حيث سيكون لديها بالفعل تخطيط بيانات أساسي لمتابعة ، وستكون العمليات في واجهتها الخلفية أسرع مما يؤدي إلى زمن انتقال أقل وتجربة عملاء فائقة.

الفرق الذي أحدثته البيانات المنظمة

حتى الآن ، تحدثت عن البيانات المنظمة وكيف تجبر ممارسات تحسين محركات البحث مواقع الويب على التحول إليها. ولكن ما هو الفرق بين البيانات المهيكلة وغير المهيكلة ولماذا يكون من الأسهل تحليل البيانات المنظمة ، سواء كان ذلك من أجل ترتيب تحسين محركات البحث أو تجريف الويب؟

دعنا نشرح هذا بمثال. لنفترض أنك موقع ويب حيث ينشر الأشخاص تعليقات حول المطاعم. يقوم الأشخاص بتقييم المطاعم وأيضًا نشر تعليقات حول الطعام الذي لديهم في مطاعم مختلفة على موقع الويب الخاص بك. لنفترض أن لديك مطعمًا مُدرجًا باسم "Red Onion Restaurant" ، وقام ثلاثة أشخاص بتقييم المطعم بينما نشر اثنان تعليقات. لنفترض أنك قمت بتخزين هذه البيانات في شكل سلسلة-

”مطعم البصل الأحمر | متوسط التقييم- 3.5 نجوم | 3 | “طعام جيد ، مزدحم للغاية” | "المعكرونة كانت رائعة."

لذلك ترى أن هذه سلسلة واحدة أو جملة واحدة ستقوم Google بتحليلها من أجل تحسين محركات البحث ، أو ربما يتم كشطها لاستخراج البيانات. يمكنك أن تفهم أنه قد تكون هناك اختلافات في هذه السلسلة ، اعتمادًا على التفاصيل الإضافية مثل الموقع ونطاق السعر لبعض المطاعم. في مثل هذه السيناريوهات ، قد يتبين أن استخراج عناصر منفصلة مثل متوسط التقييم والتعليقات المختلفة يمثل مشكلة ، ويتطلب عمليات حسابية إضافية.

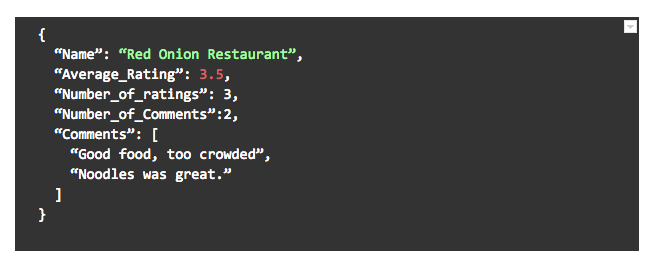

لنفترض الآن أن نفس موقع الويب كان يخزن بالفعل هذه البيانات في كائن JSON بهذا التنسيق-

فقط تخيل مدى سهولة فهم Google للبيانات وتصنيف موقع الويب ومدى سهولة الزحف إلى البيانات. حتى إذا كانت هناك حقول إضافية لبعض المطاعم (أو إذا كانت بعض هذه الحقول مفقودة) ، فسيكون فحصًا بسيطًا لالتقاط البيانات المتاحة. هذه هي الطريقة التي يسهل بها معالجة البيانات المنظمة ، سواء كانت للعين البشرية أو الكمبيوتر.

نمو تجريف الويب مدعومًا بالبيانات المنظمة

ينمو تجريف الويب بمعدل هائل منذ الوقت الذي اعتاد فيه الناس على قص المقالات الصحفية أو نسخ لصق من المدونات عبر الإنترنت. في الوقت الحاضر ، يتم إجراء معظم عمليات تجريف الويب بواسطة روبوتات ذكية آلية أو شبه آلية تتولى معالجة معظم المشكلات. في الحالات التي تواجه فيها مشكلة أو حيث يجب تدريبها للزحف إلى صفحة ويب جديدة ، يكون التدخل البشري مطلوبًا. إذا كان برنامج مكشطة الويب يعمل على مواقع الويب التي تحتوي على معظم البيانات بتنسيق منظم ، فإن فرص حدوث الأخطاء أو الحاجة إلى التدخل اليدوي يتم تقليلها إلى حد كبير وتكون السرعة التي يمكن أن يعمل بها روبوت الكشط أسرع أيضًا.

لا شيء في موقع الويب يمكن أن يساعد في تجريف الويب أكثر من البيانات المنظمة. غالبًا ما تكون الصور ومقاطع الفيديو موجودة في مواقع الويب ، وحتى يمكن إدراجها في علامات عشوائية. بدلاً من ذلك ، فإن وجود روابطهم كجزء من data-JSON ، وتخزينها في مكان آخر ، سيساعد بشكل كبير أدوات كشط الويب على التمييز بين الأشكال المختلفة من البيانات والزحف إليها وتخزينها بشكل منفصل ووفقًا لذلك.

يمكن أن تؤثر البيانات المنظمة بشكل إيجابي على تجريف الويب واكتشاف المعلومات

يعد نظافة البيانات أحد العوامل المهمة التي يتجاهلها الناس عند الحديث عن البيانات. يعد تنظيف البيانات أمرًا مهمًا للغاية لأن البيانات القذرة يمكن أن تقلل من قيمة البيانات نفسها ، أو حتى تجعلها عديمة الفائدة. يمكن أن تؤدي البيانات غير المنظمة إلى بيانات قذرة عند كشطها أو معالجتها أو حتى نقلها بين مواقع الويب أو صفحات الويب. تقلل البيانات المنظمة من فرص البيانات القذرة أو المكررة لأنه باتباع تنسيق واحد لكل إدخال بيانات جديد ، يتم وضع علامة على الأخطاء والمشكلات في نقطة إدخال البيانات نفسها.

يحدث تجريف الويب بطريقة مشابهة جدًا لكيفية تحليل محركات البحث لمواقع الويب الخاصة بك لترتيبك ، وبالتالي فليس من المستغرب أن تكون اهتمامات كلاهما مترابطة. ومع ذلك ، يتعين على المرء أن يفهم المنطق الأساسي وراء سبب تفضيل البيانات المهيكلة ، بغض النظر عن حالة الاستخدام. تحدث تغييرات الكود بانتظام ، وتكون حسابات الواجهة الأمامية والخلفية عرضة للتغييرات المنتظمة بسبب ترقيات المنتج ، والميزات الجديدة ، وما إلى ذلك ، ولكن وجود تنسيق بيانات قياسي سيقطع شوطًا طويلاً في تسهيل حياة المطورين. عندما يظل تنسيق المدخلات والمخرجات الخاص بواجهة برمجة التطبيقات كما هو بغض النظر عن التغييرات الأخرى التي تحدث على كلا الطرفين ، يكون من الأسهل على الآخرين استخدامه ، لأنهم يعلمون أن فواصل التعليمات البرمجية العادية بسبب تغييرات تنسيق البيانات لن تحدث .

كشط الويب ، باعتباره أحد المستفيدين الرئيسيين من البيانات المنظمة ، سيحقق مزيدًا من النمو ، حيث يمكن أن يعمل روبوت الكشط نفسه بوتيرة أسرع ويعطي معدلات دقة أفضل عندما يقوم فقط بتحليل البيانات المنظمة مقارنةً بالوقت الذي يتم فيه تحليل البيانات المشوهة بيانات.