ทางเลือก Portia สำหรับการดึงข้อมูลเว็บ

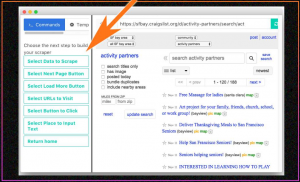

เผยแพร่แล้ว: 2019-07-15Portia เป็นเครื่องมือภาพที่อนุญาตให้ผู้ใช้รวบรวมข้อมูลเว็บไซต์โดยไม่ต้องมีความรู้ด้านการเขียนโปรแกรม มันเป็นบริการที่โฮสต์ แต่เนื่องจากการใช้เครื่องขูดแบบมองเห็นที่ลดน้อยลง บริการนี้จึงถูกถอดออกและไม่ได้ใช้งานอีกต่อไปในปัจจุบัน แล้วผู้คนใช้ Portia อย่างไรเมื่อมันมีอยู่? ในการใช้ Portia คุณจะต้องป้อนรูปแบบของ URL ที่ต้องเข้าชม แล้วเลือกองค์ประกอบในหน้าเว็บเหล่านั้นด้วยท่าทางชี้และคลิก หรือโดยใช้ CSS หรือ XPath แม้จะใช้งานง่าย แต่ปัญหาที่ใหญ่ที่สุดของ Portia ได้แก่:

- เป็นเครื่องมือที่ต้องใช้เวลามากในการควบคุมเมื่อเทียบกับเครื่องมือขูดเว็บแบบโอเพนซอร์สอื่นๆ

- การนำทางเว็บไซต์ทำได้ยาก

- คุณต้องพูดถึงหน้าเป้าหมายเมื่อคุณเริ่มรวบรวมข้อมูลเพื่อป้องกันไม่ให้ Portia ไปที่ URL ที่ไม่จำเป็น

- ไม่มีวิธีเสียบฐานข้อมูลเพื่อบันทึกจุดข้อมูลที่คัดลอกมา

ข้อดีของ Visual Web Scrapers คืออะไร?

เมื่อคุณมีข้อกำหนดการขูดเว็บแบบครั้งเดียว คุณสามารถใช้เครื่องขูดเว็บแบบภาพได้ แต่ไม่แนะนำให้ใช้เป็นส่วนหนึ่งของเวิร์กโฟลว์ทางธุรกิจ ในกรณีที่คุณกำลังดำเนินธุรกิจที่คุณต้องการรวบรวมข้อมูลจากหน้าเว็บแบบคงที่เพียงไม่กี่หน้า และบางครั้งมากเกินไป (พูดเดือนละครั้ง) คุณจะได้รับคนในทีมของคุณที่รู้ว่าต้องคัดลอกข้อมูลใดบ้างเพื่อทำความเข้าใจ การทำงานของเครื่องขูดเว็บแบบภาพภายในเวลาไม่กี่ชั่วโมง จากนั้นจึงดึงข้อมูลเว็บเป็นครั้งคราว โปรแกรมรวบรวมข้อมูลเว็บแบบภาพมีประโยชน์อย่างยิ่งสำหรับธุรกิจขนาดเล็กที่ไม่มีทีมเทคโนโลยีและมีข้อกำหนดในการขูดเล็กน้อย

โปรแกรมรวบรวมข้อมูลเว็บแบบภาพเกือบจะเหมือนกับมีคนคลิก "ตรวจสอบองค์ประกอบ" บนเว็บเพจและคัดลอกข้อมูลจากเนื้อหา HTML เมื่อคุณใช้เครื่องขูดเว็บแบบภาพ คุณจะต้องคลิกที่ส่วนหนึ่งของหน้าเว็บและซอฟต์แวร์จะคัดลอกข้อมูลไปยังตำแหน่งที่คุณเลือก

เครื่องขูดเว็บแบบมองเห็นมีข้อบกพร่องในด้านใดบ้าง

อย่างไรก็ตาม เครื่องขูดที่มองเห็นจะขาดเมื่อคุณมีงานหนักที่ต้องทำ

คุณอาจต้องรวมการดึงข้อมูลบางส่วนเป็นส่วนหนึ่งของเวิร์กโฟลว์ธุรกิจของคุณ (ซึ่งควรเป็นแบบอัตโนมัติ)

ข้อมูลอาจจำเป็นต้องคัดลอกไปยังหน้าหลายร้อยหรือหลายพันหน้า และอาจจำเป็นต้องรีเฟรชบ่อยมาก

อาจมีความจำเป็นสำหรับฟีดข้อมูลสดที่คัดลอกมาสำหรับโมดูลธุรกิจเฉพาะ ในกรณีส่วนใหญ่ข้างต้น เว็บสแครปเปอร์แบบโค้ดจะมีประโยชน์มากกว่ามีดโกนที่มองเห็นได้

โครงการขูดหินปูนส่วนใหญ่พบว่าจำเป็นต้องรวบรวมข้อมูลหน้าเว็บที่คล้ายคลึงกันจำนวนมากเพื่อรวบรวมข้อมูลเว็บเกี่ยวกับรายการต่างๆ รายการเหล่านี้อาจมีตั้งแต่ข้อมูลเที่ยวบินบนเว็บไซต์จองอิเล็กทรอนิกส์ไปจนถึงรายละเอียดผลิตภัณฑ์บนเว็บไซต์อีคอมเมิร์ซ ตรรกะที่ใช้ในสถานการณ์เช่นนี้คือ คุณพยายามทำความเข้าใจรูปแบบที่ข้อมูลถูกเก็บไว้ในหน้าเว็บโดยใช้หน้าเว็บสองสามหน้า และใช้โค้ดที่ไม่เพียงแต่รวบรวมข้อมูลหน้าเว็บที่มีโครงสร้างเดียวกันเท่านั้น แต่ยังรวมถึงหน้าเว็บที่มีโครงสร้างคล้ายกันด้วย . นอกจากนี้ ในขณะที่ดึงหน้าทั้งหมดที่มีอยู่ในเว็บไซต์ หน้าที่มีโครงสร้างบางอย่างอาจต้องถูกละเว้น การปรับแต่งทั้งหมดเหล่านี้ไม่สามารถทำได้บนเครื่องขูดภาพ ดังนั้นจึงไม่แนะนำให้ขูดหน้ามากเกินไปโดยใช้เครื่องขูดภาพ

ในทางกลับกัน เนื่องจากการเปลี่ยนแปลงในรูปลักษณ์ของเว็บไซต์ทุกๆ สองสามสัปดาห์หรือหลายเดือน คุณอาจต้องฝึกโปรแกรมขูดเว็บที่มองเห็นได้ทุกครั้งที่มีการเปลี่ยนแปลงส่วนติดต่อผู้ใช้ของเว็บไซต์ ในทางกลับกัน เมื่อใช้สแครปเปอร์แบบโค้ด บ่อยครั้งการเปลี่ยนแปลง UI อาจไม่ต้องการการเปลี่ยนแปลงใดๆ ในมีดโกนด้วยซ้ำ เนื่องจากเว็บไซต์อาจยังคงโครงสร้างเหมือนเดิม แม้ว่าจะมีการเปลี่ยนแปลงบางอย่างในส่วนติดต่อผู้ใช้ที่อาจต้องมีการเปลี่ยนแปลงในมีดโกน การเปลี่ยนแปลงมักจะน้อยที่สุด และการปรับมีดโกนให้เข้ากับการเปลี่ยนแปลงนั้นง่ายพอสมควร

เรามีทางเลือกอื่นอะไรอีกบ้าง?

มีทางเลือกมากมายสำหรับ Portia ภาษาเช่น Python, R และ Golang ถูกใช้โดยนักพัฒนาและทีมขูดเว็บทั่วโลก ไปจนถึงการดึงข้อมูลเว็บจากหน้าเว็บ มีการพัฒนาวิธีการใหม่เพื่อให้กระบวนการเร็วขึ้น ตัวอย่างเช่น ด้วยความช่วยเหลือของการเขียนโปรแกรมแบบขนานและการแคชใน Golang การใช้แพ็คเกจที่เรียกว่า Colly คุณสามารถใช้การตั้งค่าแบบกำหนดเองดังต่อไปนี้:

- จำนวนหน้าที่คุณต้องการรวบรวมข้อมูลพร้อมกัน ณ เวลาที่กำหนด

- ความลึกสูงสุดที่มีดโกนควรไปเมื่อเริ่มขูดจากหน้าเว็บ (ความหมายก็คือว่า ถ้าคุณตั้งค่าความลึกสูงสุดเป็น 3 มันจะรวบรวมข้อมูลหน้าบนสุด ไปที่ URL ที่พบในนั้น รวบรวมข้อมูล จากนั้นไปที่ URL ที่พบในหน้านั้น และรวบรวมข้อมูลนั้นด้วย แต่ตอนนี้ ในหน้าที่สามหากพบ URL จะไม่ดำเนินการต่อ)

- คุณสามารถตั้งค่าการตรวจสอบคำที่มีอยู่ใน URL ได้ นั่นคือหากมีคำอยู่ใน URL หน้าเว็บใน URL นั้นจะต้องถูกคัดลอก หรือคุณสามารถตั้งค่าการยกเว้น- URL ด้วยคำใดคำหนึ่ง ซึ่งมีดโกนไม่ควรเข้าถึง

นี่เป็นเพียงตัวอย่างบางส่วนของฟังก์ชันเล็กๆ น้อยๆ นับร้อยที่คุณได้รับเมื่อคุณสร้างเว็บสแครปเปอร์ด้วยตัวเอง

ผู้ให้บริการ DaaS กับทีมภายใน?

ธุรกิจส่วนใหญ่ที่ไม่มีทีมเทคโนโลยี หรือแม้แต่สมาชิกที่ไม่มีความเข้าใจพื้นฐานเกี่ยวกับภาษาสคริปต์ใด ๆ ควรพยายามอย่าเริ่มสร้างทีมสแครปภายในองค์กร เหตุผลเบื้องหลังนี้เป็นเรื่องง่าย เงินที่คุณใช้ในการสรรหานักพัฒนาและจากนั้นให้พวกเขาสร้างและรักษาระบบการขูดเว็บใหม่ทั้งหมดสำหรับความต้องการทางธุรกิจของคุณจะมีจำนวนมาก และท้ายที่สุด หากคุณเป็นบริษัทขนาดเล็ก และการขูดเว็บไม่ใช่เชื้อเพลิงสำหรับธุรกิจของคุณ (นั่นคือธุรกิจของคุณไม่ได้เน้นที่ข้อมูลที่คุณรวบรวมข้อมูลจากเว็บ) จึงไม่สมเหตุสมผลที่จะสร้าง ทีมงานภายใน.

วิธีแก้ปัญหาง่ายๆ ในกรณีนี้คือผู้ให้บริการ DaaS ที่ตอบสนองความต้องการของคุณและให้ข้อมูลของคุณในรูปแบบที่คุณเลือก ทีมงานของเราที่ PromptCloud มีความภาคภูมิใจอย่างยิ่งในการลดการขูดเว็บเป็นกระบวนการสองขั้นตอนสำหรับธุรกิจและองค์กร

บทสรุป

แม้ว่าเครื่องมือภาพจะดีสำหรับทีมธุรกิจ แต่เราก็เห็นด้วยว่าการขูดเว็บไม่ได้เป็นเพียงงานทางธุรกิจธรรมดาๆ เป็นงานที่ต้องมีประสิทธิภาพ รวดเร็ว และปรับแต่งได้อย่างสมบูรณ์ หากคุณมีข้อกำหนดในการขูดเว็บปริมาณมากหรือต้องการดึงข้อมูลเว็บในปริมาณที่มากขึ้น ขอแนะนำให้ใช้บริการดึงข้อมูลเว็บ

หากคุณไม่เชี่ยวชาญในการเขียนโปรแกรมหรือความต้องการของคุณมีความซับซ้อน คุณสามารถใช้ผู้ให้บริการที่มีการจัดการอย่างเต็มรูปแบบ เช่น PromptCloud เพื่อรับข้อมูลที่สะอาดโดยอัตโนมัติโดยไม่ต้องยุ่งยากทางเทคนิคหรือเรียนรู้เครื่องมือใดๆ